MotionBert: aprender la representación del movimiento humano desde una perspectiva unificada

Al aprender las representaciones del movimiento humano, los autores originales del artículo proponen un enfoque unificado para las tareas de vídeo centradas en el ser humano. Se implementa un codificador de movimiento utilizando una red de transformador espaciotemporal de doble flujo (DSTformer), que puede capturar de manera integral y adaptativa las relaciones espaciotemporales de largo alcance entre las articulaciones esqueléticas. La representación del movimiento aprendida se transfiere fácilmente a múltiples tareas posteriores y logra un rendimiento de vanguardia en tres tareas, lo que demuestra su versatilidad.

Enlaces relacionados:

Documento: Aprendizaje de representaciones del movimiento humano: una perspectiva unificada

Github: MotionBert

Con fines de aprendizaje, el autor ha compilado el contenido relevante de MotionBert de la siguiente manera: Los derechos de autor de

todos los textos e imágenes directamente relacionados con el artículo que aparecen en este artículo pertenecen al autor original del artículo y se muestran aquí como referencia y aprendiendo solamente.

Demostración de efectos

Proceso de medición real

Nota: El momento y el entorno para probar esta configuración son: Ubuntu22.04, 2023-7-18y el siguiente contenido es factible de probar en este entorno.

1. Configurar alfapose

La entrada 2D Pose de MotionBert proviene de alphapose, por lo que el video debe ponerse en alphapose para procesarse primero.

# 1. Create a conda virtual environment.

conda create -n alphapose python=3.7 -y

conda activate alphapose

# 2. Install specific pytorch version

conda install pytorch==1.12.1 torchvision==0.13.1 torchaudio==0.12.1 cudatoolkit=11.3 -c pytorch

# 3. Get AlphaPose

git clone https://github.com/MVIG-SJTU/AlphaPose.git

cd AlphaPose

# 4. install dependencies

export PATH=/usr/local/cuda/bin/:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64/:$LD_LIBRARY_PATH

sudo apt-get install libyaml-dev

pip install cython==0.27.3 ninja easydict halpecocotools munkres natsort opencv-python pyyaml scipy tensorboardx terminaltables timm==0.1.20 tqdm visdom jinja2 typeguard pycocotools

################Only For Ubuntu 18.04#################

locale-gen C.UTF-8

# if locale-gen not found

sudo apt-get install locales

export LANG=C.UTF-8

######################################################

# 5. install AlphaPose

python setup.py build develop

# 6. Install PyTorch3D (Optional, only for visualization)

conda install -c fvcore -c iopath -c conda-forge fvcore iopath

conda install -c bottler nvidiacub

pip install pytorch3d

Descárguelo de la página del proyecto github yolov3-spp.weights, AlphaPose/detector/yolo/data si no existe dicha carpeta, cree una.

DescargueFastPose el modelo previamente entrenado paraAlphaPose/pretrained_models

2. Prueba alfapose

python scripts/demo_inference.py --cfg configs/halpe_26/resnet/256x192_res50_lr1e-3_1x.yaml --checkpoint pretrained_models/halpe26_fast_res50_256x192.pth --indir examples/demo/ --save_img

AlphaPose/examples/demoLas imágenes de la carpeta se utilizarán para el procesamiento y AlphaPose/examples/reslos resultados procesados aparecerán en la carpeta.

3. Importe el video al modelo para estimar la pose.

python scripts/demo_inference.py --cfg configs/halpe_26/resnet/256x192_res50_lr1e-3_1x.yaml --checkpoint pretrained_models/halpe26_fast_res50_256x192.pth --video examples/demo/test_video.mp4 --save_video

4. Configurar Motionbert

conda create -n motionbert python=3.7 anaconda

conda activate motionbert

# Please install PyTorch according to your CUDA version.

conda install pytorch torchvision torchaudio pytorch-cuda=11.6 -c pytorch -c nvidia

pip install -r requirements.txt

5. Genera pose 3D en motionbert

Consulte motionbert-3dpose , descargue el archivo de punto de control y guárdelo para checkpoint/pose3d/FT_MB_lite_MB_ft_h36m_global_lite/

ejecutarlo en el directorio MotionBERT.

mkdir -p checkpoint/pose3d/FT_MB_lite_MB_ft_h36m_global_lite

Coloque best_epoch.binel archivo en esta carpeta

y luego ejecútelo en el directorio MotionBERT.

python infer_wild.py \

--vid_path <your_video.mp4> \

--json_path <alphapose-results.json> \

--out_path <output_path>

Según mi ejemplo es:

python infer_wild.py \

--vid_path test_demo/AlphaPose_test_video.mp4 \

--json_path test_demo/alphapose-results.json \

--out_path test_demo

Nota: debe cambiar a motionbertConda Env para ejecutar este archivo

conda activate motionbert

Si el error se informa de la siguiente manera:

qt.qpa.plugin: Could not load the Qt platform plugin "xcb" in "/home/hermanye/anaconda3/envs/motionbert/lib/python3.7/site-packages/cv2/qt/plugins" even though it was found.

This application failed to start because no Qt platform plugin could be initialized. Reinstalling the application may fix this problem.

Simplemente reinstale opencv

pip uninstall opencv-python

pip install opencv-python-headless

6. Crea una malla en motionbert

Consulte motionbert-mesh , descargue el archivo de punto de control y guárdelo encheckpoint/mesh/FT_MB_release_MB_ft_pw3d/

Ejecutar en el directorio MotionBERT

mkdir -p checkpoint/mesh/FT_MB_release_MB_ft_pw3d

Coloque best_epoch.binel archivo en la carpeta.

Nota: El nombre del archivo es el mismo que el del paso 4, pero no es el mismo archivo y necesita ser identificado.

Vaya a simplificar para descargar SMPL, debe registrar una cuenta.

Cambie /smplify_public/code/models/basicModel_neutral_lbs_10_207_0_v1.0.0.pklel nombre SMPL_NEUTRAL.pkly colóquelo en MotionBERT/data/meshuna carpeta. Si la carpeta no existe, cree una.

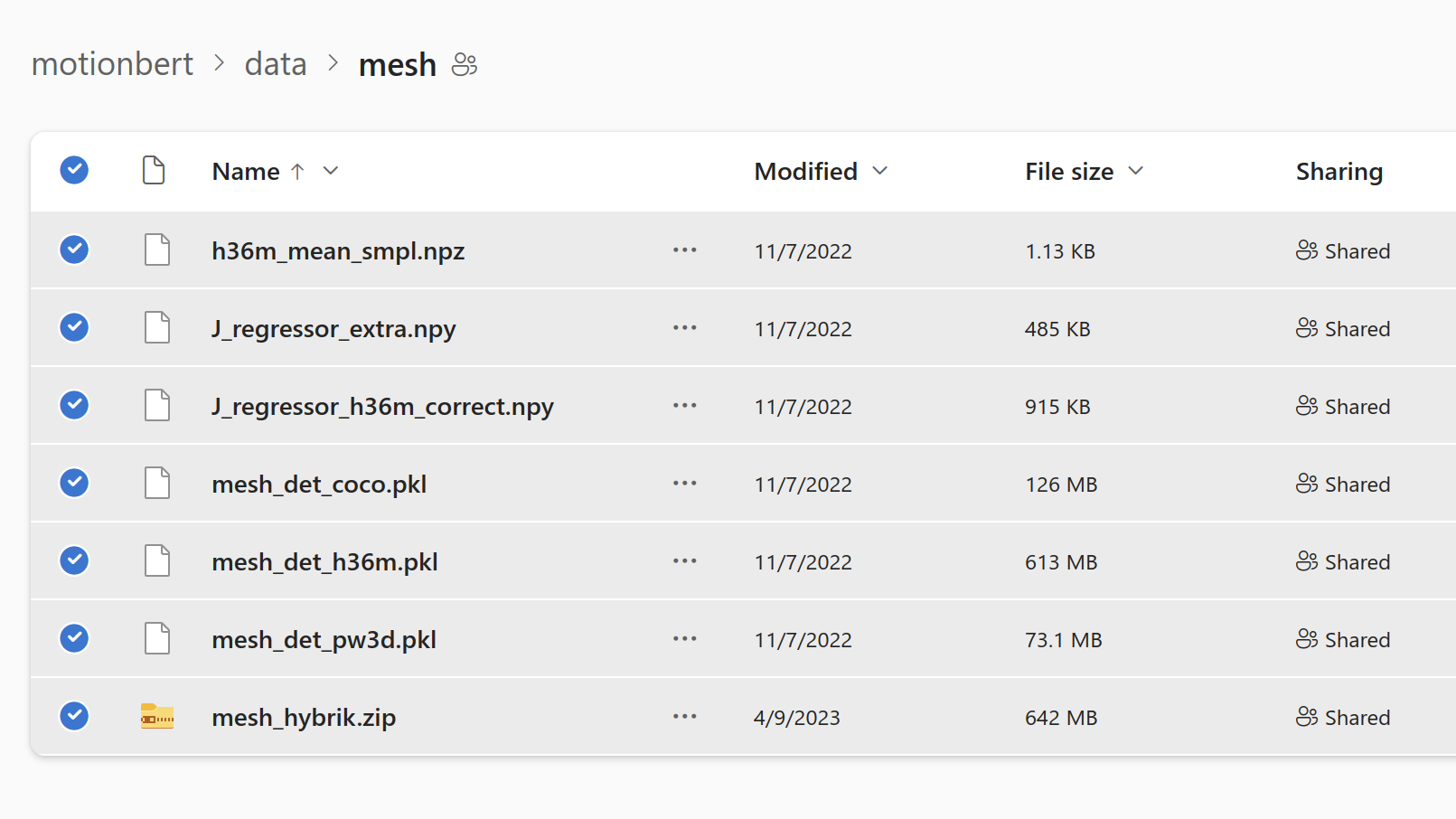

Luego vaya a descargar el conjunto de datos y coloque el conjunto de datos proporcionado por MotionBERT en MotionBERT/data/meshla carpeta

. Encontré un error:

Traceback (most recent call last):

File "infer_wild_mesh.py", line 71, in <module>

model = MeshRegressor(args, backbone=model_backbone, dim_rep=args.dim_rep, hidden_dim=args.hidden_dim, dropout_ratio=args.dropout)

File "/home/hermanye/motion_bert_ws/src/MotionBERT/lib/model/model_mesh.py", line 87, in __init__

self.head = SMPLRegressor(args, dim_rep, num_joints, hidden_dim, dropout_ratio)

File "/home/hermanye/motion_bert_ws/src/MotionBERT/lib/model/model_mesh.py", line 30, in __init__

mean_params = np.load(self.smpl.smpl_mean_params)

File "/home/hermanye/anaconda3/envs/motionbert/lib/python3.7/site-packages/numpy/lib/npyio.py", line 417, in load

fid = stack.enter_context(open(os_fspath(file), "rb"))

FileNotFoundError: [Errno 2] No such file or directory: 'data/mesh/smpl_mean_params.npz'

Se estima que el nombre del conjunto de datos proporcionado por el autor de MotionBERT es incorrecto y debe cambiarse h36m_mean_smpl.npzy smpl_mean_params.npz

luego ejecutarse en el directorio de MotionBERT.

python infer_wild_mesh.py \

--vid_path <your_video.mp4> \

--json_path <alphapose-results.json> \

--out_path <output_path> \

--ref_3d_motion_path <3d-pose-results.npy> # Optional, use the estimated 3D motion for root trajectory.

Según mi ejemplo es:

python infer_wild_mesh.py \

--vid_path test_demo/AlphaPose_test_video.mp4 \

--json_path test_demo/alphapose-results.json \

--out_path test_demo \

--ref_3d_motion_path test_demo/X3D.npy # Optional, use the estimated 3D motion for root trajectory.

La reproducción fue exitosa, pero no sé por qué se siente raro en comparación con @bitingcat.

De hecho, el efecto de MotionBert fue muy bueno esta mañana. Originalmente estaba destinado a ser utilizado para el mapeo sincrónico en tiempo real de los movimientos del brazo robótico. Después de las pruebas, descubrí que el tiempo de procesamiento era demasiado largo y el código original La estructura de MotionBert era demasiado problemática, así que me di por vencido y comencé con Swing.

Traducción de tesis

Consejo:

el nivel del autor es limitado y las siguientes traducciones y anotaciones pueden contener errores fácticos.

Para obtener información detallada sobre el artículo, consulte la página del artículo original del autor .

título

Aprendizaje de representaciones del movimiento humano: una perspectiva unificada

autor

Wentao Zhu1 Xiaoxuan Ma1 Zhaoyang Liu2 Libin Liu1 Wayne Wu2,3 Yizhou Wang1

1 Universidad de Pekín 2 Investigación SenseTime 3 Laboratorio de IA de Shanghai

{wtzhu,maxiaoxuan,libin.liu,yizhou.wang}@pku.edu.cn

{zyliumy,wuwenyan0503}@gmail .com

Resumen

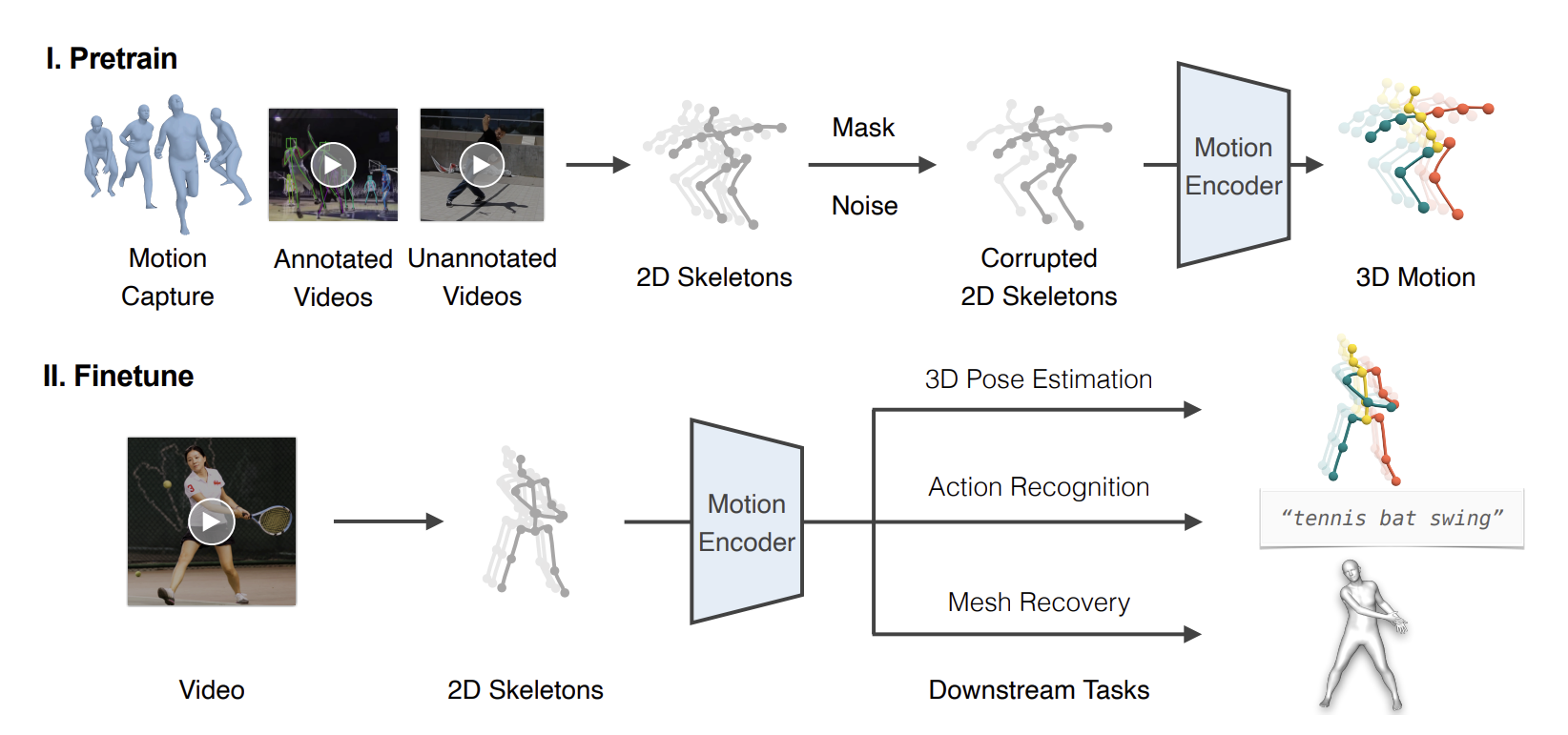

Proponemos una perspectiva unificada para manejar diversas tareas de video centradas en el ser humano mediante el aprendizaje de representaciones del movimiento humano a partir de recursos de datos heterogéneos y a gran escala. Específicamente, proponemos una etapa de preentrenamiento en la que se entrena un codificador de movimiento para recuperar el movimiento 3D subyacente a partir de observaciones 2D parciales ruidosas . La representación del movimiento obtenida de esta manera combina conocimientos geométricos, cinemáticos y físicos y puede transferirse fácilmente a múltiples tareas posteriores. Implementamos el codificador de movimiento utilizando una red neuronal de transformador de espacio-tiempo (DSTformer) de doble flujo . Captura de manera integral y flexible relaciones espacio-temporales de largo alcance entre articulaciones esqueléticas , exhibiendo el error de estimación de pose 3D más bajo hasta la fecha cuando se entrena desde cero. Además, nuestro marco propuesto logra un rendimiento de vanguardia en las tres tareas posteriores simplemente ajustando el codificador de movimiento previamente entrenado y agregando un cabezal de regresión simple (capas 1-2), lo que demuestra la universalidad aprendida del movimiento. representación.

comentario resumido

La principal contribución de este artículo es proponer un nuevo método para aprender la representación del movimiento humano y luego aplicar esta representación aprendida a diferentes tareas. En la fase previa al entrenamiento, los autores entrenan un modelo para recuperar acciones humanas en 3D a partir de ruido y observaciones parciales en 2D. Luego, este modelo se puede ajustar para tareas específicas en tareas posteriores. Una característica importante de este método es que utiliza una red de transformadores espacio-temporales de dos flujos, que es capaz de capturar las relaciones del esqueleto humano en el espacio y el tiempo. Esto permite que el modelo muestre un error de estimación de pose 3D muy bajo durante el entrenamiento.

1. Introducción

Comprender y detectar las actividades humanas ha sido durante mucho tiempo un objetivo central de la inteligencia artificial. Con este fin, los investigadores han definido varias tareas para estimar etiquetas semánticas sobre personas a partir de vídeos , como puntos clave esqueléticos, categorías de acciones y mallas de superficie . Aunque se han logrado avances significativos en estas tareas, a menudo se las modela como problemas independientes en lugar de problemas interconectados. Por ejemplo, se han utilizado redes convolucionales de gráficos espacio-temporales (ST-GCN) para modelar las relaciones espaciotemporales de las articulaciones humanas en la estimación de poses 3D y el reconocimiento de acciones, pero las conexiones entre estos modelos no se han explorado completamente. Intuitivamente, todos estos modelos deberían haber aprendido a reconocer patrones típicos de movimiento humano, aunque estén diseñados para problemas diferentes. Sin embargo, los métodos actuales no logran explorar ni explotar los puntos en común entre estas tareas. Idealmente, podríamos desarrollar una representación de video unificada y orientada a los humanos que pueda compartirse en todas las tareas relevantes.

Un desafío importante en el desarrollo de tales representaciones es la heterogeneidad de los recursos de datos disponibles. Los sistemas de captura de movimiento (Mocap) proporcionan datos de movimiento 3D de alta fidelidad obtenidos mediante marcadores y sensores, pero la apariencia del vídeo capturado a menudo se limita a simples escenas interiores . Los conjuntos de datos de reconocimiento de acciones proporcionan anotaciones de la semántica de las acciones, pero no contienen etiquetas de pose humana o solo tienen acciones limitadas para las actividades diarias . Por el contrario, los vídeos al aire libre ofrecen una gama amplia y diversa de apariencias y movimientos. Sin embargo, obtener anotaciones de pose 2D precisas requiere mucho esfuerzo y obtener datos reales de las posiciones de las articulaciones 3D es casi imposible. Por lo tanto, la mayoría de las investigaciones existentes se centran en utilizar un único tipo de datos de movimiento humano para resolver tareas específicas , sin poder disfrutar de las ventajas de otros recursos de datos .

En este trabajo, proporcionamos una nueva perspectiva para aprender la representación del movimiento humano. La idea clave es que podemos aprender una representación universal del movimiento humano a partir de recursos de datos heterogéneos de forma unificada y explotar esta representación de forma unificada para manejar diferentes tareas posteriores . Proponemos un marco de dos etapas , que incluye capacitación previa y ajuste , como se muestra en la Figura 1. En la etapa de preentrenamiento, extraemos secuencias de esqueletos 2D de diversas fuentes de datos de movimiento y las corrompimos con máscaras y ruido aleatorios . Posteriormente, entrenamos un codificador de movimiento para recuperar el movimiento 3D del esqueleto 2D corrupto . Esta desafiante tarea previa al texto esencialmente requiere codificadores de movimiento para i) inferir la estructura humana tridimensional subyacente a partir de sus movimientos temporales ; ii) recuperar observaciones erróneas y faltantes . De esta manera, los codificadores de movimiento capturan implícitamente el sentido común del movimiento humano, como las conexiones articulares, las limitaciones anatómicas y la dinámica temporal . En la práctica, proponemos un transformador espacio-temporal de doble flujo (DSTformer) como codificador de movimiento para capturar las relaciones de largo alcance entre los puntos clave del esqueleto . Nuestra hipótesis es que las representaciones de movimiento aprendidas de recursos de datos diversos y a gran escala se pueden compartir entre diferentes tareas posteriores y mejorar su rendimiento. Por lo tanto, para cada tarea posterior , utilizamos datos de capacitación y señales de supervisión específicos de la tarea yUn cabezal de regresión simple para adaptar la representación de movimiento previamente entrenada.

En general, las contribuciones de este trabajo son triples: 1) Proporcionamos una nueva perspectiva sobre la resolución de diversas tareas de vídeo orientadas a humanos mediante el aprendizaje de representaciones de movimiento humano. 2) Proponemos un método de preentrenamiento para aprender una representación universal del movimiento humano utilizando recursos de movimiento humano heterogéneos pero a gran escala. Nuestro método puede explotar simultáneamente la precisión de los datos de mocap 3D y la diversidad de vídeos RGB de exteriores. 3) Diseñamos una red Transformer de dos flujos equipada con bloques de autoatención espacio-temporales concatenados, que pueden usarse como un esqueleto universal para el modelado del movimiento humano. Los experimentos muestran que el diseño anterior permite la transferencia de representaciones generales del movimiento humano a múltiples tareas posteriores, superando los métodos de última generación para tareas específicas.

Anotación de introducción

Esta investigación proporciona una nueva perspectiva y tiene como objetivo resolver una variedad de tareas de video orientadas a humanos mediante el aprendizaje de la representación del movimiento humano. Para lograr este objetivo, los autores proponen un marco de dos etapas, que incluye capacitación previa y ajuste. La etapa de preentrenamiento utiliza varios recursos de datos heterogéneos para entrenar un codificador de movimiento que puede recuperar movimiento 3D a partir de ruido y observaciones 2D parciales. El entrenamiento en esta etapa requiere que el modelo sea capaz de comprender y capturar las leyes básicas del movimiento humano, como las conexiones articulares, las limitaciones anatómicas y la dinámica temporal. Para ello, los autores proponen el transformador espacio-temporal de doble flujo (DSTformer), una red neuronal capaz de capturar relaciones a larga distancia entre puntos clave del esqueleto. Una vez completada la fase de preentrenamiento, cada tarea posterior se ajusta y la representación del movimiento preentrenado se puede ajustar con un simple cabezal de regresión. La principal aportación de este trabajo

Las contribuciones incluyen proporcionar una nueva perspectiva para resolver tareas de video orientadas a humanos, proponer un método de preentrenamiento que pueda utilizar completamente datos heterogéneos a gran escala y diseñar una red neuronal general que pueda usarse como modelo de movimiento humano.

2. Trabajo relacionado

Aprender la representación del movimiento humano

Los primeros estudios utilizaron modelos ocultos de Markov y modelos gráficos para describir el movimiento humano. Kanazawa y otros diseñan un codificador temporal y un fantasma para aprender representaciones de la dinámica humana en 3D. Zhang y otros predicen la dinámica 3D futura de forma autosupervisada . Sun y otros combinaron además etiquetas de acción y recuerdos de acción. Desde la perspectiva del reconocimiento de acciones, varias tareas frontales autosupervisadas están diseñadas para aprender representaciones de movimiento, incluidas predicciones futuras, acertijos, contraste de esqueletos, cambios de velocidad, coherencia de vistas cruzadas y reconstrucción de contrastes. También se han explorado técnicas similares en tareas de evaluación de acciones y relocalización de acciones. Estos métodos explotan datos de acción homogéneos, diseñan tareas anteriores correspondientes y las aplican a tareas posteriores específicas . En este trabajo, proponemos un marco unificado de ajuste previo al entrenamiento que integra varios recursos de datos heterogéneos y demuestra su generalidad en varias tareas posteriores .

Estimación de la pose humana en 3D.

Recuperar poses humanas en 3D a partir de vídeos RGB monoculares es un problema clásico y los métodos se pueden dividir en dos categorías. La primera categoría utiliza CNN para estimar la pose 3D directamente a partir de imágenes . Sin embargo, una limitación de estos métodos es el equilibrio entre la precisión de la pose 3D y la diversidad de apariencia debido a las técnicas actuales de recopilación de datos . La segunda categoría es extraer primero la pose 2D y luego usar otra red neuronal para actualizar la pose 2D estimada a 3D . La mejora se puede lograr a través de redes completamente conectadas, redes convolucionales temporales, GCN y Transformer . Nuestro marco se basa en la segunda categoría y utilizamos el DSTformer propuesto para completar la promoción de 2D a 3D.

Reconocimiento de comportamiento basado en esqueletos

Un trabajo pionero señaló la conexión intrínseca entre el reconocimiento de acciones y la estimación de la pose humana . Para modelar la relación espaciotemporal entre las articulaciones del cuerpo humano, estudios anteriores adoptaron principalmente LSTM y GCN . Recientemente, PoseConv3D propuso aplicar 3D-CNN en mapas de calor de juntas 2D apiladas y logró mejores resultados. Además de las tareas de reconocimiento de acciones totalmente supervisadas, NTU-RGB+D120 llama la atención sobre el problema del reconocimiento de acciones únicas. Para ello, SL-DML aplica un aprendizaje métrico profundo a señales multimodales. Sabater y otros exploraron el reconocimiento de una sola vez en un entorno terapéutico. Demostramos que las representaciones de movimiento previamente entrenadas se generalizan bien en tareas de reconocimiento de acciones y que un marco afinado previamente entrenado es una solución adecuada para desafíos únicos .

Restauración de malla humana

Basados en modelos humanos paramétricos como SMPL, muchos trabajos de investigación se centran en hacer una regresión de mallas humanas a partir de una única imagen. Aunque sus resultados por fotograma son prometedores, estos métodos producen resultados nerviosos e inestables cuando se aplican al vídeo. Para mejorar su coherencia temporal, PoseBERT y SmoothNet proponen utilizar módulos de eliminación de ruido y suavizado en la predicción de un solo cuadro . Varios trabajos toman videoclips como entrada para explotar señales temporales . Otro problema común es que las imágenes emparejadas y las mallas GT se capturan principalmente en escenas restringidas , lo que limita la capacidad de generalización de los métodos anteriores. Con este fin, Pose2Mesh propone extraer primero un esqueleto 2D utilizando un estimador de pose disponible en el mercado y luego elevarlo a los vértices de la malla 3D . Nuestro enfoque complementa los métodos de recuperación de mallas humanas de última generación y puede mejorar aún más su coherencia temporal a través de representaciones de movimiento previamente entrenadas .

Notas de trabajo relevantes

-

Esta sección revisa la investigación en cuatro áreas principales: aprendizaje de la representación del movimiento humano, estimación de la pose humana en 3D, reconocimiento de acciones basado en esqueletos y restauración de mallas humanas. El autor menciona tecnologías y métodos clave en estos campos, incluidos modelos ocultos de Markov, modelos gráficos, aprendizaje métrico profundo, CNN, Transformer, etc. Además, los autores destacan la innovación de este trabajo de investigación, que propone un marco unificado de ajuste previo al entrenamiento que puede integrar varios recursos de datos heterogéneos y exhibir generalidad en diversas tareas posteriores.

-

La clave para el aprendizaje de la representación del movimiento humano es aprender información sobre las acciones humanas a partir de grandes cantidades de datos y luego aplicar esta información a diversas tareas. Aprovechando las técnicas de aprendizaje profundo, los investigadores pueden crear modelos complejos para comprender y predecir el movimiento humano.

-

La estimación de la pose humana en 3D es la tarea de recuperar la pose humana en 3D a partir de imágenes o vídeos en 2D. Hay dos enfoques principales: estimar la pose 3D directamente a partir de la imagen o extraer primero la pose 2D y luego actualizarla a 3D. Un desafío clave en este campo es cómo equilibrar la precisión de las poses 3D con la capacidad del modelo para manejar diferentes formas y poses del cuerpo humano.

-

El reconocimiento de comportamiento basado en esqueletos se basa en la postura o el movimiento humano.

La tarea de identificar su comportamiento continuo. La dificultad de esta tarea radica en comprender las complejas relaciones espaciotemporales entre las articulaciones del cuerpo humano.

-

La recuperación de malla humana es la tarea de recuperar un modelo humano 3D basado en imágenes o videos 2D. Esto requiere abordar cuestiones como la continuidad temporal y las capacidades de generalización del modelo.

-

El DSTformer propuesto es un nuevo modelo basado en Transformer, utilizado para comprender y modelar el movimiento humano, con el objetivo de resolver problemas en los campos anteriores.

3.Método

3.1 Descripción general

Como se analizó en la primera parte, nuestro método consta de dos etapas, a saber, preentrenamiento unificado y ajuste fino específico de la tarea . En la primera etapa, entrenamos un codificador de acción para completar la tarea de 2D a 3D y utilizamos el transformador espacio-temporal de doble flujo propuesto (DSTformer) como red troncal. En la segunda etapa, ajustamos el codificador de acción previamente entrenado y algunas capas nuevas para adaptarnos a las tareas posteriores . Utilizamos secuencias de esqueletos 2D como entrada tanto en las etapas de preentrenamiento como de ajuste porque se pueden extraer de manera confiable de varias fuentes de movimiento y son más resistentes a los cambios. Las investigaciones existentes han demostrado la eficacia del uso de secuencias de esqueletos 2D para manejar diferentes tareas posteriores. Primero presentaremos la arquitectura de DSTformer y luego describiremos el esquema de capacitación en detalle.

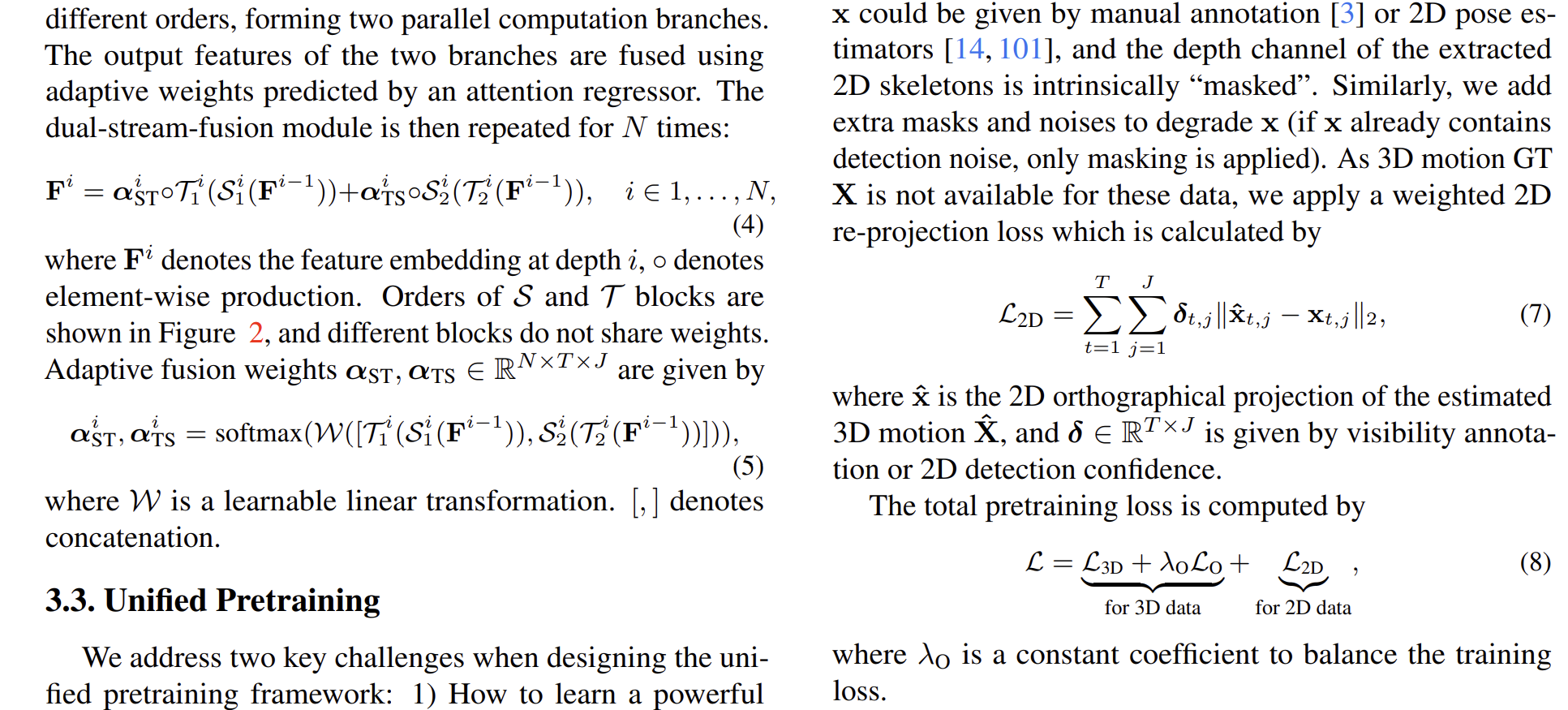

3.2 Arquitectura de red

La figura anterior muestra la arquitectura de red para la conversión de 2D a 3D. Dada una secuencia de esqueleto 2D de entrada , primero la proyectamos en una característica de alta dimensión y luego agregamos codificación de posición espacial y codificación de posición temporal que se pueden aprender. Luego calculamos características utilizando el modelo de secuencia a secuencia DSTformer , donde N es la profundidad de la red. Usamos capas lineales con funciones de activación tanh para calcular representaciones de acciones. Finalmente, realizamos una transformación lineal en la representación de la acción para estimar acciones 3D. Aquí, T representa la longitud de la secuencia y J representa el número de articulaciones del cuerpo. Cin, Cf, Ce y Cout representan el número de canales de entrada, características, incrustación y salida respectivamente. Primero presentamos los bloques de construcción básicos de DSTformer, es decir, bloques espaciales y temporales con autoatención de múltiples cabezas (MHSA) , y luego explicamos el diseño arquitectónico de DSTformer .

bloque espacial

La autoatención espacial de múltiples cabezas (S-MHSA) tiene como objetivo modelar la relación entre articulaciones dentro del mismo paso de tiempo. Usamos la autoatención para obtener la consulta, la clave y el valor de cada encabezado.

bloque de tiempo

La autoatención temporal de múltiples cabezas (T-MHSA) tiene como objetivo modelar la relación de una articulación del cuerpo a lo largo de pasos de tiempo. Su proceso de cálculo es similar al S-MHSA, excepto que MHSA se aplica a las características temporales de cada articulación y se paraleliza en la dimensión espacial.

Convertidor espacio-temporal de doble flujo

Dado un MHSA espacial y temporal que captura las interacciones de las articulaciones corporales intra e interestructura, ensamblamos los componentes básicos para fusionar información espacial y temporal en la corriente. Diseñamos una arquitectura de dos flujos basada en los siguientes supuestos: 1) Dos flujos deberían poder simular un contexto espaciotemporal integral. 2) Cada corriente debería especializarse en diferentes aspectos espaciotemporales. 3) Las dos corrientes deben fusionarse y los pesos de fusión deben equilibrarse dinámicamente de acuerdo con las características espaciotemporales de la entrada. Por lo tanto, apilamos bloques MHSA espaciales y temporales en diferentes órdenes para formar dos ramas paralelas de cálculo. Las características de salida de las dos ramas se fusionan mediante pesos adaptativos predichos por el regresor de atención. Luego repita el módulo de fusión de doble flujo N veces.

3.3 Preformación unificada

Al diseñar un marco de preentrenamiento unificado, abordamos principalmente dos desafíos clave: 1) Cómo aprender representaciones de movimiento potentes a través de tareas de preentrenamiento universales. 2) Cómo explotar datos de movimiento humano heterogéneos pero a gran escala en varios formatos .

Para el primer desafío, nos basamos en prácticas exitosas en el modelado de lenguaje [12, 29, 88] y visión [7, 35] para construir una señal supervisada , es decir, enmascarar partes de la entrada y usar la representación codificada para reconstruir la entrada completa. . Cabe señalar que este tipo de tarea de "completar los espacios en blanco" existe naturalmente en el análisis del movimiento humano, es decir, recuperar la información de profundidad perdida de observaciones visuales 2D, es decir, estimación de la postura humana 3D **. Inspirándonos en esto, utilizamos datos de captura de movimiento 3D a gran escala [74] y diseñamos una tarea previa al entrenamiento para el levantamiento de 2D a 3D. Primero extraemos secuencias de esqueletos 2D proyectando ortogonalmente movimiento 3D. Luego destruimos ocluyendo aleatoriamente y agregando ruido , lo que da como resultado secuencias de esqueletos 2D destruidas que también son similares a los resultados de detección 2D en que contienen oclusiones, fallas de detección y errores. Aplica probabilidades específicas a máscaras a nivel de articulación y a nivel de marco. Usamos el codificador de movimiento descrito anteriormente para obtener la representación del movimiento E y reconstruir el movimiento 3D. ¿Entonces calculamos? ¿Y GT 3D Deportes? Pérdida conjunta entre L3D. También agregamos una pérdida de velocidad LO, siguiendo trabajos previos [87, 132]. Por tanto, la pérdida de reconstrucción 3D viene dada por el contenido del artículo original.

Para el segundo desafío, observamos que los esqueletos 2D pueden servir como un medio versátil ya que pueden extraerse de una variedad de fuentes de datos de movimiento. Además, incorporamos videos RGB de exteriores en el marco de elevación de 2D a 3D para una capacitación previa unificada. ¿Para vídeo RGB, esqueleto 2D? puede darse mediante anotaciones manuales [3] o estimadores de pose 2D [14, 101], mientras que el canal de profundidad del esqueleto 2D extraído está esencialmente "ocluido". Asimismo, ¿agregamos enmascaramiento y ruido adicionales para degradar? (Si ? ya contiene ruido de detección, solo se aplica la máscara). ¿Ya que estos datos no están disponibles para 3D Sports GT? , aplicamos una pérdida de reproyección 2D ponderada dada por ? calcular.

en,? ¿Se estima movimiento 3D? Proyección ortográfica 2D de , mientras que δ ∈ RT×J viene dada por la anotación de visibilidad o la confianza de detección 2D.

¿La pérdida total previa al entrenamiento viene dada por la fórmula? calcular.

3.4 Ajustes específicos de tareas

Las incorporaciones de características aprendidas E sirven como representaciones del movimiento humano para la percepción 3D y del tiempo. Para las tareas posteriores, adoptamos un principio de diseño minimalista, que consiste en implementar una red aguas abajo poco profunda y entrenarla sin ninguna complejidad adicional. En la práctica, utilizamos capas lineales adicionales o un MLP que contiene una capa oculta. Luego ajustamos toda la red de un extremo a otro.

estimación de pose 3D

Dado que utilizamos el impulso de 2D a 3D como tarea previa al entrenamiento, simplemente reutilizamos toda la red previamente entrenada. Durante el ajuste fino, el esqueleto 2D de entrada se estima a partir del vídeo sin enmascaramiento ni ruido adicionales.

Reconocimiento de acciones basado en esqueletos. Realizamos directamente una agrupación promedio global entre diferentes personas y períodos de tiempo. Luego, los resultados se introducen en un MLP que contiene una capa oculta. La red se entrena mediante pérdida de clasificación de entropía cruzada. Para el aprendizaje de un solo disparo, aplicamos una capa lineal después de agrupar funciones para extraer representaciones de acciones a nivel de clip. Presentamos la configuración detallada para el aprendizaje de un solo disparo en la Sección 4.4.

Restauración de malla humana

Usamos el modelo SMPL [70] para representar la malla humana y hacer una regresión de sus parámetros. El modelo SMPL consta del parámetro de actitud θ ∈ R72 y el parámetro de forma β ∈ R10, y la cuadrícula 3D calculada es M(θ, β) ∈ R6890×3. Para hacer una regresión de los parámetros de pose en cada cuadro, ingresamos el movimiento que incorpora E en un MLP que contiene una capa oculta, lo que da como resultado θˆ ∈ RT×72. Para estimar los parámetros de forma, considerando que la forma del cuerpo humano en la secuencia de video debe ser consistente, primero promediamos el grupo E en la dimensión temporal, luego lo introducimos en otro MLP para hacer una regresión de un βˆ separado y luego lo expandimos a toda la secuencia. obtenemos βˆ ∈ RT×10. La estructura de la forma MLP es la misma que la de la regresión de pose, se inicializan con la forma media y la pose respectivamente, como se describe en [45]. La pérdida total se calcula de la siguiente manera:

Nota, ¿movimiento? ¿Cada pose 3D en el cuadro t pasa por un vértice de malla? devolver.

anotación de método

Hay muchas fórmulas en esta parte y la reescritura de Markdown es más problemática. ¿El autor usa? Si se omite el reemplazo, se recomienda consultar directamente el documento original .

La sección de descripción general describe el diseño general y la implementación específica del método. En primer lugar, los autores describen su enfoque en dos etapas, incluida una etapa previa al entrenamiento y una etapa de ajuste. Los datos de entrada que utilizaron fueron secuencias esqueléticas 2D porque este tipo de datos se puede extraer de manera confiable de una variedad de fuentes de movimiento y es muy resistente a los cambios.

Luego, presentan su arquitectura de red, DSTformer, que es un modelo de secuencia a secuencia adecuado para procesar datos de series temporales. Utilizaron la autoatención de múltiples cabezas (MHSA) espacial y temporal en esta red para capturar interacciones conjuntas intra e inter-frame, respectivamente.

En segundo lugar, diseñaron una arquitectura de flujo dual que considera información tanto espacial como temporal y puede equilibrar dinámicamente los pesos de fusión de los dos para adaptarse a diferentes características de entrada.

La sección de preentrenamiento unificado describe el método de preentrenamiento unificado, que resuelve principalmente dos problemas clave. En primer lugar, los autores utilizan una tarea de "completar espacios en blanco", que ocurre naturalmente en el análisis del movimiento humano, para aprender representaciones de movimiento sólidas. El objetivo de esta tarea es recuperar la información de profundidad perdida a partir de la observación visual 2D, es decir, la estimación de la pose humana en 3D. En segundo lugar, adoptaron un enfoque que utiliza esqueletos 2D como medio universal para extraer información de varias fuentes de datos de movimiento y entrenar previamente los esqueletos 2D para que la conversión de 2D a 3D de los esqueletos pueda usarse para unificar el entrenamiento previo.

La sección de ajuste específico de la tarea describe métodos de ajuste específico de la tarea. Los autores ajustaron las funciones aprendidas para adaptarlas a tareas específicas, como la estimación de pose 3D, el reconocimiento de acciones basado en esqueletos y la recuperación de mallas humanas. Para adaptarse a estas tareas, agregaron algunas modificaciones simples a la red previamente entrenada, como agregar capas lineales o usar MLP, y luego ajustaron la red de un extremo a otro. En cada tarea, adoptaron un enfoque adaptativo, como en la estimación de pose 3D, simplemente reutilizaron la red previamente entrenada, y en el reconocimiento de acciones basado en esqueleto, realizaron en diferentes personas y pasos de tiempo. Se realiza una agrupación promedio global y los resultados son alimentado al MLP. En la recuperación de malla humana, utilizan el modelo SMPL y adoptan un método de regresión de parámetros de pose para cada cuadro.

4. Experimentar

4.1 Implementación

Implementamos el codificador de acción Transformador espacial-temporal de flujo dual (DSTformer) propuesto utilizando una profundidad N = 5, un número de cabeza h = 8, un tamaño de característica Cf = 512 y un tamaño de incrustación Ce = 512. En la etapa de preentrenamiento, utilizamos una longitud de secuencia T = 243. Gracias al esqueleto basado en Transformer, el modelo previamente entrenado puede manejar diferentes longitudes de entrada. En la fase de ajuste fino, establecemos la tasa de aprendizaje del esqueleto en 0,1 veces la tasa de aprendizaje de la nueva capa. Presentaremos los conjuntos de datos experimentales por separado en las siguientes secciones. Consulte el material complementario para obtener más detalles experimentales.

anotación

Esta sección describe los detalles de implementación del experimento. DSTformer es un modelo de aprendizaje profundo basado en Transformer que se utiliza para aprender y codificar información del movimiento humano a partir de datos. Entre ellos, la profundidad (N) representa el número de capas del modelo, el número de cabezas (h) es un parámetro clave del Transformador, que controla el paralelismo del modelo, y el tamaño de la característica (Cf) y el tamaño de incrustación ( Ce) describir los datos de entrada y los datos de salida.parámetros de tamaño. La longitud de la secuencia (T) de la etapa de preentrenamiento se refiere al número de fotogramas consecutivos procesados por el modelo en una sesión de entrenamiento.

4.2 Pre-entrenamiento

Recopilamos datos de movimiento humano en 3D ricos y realistas de dos conjuntos de datos, Human3.6M [37] y AMASS [74]. Human3.6M [37] es un conjunto de datos de estimación de pose humana en 3D en interiores de uso común, que contiene 3,6 millones de fotogramas de vídeo en los que actores profesionales realizan acciones diarias. Con referencia a trabajos anteriores [76, 87], utilizamos los sujetos 1, 5, 6, 7 y 8 para el entrenamiento, y los sujetos 9 y 11 para las pruebas. AMASS [74] integra la mayoría de los conjuntos de datos de captura de movimiento basados en marcadores (Mocap) existentes [1, 2, 5, 11, 15, 18, 33, 36, 51, 68, 71, 75, 82, 95, 108, 109 ] y utiliza un método de representación unificado. En la etapa previa al entrenamiento, no utilizamos las imágenes ni los resultados de detección 2D de los dos conjuntos de datos porque el conjunto de datos Mocap generalmente no proporciona videos sin procesar. En su lugar, utilizamos una proyección ortogonal para obtener un esqueleto 2D no contaminado. También combinamos dos conjuntos de datos de video RGB, PoseTrack [3] (anotado) e InstaVariety [41] (sin anotar) para mejorar la diversidad de movimiento. Alineamos la definición de puntos clave del cuerpo humano con Human3.6M y calibramos las coordenadas de la cámara a coordenadas de píxeles de acuerdo con [27]. Ponemos a cero aleatoriamente el 15% de las uniones y tomamos muestras de ruido a partir de una mezcla de distribuciones gaussianas y uniformes [17]. Primero entrenamos con datos 3D solo durante 30 épocas, y luego entrenamos con datos 3D y datos 2D durante 60 épocas, lo que sigue la práctica del aprendizaje del curso [9, 116].

anotación

En la etapa previa al entrenamiento, los investigadores utilizaron dos conjuntos de datos diferentes: Human3.6M y AMASS, los cuales contienen una gran cantidad de datos de acción humana en 3D. También introdujeron dos conjuntos de datos de vídeo RGB salvajes, PoseTrack e InstaVariety, para aumentar la diversidad de los datos de entrenamiento. Para manejar las diferencias en los conjuntos de datos, los investigadores unificaron las definiciones de puntos clave en los conjuntos de datos y calibraron las coordenadas de la cámara en coordenadas de píxeles. Además, introdujeron ruido y abandonos aleatorios en el entrenamiento para hacer el modelo más robusto.

4.3 Estimación de pose 3D

Evaluamos el rendimiento de la estimación de pose 3D en Human3.6M [37] e informamos el error medio por posición de la articulación (MPJPE) en mm, que mide la posición de la articulación prevista y la verdad del terreno después de alinear la distancia promedio de la articulación de la raíz entre ellas. Usamos una red Hourglass (SH) apilada [84] para extraer esqueletos 2D de videos y ajustar toda la red en el conjunto de entrenamiento Human3.6M [37]. Además, entrenamos otro modelo con la misma estructura, pero sin pesos previamente entrenados, se inicializaron aleatoriamente. Como se muestra en la Tabla 1 (arriba), el modelo entrenado desde cero supera los enfoques anteriores, incluidos otros diseños basados en Transformer que emplean modelado espacio-temporal. Esto muestra la efectividad de nuestro DSTformer propuesto en el aprendizaje de estructuras geométricas 3D y dinámica temporal. Para evaluar más a fondo el rendimiento del límite superior del modelo, comparamos el rendimiento cuando utilizamos secuencias de pose 2D GT como entrada, lo que elimina el impacto de diferentes detectores 2D. Como se muestra en la Tabla 1 (abajo), nuestro modelo supera significativamente a todos los métodos anteriores. Atribuimos la ventaja de rendimiento de nuestro modelo desde cero al diseño DSTformer propuesto. Proporcionamos más comparaciones y análisis en la Sección 4.6 y materiales complementarios para demostrar las ventajas de DSTformer sobre otras arquitecturas de espacio-tiempo. Además, nuestro método logra menores errores a través de la etapa de preentrenamiento propuesta.

。

anotación

En los experimentos de estimación de pose 3D, los investigadores utilizaron el error medio por posición de articulación (MPJPE) para medir el rendimiento del modelo. Compararon el rendimiento del modelo cuando se utilizaron pesas previamente entrenadas y el entrenamiento desde cero, y los resultados mostraron que el modelo entrenado desde cero con DSTformer se desempeñó mejor en esta tarea que otros métodos. Además, su modelo también supera a todos los métodos anteriores cuando los datos de entrada son secuencias de pose reales 2D, lo que demuestra aún más la superioridad de DSTformer.

4.4 Reconocimiento de acciones basado en esqueletos

Exploramos más a fondo la posibilidad de aprender la semántica de la acción con representaciones de movimiento humano previamente entrenadas. Utilizamos el conjunto de datos de acción humana NTU-RGB+D, que contiene 57.000 vídeos de 60 categorías de acción, que dividimos por temas cruzados (X-Sub) y vistas cruzadas (X-View) del conjunto de datos. También hay una versión ampliada de este conjunto de datos, NTU-RGB+D-120, que contiene vídeos de 114K de 120 categorías de acción. Seguimos el protocolo de reconocimiento de acción única propuesto en NTU-RGB+D-120. Para ambos conjuntos de datos, utilizamos HRNet para extraer esqueletos 2D. Nuevamente, entrenamos un modelo inicializado aleatoriamente para comparar. Como se muestra en la Tabla 2 (izquierda), nuestro método funciona comparablemente bien o mejor que los métodos más modernos. Vale la pena señalar que la etapa de preentrenamiento ha jugado un gran papel en la mejora del rendimiento.

Además, profundizamos en la aplicación en configuraciones de disparo único, lo cual es importante para aplicaciones prácticas. Las aplicaciones prácticas suelen requerir el reconocimiento de movimientos finos en campos específicos como la educación, los deportes y la medicina. Sin embargo, las categorías de acción en estos escenarios generalmente no están definidas en conjuntos de datos públicos. Por lo tanto, solo hay disponibles anotaciones limitadas para estas nuevas categorías de acciones, lo que dificulta la identificación precisa. Informamos los resultados del conjunto de evaluación para 20 categorías nuevas con solo 1 video etiquetado por categoría. El conjunto auxiliar contiene las otras 100 categorías y todas las muestras de estas categorías están disponibles. Utilizamos técnicas de aprendizaje contrastivo supervisado para entrenar el modelo en el conjunto auxiliar. Para un lote de datos auxiliares, las muestras de la misma categoría se acercan al espacio de incrustación de acciones, mientras que las muestras de diferentes categorías se alejan. Durante la evaluación, calculamos la distancia del coseno entre la muestra de prueba y el ejemplo y utilizamos el vecino más cercano para determinar la clase. La Tabla 2 (derecha) muestra que nuestro modelo propuesto supera significativamente a los métodos más modernos en la comparación. Además, vale la pena señalar que nuestro modelo previamente entrenado alcanza un rendimiento óptimo después de 1 o 2 rondas de ajuste. Nuestros resultados muestran que la fase previa al entrenamiento es efectiva para aprender una representación de movimiento sólida que se generaliza bien a nuevas tareas posteriores, incluso con anotaciones de datos limitadas.

anotación

Esta sección explora principalmente la posibilidad de utilizar representaciones de movimiento humano previamente entrenadas para el reconocimiento de acciones y utiliza el conjunto de datos NTU-RGB + D para la verificación. Este conjunto de datos es un gran conjunto de datos para el reconocimiento de acciones y contiene vídeos y categorías de acciones enriquecidas. Los autores encuentran que los modelos de representación del movimiento humano previamente entrenados funcionan bien en tareas de reconocimiento de acciones y exhiben fuertes capacidades de generalización incluso con anotaciones de datos limitadas.

4.5 Restauración de la Malla Humana

Realizamos experimentos con los conjuntos de datos Human3.6M y 3DPW, y agregamos el conjunto de datos COCO durante el entrenamiento. Seguimos la práctica anterior y mantuvimos la división de entrenamiento y prueba de los dos conjuntos de datos. Seguimos la práctica pública e informamos MPJPE (mm) y PA-MPJPE (mm) para 14 uniones obtenidas por JM (θ, β). PA-MPJPE calcula MPJPE después de la traslación, rotación y alineación de escala. Además, informamos el error medio por vértice (MPVE) (mm) de la malla generada por M (θ, β), que mide la distancia promedio entre los vértices estimados y los vértices GT después de alinear las uniones de raíz. Vale la pena señalar que la mayoría de los trabajos anteriores utilizan más conjuntos de datos que COCO durante el entrenamiento, como LSP, MPI-INF3DHP, etc., mientras que nosotros no. La Tabla 3 demuestra que nuestro modelo ajustado proporciona resultados competitivos en conjuntos de datos Human3.6M y 3DPW, superando todos los métodos basados en video de última generación, incluido MAED, especialmente en errores MPVE. Sin embargo, observamos que estimar una malla de cuerpo completo a partir de escasos puntos clave 2D es un problema mal planteado ya que carece de información sobre la forma del cuerpo humano. Con esto en mente, proponemos un enfoque híbrido que explota las fortalezas de nuestro marco (movimiento coherente) y los métodos basados en RGB (forma precisa). Presentamos un módulo de refinamiento que se puede combinar fácilmente con métodos existentes basados en imágenes/vídeo, similar al trabajo anterior. Específicamente, nuestro módulo de refinamiento es un MLP que toma una combinación de nuestra representación de movimiento previamente entrenada y predicciones iniciales, y hace una regresión de los residuos en las rotaciones de las articulaciones. Nuestro método mejora efectivamente los métodos más modernos y logra el error más bajo hasta la fecha.

anotación

Esta sección presenta principalmente la situación experimental de la tarea de recuperación de malla humana. La recuperación de mallas humanas es una tarea 3D que requiere estimar poses humanas 3D a partir de imágenes 2D.

En esta tarea, el modelo de representación del movimiento humano previamente entrenado también mostró un buen rendimiento. Sin embargo, dado que estimar la malla de todo el cuerpo a partir de escasos puntos clave 2D es un problema muy difícil, los autores adoptan un enfoque híbrido que combina representaciones de movimiento humano previamente entrenadas y métodos basados en RGB para mejorar aún más el resultado de la restauración de la red del cuerpo humano.

4.6 Estudios de ablación

Ajustar o empezar desde cero

Comparamos el progreso del entrenamiento mediante el ajuste fino utilizando un modelo previamente entrenado versus el entrenamiento desde cero. Como se muestra en la Figura 3, el modelo inicializado con pesos previamente entrenados muestra un rendimiento superior y una convergencia más rápida en las tres tareas. Esta observación sugiere que el modelo previamente entrenado aprende conocimientos transferibles sobre el movimiento humano, lo que facilita el aprendizaje para múltiples tareas posteriores.

ajuste local

Además del ajuste fino de un extremo a otro, congelamos la columna vertebral del codificador de movimiento y solo entrenamos en el cabezal de regresión para cada tarea posterior. Para verificar la efectividad de las representaciones de movimiento previamente entrenadas, comparamos codificadores de movimiento previamente entrenados con codificadores de movimiento inicializados aleatoriamente. Informamos resultados de pose y malla 3D en Human3.6M, y resultados de movimiento en NTU-RGB+D y NTU RGB+D-120 (lo mismo se aplica a las tablas a continuación). Como se puede ver en la Tabla 4, según la representación de movimiento congelada previamente entrenada, nuestro método aún logra un rendimiento competitivo en múltiples tareas posteriores y logra mejoras sustanciales en comparación con la línea de base. El entrenamiento previo y el ajuste parcial permiten que todas las tareas posteriores compartan la misma red troncal, lo que reduce significativamente la carga computacional para las aplicaciones de inferencia multitarea.

Estrategia previa al entrenamiento

Evaluamos cómo las diferentes estrategias de preentrenamiento afectan el desempeño de las tareas posteriores. Partiendo de una línea base desde cero, aplicamos una a una las estrategias propuestas. Como se muestra en la Tabla 5, una etapa básica de preentrenamiento de 2D a 3D es beneficiosa para todas las tareas posteriores. La introducción de daños mejora aún más las incorporaciones de movimiento aprendidas. El preentrenamiento uniforme con videos en la naturaleza (w. 2D) disfruta de una mayor diversidad de movimiento, lo que ayuda aún más en varias tareas posteriores.

Entrenamiento con diferentes intervenciones primarias. Investigamos más a fondo la generalización del método de preentrenamiento propuesto. Reemplazamos la columna vertebral del codificador de movimiento con dos variantes: TCN [87] y PoseFormer [133]. El modelo se modificó ligeramente a una versión seq2seq y simplemente se siguieron todas las configuraciones previas al entrenamiento y ajuste. La Tabla 6 muestra cómo el método propuesto produce beneficios consistentes para diferentes modelos troncales en diferentes tareas.

Arquitectura modelo

Finalmente, investigamos las opciones de diseño de DSTformer. De (a) a (f) de la Tabla 8, comparamos diferentes diseños estructurales del módulo transformador básico. (a) y (b) son versiones de flujo único con secuencias diferentes. (a) Conceptualmente similar a PoseFormer [133], MH Former [55] y MixSTE [132]. (c) Restringir cada flujo al modelado temporal o espacial antes de la fusión, similar a MAED [112]. (d) Conexión directa de S-MHSA y T-MHSA sin MLP en el medio, similar a la variante MSA-T en MAED [112]. (e) Reemplazar la fusión adaptativa en dos corrientes con agrupación promedio. (f) es nuestro diseño DSTformer propuesto. Las estadísticas resultantes confirman nuestro principio de diseño de que ambas corrientes deben ser capaces y complementarias al mismo tiempo, como se presentó en la Sección 3.2. Además, encontramos que emparejar cada bloque de autoatención con un MLP es crucial, ya que puede proyectar las interacciones de las características aprendidas y generar no linealidad. En general, diseñamos la arquitectura del modelo para la tarea de estimación de pose 3D y la aplicamos a todas las demás tareas sin ajustes adicionales.

5. Conclusión y discusión

En este trabajo, proporcionamos una perspectiva unificada para resolver varias tareas de video antropocéntricas . Desarrollamos un método de preentrenamiento para aprender representaciones del movimiento humano a partir de fuentes de datos heterogéneas y a gran escala. También proponemos DSTformer como codificador de movimiento humano general. Los resultados experimentales en múltiples puntos de referencia demuestran la versatilidad de las representaciones de movimiento aprendidas. Hasta ahora, este trabajo se ha centrado principalmente en el procesamiento de datos esqueléticos de una sola persona. El trabajo futuro podría explorar la fusión de representaciones de movimiento aprendidas con arquitecturas de video generales como características semánticas antropocéntricas, aplicarlas a más tareas (por ejemplo, evaluación de acciones, segmentación) y modelar explícitamente las interacciones humanas.

anotación

La principal contribución de este artículo es proponer una perspectiva unificada para resolver diversas tareas de vídeo centradas en el ser humano. Los autores primero entrenan un codificador de movimiento a través de una etapa de preentrenamiento para aprender representaciones del movimiento humano a partir de fuentes de datos grandes y mixtas. Luego realizaron múltiples tareas posteriores ajustando el codificador de movimiento previamente entrenado. Los estudios de ablación muestran que, en comparación con el entrenamiento desde cero, los modelos previamente entrenados tienen ventajas significativas en rendimiento y velocidad de convergencia, lo que demuestra que sus representaciones de movimiento aprendidas son transferibles. Además, la eficacia de esta estrategia de preentrenamiento no se ve afectada por la columna vertebral del codificador de movimiento, lo que demuestra su generalización. En términos de arquitectura modelo, el autor propuso DSTformer, una nueva estructura de red que aprende y expresa efectivamente la relación espaciotemporal entre las articulaciones óseas. El trabajo futuro explorará más a fondo aplicaciones adicionales de esta representación de movimiento.