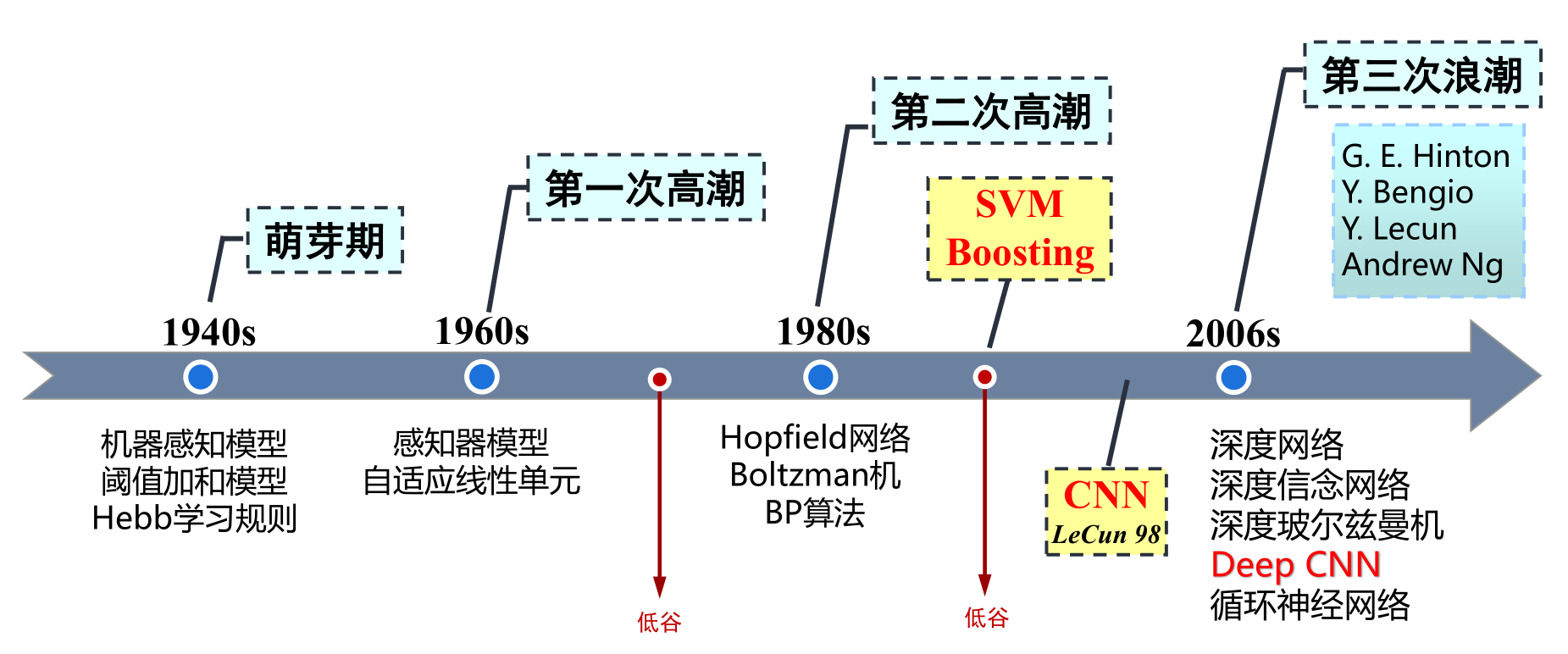

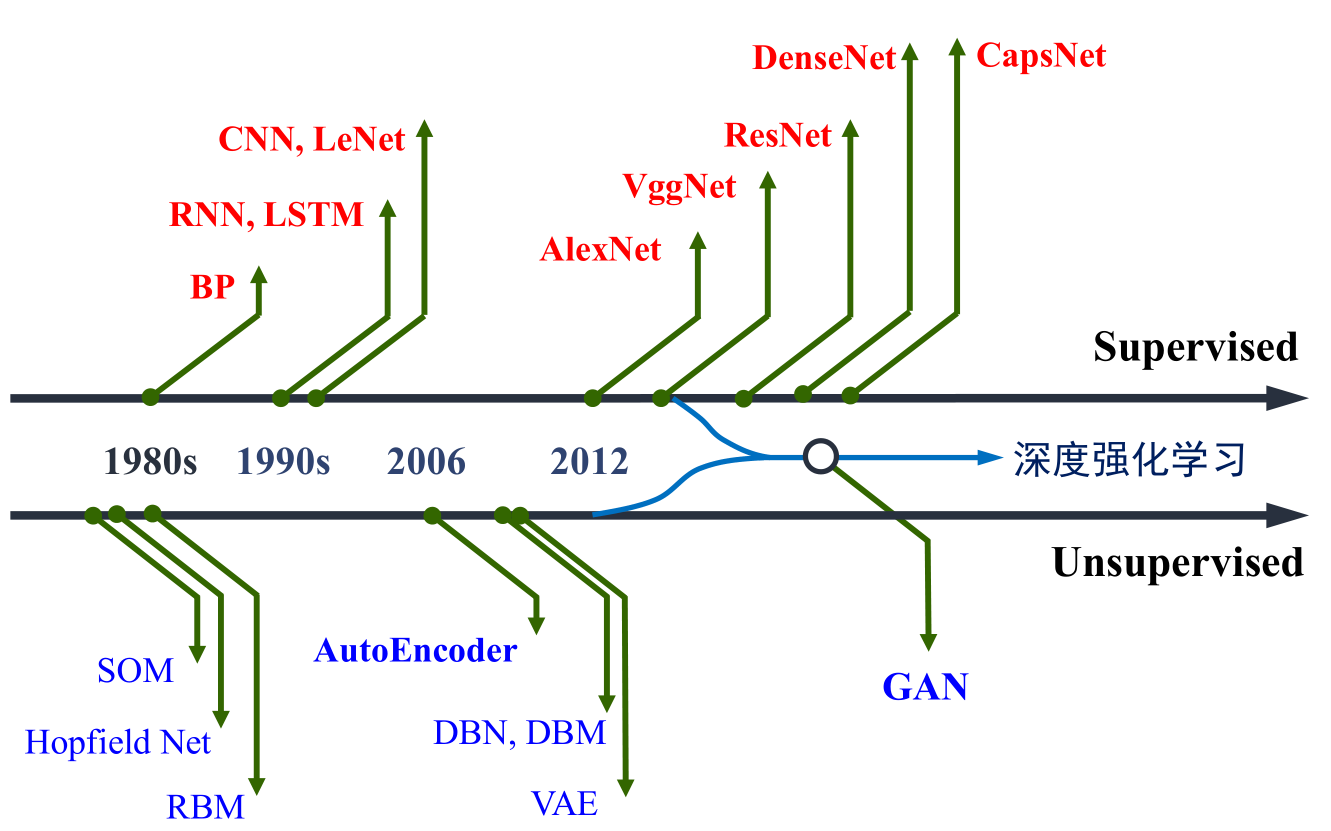

Ola de desarrollo de redes neuronales artificiales

La tercera ola: el profesor de redes neuronales convolucionales

de la Universidad de Toronto, Canadá, Geoffery Hinton, un maestro en el campo del aprendizaje automático, y sus alumnos publicaron un artículo en "Science" (Hinton, G. E. Reducing the Dimensionality of Data with Neural Networks [J].Science, 2006, 313(5786):504-507.), ¡abrió una nueva ola de aprendizaje profundo en la academia y la industria!

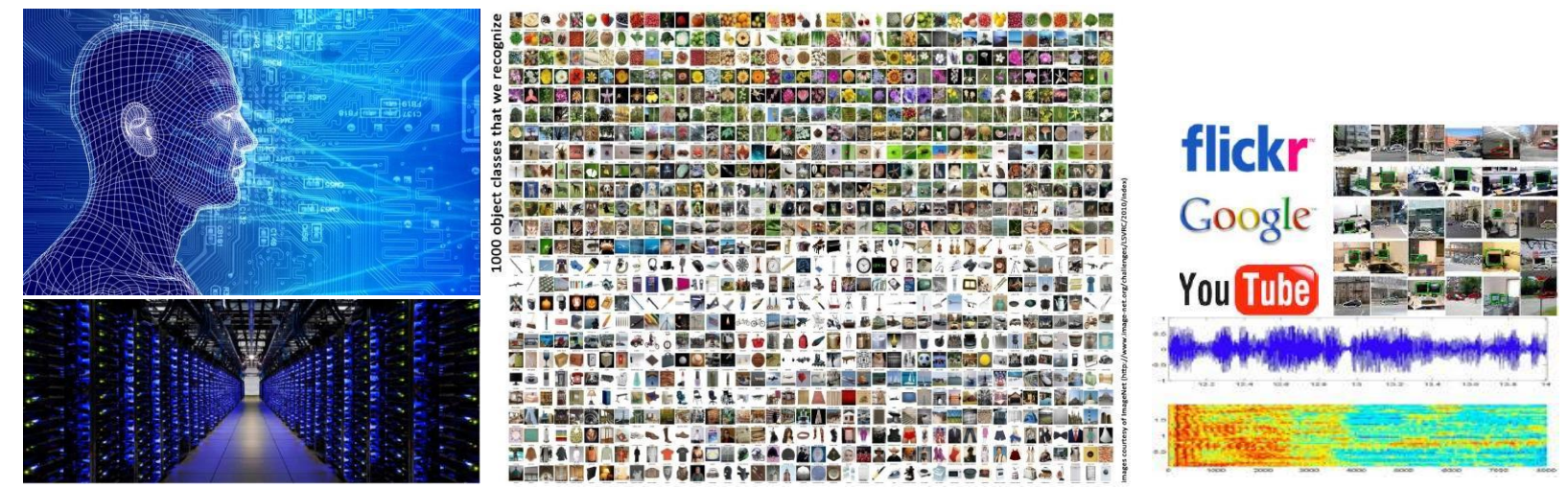

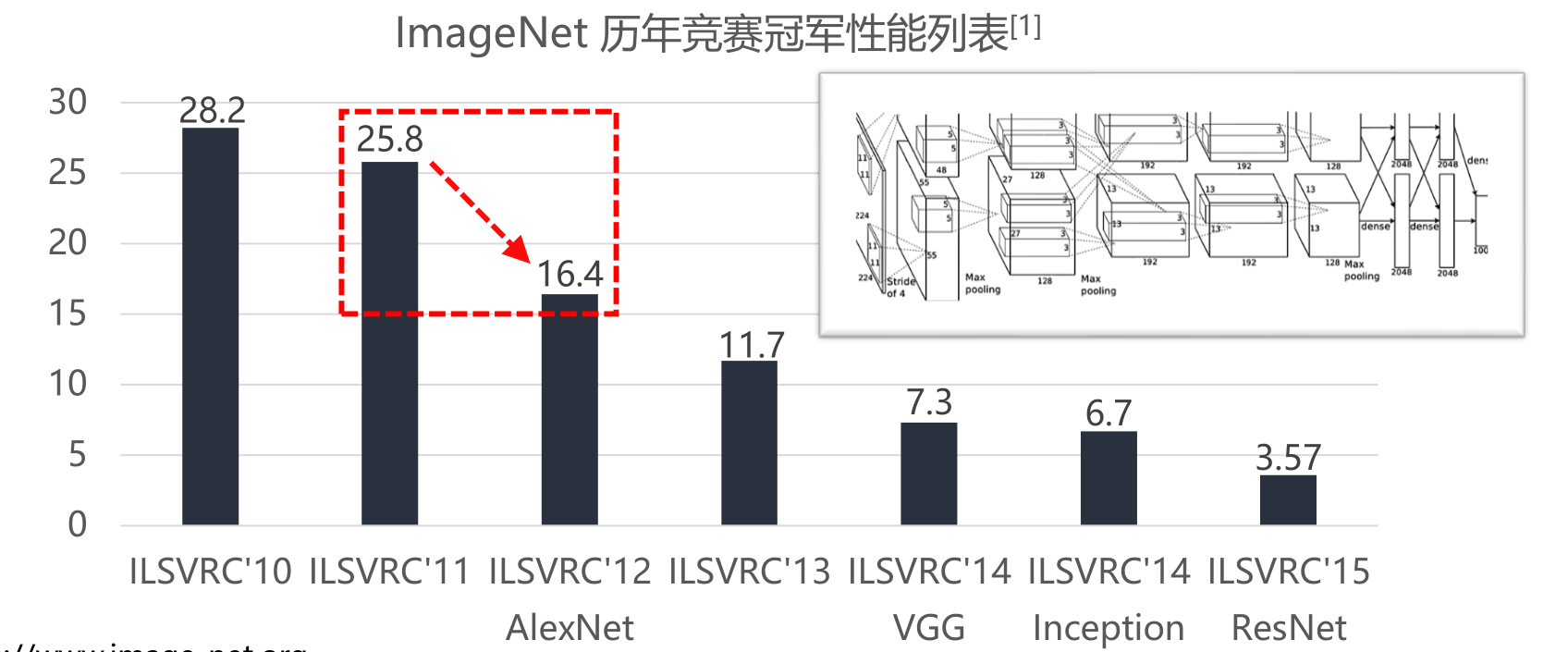

Fue la competencia ImageNet en 2012 lo que realmente hizo que la red neuronal convolucional recibiera una atención generalizada.

Cálculo de convolución y estructura de red neuronal convolucional

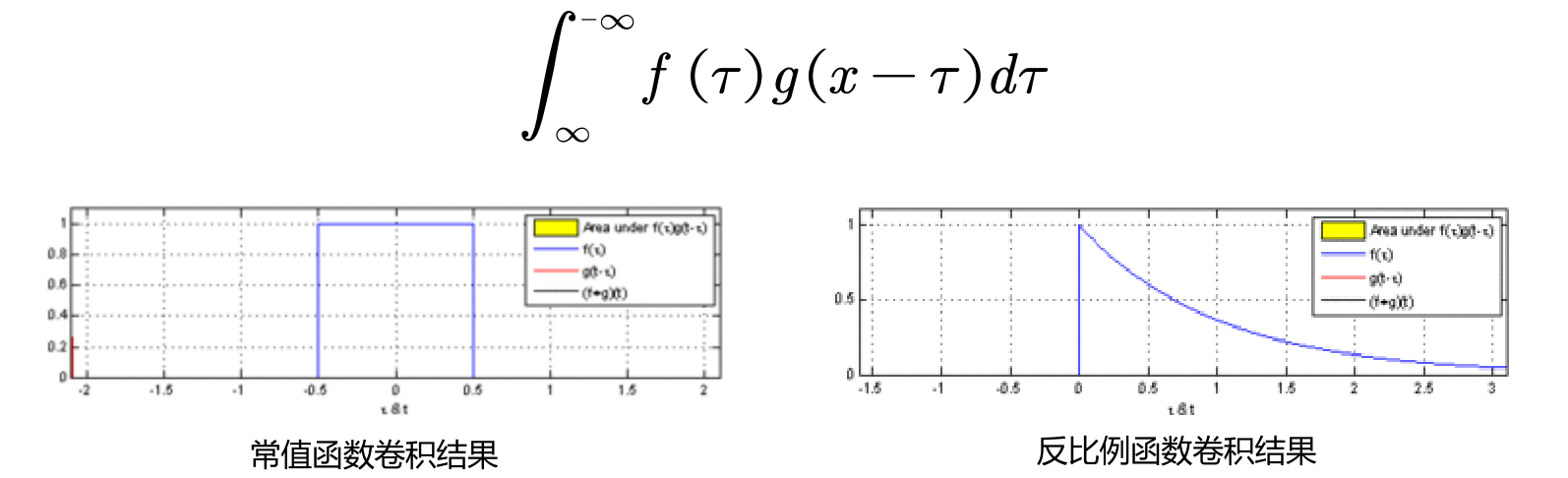

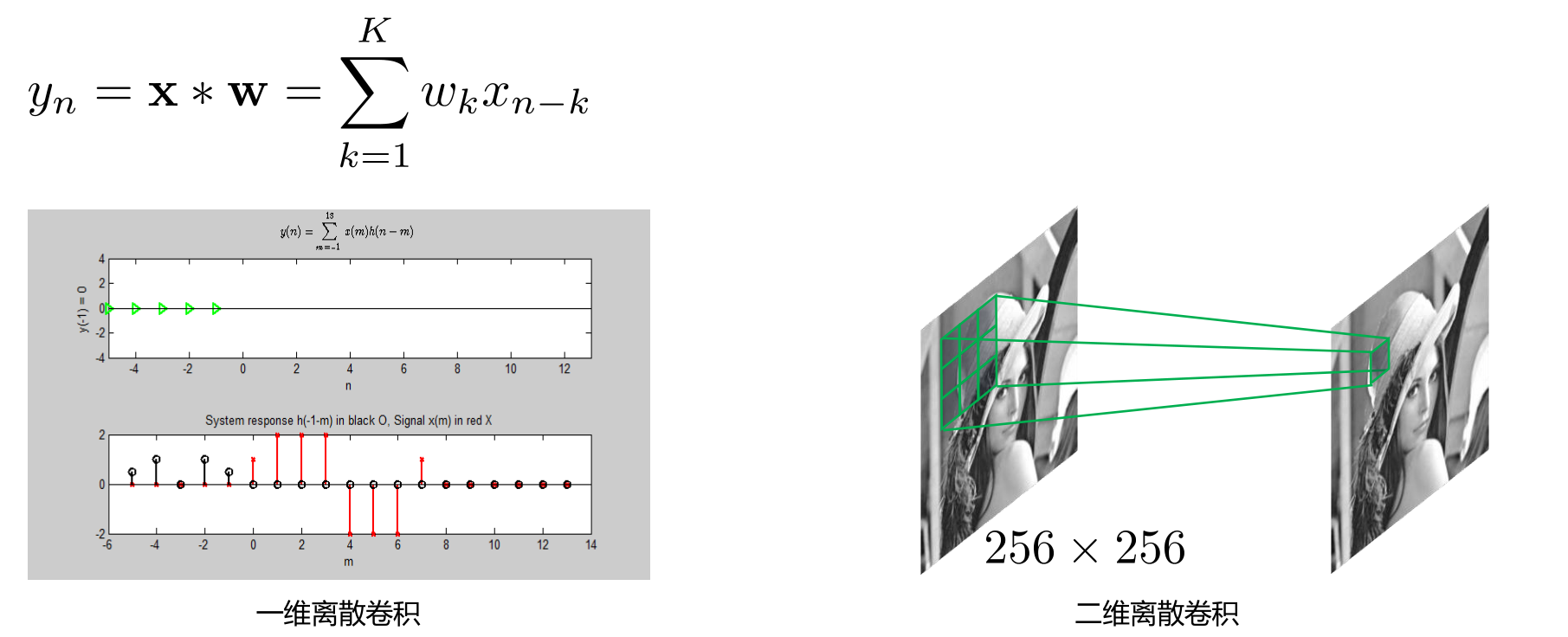

Definición de convolución

- La convolución es una operación importante en matemáticas analíticas.

- Sean f(x) y g(x) dos funciones integrables en R

- La convolución de forma continua se define de la siguiente manera

- convolución espacial discreta

- La convolución de forma continua se define de la siguiente manera

Conceptos básicos en convolución

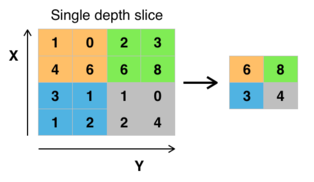

- Tamaño del núcleo: el campo receptivo de la operación de convolución En la convolución bidimensional, el tamaño general del núcleo de la convolución es un número impar, principalmente para hacer coincidir el centro del núcleo de la convolución con el centro del resultado del cálculo. Por lo general, se establece en 3, es decir, el tamaño del kernel de convolución es 3×3.

- Stride: el tamaño de zancada del kernel de convolución al atravesar la imagen, el valor predeterminado generalmente se establece en 1

- Expansión de límite (relleno): el método de procesamiento del límite de la muestra, generalmente para hacer que el tamaño de entrada sea consistente con el tamaño del resultado de la convolución.

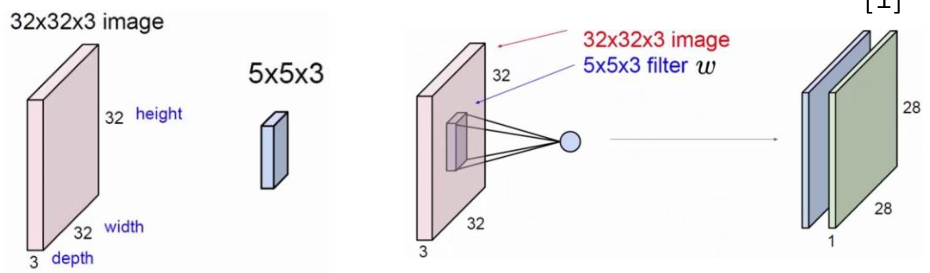

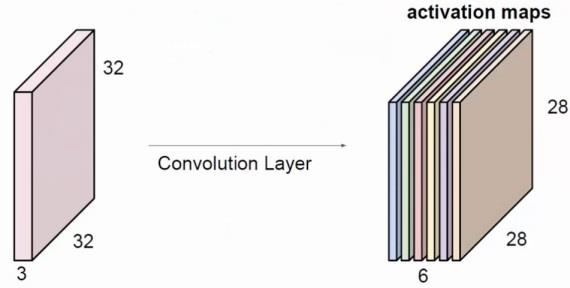

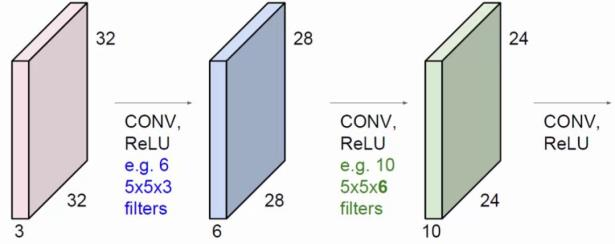

- Canales de entrada y salida (Canales): Al construir una capa convolucional, es necesario definir el número de canales de entrada I y el número de canales de salida O. La cantidad de parámetros de cada capa de red es I×O×K (K es el número de parámetros del kernel de convolución)

Las características de la convolución.

- Los cálculos de convolución son cálculos locales.

- Las circunvoluciones son detectores de características.

Más animaciones de convolución

Animaciones de convolución

NB: los mapas azules son entradas y los mapas cian son salidas.

|

|

|

|

|---|---|---|---|

| Sin relleno, sin zancadas | Relleno arbitrario, sin zancadas | Medio acolchado, sin zancadas. | Acolchado completo, sin zancadas. |

|

|

|

|

| Sin relleno, zancadas | acolchado, zancadas | Relleno, zancadas (impares) |

Animaciones de convolución transpuestas

NB: los mapas azules son entradas y los mapas cian son salidas.

|

|

|

|

|---|---|---|---|

| Sin relleno, sin zancadas, transpuesto | Relleno arbitrario, sin zancadas, transpuesto | Medio acolchado, sin zancadas, transpuesto | Acolchado completo, sin zancadas, transpuesto |

|

|

|

|

| Sin relleno, zancadas, transpuesto | Relleno, zancadas, transpuesto | Relleno, zancadas, transpuesto (impar) |

Animaciones de convolución dilatada

NB: los mapas azules son entradas y los mapas cian son salidas.

|

|---|

| Sin relleno, sin zancada, dilatación |

Conceptos básicos: agrupación, conexión completa

-

capa de agrupación

- Convolución de forma especial.

- Reducción de dimensionalidad, reducción de cálculo de datos, mitigación de sobreajuste, invariancia de características (traducción, escala)

-

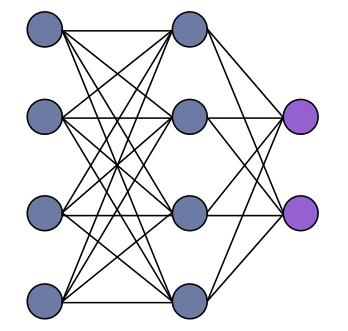

capa completamente conectada

- Capa de salida del modelo

- clasificación, regresión

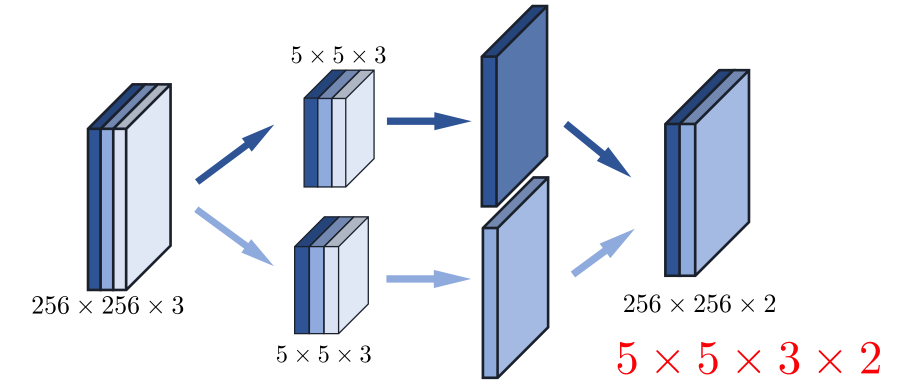

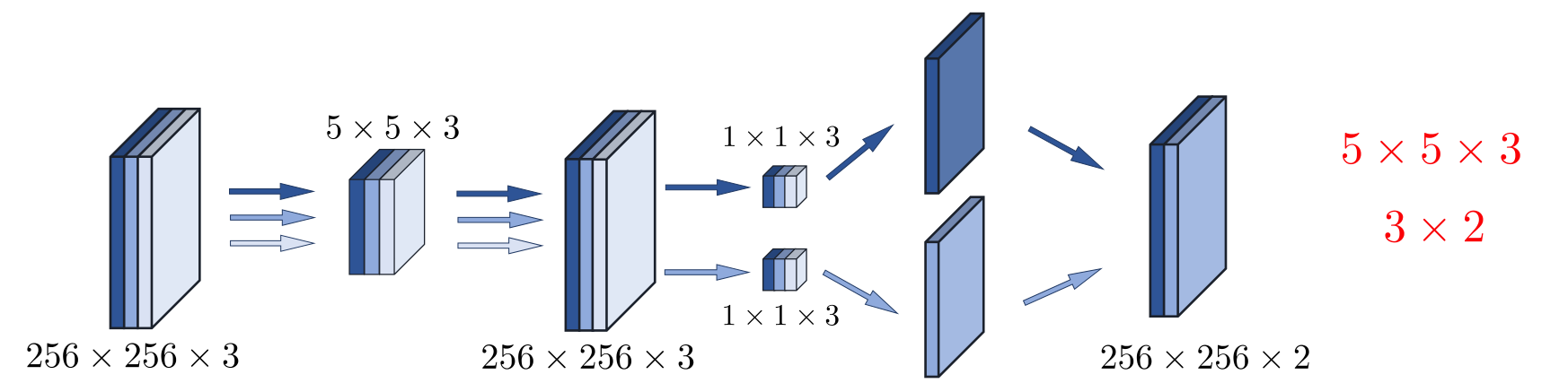

Ejemplo de red neuronal convolucional multicapa

|

|

|

|---|---|---|

| El tamaño del kernel de convolución es 5 * 5, el tamaño del paso es 1, el límite no se expande, el canal de entrada es 3 y el canal de salida es 2 | El número de canales de salida es 6 y otros parámetros permanecen sin cambios. | El número de canales de salida de la primera capa es 3 y el número de canales de salida de la segunda capa es 6. |

La historia del desarrollo de la red neuronal convolucional.

¿Por qué puede obtener un desarrollo rápido:

- Explosión de datos: datos de imagen, datos de texto, datos de voz, datos de redes sociales, computación científica, etc.

- El rendimiento informático se ha mejorado considerablemente.

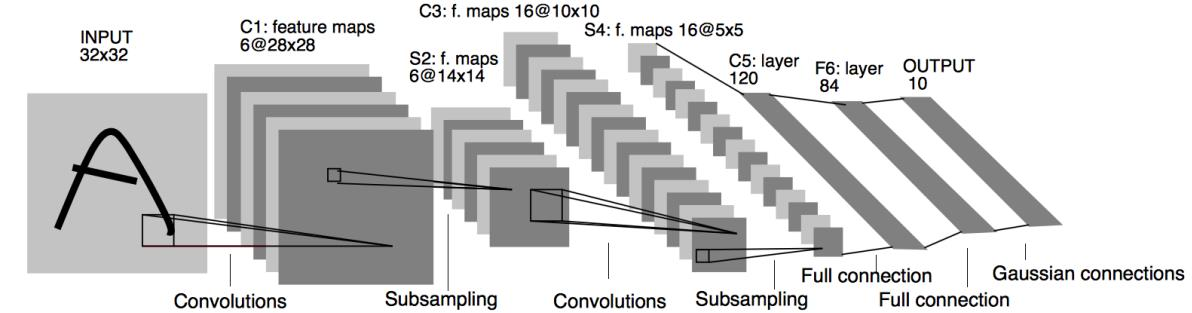

Los fundamentos de la estructura de la red neuronal convolucional moderna - LeNet

- LeNet nació en 1994 y fue propuesta por Yann LeCun para el reconocimiento y clasificación de caracteres escritos a mano.

- Estructura de red de 6 capas: dos capas convolucionales, dos capas de reducción de muestreo y dos capas completamente conectadas

- La capa de convolución consta de dos partes: cálculo de convolución y función de activación no lineal sigmoidea

El foco de la investigación se dirige a las redes neuronales convolucionales - AlexNet, VGGNet

- Red más profunda: AlexNet tiene un total de 8 capas y VGGNet tiene un total de 16 o 19 capas

- Aumento de datos: para mejorar la capacidad de generalización del modelo, la imagen original de 256 × 256 se recorta aleatoriamente para obtener una imagen con un tamaño de 224 × 224, que se ingresa en la red para entrenamiento

- Función de activación no lineal ReLU: reduce la cantidad de cálculo, alivia la desaparición del gradiente y alivia el sobreajuste. La función de activación de ReLU se ha convertido ahora en la función de activación más general en redes neuronales.

- Dropout: Las neuronas en la capa completamente conectada se desactivan con cierta probabilidad, y las neuronas desactivadas ya no participan en el entrenamiento. La referencia de Dropout alivia eficazmente el sobreajuste del modelo

- Capacitación previa: Primero capacite una parte de la red pequeña para garantizar la estabilidad y luego profundice gradualmente la red sobre esta base.

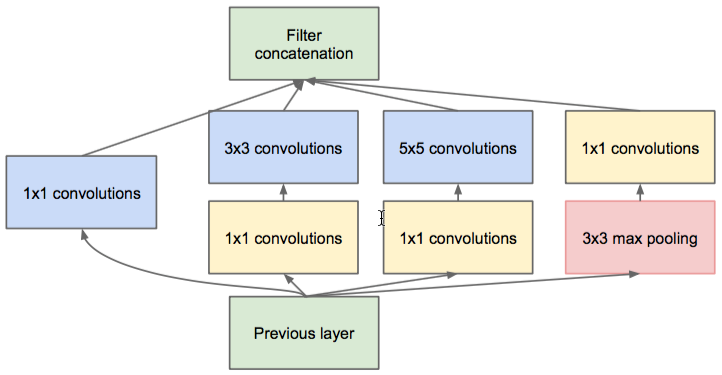

Expansión de ancho y profundidad de red neuronal convolucional - GoogLeNet

- La red es más profunda: GoogLeNet tiene un total de 22 capas

- Estructura multirresolución: introduzca la estructura Inception para reemplazar la convolución tradicional + activación

- Reducción de cálculo: use el kernel de convolución 1×1 para lograr la reducción de la dimensionalidad de los datos

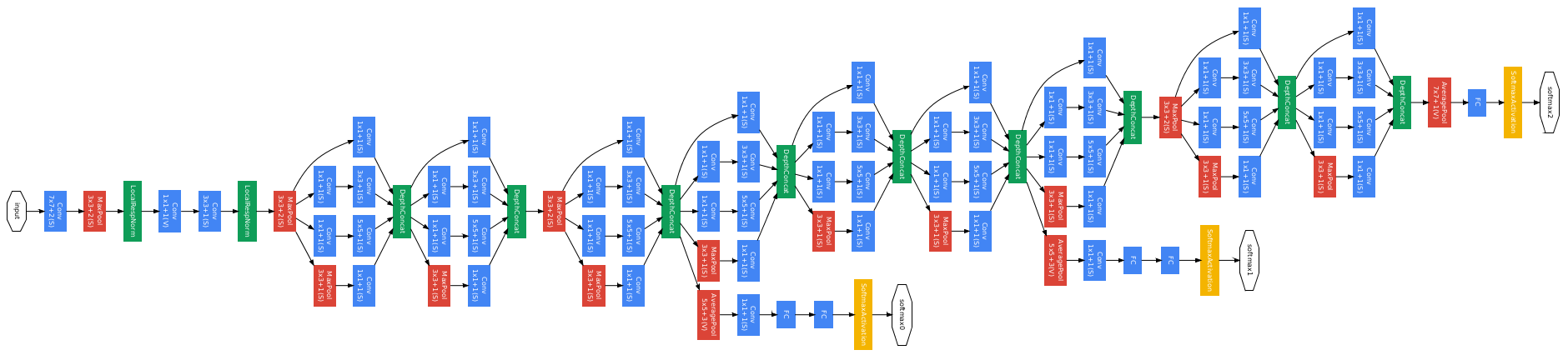

Estructura inicial

Estructura de GoogLeNet

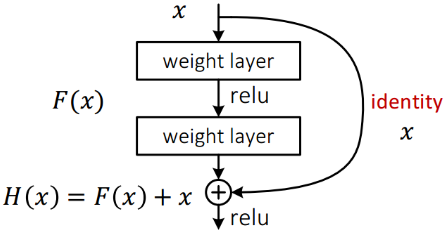

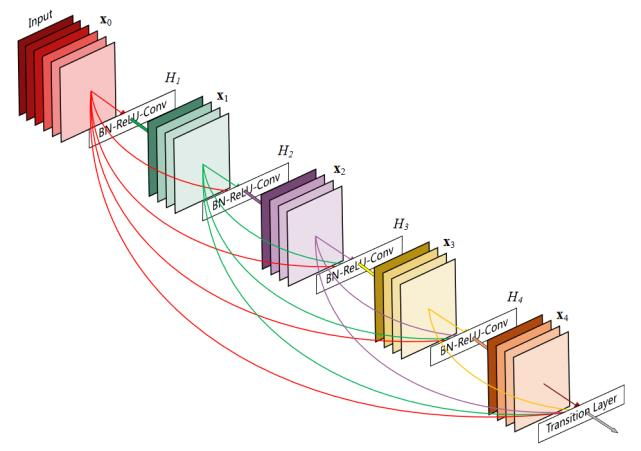

Profundidad, ancho y expansión de la red neuronal convolucional - ResNet, DenseNet

- Red más profunda: ResNet tiene más de cien capas (ResNet-101)

- Conexión residual: las características se transfieren a través de dos rutas, la ruta normal y el atajo

- Omitir conexión: las funciones de bajo nivel se fusionan con funciones de alto nivel

| Diagrama esquemático de la conexión residual ResNet | Diagrama esquemático de la estructura DenseNet |

|---|---|

|

|

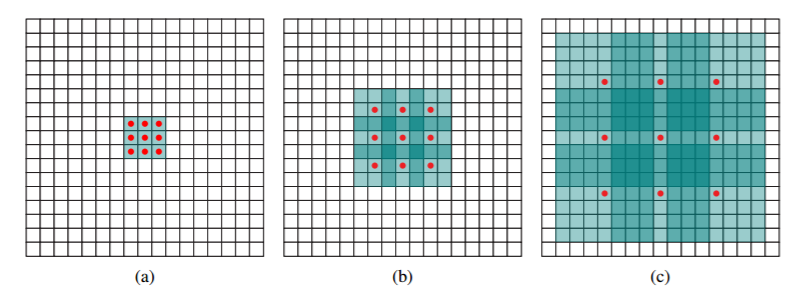

Extensión de generalización de redes neuronales convolucionales

- Convolución separable en profundidad

- convolución de 5×5 canales

- Convolución 1×1 para fusionar las características de cada canal

- Convolución atrosa (convolución dilatada)

- entrada local sin cambios

- El campo receptivo se vuelve más grande.

| Campo receptivo convolucional dilatado | Proceso de cálculo de la convolución de Atrous |

|---|---|

|

|

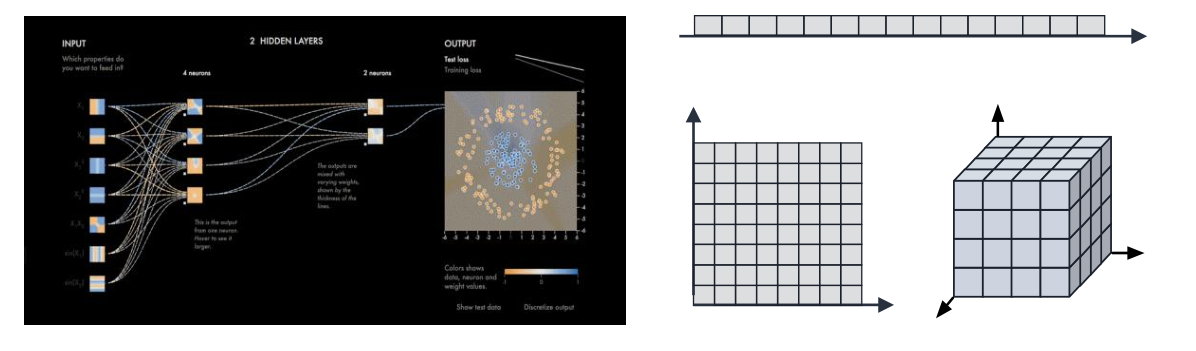

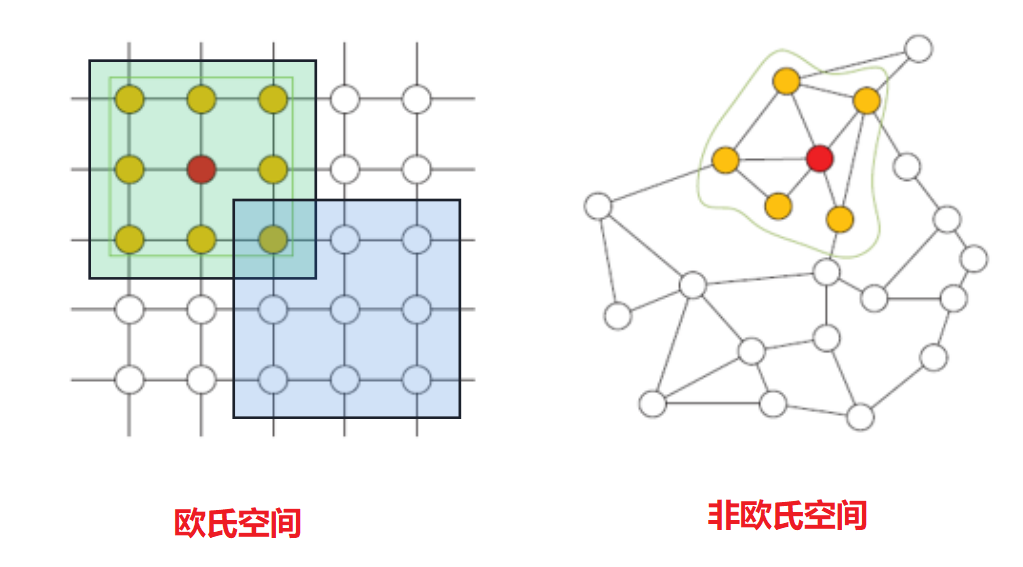

Paradigma computacional de red neuronal convolucional

- Espacio europeo multidimensional

- respuesta espacial local

- Compartir parámetros de convolución

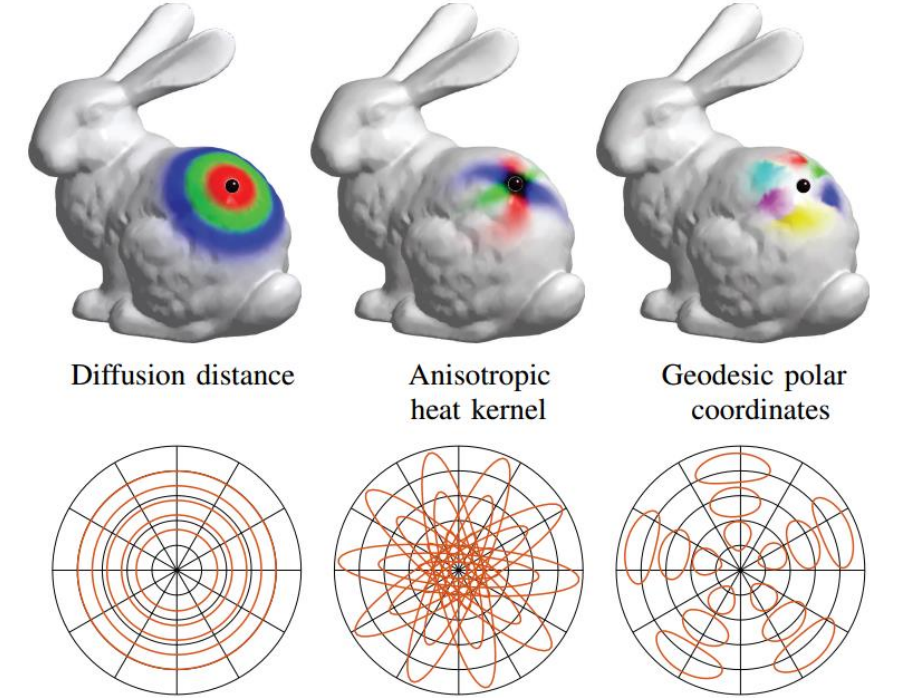

Redes neuronales convolucionales extendidas a espacios no euclidianos

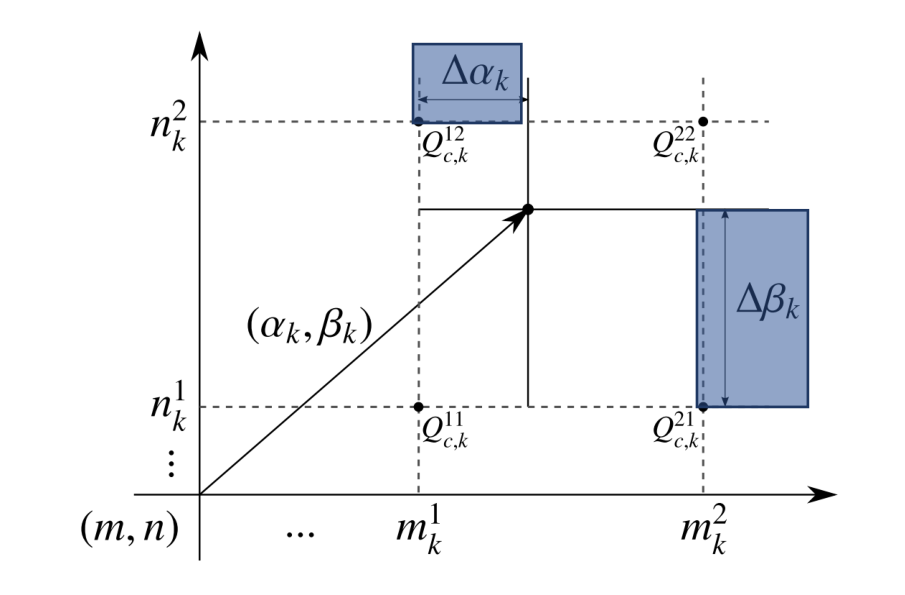

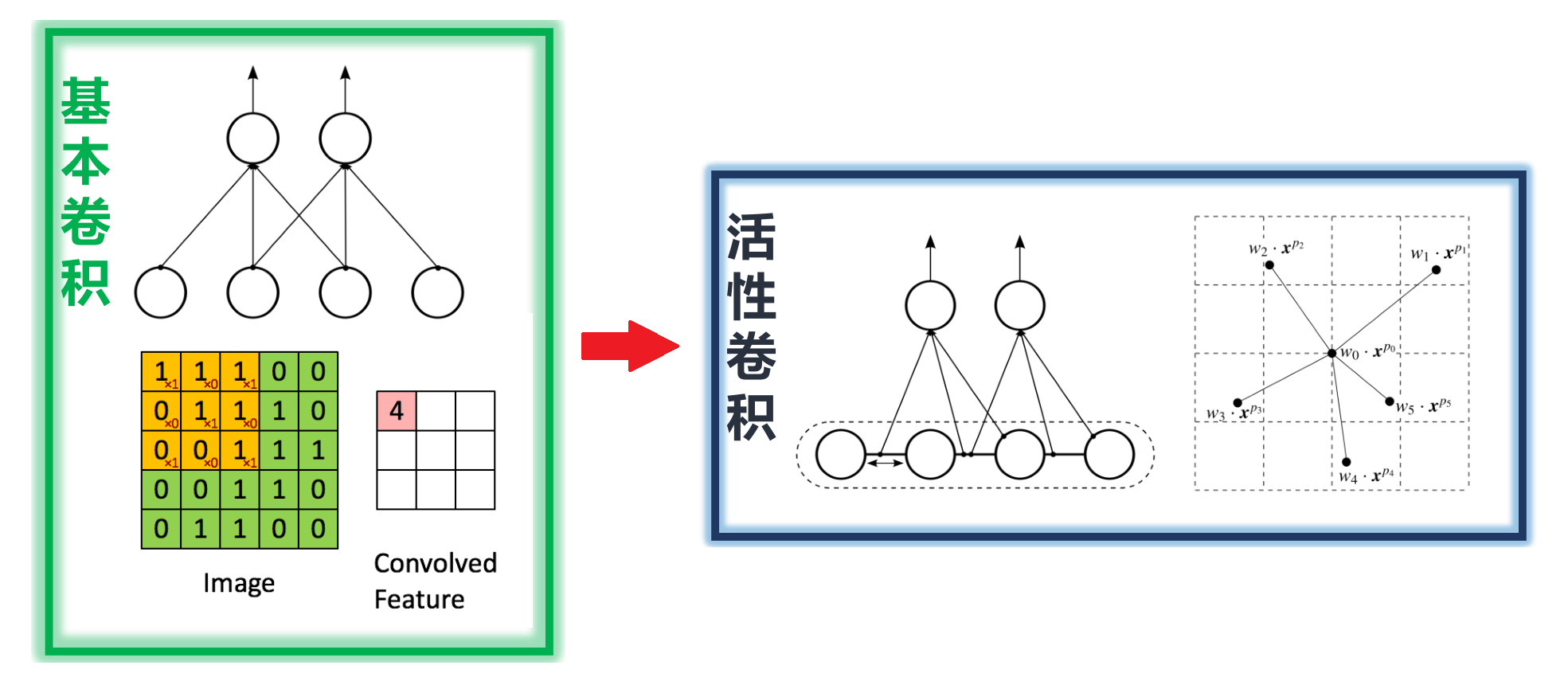

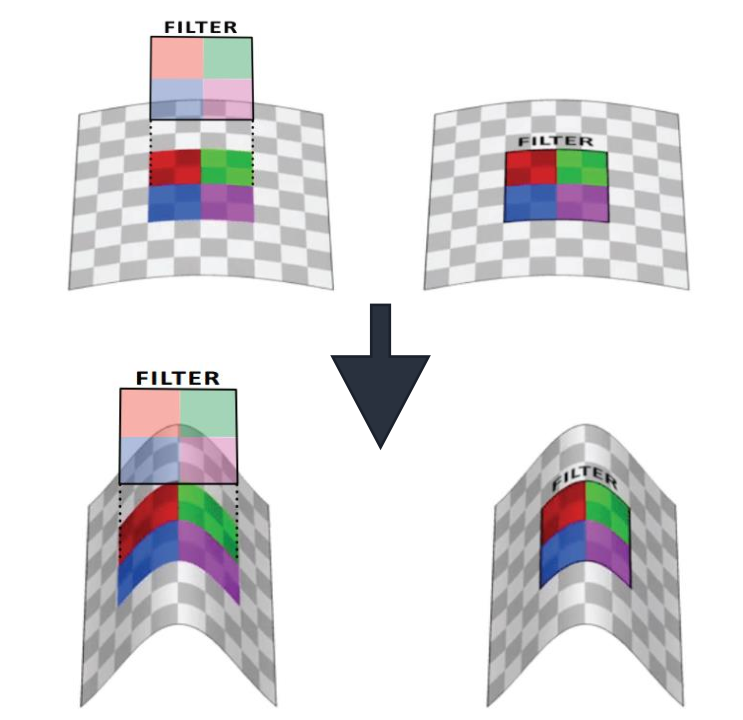

Conexión irregular del espacio euclidiano - convolución activa

- Convolución activa (CVPR 2017)

-

Interpolación bilineal: en coordenadas discretas, los valores de píxeles de posiciones continuas se pueden calcular mediante el método de interpolación

-

parámetros aprendibles△αk , △ βk

-

Forma de kernel de convolución variable fija

-

- La forma del kernel de convolución se puede cambiar.

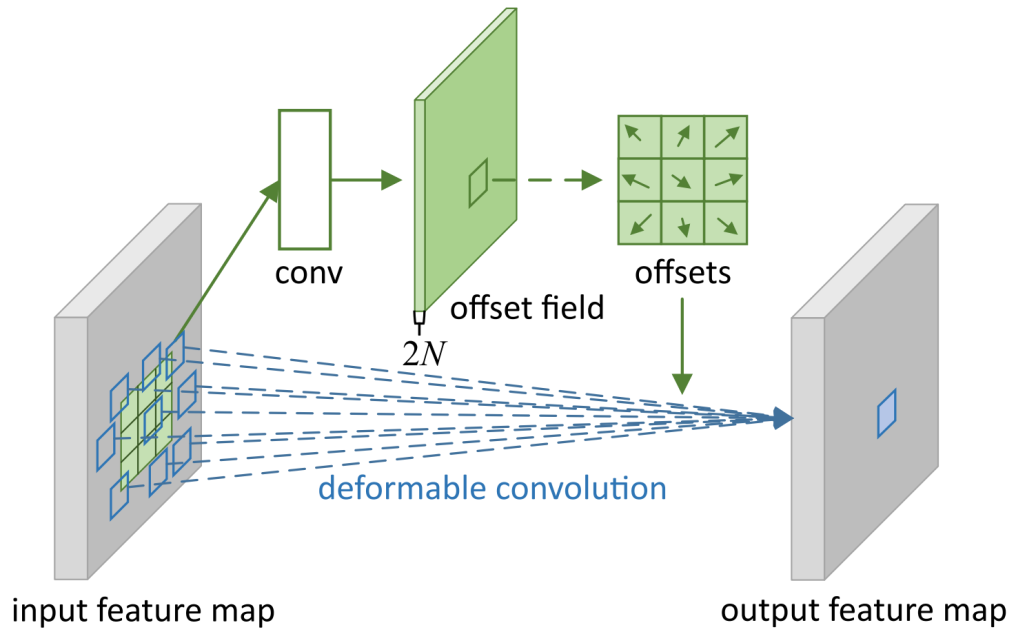

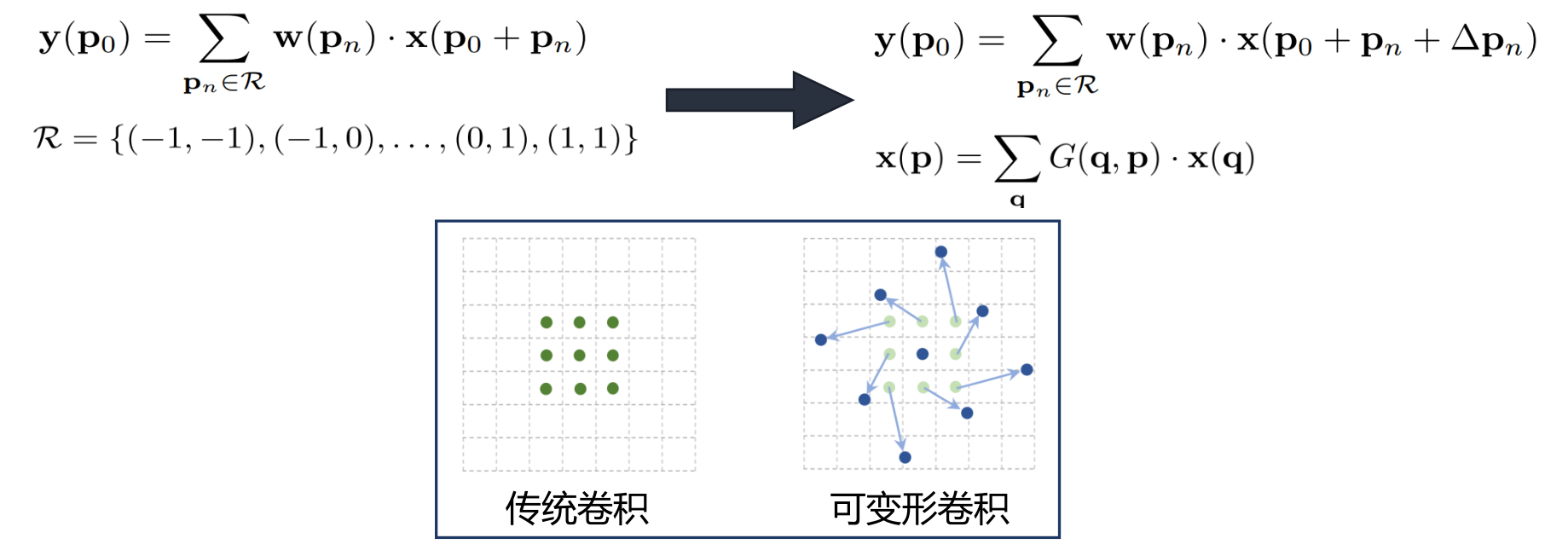

Conexión irregular del espacio euclidiano - convolución deformable

-

Convolución Deformable (ICCV 2017)

- Convolución deformable 3×3 (N=9)

- Cada posición corresponde a un sesgo

- El sesgo se aprende a través de circunvoluciones adicionales

- Cada desplazamiento es un vector 2D

-

Parametrización de la posición del kernel de convolución

-

Interpolación bilineal continua

-

Entrenamiento de algoritmo tradicional de PA

Redes neuronales convolucionales espaciales europeas

- Procesando datos de dimensión de entrada fijos, los datos de entrada locales deben pedirse

- Voz, imagen y video (estructura de reglas) cumplen los dos requisitos anteriores

Datos de estructura espacial no euclidiana

- Dimensiones de entrada locales variables

- orden de entrada local fuera de servicio

Redes neuronales convolucionales espaciales no euclidianas

Contenido de esta serie

- Introducción, Redes neuronales convolucionales: del espacio euclidiano al espacio no euclidiano (contenido de este artículo)

- Introducción a la convolución de gráficos espectrales

- Introducción a la convolución de mapas espaciales (1)

- Introducción a la convolución de mapas espaciales (2)

- Aplicaciones prácticas de la convolución de grafos

- Implementación de código de convolución de grafos basado en PyTorch

Las notas de seguimiento se actualizarán en la columna "Redes neuronales convolucionales gráficas".