0. fondo

Al comienzo de la historia, un colega del departamento comercial se acercó a nosotros y nos hizo una pregunta clásica:

"El lado de la demanda a menudo dice que los informes que hacemos parecen ser inexactos. ¿Hay alguna forma?"

Para explicarle este problema, le escribí cuatro líneas basadas en los métodos que nuestro equipo ha acumulado en la gestión de calidad de datos:

-

Expectativa de calidad de los datos: ¿qué estándar necesita la empresa para garantizar la calidad de los datos?

-

Medición de la calidad de los datos: cómo evaluar el nivel de calidad de los datos y si cumplen con el estándar

-

Aseguramiento de la calidad de los datos——para mejorar el nivel de calidad y cumplir con las expectativas de calidad, acciones específicas y contenidos de la implementación de la garantía

-

Operación de calidad de datos: cómo mejorar los resultados y la eficiencia de la garantía a través de la operación de datos

Estas cuatro líneas resumen nuestro esquema teórico en la implementación de la gestión de calidad de datos.

1. Expectativas de calidad de datos

"¿Entendió las expectativas de calidad de datos de la otra parte cuando se comunicó con usted?"

La calidad de los datos se define por los requisitos. No tiene un bien o un mal absoluto, solo estándares cualitativos y cuantitativos. Necesitamos comprender las expectativas de calidad del lado de la demanda por adelantado, para que podamos llegar a un consenso sobre los detalles del estándar de "estándar de calidad" con el lado de la demanda.

Permítame darle un ejemplo: a menudo nos encontramos con una situación: sabemos que hay problemas con estos datos, pero aun así elegimos usarlos. Siempre que eliminemos los puntos problemáticos de estos datos, los consumidores intermedios comprenderán y aceptarán sus problemas y elaborarán un plan integral. De esta forma, se evitan los accidentes de datos al reducir proactivamente las expectativas de calidad.

¿Cómo saber las expectativas de calidad de la otra parte?

Es mejor no preguntar directamente: "¿Qué tipo de protección y monitoreo necesita?" Porque el lado de la demanda no es necesariamente un desarrollador profesional, pueden perderlo o no pueden expresarlo en el lenguaje de operación y mantenimiento.

Por lo tanto, diseñamos los siguientes tres conjuntos de preguntas y solicitamos activamente la confirmación del lado de la demanda en la comunicación diaria de demanda de datos:

Grupo 1: Adquirir expectativas de calidad

| pregunta | efecto |

| ¿Cuál es el objetivo comercial de este requisito? ¿Por qué es importante? ¿Está relacionado con la línea? | Ayudar a juzgar si existe un riesgo de pérdida de activos. |

| ¿Quién lo usará aguas abajo? ¿En qué forma se usa? ¿Y se usa en Nari? | Ayudar a juzgar si se utiliza para servicios en línea, lo que tendrá un impacto en los usuarios. |

| Después de usar estos datos, ¿qué escenarios de análisis empresarial admitirá? Na algunos procesos de negocio? ¿Cuál es la lógica detrás de esto? | Ayudar a juzgar si afectar las decisiones importantes de la empresa. |

| ¿La lógica de este requisito involucra alguna privacidad de los usuarios, menores y otra información? | Ayudar a juzgar si existe un riesgo de seguridad |

| Si estos datos no se emiten/fluyen a tiempo, ¿cuál será el impacto y cuál será la pérdida? | Ayudar a juzgar los requisitos de puntualidad |

| Si estos datos se pierden o duplican, ¿cuál será el impacto y cuál será la pérdida? | Requisitos de integridad del juicio auxiliar |

| Si este valor de campo falta o es incorrecto, qué sucederá y qué se perderá | Requisitos auxiliares de monitoreo del campo de preparación |

Grupo 2: Evaluar posibles riesgos

| pregunta | efecto |

| ¿De qué fuentes obtenemos datos? ¿Está documentada la fuente de datos? | Evaluar si la fuente de datos tiene una clara atribución de responsabilidad |

| ¿La fuente de datos en sí tiene datos anormales originales y cuál es la situación anormal? ¿Los datos no estarán disponibles? | Evaluar la estabilidad empresarial de las fuentes de datos |

| ¿Cuál es el nivel de servicio de la fuente de datos? ¿Cumple con nuestra definición de materialidad para este dato? | Evaluar las capacidades de aseguramiento de la fuente de datos |

| ¿La fuente de datos tiene suficiente granularidad, campos de dimensión y campos de medición para cumplir con el resultado de los indicadores requeridos? | Evaluar la capacidad de las fuentes de datos para responder a la demanda |

| Si esta fuente de datos no cumple con los requisitos, ¿se puede mejorar? ¿Existen fuentes alternativas de datos? ¿Se puede corregir con ETL...? | Evaluar la dificultad de compatibilidad en el desarrollo de datos |

Por supuesto, los problemas anteriores son solo la punta del iceberg cuando se trata de la evaluación de riesgos.

El tercer grupo: Comunicar el conocimiento y la cognición empresarial con el lado de la demanda.

| pregunta | efecto |

| ¿Sabe el lado de la demanda a qué función en línea y proceso comercial se dirige esta fuente de datos? | Confirmar que tenemos la misma comprensión del proceso comercial que el lado de la demanda |

| Las métricas mencionadas en los requisitos. ¿Justo en la definición de calibre? Si es así, ¿lo entienden? si no hay, | Confirmar que somos consistentes con la definición de indicadores por el lado de la demanda |

| ¿Cómo definirlo? | ¿Existe un estándar de datos unificado para la masculinidad y sus atributos de dimensión mencionados en los requisitos? Si es así, entienden |

| Reconocer nuestra unidad cognitiva con la definición de fuerza del lado de la demanda | ? Si no, ¿cómo definirlo? |

Estos problemas son fáciles de dar por sentado y, al mismo tiempo, bastante mortales. Por ejemplo, el lado de la demanda necesita el CTR del manuscrito del video. Da la casualidad de que ya hemos preparado el índice CTR y se lo proporcionamos directamente para que lo use. Pero, ¿qué pasa si el CTR entendido por el lado de la demanda es inconsistente con nuestro calibre estadístico? ¿Obtuvo las estadísticas que esperaba?

¿Cuál es el mejor momento para comunicar las expectativas de calidad?

De la práctica hemos concluido que el mejor momento para obtener expectativas de calidad es en la etapa de comunicación de requisitos. En esta etapa, no hay muchos recursos ni mano de obra, y el costo de los cambios en la demanda es el más pequeño.

Por lo tanto, organizamos la recopilación de información sobre las expectativas de calidad en el enlace de preexamen de demanda. Organice los tres tipos de preguntas anteriores en una plantilla de comunicación previa a la revisión y exija que cada desarrollador de datos que participe en la revisión previa de requisitos desarrolle el hábito de preguntar sobre las expectativas de calidad.

A través de esta comunicación, el lado de la demanda puede tener una cognición comercial precisa, establecer un consenso sobre las expectativas de calidad y la conciencia de riesgo entre nosotros y el lado de la demanda, la investigación y el desarrollo comercial ascendente y los consumidores descendentes, y puede guiar al lado de la demanda hacia expectativas de calidad más bajas. o guía Business I+D+i elimina los riesgos actuales.

2. Medición de la calidad de los datos

"¿Sabe cómo evaluar el nivel de calidad de los datos y juzgar si la calidad está a la altura?"

Dado que no existe un bien o un mal absoluto en la calidad de los datos, solo existen estándares cualitativos y cuantitativos. Entonces, la forma de expresar el nivel de calidad de los datos es medirlos y compararlos con las reglas contenidas en el estándar. Llámelo una medida de la calidad de los datos.

Como queremos medir, primero debemos diseñar las reglas de medición.

El diseño de las reglas determina qué problemas podemos encontrar y qué problemas no podemos encontrar en el proceso de medición de la calidad . Primero tenemos que aclarar qué problemas es necesario exponer y cuáles no. Dividimos las reglas en reglas básicas y reglas personalizadas.

- Reglas básicas: se refiere a las reglas que se pueden aplicar a la mayoría de los datos. Por ejemplo, el número de entradas es 0 monitoreo, monitoreo de duplicación de clave principal, etc., tales anomalías deben estar expuestas en la mayoría de los escenarios. Por lo general, no es necesario diseñar las reglas básicas por sí mismas, y la plataforma proporcionará una configuración unificada para garantizar la cobertura de las reglas básicas.

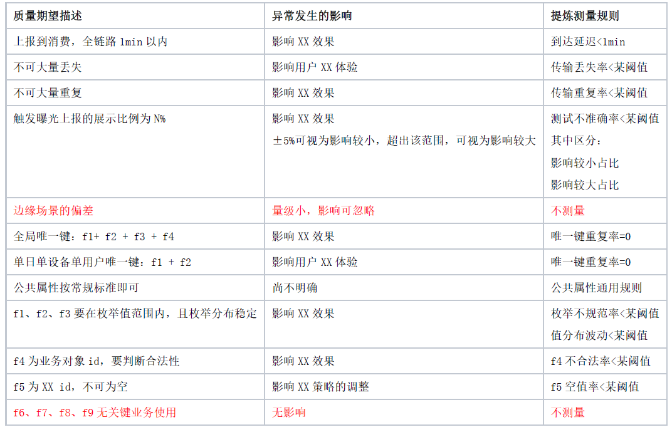

- Reglas personalizadas: se refiere a las reglas para que cada dato se diseñe de acuerdo con la situación de uso real. Las reglas de personalización deben extraerse de las expectativas de calidad. Ilustramos este proceso de refinamiento con un ejemplo real (insensibilizado) de expectativas de calidad.

Tenemos un [Business Object Exposure and Click Log] informado por el cliente . Tiene muchos consumidores intermedios. Combinamos las expectativas más altas con las expectativas de calidad de los consumidores (tome la unión de reglas y cada regla tome la que tenga el requisito más alto ).

【Exposición de objetos comerciales y registro de clics】 Ejemplo de expectativa de calidad y extracción de reglas:

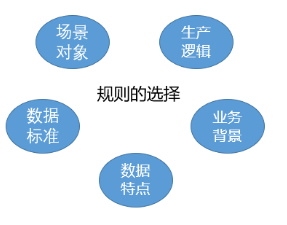

En general, las expectativas de calidad generalmente provienen de:

(1) La particularidad de escenas y objetos.

(2) Proceso de negocio y lógica de producción de datos.

(3) estándar de datos

(4) Características de los datos en sí

(5) Los antecedentes comerciales de un lugar determinado en un momento determinado. Así que nuestras reglas de medición también se basan en estos refinamientos.

2.1 Reglas de medición

Las reglas se pueden dividir en dos partes: indicadores de reglas y juicio de reglas.

Por ejemplo, en la regla [tasa de pérdida de transmisión < cierto umbral], [tasa de pérdida de transmisión] es el indicador de la regla, y [< cierto umbral] es el juicio de la regla.

Clasificación y ejemplos de indicadores de reglas:

| tipo de regla | significado de reglas | Ejemplo de indicadores de regla |

| Lo completo | Si los datos permanecen intactos durante el informe y la transmisión (ni menos ni más). | Pérdida de transmisión, transmisión repetida, etc. |

| Oportunidad | La distancia temporal entre la generación y el consumo de datos. La diferencia en los efectos decisorios producidos. | Sunshine Drift, llegada a Tingchi, etc. |

| exactitud | El mecanismo de activación y generación de datos se ajusta a la definición, y el valor de los atributos se ajusta a la lógica empresarial. | Precisión (generalmente evaluada durante la prueba) |

| unicidad | Cuando los datos tienen una clave única en el sentido comercial, son verdaderamente únicos. | Tasa de repetición de clave única, etc. |

| consistencia | Coherencia lógica entre diferentes atributos de objetos comerciales, consistencia del mismo atributo en diferentes datos, consistencia de dos magnitudes de procesos comerciales y tendencias pasivas. | Comparación de valores y tablas cruzadas, comparación constante de fluctuaciones, etc. |

| integridad | En los datos de la fila, se han completado todos los atributos que deben completarse. No falta nada. | Valor nulo del campo, valor 0, etc. no significa que los datos estén incompletos |

| Normativo | El valor de la propiedad se ajusta a alguna especificación de la clase a la que está vinculada esta propiedad. | Enumeración, rango, rango, formato, precisión, etc. |

Clasificación del juicio de regla:

| tipo de juicio | explicación lógica | expresión |

| no golpear | Se requiere que ningún registro acierte, de lo contrario es una excepción | Indicador de excepción = 0 |

| valor absoluto | El número/proporción de registros que cumplen la regla debe ser conocido y constante, y es anormal si no coincide. | Índice anormal = algún valor absoluto |

| valor de rango | El número/proporción de registros que cumplen la regla debe estar dentro de un rango de valores, y si no coincide, es una excepción. | Indicadores anormales en un cierto rango de umbral |

Después de diseñar las reglas, también es necesario especificar cuándo hacer la medición de la calidad.

2.2 Tiempo de medición

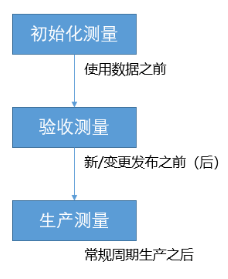

Dividimos el momento de la medición en tres tipos, correspondientes a tres formas de medición: medición de inicialización, medición de aceptación y medición de producción.

Para integrar estos tres tiempos en el trabajo de desarrollo del equipo, vinculamos estos tres tiempos con los pasos de flujo de la gestión de requisitos de datos y requerimos que el informe de ejecución de las tres mediciones se incluya en el contenido de entrega del flujo de requisitos.

-

Inicializar la medida:

Ocurre en el período previo a la revisión de los requisitos de datos, o en la etapa inicial de desarrollo. En forma de exploración de datos única, detecta los riesgos potenciales de nuevos datos o nuevos atributos de datos antiguos. Estos riesgos pueden ser defectos en la lógica comercial o peligros ocultos que no han sido estandarizados.Por lo tanto, además de los resultados de medición de los datos en sí, también debemos prestar atención a la entrada de información aguas arriba, como los documentos.

Las mediciones de inicialización nos ayudan a evitar la entrada de datos de baja calidad en nuestra cadena de producción.

-

Medidas de aceptación:

Ocurre durante el período de aceptación de requerimientos de datos. No solo los datos nuevos requieren una aceptación integral, sino también los requisitos de cambio. Según nuestra experiencia en accidentes, más del 90 % de los accidentes relacionados con la calidad de los datos se deben a la publicación de cambios.

La medición de la aceptación nos ayuda a evitar anomalías en los datos provocadas por la publicación de cambios.

-

Medidas de producción:

La configuración y la primera ejecución de la medición de la producción se produce durante el período de observación previo a la entrega de requisitos, y la ejecución diaria se produce durante el proceso de producción diario después de la entrega. En teoría, un enlace de producción estable tiene una calidad estable, pero no se pueden ignorar los problemas esporádicos de inestabilidad, como las excepciones de componentes subyacentes y las excepciones de servicios de programación.

La medición de la producción nos ayuda a evitar problemas externos esporádicos que afecten la salida de datos.

Con la medición de calidad, podemos monitorear el nivel de calidad durante mucho tiempo y encontrar problemas anormales a tiempo a través de estadísticas y juicios regulares en cualquier momento.

3. Garantía de calidad de datos

"Si los resultados de la medición de calidad no son satisfactorios, ¿qué se puede hacer para mejorar el nivel de calidad?"

La mejora del nivel de calidad de los datos solo se puede lograr mediante la implementación de la garantía de calidad de los datos. ¿Qué garantiza exactamente esta "garantía"? ¿Qué hacer para proteger?

Las reglas de medición de la calidad están diseñadas de acuerdo con las expectativas de calidad. En consecuencia, si los indicadores en el informe de medición son anormales, debemos poder decirles a todos qué expectativa no está a la altura. Primero debemos implementar salvaguardas contra las expectativas no satisfechas.

Continuamos con [Exposición de objeto comercial y registro de clics] en la sección anterior para ilustrar el proceso de implementación de la garantía después de que se descubre un problema.

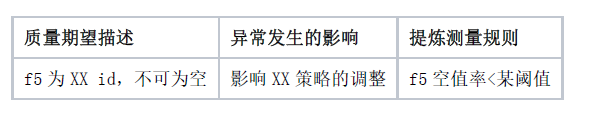

En las expectativas de calidad, existe una descripción de expectativa para el atributo f5:

Sin embargo, en los datos reales, los informes de medición indicaron que la calidad de las propiedades del f5 no cumplió con las expectativas. Es decir, hay una gran cantidad de valores nulos en el atributo f5.

Dado que este es un registro de fuente de datos que no ha sido procesado por ETL, se puede considerar que la anomalía del atributo f5 ocurrió en el enlace de informe de datos y recepción de integración de datos. Junto con otras condiciones de juicio, básicamente creemos que la anomalía ocurrió en el enlace de informes. Mediante el análisis estadístico de datos anómalos, se localiza además que esta anómala sólo se presenta en unas pocas páginas, siendo el resto de las páginas normales. A continuación, tenemos que hacer dos implementaciones para arreglar la excepción para que no vuelva a suceder:

-

De acuerdo con el proceso de reparación de excepciones ocultas, el cliente repara la excepción notificada.

-

Complemente este caso de prueba en el enlace de prueba y, en cambios posteriores, las excepciones se pueden bloquear a través de este caso de prueba.

En este caso:

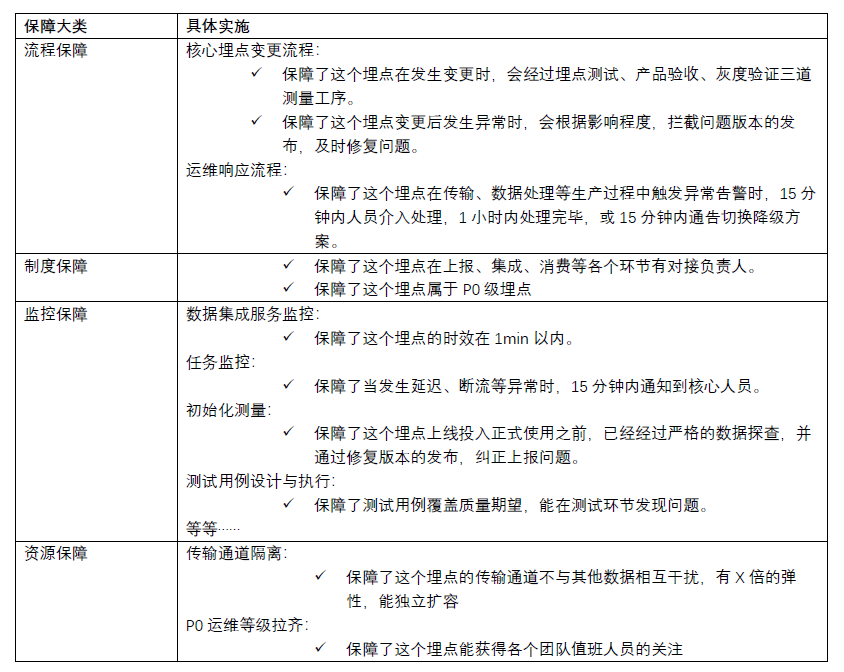

Primero, tenemos medidas de calidad para monitorear el nivel de calidad de los datos;

En segundo lugar, tenemos un proceso de reparación de excepción para arreglarlo y resolver este problema, y también tenemos un proceso de cambio para probarlo y evitar que vuelva a ocurrir el mismo problema;

A continuación, tenemos un sistema de responsabilidad claro , en el proceso anterior, cada parte responsable conoce su responsabilidad de ejecución;

Finalmente, cada uno de nuestros responsables ha asignado la mano de obra y los recursos de horas-hombre correspondientes para implementar el trabajo de monitoreo, reparación y prueba de este punto enterrado.

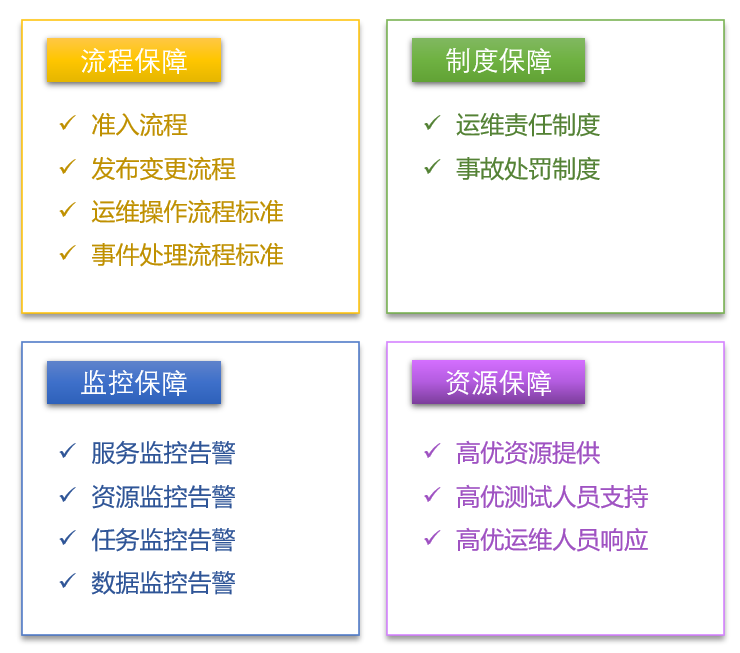

Estoy acostumbrado a dividir la implementación de la garantía de calidad en cuatro categorías, todas las cuales son indispensables.

3.1 Tipos de Implementación de Garantía de Calidad

3.1.1 Garantía del proceso

¿Por qué tener un proceso?

En el campo de la gestión de la seguridad, presta gran atención a la formulación e implementación de procedimientos operativos estándar. Existen procedimientos operativos estándar estrictos para la operación de los asistentes de vuelo para cerrar la puerta de la cabina y la operación de plantas químicas para transferir productos químicos, y estos procedimientos son lo suficientemente poderosos como para proteger la seguridad del personal. Se puede ver que la garantía del proceso es una poderosa medida de salvaguardia.

En nuestra garantía de proceso, debemos centrarnos en los dos procesos de acceso a datos y cambios de publicación.

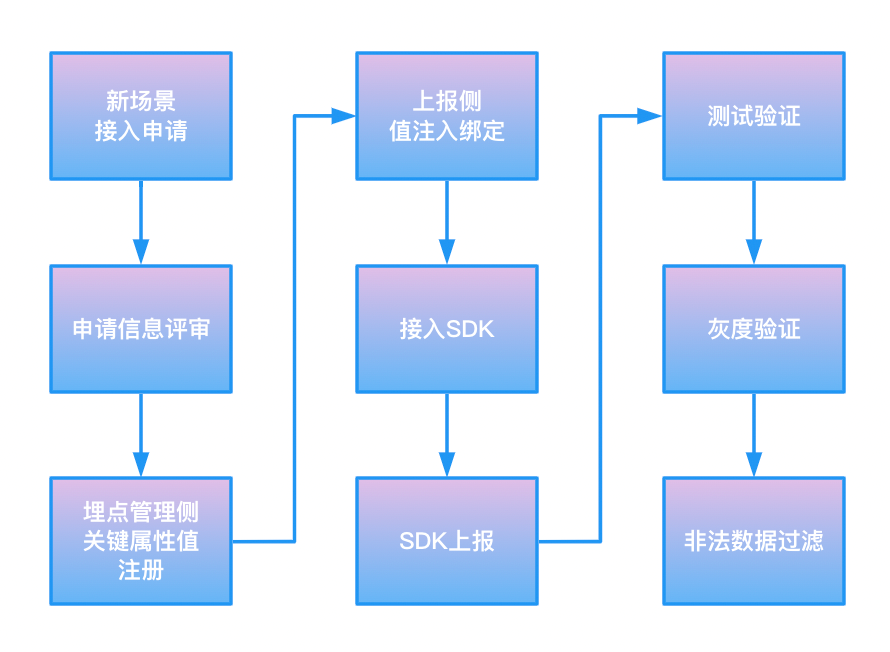

Acceso a los datos:

Hubo un caso en el que había un nuevo producto A. Durante la generación de informes y el desarrollo del punto oculto, se copió directamente la secuencia de comandos de informes de otro producto B, lo que dio como resultado que se informara el mismo valor para el atributo clave appid utilizado para distinguir los dos productos, afectando así los indicadores básicos del producto B.

En la revisión de este caso, señalamos que obviamente es inapropiado permitir que un nuevo producto o una nueva escena se conecte aleatoriamente a un importante punto enterrado existente. Entonces establecimos un proceso de admisión de datos.

El establecimiento del proceso de admisión depende de varias condiciones necesarias:

-

El valor del atributo asignado a través del proceso de admisión debe verificarse mediante un enlace bidireccional (lado del informe y lado de la gestión del punto de seguimiento).

-

Los valores de los atributos asignados a través del proceso de acceso deben ser convergidos por el SDK o los componentes públicos (como los reproductores) al momento de informar, y no pueden ser informados por el propio negocio de acceso.

-

Los datos no aprobados deben estar restringidos para informar, o restringidos para recibir y usar después de informar.

El proceso real final se refiere a la siguiente figura:

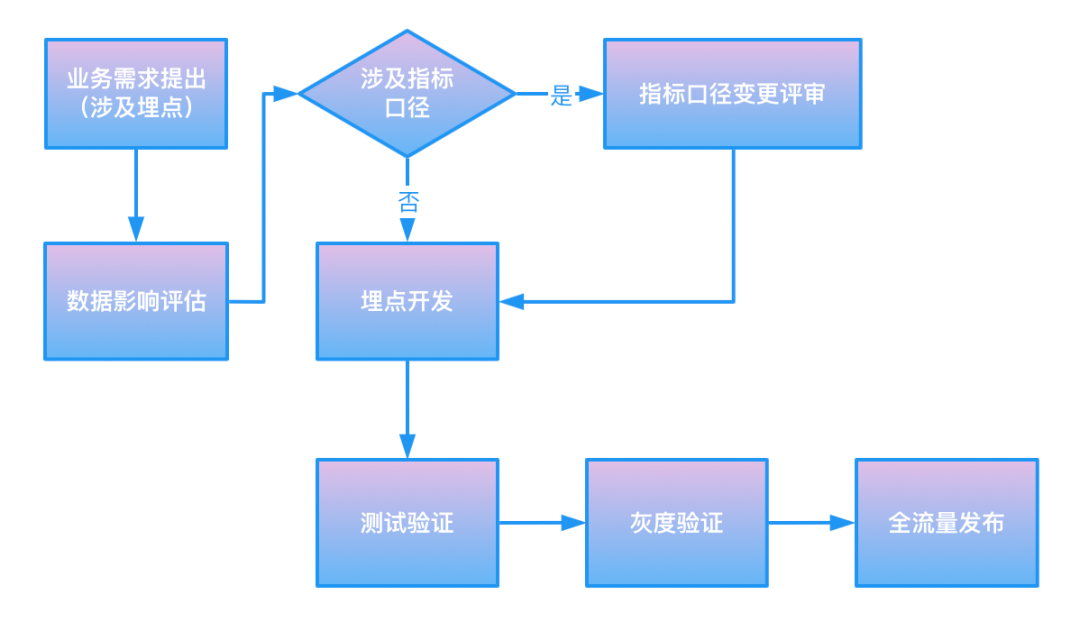

Publicar cambios:

Más del 90 % de los accidentes en la calidad de los datos son causados por cambios, lo cual es un hecho que mencionamos cuando hablamos sobre la medición de la aceptación. Por esta razón, debe existir un conjunto de procesos para garantizar la liberación de cambios.

Como se muestra en la figura, es un proceso simple de cambio de punto enterrado.

3.1.2 Garantía del sistema

Debe existir el sistema de responsabilidad de operación y mantenimiento . Define la lógica de atribución de responsabilidad para cada dato, cada tipo de componente y cada servicio, y puede asegurar que cualquier dato tenga un ejecutivo responsable de asegurar su calidad en cada enlace.

También debe existir el sistema de clasificación de operación y mantenimiento . Define qué nivel de garantía estándar puede obtener cada dato en cada enlace de todo el ciclo de vida, y los datos de alto nivel deben garantizarse más estables que los datos de bajo nivel.

Nuestra definición de calificación será evaluada desde los siguientes aspectos:

-

Incluyendo informes financieros, ingresos y pérdidas de activos

-

Implica decisiones comerciales importantes.

-

Involucrar servicios funcionales en línea y experiencia de usuario

-

Involucrado en la supervisión de los departamentos relevantes.

El sistema de penalización por accidentes es un sistema opcional (por supuesto recomendamos que exista). Define el costo de la morosidad después de que ocurre una excepción.

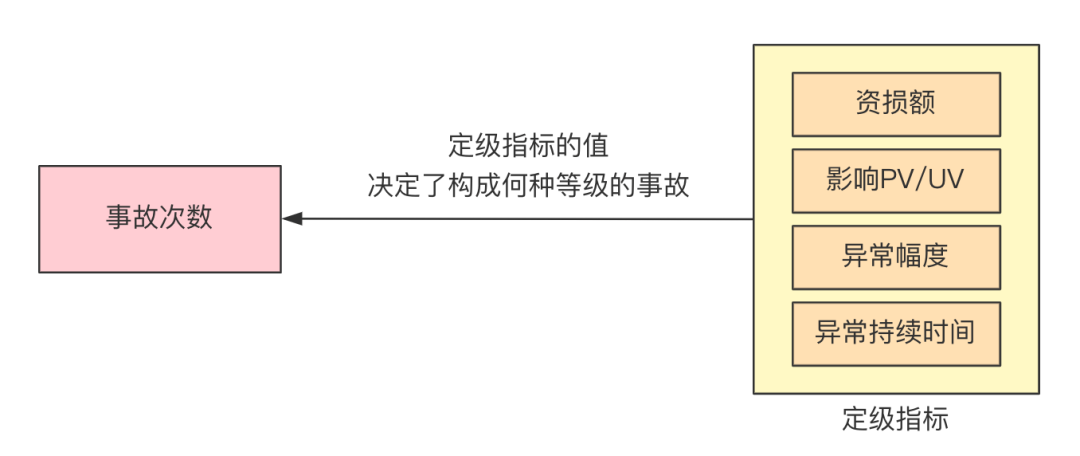

Nuestra definición de accidentes y la clasificación de los niveles de accidentes serán evaluados a partir de varios indicadores:

-

magnitud de la pérdida

-

magnitud de la queja del cliente

-

Amplitud y duración de las anomalías de datos

-

recuperabilidad de datos

-

La influencia de los datos anormales en PV y UV

-

Costo de mano de obra por hora de restauración de datos

Además, en el nuevo ciclo, también hemos absorbido la experiencia de los ciclos anteriores.Además del sistema de castigo por presión negativa, también consideramos agregar un sistema de recompensa por estímulo positivo.

3.1.3 Garantía de seguimiento

Creemos que el monitoreo de la garantía incluye cuatro tareas:

1. Monitoreo y monitoreo: observe la salud de la producción de datos durante mucho tiempo;

Este estado de salud incluye la estabilidad de los componentes de big data, el uso de recursos de big data, el estado de ejecución de tareas, la verificación de los resultados de salida de datos, etc.

2. Medición: la medición de la calidad a la que nos referimos anteriormente;

3. Supervisar: Indicar a la parte responsable que se ocupe del problema;

Por lo general, se realiza a través de diferentes niveles de notificaciones de información, como mensajes de grupo, alarma WeChat corporativa y alarma telefónica.

4. Corrección: Asistir en el manejo de problemas de ejecución.

Funciones como el análisis de causas de alarmas y el bloqueo de tareas pertenecen a esta categoría.

3.1.4 Garantía de recursos

La garantía de recurso se refiere a la inclinación del recurso para diferentes niveles de operación y mantenimiento, y el recurso aquí tiene dos significados:

-

Recursos físicos: CPU y memoria, capacidad de disco, ancho de banda, etc.

-

Recursos humanos: cronograma de ejecución de pruebas y verificación, velocidad de respuesta de operación y mantenimiento, secuencia de reparación excepcional, etc.

Continúe regresando a los datos de [Exposición de Business Object y registro de clics] para ver qué garantías hemos implementado para sus enlaces ascendentes y descendentes.

Después de completar la construcción de los cuatro tipos de garantías anteriores, nuestro sistema de aseguramiento de la calidad de los datos completó el proceso de "0" a "1".

4. Operación de calidad de datos

"Se puede realizar un seguimiento manual de una sola pieza de datos en la implementación de la protección, pero con miles de datos, ¿cómo sabe cómo proteger cada pieza de datos, si se ha implementado y si el efecto de la implementación es bueno?"

Pensemos cuál es el propósito de implementar medidas de aseguramiento de la calidad. La implementación de la garantía de calidad tiene como objetivo evitar excepciones. Debe estar en cada enlace ascendente: descubrir excepciones, interceptar excepciones y manejar excepciones.

Se puede ver que su estándar básico debería ser: la excepción se encuentra, la excepción se intercepta y la excepción se maneja ; para lograr el propósito del nodo final para evitar la excepción.

Seguimos pensando en quién, en qué momento y con qué método, cuánta mano de obra se consume y cuánta pérdida se causará.

Cualquiera espera evitar todas las excepciones, e incluso si ocurre una excepción, puede solucionarse antes de causar pérdidas. Entonces, tenemos que mejorar aún más sus estándares:

-

Interceptar emisiones anormales en la mayor medida posible en pruebas limitadas y horas de aceptación.

-

Upstream encuentra excepciones un paso por delante de downstream

-

Las alarmas anormales se notifican a la persona que puede manejar la excepción lo antes posible

-

Antes de la intervención humana, el sistema toma la delantera en la interceptación automática de anomalías

-

Los controladores manejan las excepciones con la ruta más corta y el costo mínimo

-

No dejes que el mismo problema suceda una y otra vez

Se puede observar que los requisitos básicos del aseguramiento de la calidad se reflejan en evitar pérdidas a través de las garantías, y los requisitos avanzados se reflejan en la mejora de la eficiencia de las garantías. A partir de esto, obtenemos dos objetivos operativos de las operaciones de calidad de datos: reducir las pérdidas por accidentes y mejorar la eficiencia de la garantía.

Como trabajadores de datos, debemos, por supuesto, lograr nuestros objetivos a través de operaciones basadas en datos. Para ello, hemos diseñado un sistema de índices de calidad de las operaciones.

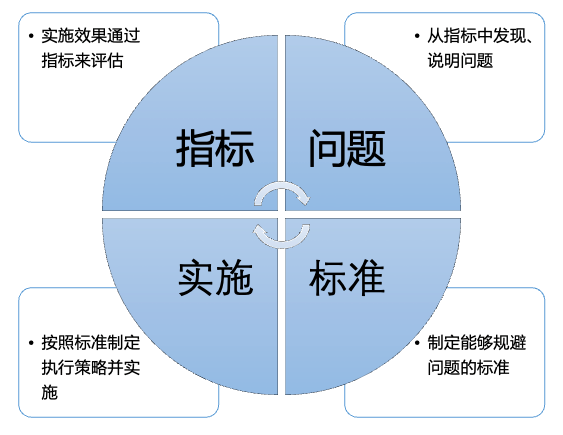

Nuestro sistema de índice de operación de calidad se basa en nuestro modelo de construcción del sistema de índice de gobierno, que incluye: objetivos de gobierno, estrategias de gobierno y evaluación de gobierno . El siguiente es un resumen de nuestro sistema de indicadores de operación de calidad en ciclos recientes.

Entre ellos, la matriz de estrategia de gobierno representa que necesitamos formular estándares de garantía, diseñar reglas para implementar estrategias y proporcionar las capacidades de herramientas correspondientes para cada eslabón en el ciclo de vida antes, durante y después del evento.

4.1 Establecer normas de salvaguarda

Un estándar es una referencia de implementación.

Dígales a todos cómo cumplir con el estándar, cuál es el proceso más seguro... etc. Los estándares unifican nuestra conciencia y comportamiento en el proceso de implementación de la garantía de calidad y eliminan la responsabilidad y el traspaso de responsabilidades.

Los estándares de garantía provienen de un resumen de varias expectativas de calidad, y las partes públicas y generales deben anunciarse a todos los usuarios. Puede pasar por negociaciones, compromisos y eventualmente un consenso de opinión. Incluye pero no se limita a:

-

Servicio SLA estándar

-

Criterios de cobertura de prueba/supervisión

-

Estándar de tiempo de respuesta de excepción

-

estándar de división de recursos

Los estándares deben graduarse, y los diferentes niveles de garantía de operación y mantenimiento se asignan a diferentes valores estándar de garantía.

Los recursos energéticos y físicos del equipo son limitados, y la parte más importante debe estar garantizada dentro de un rango limitado.

Por ejemplo, los datos [Business Object Exposure and Click Log] que mencionamos anteriormente pertenecen al nivel P0 según el sistema de clasificación de operación y mantenimiento. Como los datos del nivel P0, su garantía de antigüedad de datos es de 1 punto y el requisito de antigüedad de respuesta es de 15 minutos. Para otros datos de nivel P1 o incluso de nivel inferior, el estándar de puntualidad se reducirá paso a paso.

4.2 Reglas específicas para el diseño de estrategias de ejecución

Las reglas son la letra pequeña de un lanzamiento estándar.

Por ejemplo, ampliamos el proceso estándar de manejo de eventos: cuando ocurre una excepción, nuestro proceso estándar es detener la pérdida primero y luego repararla . Con base en este estándar, suponiendo que los datos [Exposición del objeto comercial y Registro de clics] son anormales en un enlace determinado, nuestras reglas detalladas son:

-

El controlador de excepciones en este enlace debe recibir directamente la alarma y responder en 10 minutos;

-

Si no hay respuesta dentro de los 10 minutos, se actualizará a LD técnico;

-

Después de recibir la alarma, primero notifique al personal que puede hacer el cambio de recuperación de desastres (el enlace más rápido y más corto) y luego sincronice la información con el grupo de respuesta de emergencia del proyecto;

-

El controlador de excepciones explica la causa de la excepción y evalúa la reparación que requiere mucho tiempo;

-

De acuerdo con las condiciones de activación de la recuperación ante desastres del proyecto, el ejecutor de la recuperación ante desastres juzga si activa el plan de recuperación ante desastres;

-

Arreglar el problema;

-

Vuelve al proyecto principal.

Estas reglas mantienen a todos alejados del mal funcionamiento y mejoran la eficiencia de la ejecución. También puede permitir que un principiante comience rápidamente y reduzca la dificultad de ejecución.

Además, también podemos ver que esta regla de procesamiento de eventos tiene varias reglas de requisitos previos:

-

Se requiere cobertura de monitoreo de enlace completo

-

Necesita un plan de recuperación ante desastres

-

Se requiere un mecanismo de escalada de alarma y un mecanismo de notificación.

4.3 Proporcionar capacidades de herramientas

En la actualidad, hemos acumulado una serie de herramientas que se utilizan en varios enlaces del ciclo de vida de los datos para proporcionar capacidades de ejecución automática.

Por ejemplo, herramientas de monitoreo y alarma, herramientas de gestión de línea de base, herramientas de gestión de DQC, herramientas de cambio de indicador, herramientas de operación de operación y mantenimiento, etc., se pueden aprender en otros artículos en la cuenta oficial.

La ejecución de la estrategia necesita evaluar si el efecto es bueno o malo, para ajustar las reglas de la estrategia en cualquier momento o mejorar las capacidades de la herramienta. Cómo evaluar el efecto de implementación de la estrategia requiere que diseñemos los indicadores de evaluación .

Principios de diseño de indicadores de evaluación:

- Debe desmontarse de la primera capa de indicadores de objetivos,

- Capaz de exponer los problemas en la situación,

- ser capaz de evaluar el progreso de la implementación de la estrategia de gobernanza,

- Capacidad para evaluar los beneficios de rendimiento

Este tipo de diseño hace que la operación funcione en un ciclo continuo de descubrimiento de problemas a partir de los indicadores: el problema se refleja en los indicadores después de resolverlo , acercándose constantemente y finalmente logrando la meta.

En la descripción general anterior del sistema de índice de operación de calidad, primero desmantelamos el índice objetivo (número de accidentes) en un índice de clasificación de accidentes directamente relacionado con el accidente.

Cuanto menor sea el rango de valores del índice de clasificación, menor será el número de accidentes.

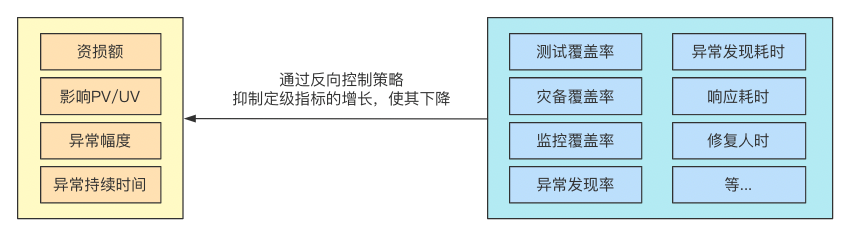

Luego, a continuación, necesitamos desmontar qué indicadores de ejecución están relacionados con la reducción de los indicadores de calificación.Este paso de desmontaje debe estar directamente vinculado a las reglas de la política. Porque las reglas que no pueden evaluar el efecto son difíciles de ser convincentes en la implementación y difíciles de implementar.

La cobertura de prueba está ligada a la implementación de casos de prueba, la cobertura de monitoreo está ligada a la implementación de la configuración de monitoreo, el tiempo de reparación está ligado a la mejora de la eficiencia y optimización de las herramientas de operación y mantenimiento... y así sucesivamente.

Entre ellos, indicadores con conceptos más abstractos, como la cobertura de seguimiento , recorren todo el ciclo de vida y tienen distintas definiciones en diferentes eslabones.

Por ejemplo, en el proceso de desarrollo de datos, requerimos que todos los datos de nivel P0 se configuren con tres tipos de alarmas de monitoreo (falla, demora y contenido anormal), y el formulario de alarma es alarma telefónica + actualización dentro del departamento. Estas reglas de configuración son indispensables, y solo cuando se completan todas se pueden contar como la "finalización de la cobertura de seguimiento" de estos datos. A través de la cobertura de monitoreo de auditoría semanal, controlamos la implementación de nuestras garantías de monitoreo en el enlace de desarrollo de datos.

Aquí, hay un caso real de operación de efectividad de alarma , que puede explicar nuestro método de operación basado en datos.

Primero, permítanme presentarles los antecedentes. Creemos que más monitoreo no es mejor, y las reglas de monitoreo deben ajustarse a tiempo a medida que cambia el negocio. Demasiadas alarmas interferirán con el enfoque de operación y mantenimiento de los ejecutivos, causarán parálisis o resistencia a las alarmas e incluso perderán alarmas clave, lo que reducirá la tasa de descubrimiento anormal.

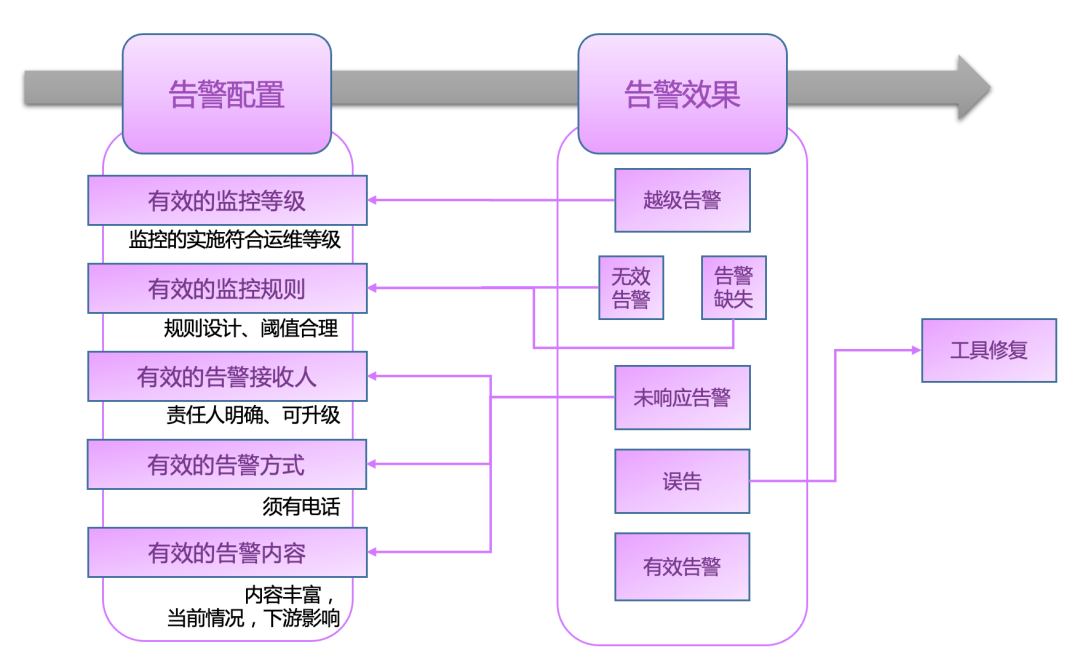

Primero debemos determinar cómo se ve un ciclo sostenible en este asunto operativo. De acuerdo con el diagrama del ciclo indicador-problema-estándar-implementación mencionado anteriormente , enumeramos brevemente este ciclo:

-

Indicadores: se necesitan indicadores para exponer los defectos de advertencia, como la invalidez, la falta de respuesta, la ausencia y el salto de rana.

-

Problemas: Tratar las fallas como un problema a ser gobernado

-

Criterios: defina criterios para alertas válidas

-

Implementación: desarrollar estrategias para reducir los defectos de alerta y aumentar las alertas efectivas

Para facilitar la comprensión, primero permítanme explicar la definición del efecto de advertencia.

Alarma efectiva : se cumple la regla y, de hecho, se cumple la excepción, y al mismo tiempo, puede incitar al personal de procesamiento a intervenir rápidamente.

Alarma no válida : la regla se cumple, pero la excepción no se cumple, lo que generalmente se debe a una falta de coincidencia de la regla o a actividades comerciales.

Alarma que no responde : se activa la regla y, de hecho, se aplica la excepción, pero nadie responde, o el personal que responde no puede y no tiene derecho a intervenir.

Alarma Leapfrog : El nivel de operación y mantenimiento de datos es bajo, pero se configura un formulario de alarma de estándar superior, lo que hace que el número de despertares sea falsamente alto.

Falsa alarma : la regla no se cumple y la herramienta activa una alarma por error.

Falta advertencia : se produce una excepción, pero no hay advertencia.

El primer paso es formular un mecanismo de retroalimentación de alarmas e instar al propietario a proporcionar retroalimentación jerárquica sobre las alarmas.

El segundo paso es construir el almacén de datos del sujeto de metadatos del módulo de alarma, hacer un informe estadístico de los defectos de alarma, proporcionar una lista detallada para abordar y enviar la información de gobierno al propietario de los datos en la lista.

El tercer paso es formular estándares de advertencia y reglas de implementación efectivos, instar al propietario a dar prioridades de gobierno y determinar objetivos de gobierno a corto y largo plazo. Los detalles se refieren a la siguiente figura:

El cuarto paso es auditar periódicamente los defectos de las alarmas, actualizar la lista para corregir, analizar el progreso de la implementación, el margen de gobernanza y los nuevos incrementos, y completar gradualmente las partes de alta calidad de la cabeza.

En el quinto paso, se propone el plan de optimización de herramientas para bloquear nuevos incrementos irrazonables y procesar automáticamente el margen de cola larga.