//

Tencent ha acumulado más de 21 años de tecnología de audio y vídeo y es propietario exclusivo de la red global RT-ONE. Además, ha creado la familia de productos PaaS y aPaaS más completa de la industria, que incluye audio y vídeo en tiempo real, transmisión en vivo en la nube, nube bajo demanda, mensajería instantánea, procesamiento de medios, etc., brindando soluciones de bajo código para varios escenarios importantes. , para que los desarrolladores y las empresas puedan lanzar rápidamente aplicaciones de audio y vídeo de alta calidad. A continuación, nos gustaría invitar al Sr. Sun Xiangxue a compartir con nosotros las estrategias de inspección de calidad y evaluación de la calidad de la imagen adoptadas por Tencent Cloud en audio y video.

Texto/Sun Xiangxue

Editor/LiveVideoStack

Soy Sun Xiangxue de Tencent Cloud Audio and Video y ahora soy responsable del desarrollo backend de los productos Tencent Cloud Media Processing (MPS). El tema que quiero compartir con ustedes hoy es la inspección de la calidad de audio y video y la evaluación de la calidad de la imagen. El concepto de inspección de calidad puede ser desconocido para todos, pero de hecho, hace mucho tiempo, hubo otro nombre relacionado en el campo de la radio y la televisión: revisión técnica de video, que revisa la calidad del video desde una perspectiva técnica. Revisión del contenido, y todos deberían revisar el contenido del video, estoy relativamente familiarizado con él y reviso si el video involucra pornografía y violencia política. La inspección de calidad examina los problemas del vídeo desde una perspectiva técnica.

Esta imagen puede resultarte un poco familiar. No se trata de una imposibilidad de jugar debido al equipo del sitio. Esta es una captura de pantalla que no se puede reproducir en sí misma. Cuando todo el mundo ve vídeos de televisión o de teléfonos móviles en casa, especialmente algunas fuentes de vídeo antiguas, este problema ocurre ocasionalmente. Muchos vídeos tienen problemas de compatibilidad en el terminal, lo que hace que no se puedan reproducir. Para los proveedores de contenidos, este tipo de experiencia de reproducción es muy pobre e incluso puede provocar la pérdida de algunos clientes. La inspección de calidad es una solución derivada de solucionar este problema, evitando que aparezcan vídeos problemáticos en línea o incluso que se encuentren anormales cuando los usuarios los solicitan.

Hoy lo presentaremos en seis partes: descripción general, diagnóstico de formato, inspección de calidad del contenido, puntuación sin referencia, reparación de excepciones y prueba de experiencia.

-01-

Descripción general

A lo largo de todo el ciclo de vida del vídeo, desde la grabación, recopilación, codificación, empaquetado hasta la transmisión, desencapsulación, decodificación, renderizado y reproducción, se pueden introducir problemas de calidad. Para dar dos ejemplos, todo el mundo sabe que los vídeos cortos son muy populares ahora. Hay una palabra familiar en la grabación de vídeos cortos llamada movimiento de cámara. Si mueves bien la cámara te llamarán técnico, pero si la mueves mal te marearás, este es un problema de calidad introducido desde el proceso de disparo. Otro ejemplo es el proceso de codificación. Los videos tienen muchos formatos de códec y formatos de empaquetado. Después de una codificación no estándar, puede haber problemas de compatibilidad en diferentes terminales y diferentes modelos de teléfonos móviles. Verificar la compatibilidad de un solo video ya requiere mucho tiempo y trabajo, y el control de calidad de datos de video masivos es aún más un dolor de cabeza. La función de la inspección de calidad es descubrir rápidamente estos videos problemáticos antes de su publicación.

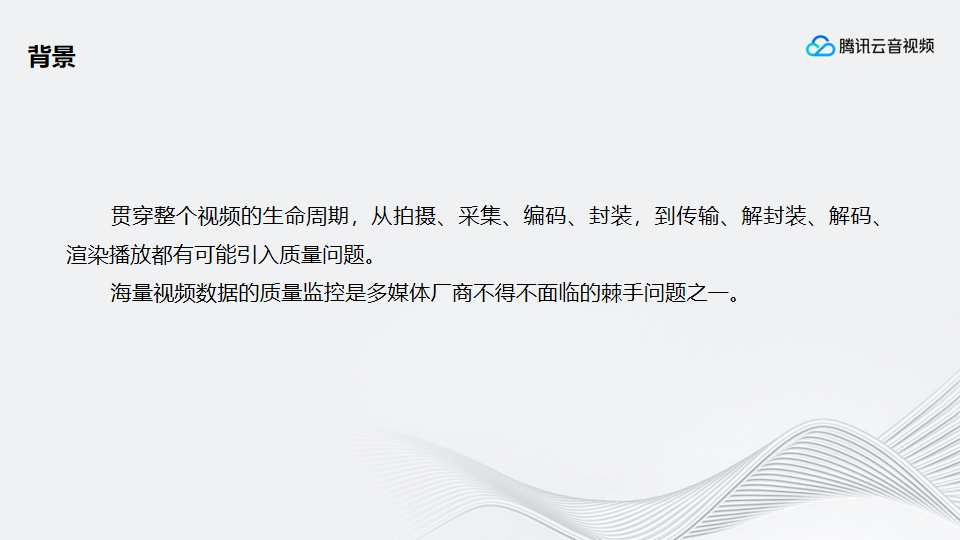

Para resolver este problema, Tencent Cloud Media Processing (MPS) ha creado un enlace de plataforma completa para el monitoreo de la calidad de los medios. Consta principalmente de tres partes: inspección de la calidad de los medios, reparación posprocesamiento y reproducción . La inspección de calidad de los medios es responsable de identificar primero el problema, luego realizar el posprocesamiento y la reparación, y luego reproducirlo en el terminal. Después de reproducirlo, proporciona retroalimentación al algoritmo de inspección de calidad a través de los datos de comportamiento QoE y QoS del usuario.

La inspección de la calidad de los medios también se divide internamente en tres partes: diagnóstico de formato, inspección de la calidad del contenido y puntuación sin referencias. El diagnóstico de formatos se centra en la inspección normativa de formatos de empaquetado de vídeo, como formatos MP4, AV1, ASF para vídeo, MP3, AAC, etc. para audio. Mientras se verifica el formato del paquete, también se verificarán las especificaciones de codificación para verificar si el video está codificado de acuerdo con las especificaciones oficiales. El diagnóstico de formato determina que el vídeo no tiene problemas de formato y luego se lleva a cabo la inspección de la calidad del contenido de la pantalla. Compruebe si la imagen se puede reproducir normalmente, si hay alguna vibración, desenfoque, sobreexposición, ruido y otros problemas. En cuanto al audio, nos centraremos en cuestiones como el volumen desigual, el ruido y el ruido. Después de completar la inspección de calidad del contenido, analizaremos estéticamente la composición y el color de toda la imagen en función de la claridad, saturación, profundidad y contraste, y luego calificaremos sin referencia. Diferenciar videos por puntuación. Cuando recomiende videos a los usuarios, recomiéndelos con mejores puntuaciones, lo que generará mejores tasas de finalización y conversiones en colecciones, clics y atención.

Realice las reparaciones correspondientes después de identificar el problema. Por ejemplo, cuando la fluctuación es severa, se puede usar la transcodificación para eliminar la vibración, se pueden mejorar el color de las escenas muy oscuras, si hay un problema con el formato, se puede reparar la transcodificación y existen muchos otros métodos de reparación.

Después del posprocesamiento y reparación, se distribuirá al terminal para su reproducción. Durante la reproducción, se recopilan datos de los usuarios, como el número de vistas, la tasa de finalización, la QoE y la QoS, para proporcionar retroalimentación al algoritmo. Al conectarnos con los clientes en la nube, descubrimos gradualmente que el pensamiento de los usuarios también cambia constantemente. En el pasado, los usuarios buscaban más datos indicadores como la precisión y la recuperación. Ahora los usuarios están más preocupados por la mejora de los datos de QoS y QoE. No importa lo bueno que sea, no es tan bueno como ab. Verifique si hay algún beneficio antes de discutirlo.

A través de una gran cantidad de experimentos controlados, encontramos que los datos de QoS y QoE para videos sin problemas de calidad encontrados durante la inspección de calidad son significativamente mejores que los de videos con problemas de calidad encontrados. Esta es una comparación de vídeos con y sin problemas durante la inspección de calidad. El segundo tipo de comparación es la comparación entre el video problemático antes y después de la reparación. El video reparado traerá una mejora en la calidad y, a su vez, una mejora en Qos y QoE. El tercer tipo de comparación es más común: después de calificar el video sin referencia y reproducirlo en diferentes segmentos en línea, encontrará obviamente diferentes comportamientos de reproducción del usuario. Los vídeos con puntuaciones altas tendrán tasas de finalización, visualizaciones y duración de visualización significativamente más altas que los vídeos con puntuaciones más bajas. Esto también se verifica desde el exterior: la inspección de calidad puede encontrar problemas; los problemas pueden repararse si se encuentran; hay distinción en la puntuación sin referencia;

Llamamos al diagnóstico de formato, inspección de la calidad del contenido y puntuación de no referencia los tres pilares de la inspección de la calidad de los medios. El diagnóstico de formato resuelve el problema de si se puede reproducir o no. La inspección de la calidad del contenido resuelve el problema de si la transmisión es buena o no. Puntuar sin referencias resuelve el problema de si la retransmisión es agradable o no. Estos tres ejes se presentan en detalle a continuación.

-02-

Diagnóstico de formato

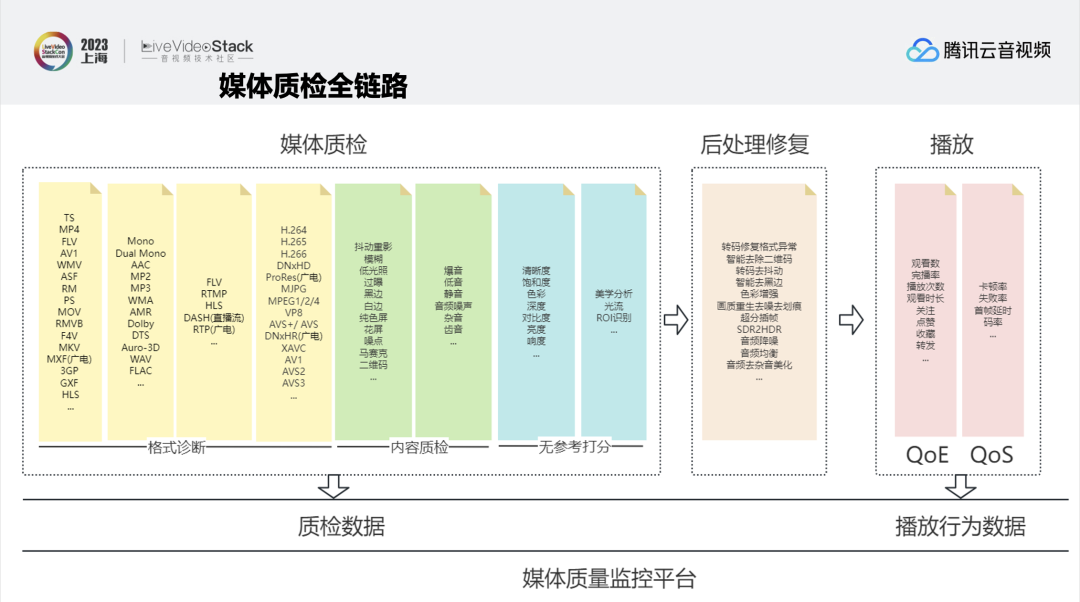

Al realizar el procesamiento de medios en la nube, a menudo surgen dos problemas. El primer problema es que hay un problema con el vídeo, pero no sé cuál es, por lo que es muy difícil solucionarlo. El segundo problema es cómo reproducir de forma estable en muchas plataformas de reproducción. Estos también son dos desafíos importantes en el procesamiento de medios, a saber, el análisis de flujo de excepciones y los problemas de compatibilidad entre plataformas.

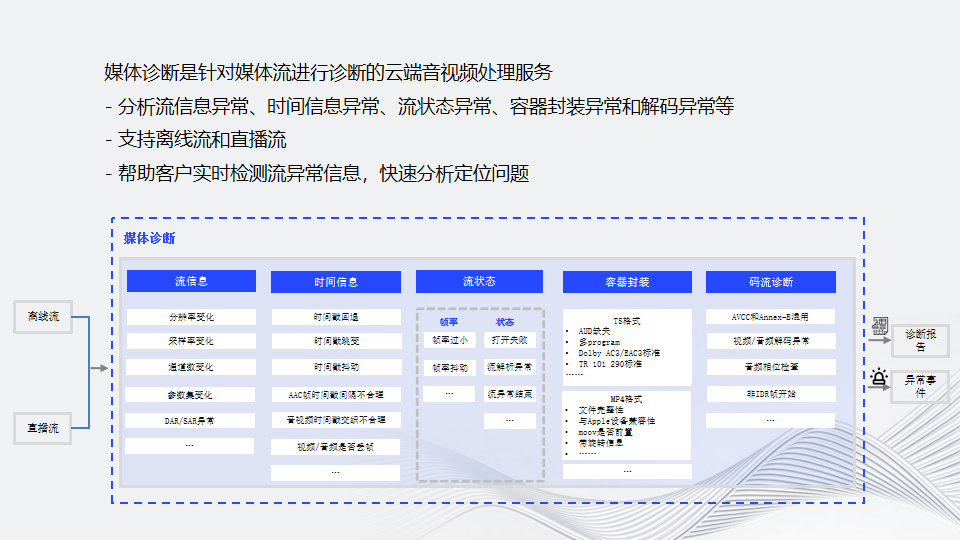

Media Diagnosis es un servicio de procesamiento de audio y video en la nube que diagnostica transmisiones de medios y no solo admite transmisiones en vivo, sino que también admite archivos sin conexión a pedido. A través de la inspección multicapa de información de flujo, información de tiempo, estado de flujo, encapsulación de contenedores y diagnóstico de flujo de código, en realidad se verifica uno por uno con el formato de encapsulación y las especificaciones del formato de codificación para descubrir problemas anormales en tiempo real, brindando así retroalimentación a los usuarios. y permitir a los usuarios localizar rápidamente la ubicación del problema. Se puede generar un informe de diagnóstico para archivos fuera de línea y la transmisión en vivo generará eventos de devolución de llamada en tiempo real. Según los eventos de devolución de llamada, los usuarios pueden realizar operaciones como cambiar transmisiones, interrumpir transmisiones y volver a enviar.

A continuación se enumeran varios escenarios de aplicación de diagnóstico. El primer escenario trata sobre el monitoreo en tiempo real de transmisiones en vivo. Para actividades importantes de transmisión en vivo, el monitoreo en tiempo real del proceso de transmisión en vivo se lleva a cabo a través del monitoreo en tiempo real, y se emiten alarmas por anomalías de la red, interrupciones de la transmisión y otras situaciones que afectan la transmisión en vivo, lo que permite a los clientes intervenir y proteger rápidamente. Importante negocio de retransmisiones en directo. La imagen de la derecha es una captura de pantalla de la pantalla de monitoreo en tiempo real. Las configuraciones de monitoreo convencionales incluyen detección de interrupciones, detección de anomalías de formato, detección de baja velocidad de fotogramas, etc. En el futuro, se lanzarán capacidades relacionadas con la inspección de la calidad del contenido y la puntuación sin referencias.

El segundo escenario es la detección de escenarios OTT. El estándar ETSI TR 101-290 es un estándar de referencia para medir la calidad de los sistemas DVB y se utiliza principalmente para la detección de flujos MPEG-TS en escenarios OTT. Se definen tres requisitos de prioridad para los flujos MPEG-TS. El primero es si afecta a la decodificación normal (incluida la verificación del código de sincronización TS, PAT, verificación PMT, etc.); el segundo es si afecta la decodificación continua y correcta; el tercero es si Afecta a aplicaciones específicas. Una vez completado todo el proceso, puede determinar si hay problemas y proporcionar comentarios en tiempo real.

El tercer escenario es la detección de compatibilidad de reproducción. Aquí hay tres ejemplos de preguntas en línea:

La primera pregunta es sobre la compatibilidad de los dispositivos Apple. Un usuario informó que la transmisión de video que codificaron en Safari solo reproducía sonido y no imagen, pero no tuvimos este problema cuando la transcodificamos. A través de la investigación, encontramos que el flujo de código H.264 en el flujo TS no tiene AUD. AUD, el nombre completo de Access Unit Delimiter, es el delimitador de unidades de acceso H.264. El nal_unit_type de AUD en el estándar H.264 es 9 y el nal_unit_type en H.265 es 35. Es opcional en H264, pero es requerido por la especificación TS. Traiga AUD. Si no hay un separador de unidad de acceso, causará los problemas anteriores en los dispositivos Apple.

El segundo problema también es un problema de compatibilidad en dispositivos Apple. No se puede reproducir vídeo en formato MP4 codificado con H.265. Después de solucionar el problema, se descubrió que H.265 fourcc está configurado en hev1 en lugar de hvc1. Esto se debe a que hev1 o hvc1 son dos etiquetas de códec y Apple no admite 265 hev1.

El tercer problema es que los usuarios informaron que el audio Dolby Digital Plus no se puede reproducir en algunos decodificadores. Esto se debe a que Dolby Digital Plus tiene dos estándares, ATSC y DVB, en TS, y algunos decodificadores no son compatibles con el estándar ATSC Dolby Digital Plus. Usamos la herramienta Tsduck para verificar el tipo de flujo de eac3 en el PMT del archivo ts y descubrimos que dvb es 0x06 y atsc es 0x87. Solucionar problemas como estos requiere mucha mano de obra, pero si utiliza el sistema de diagnóstico de Tencent Cloud Audio and Video Quality Inspection, podrá localizar rápidamente el problema.

-03-

Inspección de calidad del contenido.

Una vez que el diagnóstico de formato no encuentre anomalías, se debe realizar una inspección de la calidad del contenido.

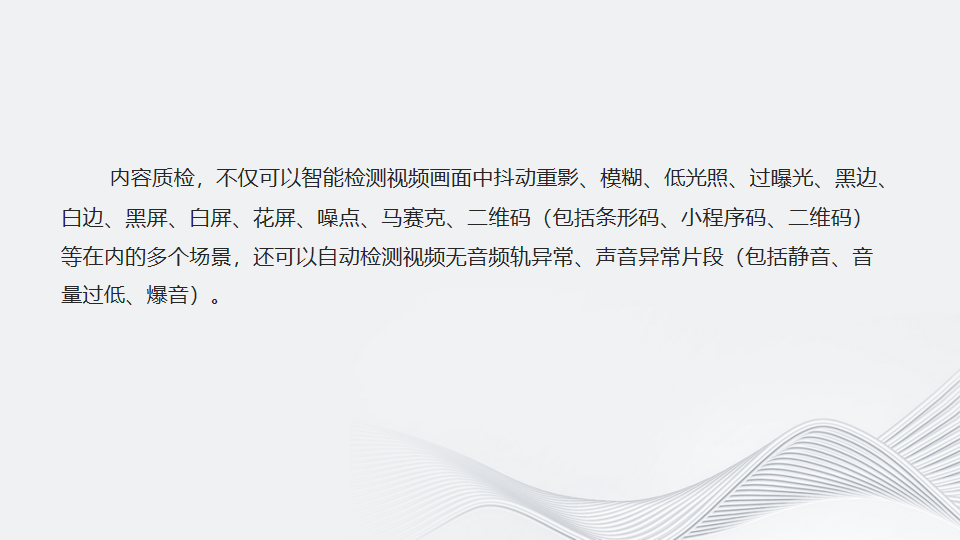

La inspección de la calidad del contenido no solo puede detectar de forma inteligente imágenes fantasma, desenfoque, poca luz, sobreexposición, bordes negros, bordes blancos, pantalla negra, pantalla blanca, pantalla borrosa, ruido, mosaico, código QR (incluidos códigos de barras, códigos de subprogramas) en la pantalla de video. , código QR), etc., también puede detectar automáticamente pistas de audio de video anormales y segmentos de sonido anormales (incluido silencio, volumen bajo y explosión sónica).

De izquierda a derecha y de arriba a abajo, los ejemplos son imágenes fantasma, desenfoque, poca luz, bordes negros, pantalla borrosa, sobreexposición, ruido, código QR y mosaico.

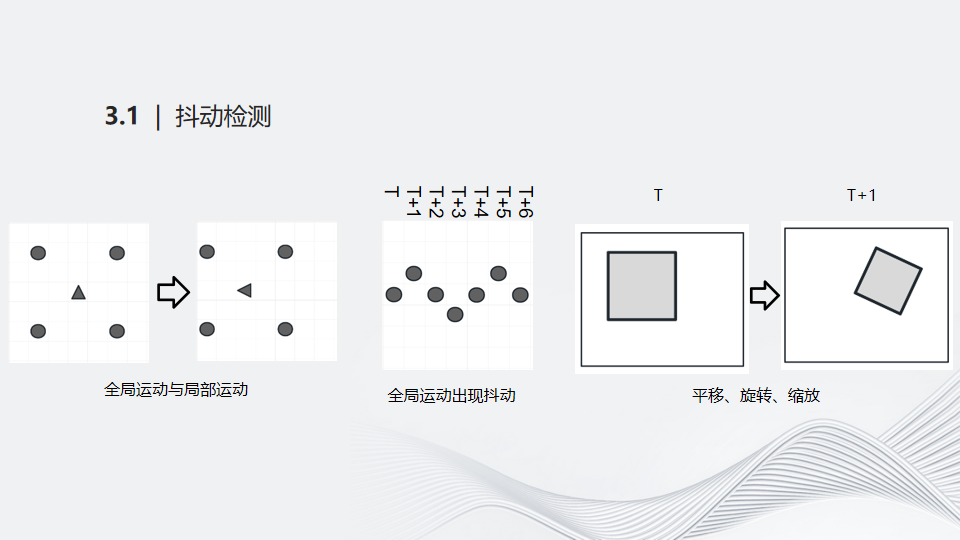

Veamos primero la detección de fluctuaciones. El movimiento relativo entre dos cuadros de imágenes se puede descomponer en movimiento global para la mayoría de las escenas y movimiento local para una pequeña parte de la escena, y el movimiento global generalmente representa el movimiento subjetivo de la cámara. La inestabilidad del soporte de la cámara provocará trayectorias de movimiento hacia arriba y hacia abajo entre fotogramas consecutivos. La tercera imagen muestra que el movimiento entre los fotogramas t y t+1 se simplifica en traslación, rotación y escala.

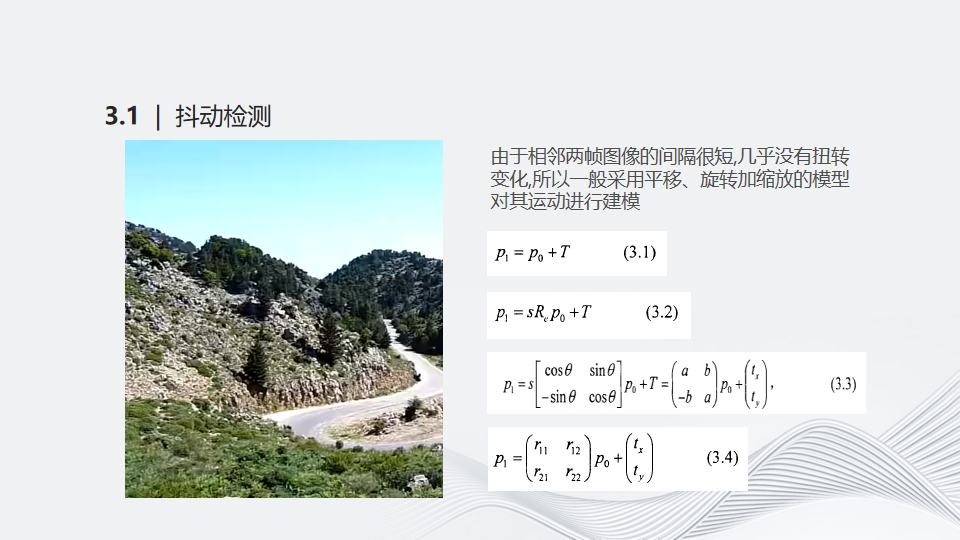

El vídeo de la izquierda está muy agitado debido a la inestabilidad del soporte de la cámara, es fácil marearse después de verlo durante mucho tiempo. Dado que el intervalo entre dos fotogramas de imágenes adyacentes es muy corto y casi no hay cambio de torsión, generalmente se utiliza un modelo de traslación, rotación y escala para modelar su movimiento. La fórmula de la primera línea describe un cambio de traducción, es decir, la traducción de píxeles del eje X y del eje Y. Finalmente, mediante deducción se obtiene la fórmula de la última línea. Según el modelo, el valor de traslación, el valor de rotación y el valor de escala entre los dos cuadros se calculan para determinar si se produce fluctuación. El escenario de aplicación real es contar los cambios promedio dentro de un período de tiempo. Si el valor promedio alcanza el umbral, la fluctuación de la imagen se considera grave. La transmisión en vivo se calcula de manera similar.

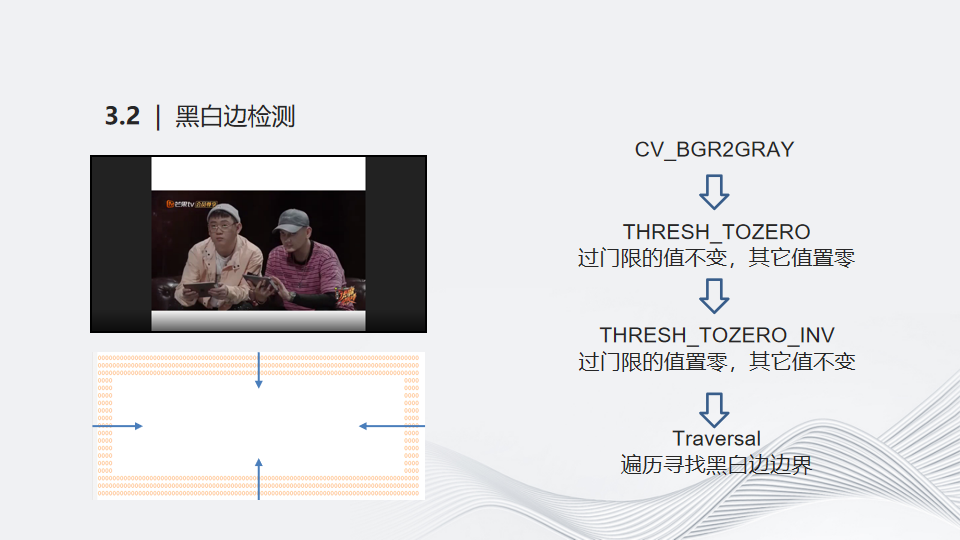

El algoritmo para la detección de bordes en blanco y negro es relativamente simple. Después de la conversión de la imagen en escala de grises, se utilizan dos funciones de umbral para procesar todos los bordes blancos y negros de la imagen en escala de grises en un cuadro con un límite cero. Siempre que descubra dónde está el límite de este cero, naturalmente podrá calcular dónde está el límite de los bordes blanco y negro. No sólo puede saber si hay bordes blancos y negros, sino que también puede saber dónde están los límites de los bordes blancos y negros.

Aunque el algoritmo no es complicado, todavía ocurren algunos casos malos. El caso más común es que todo el fotograma del primer episodio que se muestra al comienzo de muchas series de televisión es negro. Es probable que este algoritmo devuelva todos los fotogramas, excepto el primer episodio, con bordes en blanco y negro. Con este fin, agregamos una detección similar al ángulo de bisel para cubrir casos tan graves.

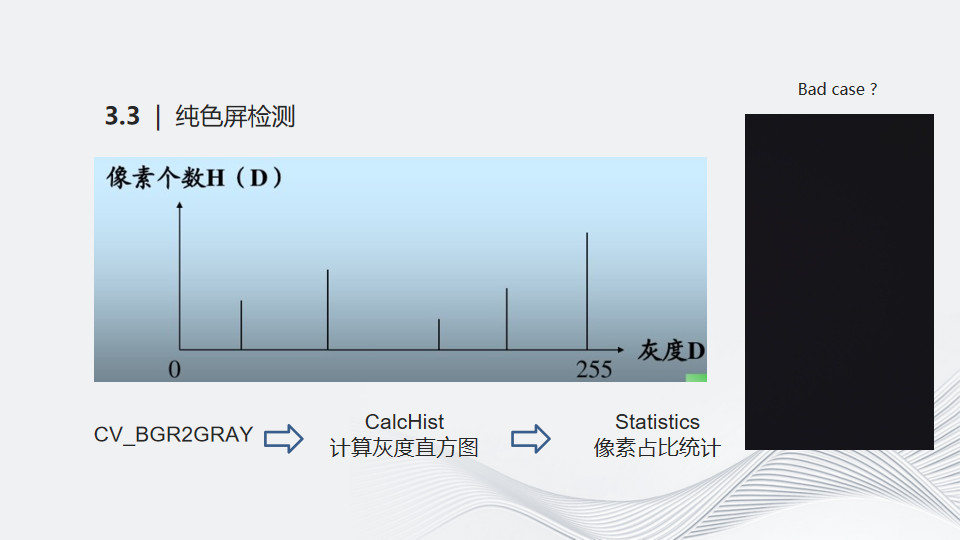

Puede que le resulte más fácil pensar en un algoritmo de detección de pantalla en color puro. La operación convencional es contar la proporción de píxeles en el histograma después de la imagen en escala de grises. Cuando la proporción de un solo píxel excede un cierto umbral, se considera una pantalla de color sólido. La imagen de la derecha muestra un caso grave en línea. Los usuarios nos informaron que una imagen parecía "puramente negra" al ojo humano, pero el algoritmo no la detectó. Al calcular su valor de gris, encontramos que un solo punto no se distribuye en un determinado valor de píxel, sino que se distribuye en áreas adyacentes de varios valores de píxel. En este momento, simplemente contar la proporción de píxeles de un solo punto no puede cumplir con las expectativas. Entonces agregamos un mecanismo similar a una ventana deslizante para detectar la proporción de los valores acumulados de los píxeles adyacentes, resolviendo así un caso tan grave.

-04-

Sin calificación de referencia

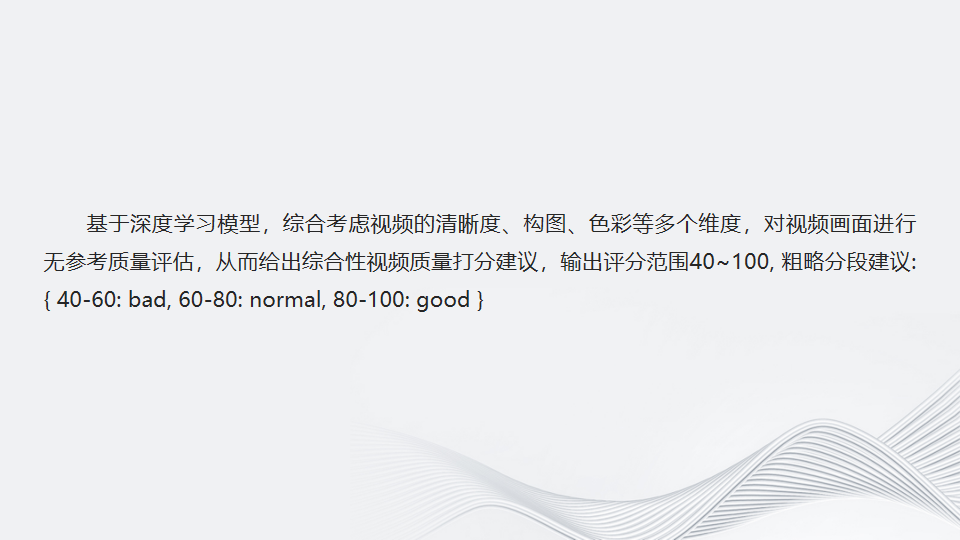

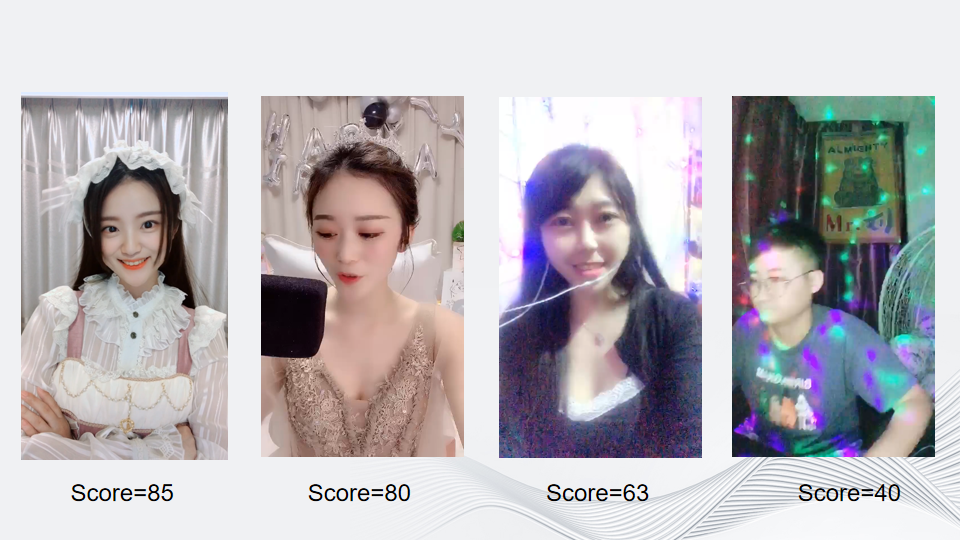

Los que más se oyen sobre la puntuación son VAMF, PSNR, etc. Estos deben calcularse en función de fuentes de referencia. La característica de la puntuación sin referencia es que no requiere una fuente de referencia y calcula la puntuación directamente en función de la composición, saturación de color, etc. de la imagen. El modelo se basa en un modelo de aprendizaje profundo y considera de manera integral múltiples dimensiones, como la claridad, la composición y el color del video, para realizar una evaluación de la calidad de la imagen del video sin referencias, brindando así sugerencias integrales de calificación de la calidad del video. La puntuación de salida varía de 40 a 100, que se divide aproximadamente en tres niveles: 40 a 60 es pobre, 60 a 80 es promedio y 80 a 100 es buena.

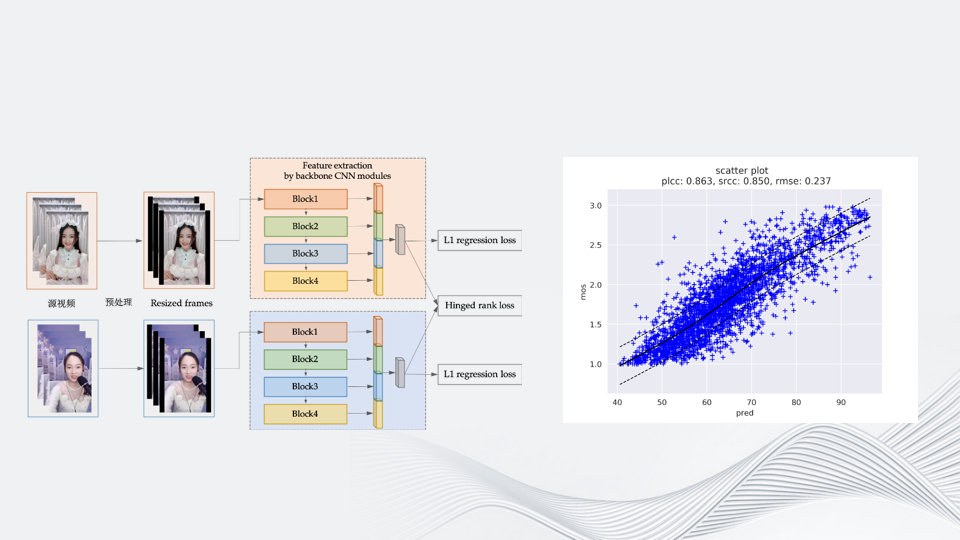

En la escena de transmisión en vivo, puede utilizar la puntuación para guiar al presentador a ajustar la imagen, la iluminación, etc. en tiempo real, brindando así una mejor experiencia de transmisión en vivo. Este diagrama muestra la red de datos central del aprendizaje profundo. A la izquierda está el preprocesamiento de fotogramas de vídeo a imagen. El tamaño de entrada que utilizamos aquí es cercano a 720p, que es 672×448. La razón por la que se elige este tamaño es porque la entrada de la red neuronal convolucional de aprendizaje profundo es generalmente 224. Usamos 224 × 3 como altura y 224 × 2 como ancho para obtener más características de la imagen. Al utilizar una estructura de columnas mixtas, no solo se utiliza el bloque 4 como entrada de extracción de características, sino que también se recopila la salida de cada capa, lo que aumenta el impacto de las características de bajo nivel en la predicción de calidad. Al mismo tiempo, consulte las clasificaciones entre diferentes vídeos para mejorar el efecto del aprendizaje. El lado derecho son los datos PLCC y SRCC medidos en línea por el algoritmo. El eje horizontal es la puntuación prevista y el eje vertical es la puntuación mos. Cuanto más cerca de la línea continua en el medio, mayor será la correlación con la puntuación subjetiva del ojo humano y mejor será el índice del algoritmo.

Aquí se muestran ejemplos de vídeos con diferentes segmentos de calificación.

-05-

Corrección de excepción

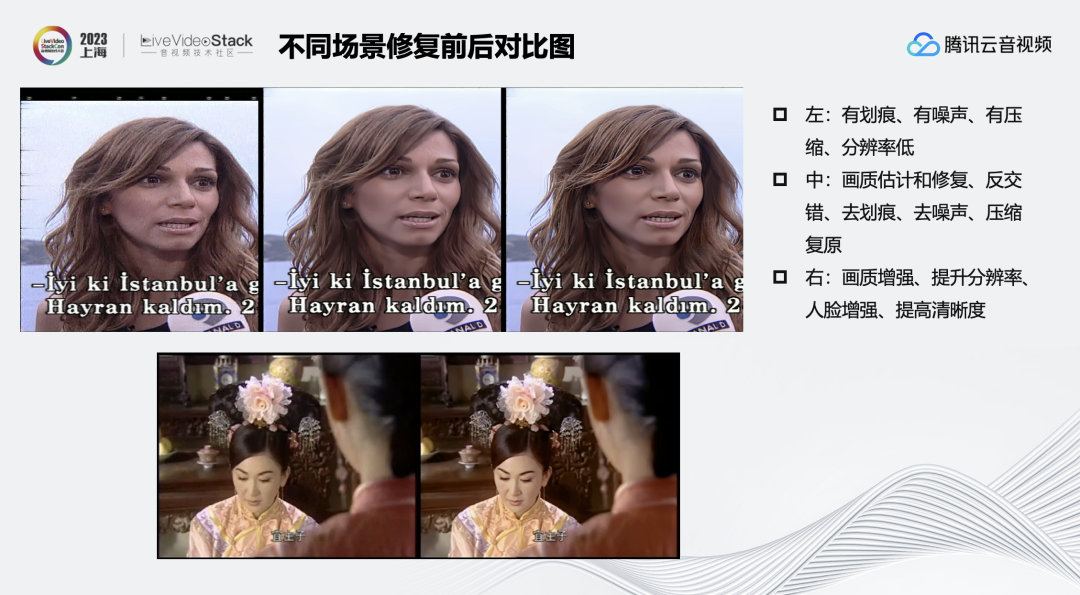

Después de detectar problemas a través de Sanbanaxe, también proporcionaremos las estrategias de reparación correspondientes. Aquí hay algunas imágenes comparativas antes y después de la restauración en varias escenas diferentes. La imagen de la izquierda muestra el efecto de la eliminación inteligente de marcas de agua. Después de eliminar la marca de agua, se ajusta de acuerdo con los valores de píxeles alrededor de la marca de agua para acercarse al efecto original. La estrategia que adoptamos al principio fue aplicar el desenfoque gaussiano directamente, pero una vez que los usuarios lo notaron, sería muy abrupto y más llamativo, por lo que más tarde comenzamos a intentar usar la red GAN para encajar las partes faltantes.

La imagen de la derecha muestra el efecto de eliminación de fluctuaciones, que se puede eliminar mediante la transcodificación. Puede ver claramente el mismo vídeo, la inquietud se alivia mucho y todo el movimiento del vídeo es más fluido.

Cuando se detecta que el vídeo tiene bordes en blanco y negro, puede eliminarlos de forma inteligente. Después de eliminar los bordes en blanco y negro, para mantener la misma resolución que antes, estiramos el video y tradujimos los subtítulos. Sin embargo, los estudiantes cuidadosos pueden encontrar que la proporción de la imagen es un poco extraña después de estirarla, por lo que ahora también estamos tratando de usar redes GAN o incluso modelos grandes para completar los detalles del borde. Cuando la imagen es oscura, los colores se pueden mejorar. El contraste entre las imágenes de izquierda y derecha a continuación es muy obvio.

La imagen de la izquierda tiene rayones, ruido, compresión y baja resolución. La imagen del medio es el resultado después de realizar la estimación y reparación de la calidad de la imagen, el desentrelazado, la eliminación de rayones, la eliminación de ruido, la restauración de la compresión y otras operaciones. La imagen de la derecha es el efecto después de mejorar la calidad de la imagen, mejorar la resolución, mejorar el rostro y mejorar la claridad. La siguiente imagen también es una restauración de una antigua serie de televisión. Utiliza superpuntuación, inserción de cuadros, mejora del color y otros procesos. El efecto de mejora es obvio.

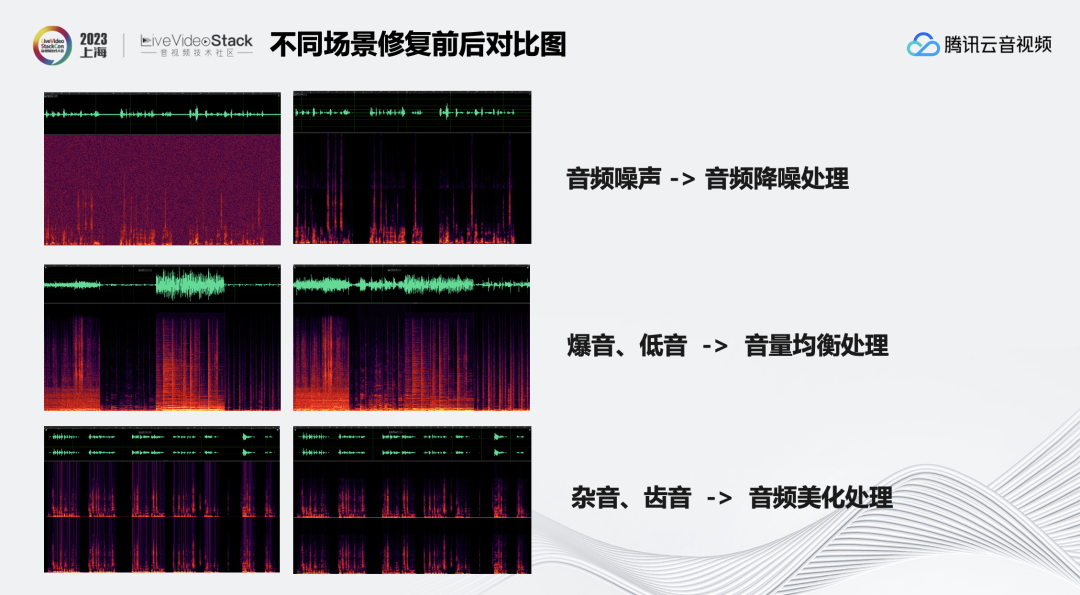

En el nivel de audio, el ruido del audio se puede eliminar mediante la reducción de ruido; o se puede usar la ecualización de volumen para reducir los sonidos estallidos en el audio, mejorar los graves y hacer que el sonido sea más natural; el audio también se puede embellecer para eliminar algo de ruido. y sibilancia.

-06-

prueba de experiencia

Para las capacidades mencionadas anteriormente, Tencent Cloud proporciona algunas interfaces para pruebas de experiencia, puede prestarles atención.

Sin conexión: https://cloud.tencent.com/document/api/862/37578

Transmisión en vivo: https://cloud.tencent.com/document/api/862/39227

Monitoreo: https://cloud.tencent.com/document/product/267/79959

Bajo demanda: https://cloud.tencent.com/document/product/266/94242

¡gracias a todos!

▲Escanee el código QR en la imagen o haga clic en " Leer el texto original " ▲

Acceso directo a LiveVideoStackCon 2023 Shenzhen Station 10% de descuento en el canal de compra de entradas