[ML-13-1 ] Modelo oculto de Markov HMM

[ML-13-2 ] Modelo oculto de Markov HMM- algoritmo hacia adelante y hacia atrás

[ML-13-3 ] Modelo oculto de Markov HMM - Baum-Welch ( Baum- Welch)

[ML-13-4 ] Modelo de Markov oculto HMM-- Algoritmo de Viterbi (Viterbi) para problemas de predicción

Directorio

- Conocimiento básico-cadena de Markov

- Introducción a HMM

- Definición HMM

- Tres problemas básicos del modelo HMM

- Ejemplos

1. Conocimiento básico-Cadena de Markov

1.1 Propiedades de Markov

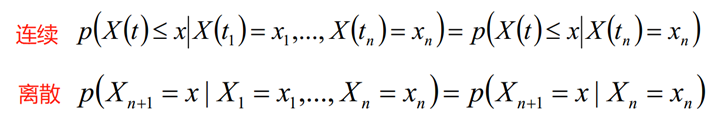

Sea {X (t), t ∈ T} un proceso aleatorio, E es su espacio de estado, si para cualquier t1 <t2 <... <tn <t, cualquier x1, x2, ..., xn, x∈E, la función de distribución condicional de la variable aleatoria X (t) bajo la variable conocida X (t1) = x1, ..., X (tn) = xn solo está relacionada con X (tn) = xn, pero con X (t1) = x1, ..., X (tn-1) = xn-1 es irrelevante, es decir, la función de distribución condicional satisface la siguiente ecuación, esta propiedad se llama propiedad de Markov; si el proceso aleatorio satisface la propiedad de Markov, entonces Este proceso se llama proceso de Markov.

1.2 cadena de Markov

- La cadena de Markov se refiere a un proceso aleatorio con propiedades de Markov. En el proceso, dada la información actual, el estado de la información pasada es irrelevante para predecir el estado futuro .

- Cadena de Markov En cada paso de la cadena de Markov, el sistema puede cambiar de un estado a otro de acuerdo con la distribución de probabilidad, o puede mantener el estado actual sin cambios. El cambio de estado se llama transición, y la probabilidad de cambio de estado se llama probabilidad de transición .

- Los tres elementos en la cadena de Markov son: espacio de estado S, matriz de probabilidad de transición P y distribución de probabilidad inicial π.

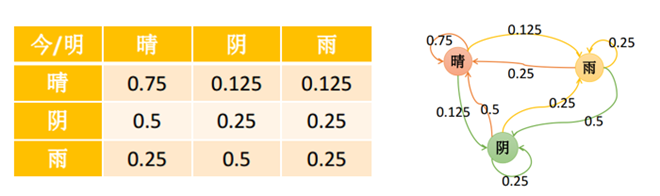

1.3 La caja de la cadena Markov

Suponga que el estado del tiempo se divide en tres estados: soleado, nublado y lluvia. Se supone que el estado del tiempo de un día determinado solo está relacionado con el estado del tiempo del día anterior. El estado está representado por 1 (despejado), 2 (nublado) y 3 (lluvia). La probabilidad de transición La matriz P es la siguiente:

La probabilidad de que el estado del tiempo en el día n + 1 sea j es:

Por lo tanto, la matriz P es la matriz de transición de probabilidad condicional.

El elemento de la fila i-ésima de la matriz P indica la probabilidad de distribución cuando el estado anterior es i, es decir, la suma de cada elemento de fila debe ser 1.

El estado final está relacionado con la matriz de transición y no tiene nada que ver con el valor inicial.

2. Introducción a HMM

El modelo oculto de Markov (HMM) es un modelo estadístico con alto rendimiento en los campos de reconocimiento de voz, reconocimiento de comportamiento, PNL y diagnóstico de fallas. Nuestro problema con el modelo HMM generalmente tiene estas dos características:

1) Nuestro problema se basa en secuencias, como series de tiempo o series de estado.

2) Hay dos tipos de datos en nuestro problema: un tipo de datos de secuencia es observable, es decir, la secuencia de observación, y el otro tipo de datos no es observable, es decir, la secuencia de estado oculta, denominada secuencia de estado.

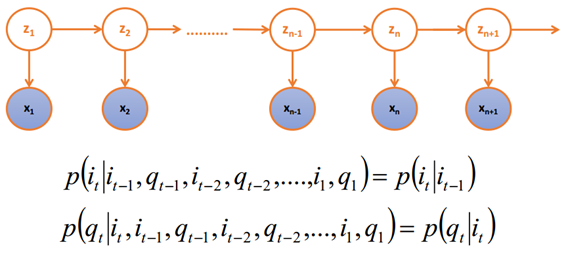

z1, z2 ..., zn son estados no observables, x1, x2, ... xn son secuencias observables; los estados no observables sienten el valor de las secuencias observables (el valor de z determina el valor de x) .

Cuando z1 y z2 no son observables, ¿son x1 y z2 independientes? ¿Son x1 y x2 independientes? --- Respuesta: no independiente

Dado z1, ¿son z2 y x1 independientes? --- Respuesta: Independiente

3. definición HMM

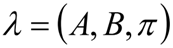

HMM consta de estado implícito S, estado observable O, matriz de probabilidad de estado inicial π, matriz de probabilidad de transición de estado implícito A y matriz de transición de valor observable B (también conocida como matriz de confusión); π y A determinan la secuencia de estado , B determina la secuencia de observación, por lo que HMM puede expresarse usando símbolos ternarios, dijo

Los tres elementos de HMM:

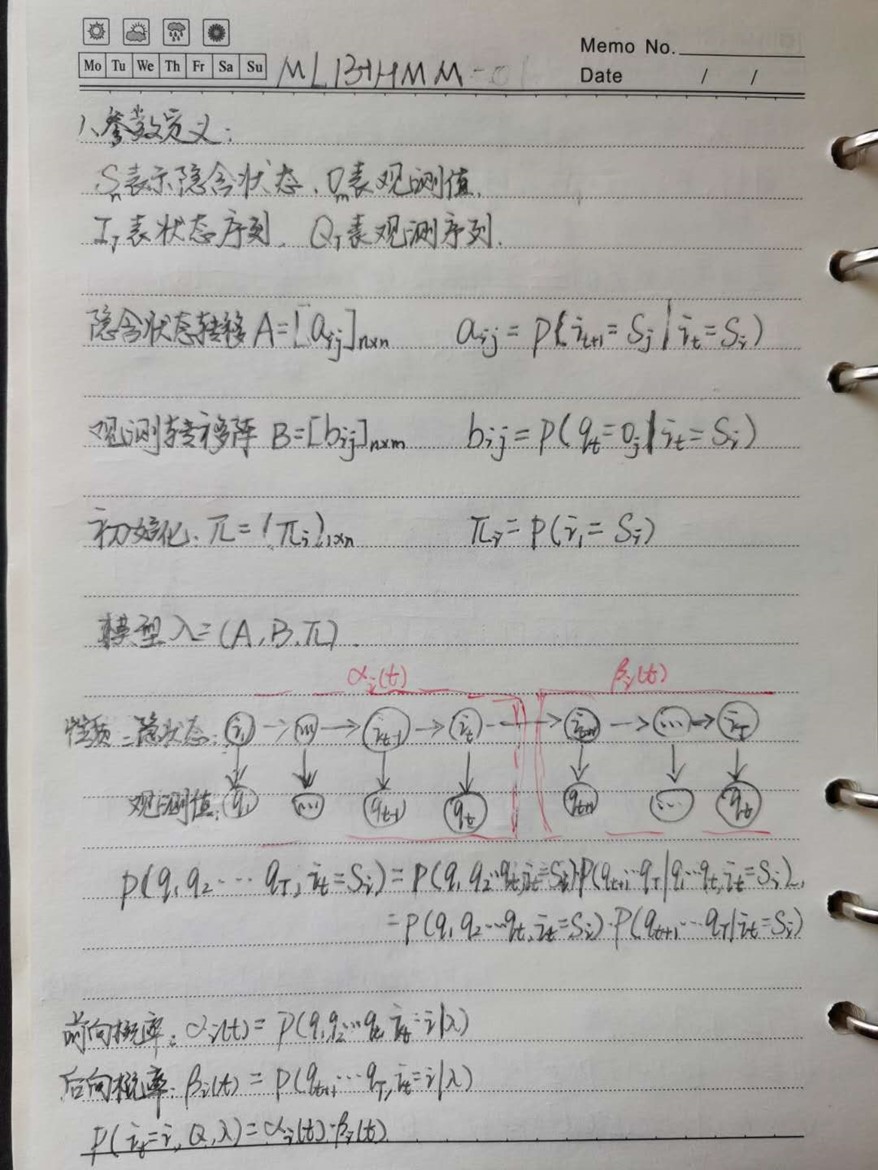

2.1 Parámetros HMM :

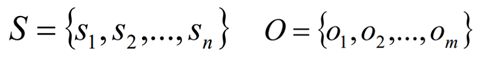

- S es el conjunto de todos los estados implícitos posibles; O es el conjunto de todas las observaciones posibles :

- I es una secuencia de estado de longitud T, Q es la secuencia de observación correspondiente:

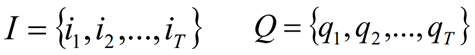

- A es la matriz de probabilidad de transición de estado implícita:

aij es la probabilidad de pasar al estado sj en el tiempo t + 1 cuando el tiempo t está en el estado si.

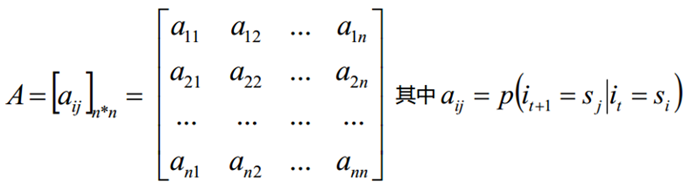

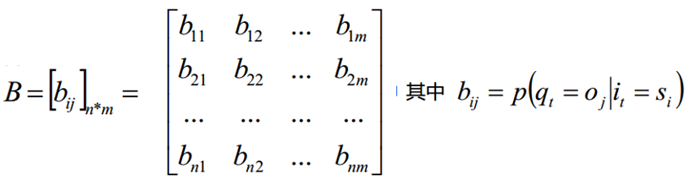

- B es la matriz de probabilidad de transferencia de valor observable:

bij es la probabilidad de que el valor de observación oj se genere bajo la condición de que esté en el estado si en el momento t.

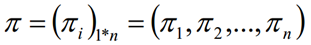

- π es el vector de probabilidad de estado inicial:

2.2 Propiedades básicas:

Cuatro, tres problemas básicos del modelo HMM

Problema de cálculo de probabilidad de secuencia de observación: algoritmo de avance-retroceso

Dado el modelo λ = (A, B, π) y la secuencia observada Q = {q1, q2, ..., qT}, calcule la probabilidad P (Q | λ) de la secuencia observada Q bajo el modelo λ. El más simple de los tres problemas del modelo HMM, vea la segunda parte de esta serie para más detalles.

Problema de aprendizaje del modelo: algoritmo de Baum-Welch (estado desconocido)

Dada la secuencia de observación Q = {q1, q2, ..., qT}, los parámetros del modelo λ = (A, B, π) se estiman para que la secuencia de observación P (Q | λ) sea la más grande en este modelo. La solución de este problema necesita usar Baum-Welch basado en el algoritmo EM. Es el más complicado de los tres problemas del modelo HMM. Vea la tercera parte de esta serie para más detalles.

El problema de predicción también se llama problema de decodificación: algoritmo de Viterbi (Viterbi)

Dado el modelo λ = (A, B, π) y la secuencia de observación Q = {q1, q2, ..., qT}, encuentre la secuencia de estado implícita con la mayor probabilidad condicional P (I | Q, λ) de la secuencia de observación dada I. La solución de este problema requiere el algoritmo de Viterbi basado en programación dinámica. Vea la cuarta parte de esta serie para más detalles.

5. Ejemplos

Supongamos que hay tres cajas, numeradas 1,2,3; cada caja está equipada con pequeñas bolas de colores blanco y negro, la proporción de las bolas es la siguiente:

De acuerdo con las siguientes reglas, la bola con el reemplazo se extrae para obtener la secuencia de observación del color de la bola:

- Seleccione un cuadro de acuerdo con la probabilidad de π, extraiga aleatoriamente una pequeña bola del cuadro, registre el color y vuelva a colocarlo en el cuadro;

- Seleccione un nuevo cuadro de acuerdo con una cierta probabilidad condicional y repita la operación;

- Obtuve la secuencia de observación finalmente: "Blanco negro y blanco blanco negro

- Conjunto de estados: S = {Cuadro 1, Cuadro 2, Cuadro 3}

- Conjunto de observación: O = {blanco, negro}

- Secuencia de estado y longitud de secuencia de observación T = 5

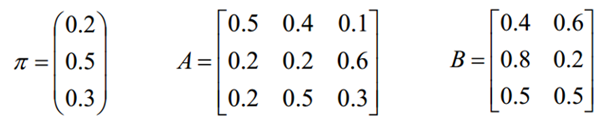

- Distribución de probabilidad inicial π

- Matriz de probabilidad de transición de estado A (hipótesis)

- Matriz de probabilidad de observación B (basada en datos)

Suponga que la regla de la matriz de probabilidad de transición de estado A es: si el cuadro que se dibuja actualmente es el primer cuadro, entonces la probabilidad de 0.5 permanece en el primer cuadro para continuar dibujando, y la probabilidad de 0.4 al segundo cuadro para dibujar la bola, para 0.1 probabilidad de ir al tercer cuadro para dibujar la pelota. Si el cuadro que se está dibujando actualmente es el segundo cuadro, permanecerá en el segundo cuadro con una probabilidad de 0.2 para continuar dibujando la pelota, vaya al primer cuadro con una probabilidad de 0.2 para dibujar la pelota y vaya al tercer cuadro con una probabilidad de 0.6 Pelota. Si el cuadro que se dibuja actualmente es el tercer cuadro, entonces permanecerá en el tercer cuadro con una probabilidad de 0.3 para continuar dibujando la pelota, ir al primer cuadro con una probabilidad de 0.2 y pasar al segundo cuadro con una probabilidad de 0.5 Pelota. Así que continúa hasta repetir cinco veces

Dados los parámetros π, A y B, ¿cuál es la probabilidad de que la secuencia observada sea "blanca, negra, blanca, blanca y negra"?

Apéndice 1: ejercicios de escritura a mano