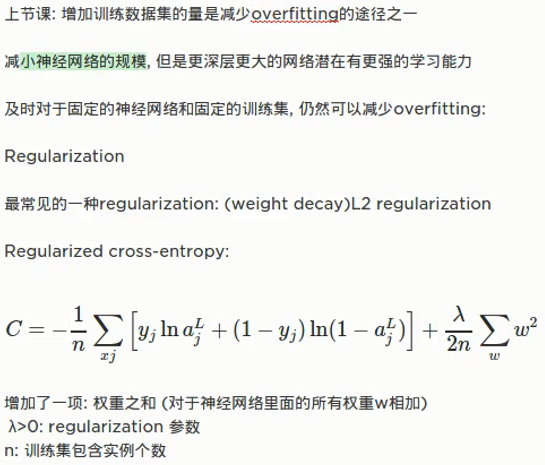

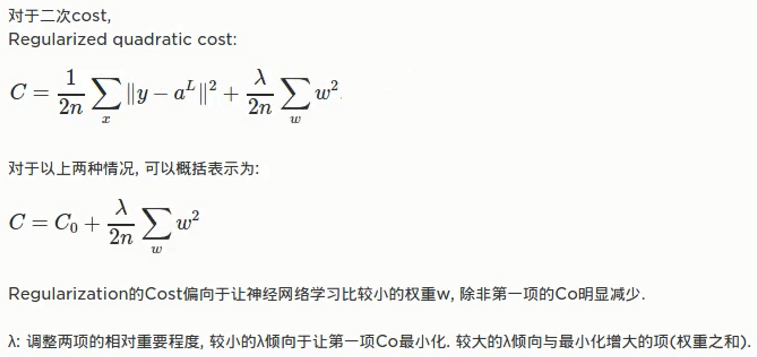

Regularization:

L2:

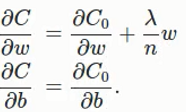

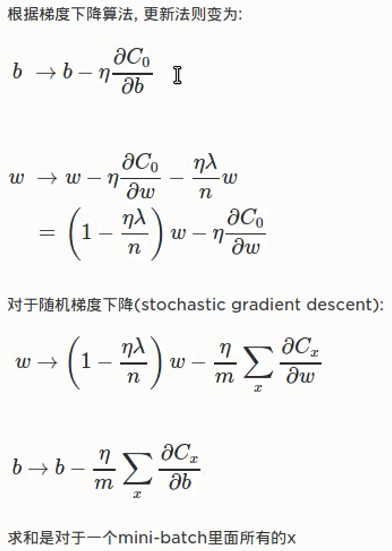

Regularization后权重减小了,按比例减小,比例为:![]()

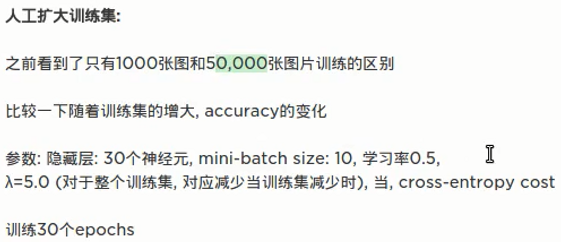

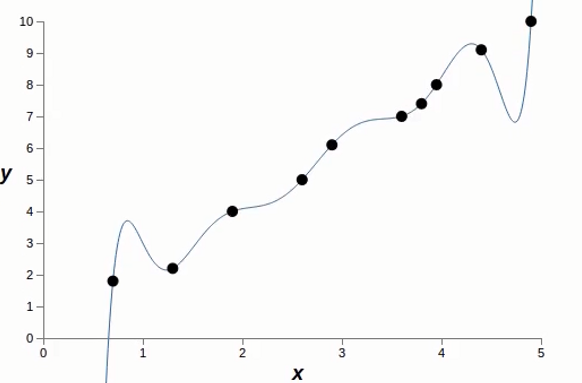

我们建的第一个模型:

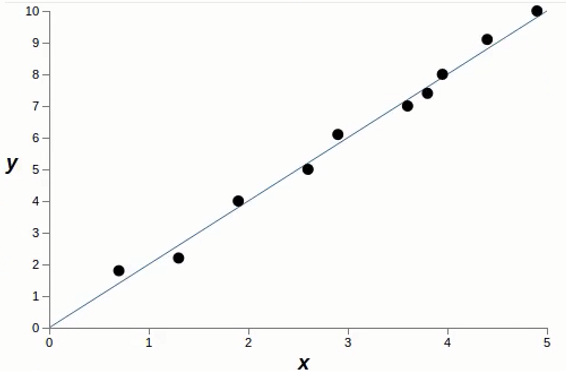

我们建的第二个模型:

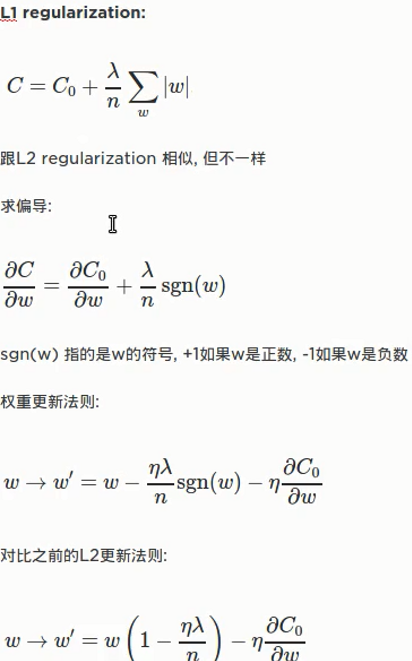

L1:

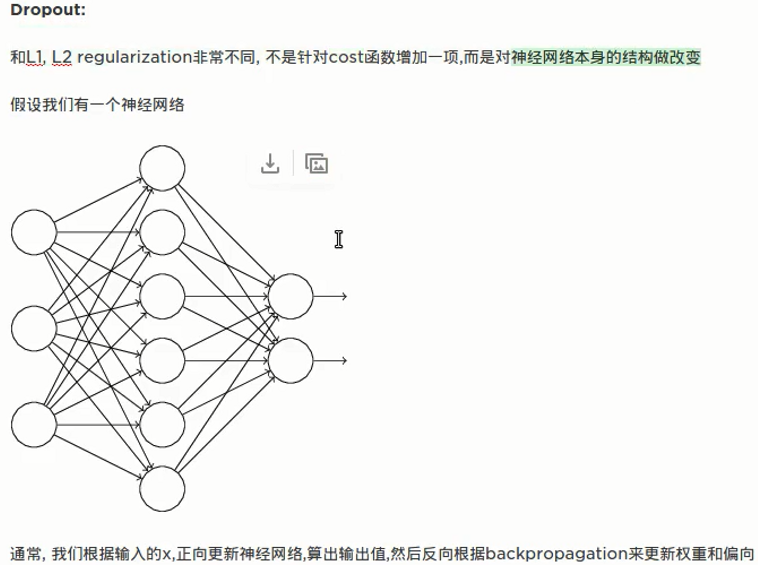

Dropout:

先删除一半然后向前更新再反向传播更新参数(w和b),然后把刚刚删除的神经元恢复,再重新随机选一半删掉

另一种减少过拟合的方法: