环境:win10

这里介绍了在spark环境下如何通过shell来打开python和scala

目标:

由于我擅长python语言,jupyter notebook 是我比较熟悉的编辑器(由于其方便的单元测试,可以很好的进行结果展示)

所以,我想在pyspark环境下启动jupyter notebook!!!

确定好目标需求之后,来执行吧!

首先查阅网上是咋操作的,我尝试了一圈确定最简单且有效的方案如下

step1:首先检查在spark环境下是否可以通过shell打开python和scala,这一步是基础,确保你的安装没出问题!

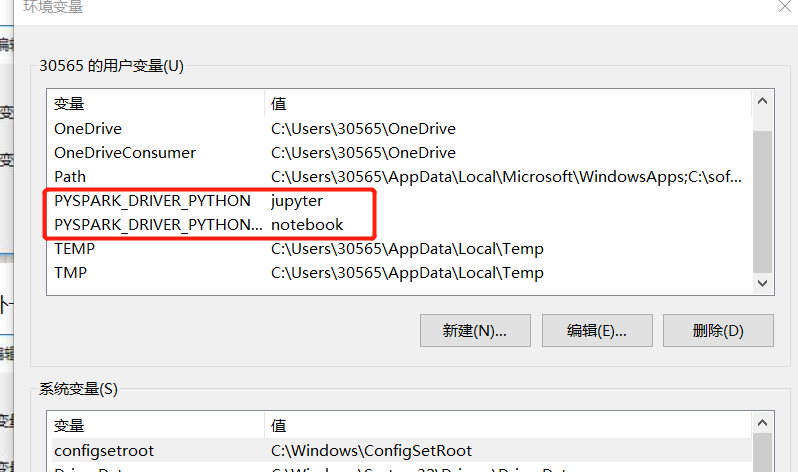

step2: 需要配置环境变量---用户变量---新建

直接在windows环境变量中增加两个pyspark启动时需要检查的变量即可将python解释环境转移到jupyter notebook

第一个用户变量是PYSPARK_DRIVER_PYTHON:jupyter

第二个用户变量是PYSPARK_DRIVER_PYTHON_OPTS:notebook

结果如下:

step3:分两种情况

(1)若已经配置了好了spark的环境变量(系统变量)

直接在终端输入: pyspark

就可以进入pyspark下的jupyter notebook

结果如下:

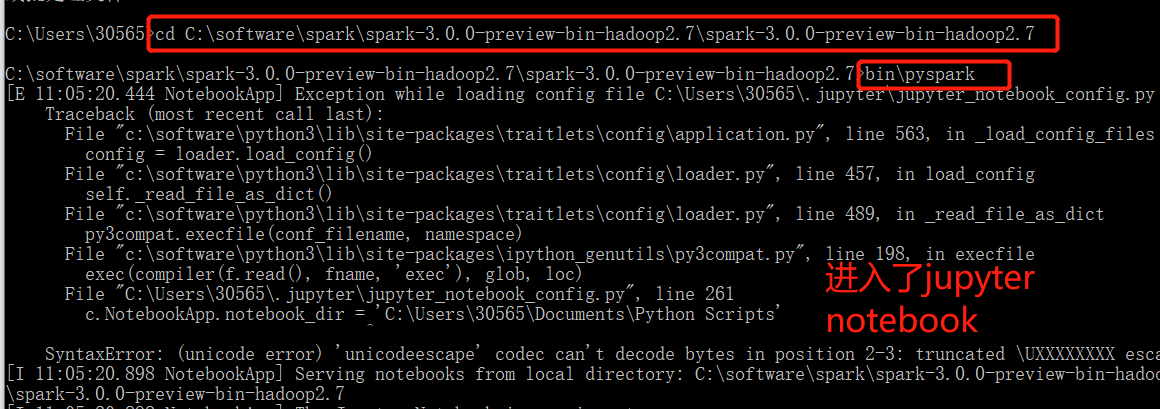

(2)若没有配置spark的环境变量

需要先进入spark的目录,然后输入: bin\pyspark

结果如下:

step4:开心吧,我们完成了啊,开始写代码吧!

补充一点:

上述操作完成之后,我的计算机就只能进入jupyter notebook版本的操作,shell进不去了,除非我将环境变量--用户变量的2个新增删除!

如果后续我能将2者共存之后,再给出解决方案!