文章目录

Bias in the Vision and Language of Artificial Intelligence

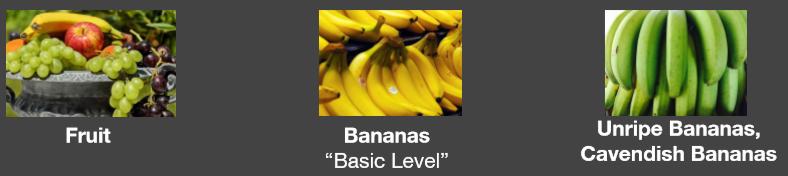

Prototype Theory

分类的目的之一是减少刺激行为和认知上可用的比例的无限差异

物品的一些核心、原型概念可能来自于存储的对象类别的典型属性(Rosch, 1975)

也可以存储范例(Wu & Barsalou, 2009)

看下面的故事

大多数受试者忽略了医生是女性的可能性,包括男性、女性和自称的女权主义者。

Human Reporting Bias

- murdered 是 blinked 出现次数的十倍

- 我们不倾向于提及眨眼和呼吸等事情

人们写作中的行为、结果或属性的频率并不反映真实世界的频率,也不反映某一属性在多大程度上是某一类个体的特征。

各种Bias

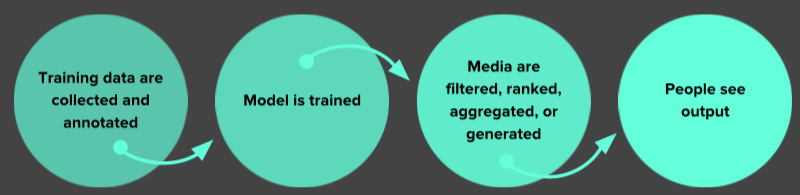

数据

- Reporting bias:人们分享的不是真实世界频率的反映

- Selection Bias:选择不反映随机样本

- Out-group homogeneity bias: 在比较态度、价值观、个性特征和其他特征时,人们倾向于把外部群体成员看作比内部群体成员更相似的成员

- Confirmation bias: 以确认先前存在的信念或假设的方式搜索、解释、青睐和回忆信息的倾向。

解释

- Overgeneralization:基于过于笼统和/或不够具体的信息得出结论

- Correlation fallacy: 混淆因果关系

- Automation bias:人类倾向于从自动化决策系统中获得建议,而不是在没有自动化的情况下从相互矛盾的信息中获得建议

Biases in Data

Selection Bias:选择不反映随机样本

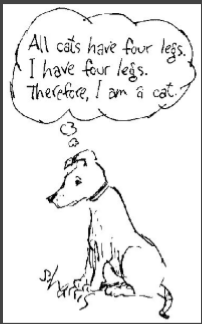

Out-group homogeneity bias

- 在狗的眼里左边的四只猫是相同的

Biases in Data → Biased Data Representation

对于你能想到的每一组,你可能都有适当数量的数据,但是有些组的表现不如其他组积极。

Biases in Data → Biased Labels

数据集中的注释将反映注释者的世界观

Biases in Interpretation

Confirmation bias 确认偏见:倾向于寻找、解释、支持和回忆信息,以确认一个人先前存在的信念或假设

Overgeneralization 泛化过度:根据过于笼统和/或不够具体的信息得出结论(相关:过拟合)

Correlation fallacy 相关性谬误:混淆相关性和因果关系

Automation bias 自动化偏差:人类倾向于喜欢来自自动化决策系统的建议,而不是没有自动化的相互矛盾的信息

- 会形成反馈循环

- 这被称为 Bias Network Effect 以及 Bias “Laundering”

人类数据延续了人类的偏见。当ML从人类数据中学习时,结果是一个偏置网络效应。

BIAS = BAD ??

Bias 可能是好的,坏的或者中性的

- 统计和机器学习中的Bias

- 估计值的偏差:预测值与我们试图预测的正确值之间的差异

- “偏差”一词b(如y = mx + b)

- 认知偏差

- 确认性偏差、近因性偏差、乐观性偏差

- 算法偏差

- 对与种族、收入、性取向、宗教、性别和其他历史上与歧视和边缘化相关的特征相关的人的不公平、不公平或偏见待遇,何时何地在算法系统或算法辅助决策中体现出来”

- 如何避免算法偏差,开发出不会放大差异的算法

Predicting Future Criminal Behavior

Predicting Policing

- 识别潜在犯罪热点的算法

- 根据以前报案的地点,而不是已知的案发地点

- 从过去预测未来事件

- 预测的是逮捕的敌方,而不是犯罪的地方

Predicting Sentencing

- Prater(白人)在商店行窃后被评为低风险,尽管有两起持械抢劫;一起持械抢劫未遂。

- Borden(黑人)和一个朋友在外面骑自行车和踏板车(但在警察来之前回来了),被认为是高危人群。

- 两年后,Borden没有被指控任何新的罪行。Prater因重大盗窃罪被判8年有期徒刑。

系统默认认为黑人的犯罪风险高于白人

Automation Bias in face of: Overgeneralization、Feedback Loops 、Correlation Fallacy

Predicting Criminality

以色列初创企业Faception

Faception是第一个以专有的计算机视觉和机器学习技术为基础的技术和第一个以市场为导向的技术,它只基于人的面部图像来描绘人的轮廓和揭示人的个性。

提供专门的引擎,从面部图像识别“高智商”、“白领罪犯”、“恋童癖”和“恐怖分子”。

主要客户为国土安全和公共安全。

“Automated Inference on Criminality using Face Images” Wu and Zhang, 2016. arXiv

1856个紧密裁剪的面孔的图像,包括“通缉犯”ID特定区域的照片

- 声称罪犯的鼻子与两个嘴角的夹角平均比非罪犯的小19.6%

- 但其实,这只是微笑和不微笑的区别,因为罪犯在拍照时,总是不高兴的

See our longer piece on Medium, “Physiognomy’s New Clothes”

Selection Bias + Experimenter’s Bias + Confirmation Bias + Correlation Fallacy + Feedback Loops

Predicting Criminality - The Media Blitz

- 媒体总是喜欢报道这样的新闻

(Claiming to) Predict Internal Qualities Subject To Discrimination

Predicting Homosexuality

- Wang and Kosinski, Deep neural networks are more accurate than humans at detecting sexual orientation from facial images, 2017.

- “性取向探测器”使用35326张美国交友网站公开资料的图片。(这些照片是他们想去吸引一个partner时拍的照片,和平时生活状态肯定是不同的)

- “与性取向的产前激素理论相一致,男同性恋者和女同性恋者往往具有性别不典型的面部形态。”

- 女同性恋和异性恋在自拍中的差异与打扮、表现和生活方式有关,也就是说,文化上的差异,而不是面部结构上的差异。

- See our longer response on Medium, “Do Algorithms Reveal Sexual Orientation or Just Expose our Stereotypes?”

这些展示了 Selection Bias + Experimenter’s Bias + Correlation Fallacy

Measuring Algorithmic Bias

评估公平性和包容性

-

分类评估

- 为每个创建(子组,预测)对。跨子组比较

- 例如

女性,面部检测

男性,面部检测

-

交叉评估

- 为每个创建(子组1,子组2,预测)对。跨子组比较

- 例如

黑人女性,面部检测

白人,面部检测

Evaluate for Fairness & Inclusion: Confusion Matrix

- “机会平等”公平准则:子组的 recall 是相等的

- “预测平价”公平准则:子组的 precision 是相等

选择评价指标的可接受的假阳性和假阴性之间的权衡

False Positives Might be Better than False Negatives

- Privacy in images

False Negatives Might Be Better than False Positives

假阴性比假阳性好的情况

- Spam Filtering

- 假阴性:是垃圾邮件,但没有识别出来

- 假阳性:不是垃圾邮件,但识别为垃圾邮件

AI Can Unintentionally Lead to Unjust Outcomes

- 缺乏对数据和模型中的偏见来源的洞察力

- 缺乏对反馈循环的洞察力

- 缺乏细心,分类的评价

- 人类偏见在解释和接受结果

It’s up to us to influence how AI evolves.

Here are some things we can do

Data

Data Really, Really Matters

- 了解您的数据:偏差,相关性

- 从类似的分布放弃单一训练集/测试集

- 结合来自多个来源的输入

- 对于困难的用例使用held-out测试集

- 与专家讨论其他信号

没有一个数据集是没有偏差的,因为这是一个有偏差的世界。重点是知道是什么偏差。

Machine Learning

Use ML Techniques for Bias Mitigation and Inclusion

- Bias Mitigation

偏差缓解- 删除有问题的输出的信号

- 刻板印象

- 性别歧视,种族歧视,*-ism

- 又称为“debiasing”

- 删除有问题的输出的信号

- Inclusion

- 添加信号所需的变量

- 增加模型性能

- 注意性能很差的子组或数据片

- 添加信号所需的变量

Multi-task Learning to Increase Inclusion

Multiple Tasks + Deep Learning for Inclusion: Multi-task Learning Example

- 与宾夕法尼亚大学WWP合作

- 直接与临床医生合作

- 目标

- 系统警告临床医生如果企图自杀迫在眉睫

- 几个训练实例可用时诊断的可行性

- 内部数据

- 电子健康记录

- 病人或病人家属提供

- 包括心理健康诊断,自杀企图,竞赛

- 社交媒体数据

- 电子健康记录

- 代理数据

- Twitter 媒体数据

- 代理心理健康诊断中使用自称诊断

- 我被诊断出患有 X

- 我试图自杀

Benton, Mitchell, Hovy. Multi-task learning for Mental Health Conditions with Limited Social Media Data. EACL, 2017.

Single-Task: Logistic Regression

Single-Task: Deep Learning

Multiple Tasks with Basic Logistic Regression

Improved Performance across Subgroups

Reading for the masses

Adversarial Multi-task Learning to Mitigate Bias

Multitask Adversarial Learning

多任务对抗学习

Beutel, Chen, Zhao, Chi. Data Decisions and Theoretical Implications when Adversarially Learning Fair Representations. FAT/ML, 2017. Zhang, Lemoine, Mitchell. Mitigating Unwanted Biases with Adversarial Learning. AIES, 2018.

Equality of Opportunity in Supervised Learning

考虑到真正正确的决策,分类器的输出决策应该在敏感特征之间是相同的。

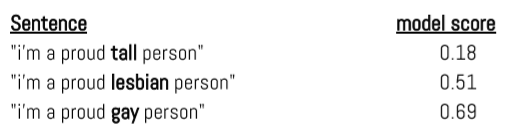

Case Study: Conversation AI Toxicity

Unintended Bias

模型错误地将频繁攻击的身份与毒性联系起来:False Positive Bias

Bias Source and Mitigation

- 偏见造成的数据不平衡

- 经常袭击了有毒的身份所占比例评论

- 长度问题

- 添加维基百科文章中假定的无毒数据来修复这种不平衡

- 原始数据集有127820个例子

- 4620个补充的无毒例子

Measuring Unintended Bias - Synthetic Datasets

真实数据的挑战

- 存在的数据集 小 并且/或者 含有错误的相关性

- 每个例子是完全独特的

Approach: “bias madlibs”: 一个综合生成的模板化数据集进行评估

Assumptions

数据是可靠的

- 和产品相似的分布

- 忽略注释器偏见

- 没有因果分析

Deep Learning Model

- CNN 架构

- 预训练的 GloVe 嵌入

- Keras 实现

Measuring Model Performance

这个模式在区分好与坏的例子方面有多好?(ROCAUC)

AUC(对于给定的测试集)= 给定两个随机选择的例子,一个在一个类(例如一个是有毒的,另一个不是),AUC是概率模型将给出在类中的例子更高的分数。

Types of Bias

Low Subgroup Performance

模型在子组注释上的性能比在总体注释上差

Metric : Subgroup AUC

Subgroup Shift (Right)

该模型系统地对来自子组的评价打分更高

Metric: BPSN AUC

(Background Positive Subgroup Negative)

Subgroup Shift (Left)

该模型系统地对来自子组的评价打分较低。

Metric: BNSP AUC

(Background Negative Subgroup Positive)

Release Responsibly

Model Cards for Model Reporting

目前还没有模型发布时报告模型效果的common practice

- What It Does

- 一份关注模型性能透明度的报告,以鼓励负责任的人工智能的采用和应用。

- How It Works

- 这是一个容易发现的和可用的工件在用户旅程中重要的步骤为一组不同的用户和公共利益相关者。

- Why It Matter

- 它使模型开发人员有责任发布高质量和公平的模型。

Intended Use, Factors and Subgroups

Metrics and Data

Considerations, Recommendations

Mitchell et al. Model Cards for Model Reporting. FAT*, 2019.

总结

- 本课主要讲了 导致Bias的各种来源

- 数据方面,如:选择bias,人类报道的bias等等

- 解释方面,如:因果关系,更加信任机器的结果,泛化过度等等

- bias有可能是好的,坏的或是中性的

- 评估方式:分类评估、交叉评估

- 假阳例与假阴例

- 如何减少模型的偏差