环境准备

Pentaho Kettle : 4.3.0~5.1.0

插件:pdi-ce-5.1.0.0-752中的pentaho-big-data-plugin

插件配置 : cdh50

Hadoop : hadoop-2.7.4

HBase : hbase-1.2.6

创建HBase表

1、打开HBase Shell

# hbase shell2、在HBase中创建表

create 'weblogs', 'pageviews'3、在HBase中查询表

scan 'weblogs', {LIMIT => 10}4、关闭HBase Shell

quit创建Transformation加载数据到HBase

1、启动Ketttle,并新建一个Transformation

2、添加【CSV输入】插件

3、配置【CSV输入】插件,如图所示:

4、添加【HBase输出】插件

5、连接【CSV输入】【HBase输出】插件,如图所示

6、配置【HBase输出】插件

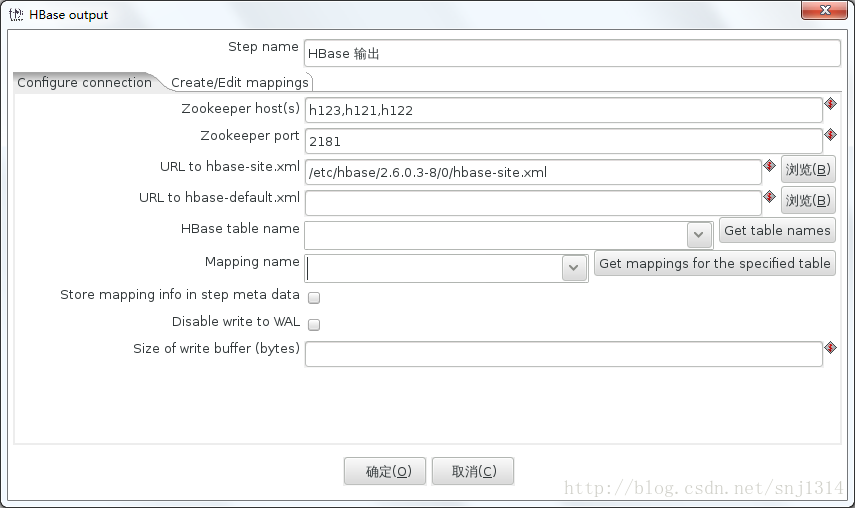

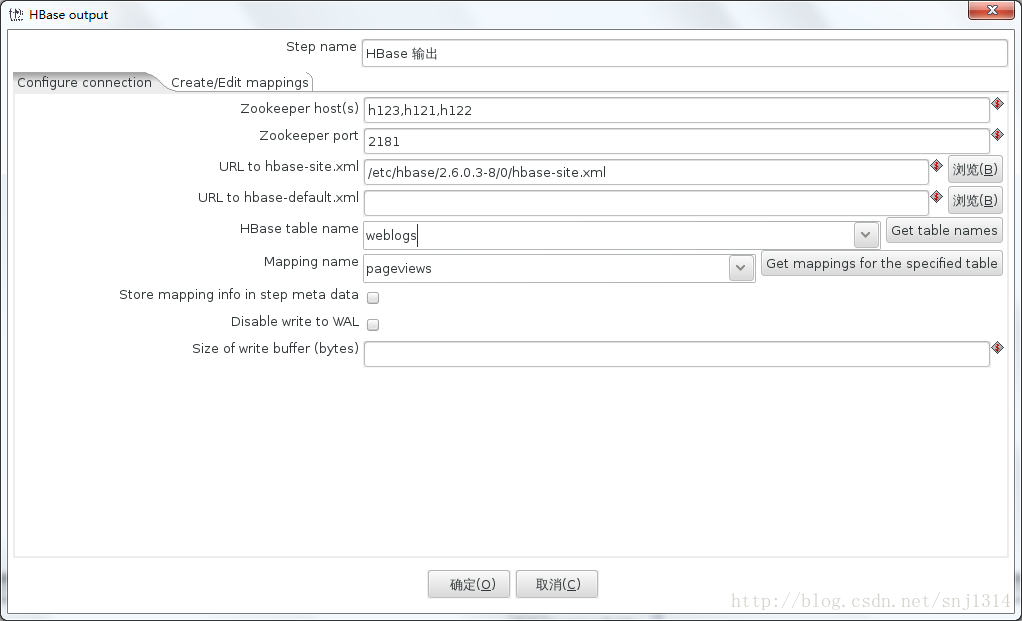

Configure connection 基本配置

a、Zookeeper host(s): HBase Zookeeper Hosts 用“,”分隔的列表;

b、Zookeeper port: Zookeeper hosts 端口。HBase默认为 '2181';

如图所示:

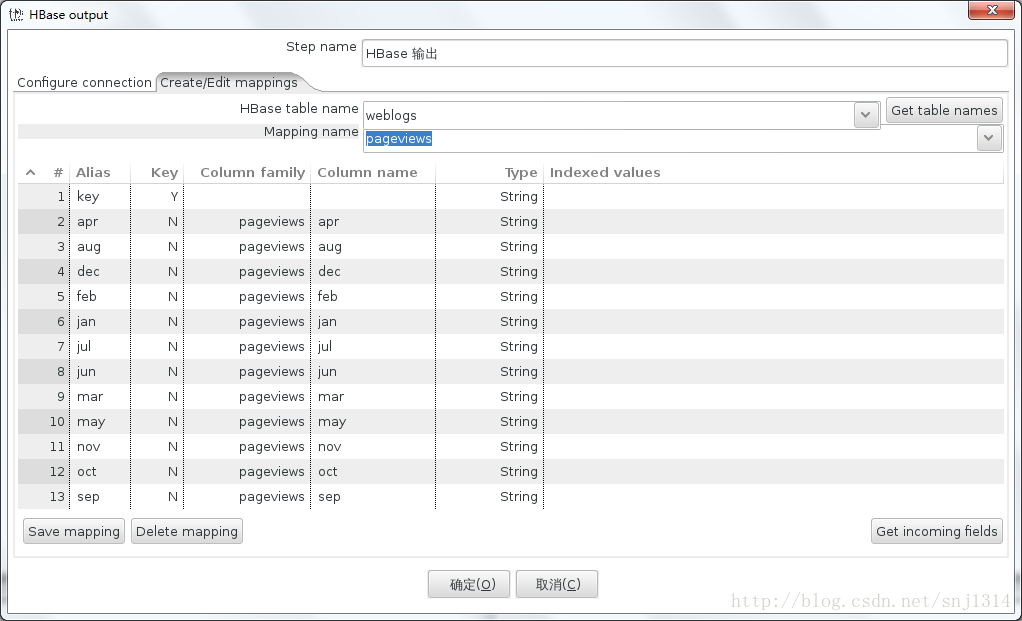

Create/Edit mappings 配置

a、HBase table name:点击【Get table names】选择 'weblogs';

b、Mapping name:输入'pageviews';

c、点击 'Get incoming fields' 按钮;

d、修改Alias为key行的配置信息,修改Key为Y,修改'Column family' 与'Column name'为空,修改Type为'String';

e、点击 'Save mapping' 按钮;

f、Mapping name:输入'pageviews';

如图所示:

完成Configure connection 最终配置

a、HBase table name:点击'Get table names'选择 'weblogs';

b、Mapping name:点击'Get mappings for the specified table'选择 'pageviews';

如图所示:

7、保存转换

8、运行转换

查看HBase

1、打开HBase Shell

# hbase shell2、在HBase中查询表

scan 'weblogs', {LIMIT => 10}3、关闭HBase Shell

quit本文附件地址:

链接: https://pan.baidu.com/s/1-1l9YyIKHT68W3iwDqbsMg 密码: 9p5h