简介

IK Analyzer 是一个开源的,基于 java 语言开发的轻量级的中文分词工具包。它是以开源项目Luence 为应用主体的,结合词典分词和文法分析算法的中文分词组件,IK 实现了简单的分词歧义排除算法,标志着 IK 分词器从单纯的词典分词向模拟语义分词衍化。

作用: 有中文语义分析的效果, 对中文分词效果好.

配置

一、把IKAnalyzer2012FF_u1.jar 添加到 solr 工程的 lib 目录下,根据自己的安装目录来操作

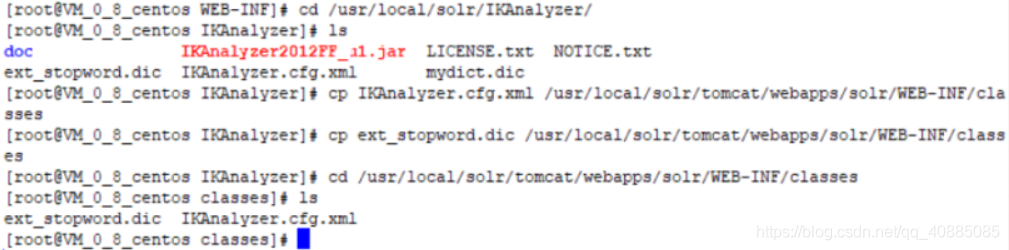

①进入IKAnalyzer文件目录下:cd /usr/local/solr/IKAnalyzer/

②复制文件:cp IKAnalyzer2012FF_u1.jar /usr/local/solr/tomcat/webapps/solr/WEB-INF/lib/

二、创建WEB-INF/classes文件夹

①进入Tomca的WEB-INF文件夹下:cd /usr/local/solr/tomcat/webapps/solr/WEB-INF/

②创建classes文件夹:mkdir classes

三、把扩展词典、停用词词典、配置文件放到 solr 工程的 WEB-INF/classes 目录下

①进入IKAnalyzer文件目录下:cd /usr/local/solr/IKAnalyzer/

②复制配置文件:cp IKAnalyzer.cfg.xml /usr/local/solr/tomcat/webapps/solr/WEB-INF/classes

③复制停用词典:cp ext_stopword.dic /usr/local/solr/tomcat/webapps/solr/WEB-INF/classes

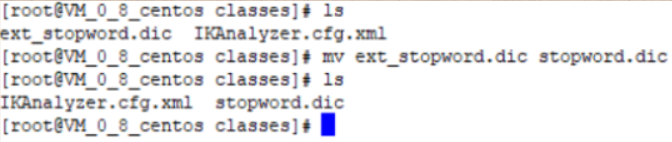

④修改停用词典名字:mv ext_stopword.dic stopword.dic

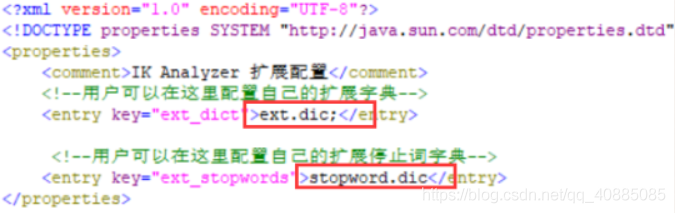

四、修改IKAnalyzer.cfg.xml配置文件,stopword.dic已经有了,而ext.dic还没有

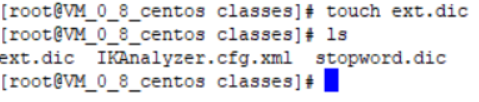

①创建ext.dic:touch ext.dic

②修改扩展词字典和停止词字典:vim IKAnalyzer.cfg.xml

五、解释停止词典和扩展词典

stopword.dic - 停止词典:切分词的时候, 凡是出现在停止词典中的词都会被过滤掉

ext.dic - 扩展词典:凡是专有名词都会放到这里, 如果自然语义中不是一个词, 放到这里后solr切分词的时候就会切分成一个词

六、配置分词器

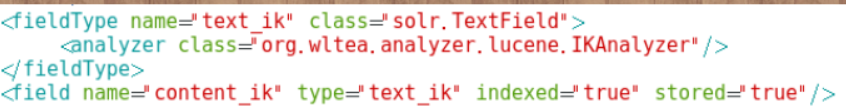

1.修改 Solrhome 的 schema.xml 文件

①进入到conf文件夹下:cd /usr/local/solr/solrhome/collection1/conf

②修改 schema.xml ,在文件最后添加(注:需在</schema>标签内)

<fieldType name="text_ik" class="solr.TextField">

<analyzer class="org.wltea.analyzer.lucene.IKAnalyzer"/>

</fieldType>③自定义域名使用自己创建的分词器

<field name="content_ik" type="text_ik" indexed="true" stored="true"/>

2.关闭和重启Tomcat

cd /usr/local/solr/tomcat/bin/

./shutdown.sh

./startup.sh

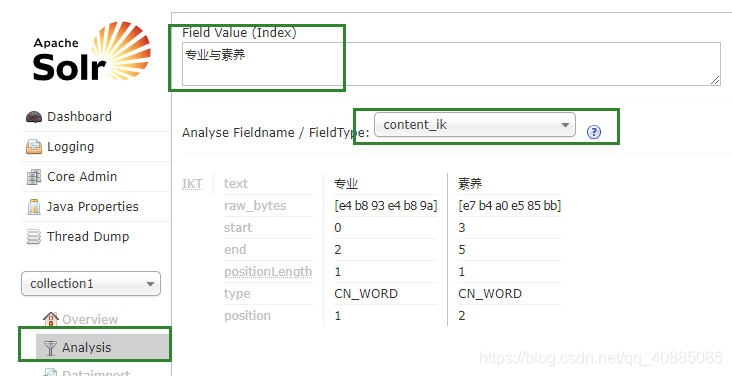

3.测试