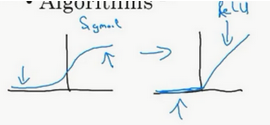

relu激活函数的优势:

(1)反向传播时,可以避免梯度消失。

(2)Relu会使一部分神经元的输出为0,这样就造成了网络的稀疏性,并且减少了参数的相互依存关系,缓解了过拟合问题的发生(以及一些人的生物解释balabala)。

(3)相对于sigmoid激活函数,tanh激活函数,求导简单。采用sigmoid等函数,算激活函数时(指数运算),计算量大,反向传播求误差梯度时,求导涉及除法,计算量相对大,而采用Relu激活函数,整个过程的计算量节省很多。

缺点:

(1)左侧神经元为0,导致神经元死亡,不再更新。

(2)输出非负,仍然存在zigzag现象。

参考文章1:【深度学习】为什么使用ReLU作为激活函数,ReLU比sigmoid优秀在哪里