一、Word Embedding

1.Word2Vec(2013)

分布式假设:假设两个词上下文相似,则它们的语义也相似。

2.GloVe

二、RNN改进和扩展

问题:词向量不考虑上下文,无法解决“一词多义”

解决方案:RNN具有“记忆”能力

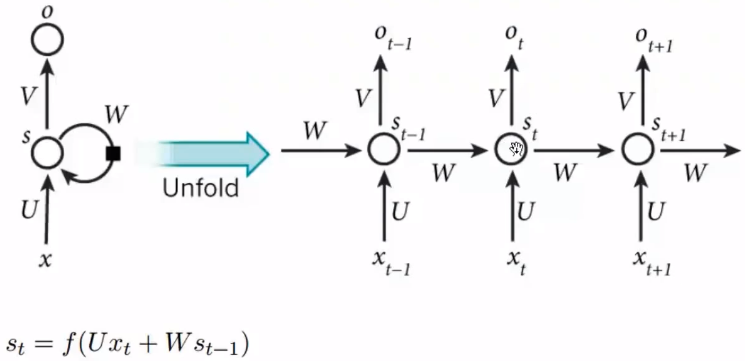

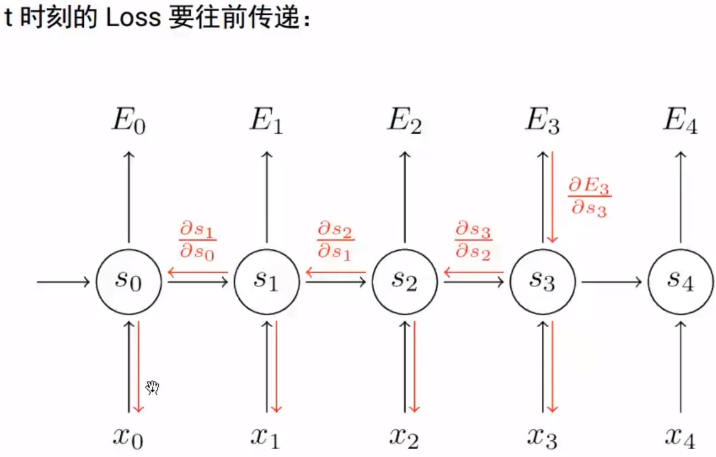

1.RNN

RNN的问题:顺序依赖,无法并行。(单向信息流)

2.LSTM/GRU

2.1 LSTM

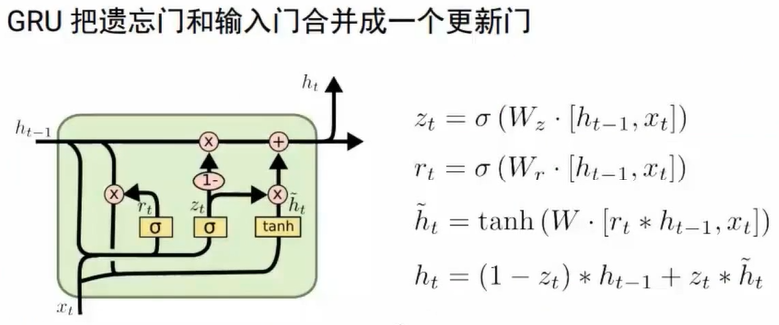

2.2 GRU

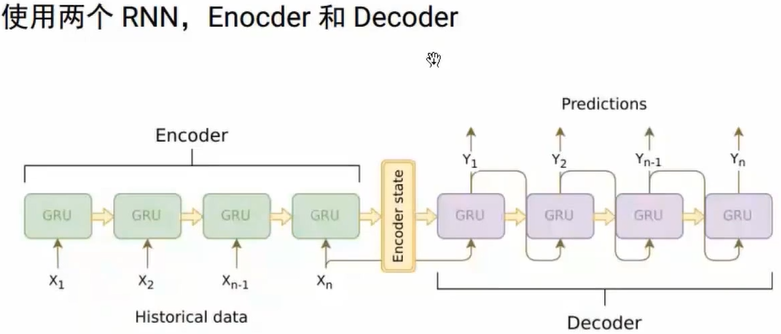

3.Seq2Seq

可用于翻译、摘要、问答和对话系统

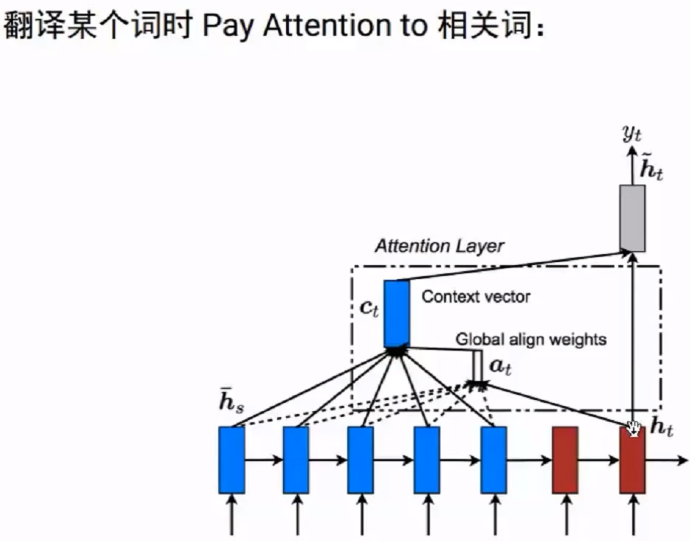

问题:定长的context向量

3.Attention/Self Attention

三、Contextual Word Embedding

问题:监督数据量不足,难以学到复杂的上下文表示;

解决方案:无监督的contextual word embedding:ELMo、OpenAI GPT、BERT

1.ELMo

2.OpenAI GPT

3.BERT