ICC(intraclass correlation coeficient):

用来评价对同一对象的多次测量之间的信度(reliability scale)#在SPSS中就是在这个词组里包含ICC检验的。

比如测量实验老鼠的影像学指标,需对同一只老鼠测量8次,取其平均数或中位数来表示该老鼠的最终结果值

计算公式为

MS(mean square)均方差,m为测量次数。均方差的计算见two-way ANOVA对方差的分解。

ICC最后得到一个0--1的值,如果ICC值小于0.4,我们认为诊断试验的可重复性较差;如果ICC值大于0.75,那么诊断试验的可重复性好。

参考:https://www.mediecogroup.com/method_article_detail/41/

http://www.doc88.com/p-3856737116572.html

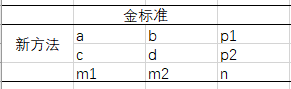

KAPPA用于评价不同测量者(2位)对同一事物的判断(二分类)是否准确, 比如医生对同一批患者使用两种诊断方式,评价两种诊断方式的一致性

P0(实际一致性)=a+d/n #两种方法一致的占总数的比例

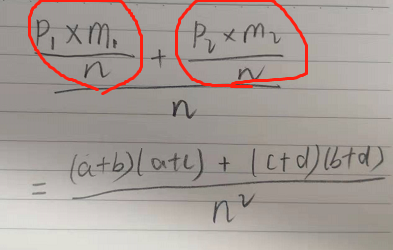

Pe(理论一致性)=((p1*m1)/n+(p2*m2)/n)/n #这样的公式看起来费劲,见下图

红圈里的计算了对角线格子的理论频数,所以Pe(理论一致性)就是理论上两方法评价一致之和占总数的比例 #对理论频数不清楚的童鞋参看流病书,灵敏度特异度那块

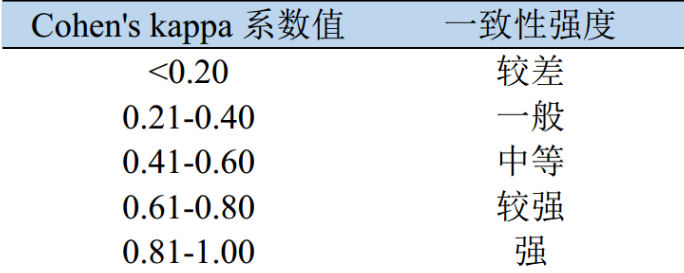

KAPPA评价标准:

加权KAPPA用于在多分类有序变量的情况,比如写这篇博文的动机来自,需要评价对同一个患者在前瞻和回顾两个scenarioes得到的同一量表的得分是否一致。量表得分为等级资料。

加权分为两种:线性加权(linear)、平方加权(quadratic)

理解:比如对于眼底图像识别的数据,class=0为健康,class=4为疾病晚期非常严重,所以对于把class=0预测成4的行为所造成的惩罚应该远远大于把class=0预测成class=1的行为,使用quadratic的话0->4所造成的惩罚就等于16倍的0->1的惩罚。

加权KAPPA评价标准:

参考:https://www.mediecogroup.com/method_article_detail/50/

https://www.mediecogroup.com/method_article_detail/37/