版权声明:署名,允许他人基于本文进行创作,且必须基于与原先许可协议相同的许可协议分发本文 (Creative Commons)

版权声明:署名,允许他人基于本文进行创作,且必须基于与原先许可协议相同的许可协议分发本文 (Creative Commons)

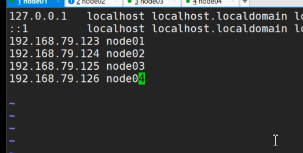

1、配置多个节点的网络映射

192.168.79.123 node01

192.168.79.124 node02

192.168.79.125 node03

192.168.79.126 node04

备注:写入自己的ip

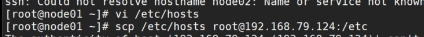

将某一个节点的文件发送到其他的节点上

scp /etc/hosts [email protected]:/etc

注意:创建了几个发送几次,每次把ip改对。

否则找不到。

2、多节点之间配置

(1)时间同步

①各个节点安装ntp命令yum install ntp

②上网查找最新的时间服务器ntp1.aliyun.com

③同步时间ntpdate ntp1.aliyun.com

(2)配置免密登录

node01->node01 node01->node02 node01->node03 node01->node04

①所有节点执行 ssh-keygen -t rsa -P ‘’ -f ~/.ssh/id_rsa (私钥)

②在node01节点执行,将node01的公钥加入到其他节点的白名单中 (公钥)

通过公钥建立连接

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node02

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node03

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node04

(3)修改hdfs-site.xml配置文件

(4)修改core-site.xml配置文件

(5)修改slaves配置文件

(4)(4)(5)不懂可参考伪分布式模式,有详细图片

https://blog.csdn.net/power_k/article/details/91572131

以及修改 *.env.sh文件内部多有的java路径改成绝对路径

(6)修改为node02 node03 node04

将配置好的安装包分发到其他节点上

scp -r jdk1.8.0_121 root@node03:/opt/software

scp -r hadoop-2.6.5 root@node03:/opt/software

如果你的安装包也是在同一个文件下,可一次行发送

scp -r /opt/software root@node03:/opt

(7)格式化NameNode

(创建目录以及文件)在node01节点执行

cd /opt/software/hadoop-2.6.5/bin

./hdfs namenode -format

注意点:如果第一次格式化。一定要 rm -rf /var/abc

两次格式化文件生效,容易造成冲突。

(9)启动HDFS start-dfs.sh

在sbin里启动

启动后网页查看 ip:50070

出现页面则成功

(10)操作HDFS文件系统

①创建目录 hdfs dfs -mkdir -p /user/root

②上传文件 hdfs dfs -D dfs.blocksize=1048576 -put