如何利用nginx实现负载均衡(总结)

一、总结

一句话总结:

推荐使用nginx七层(应用层)负载均衡的实现:配置那是相当的简单

1、nginx配置实例?

|||-begin

#这里的域名要和下面proxy_pass的一样 upstream fengzp.com { server 192.168.99.100:42000 weight=1; server 192.168.99.100:42001 weight=2; } server { listen 80; server_name 192.168.99.100; location / { proxy_pass http://fengzp.com; proxy_redirect default; } error_page 500 502 503 504 /50x.html; location = /50x.html { root html; } }

|||-end

主要是location中的proxy_pass http://fengzp.com; 和upstream fengzp.com 中配置的server

2、nginx负载均衡中加权重实例?

|||-begin

upstream fengzp.com { server 192.168.99.100:42000 weight=1; server 192.168.99.100:42001 weight=2; }

|||-end

server 192.168.99.100:42000 weight=1;

3、nginx配置负载均衡中:如果关了tomcat1,再多次刷新页面,接下来出现的就会都是tomcat2的页面,但是时而快时而慢。 原因及如何解决?

原因:转tomcat1时出现等待响应过程:这其中原因是当如果nginx将请求转发到tomcat2时,服务器会马上跳转成功,但是如果是转到tomcat1,因为tomcat1已经关闭了,所以会出现一段等待响应过程的过程,要等它失败后才会转到tomcat2。

解决:配置等待时间:等待时间 = proxy_connect_timeout + fail_timeout * max_fails:实例:server 192.168.99.100:42000 weight=1 fail_timeout=2s max_fails=2s;

4、nginx配置负载均衡中如何配置每个服务器具体的等待及响应时间?

proxy_connect_timeout:与服务器连接的超时时间,默认60s

fail_timeout:当该时间内服务器没响应,则认为服务器失效,默认10s

max_fails:允许连接失败次数,默认为1

5、nginx配置负载均衡中 配置每个服务器具体的等待及响应时间 实例?

等待时间 = proxy_connect_timeout + fail_timeout * max_fails

server 192.168.99.100:42000 weight=1 fail_timeout=2s max_fails=2s;

6、nginx常见的负载均衡策略有哪些?

1、轮询:这种是默认的策略,把每个请求按顺序逐一分配到不同的server,如果server挂掉,能自动剔除。

2、最少连接:把请求分配到连接数最少的server

3、权重:使用weight来指定server访问比率,weight默认是1。以下配置会是server2访问的比例是server1的两倍。

4、ip_hash:每个请求会按照访问ip的hash值分配,这样同一客户端连续的Web请求都会被分发到同一server进行处理,可以解决session的问题。如果server挂掉,能自动剔除。

7、nginx负载均衡策略中的ip_hash策略配置实例?

|||-begin

upstream fengzp.com { ip_hash; server 192.168.99.100:42000; server 192.168.99.100:42001; }

|||-end

就是在upstream里面加一个ip_hash;即可

二、利用nginx实现负载均衡

转自或参考:利用nginx实现负载均衡

https://www.cnblogs.com/andyfengzp/p/6434125.html">利用nginx实现负载均衡

1、安装nginx和tomcat

我这里是使用docker安装的。安装流程可参照

1、安装nginx和tomcat

我这里是使用docker安装的。安装流程可参照 dockerfile

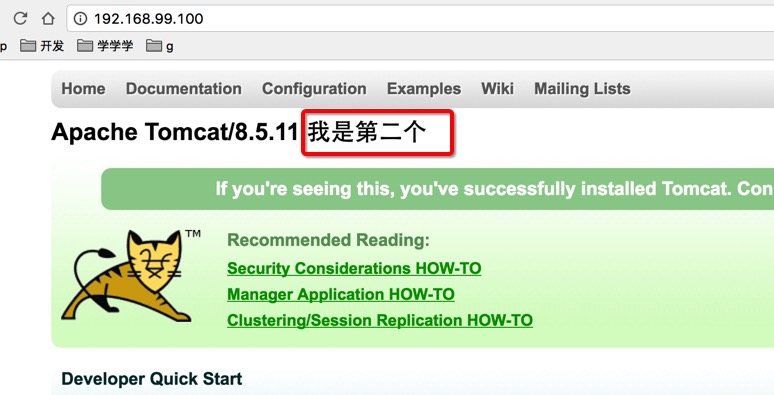

这里安装了两个tomcat,端口分别是42000和42001。第二个tomcat的首页随便加了些代码区分

2、nginx配置

#这里的域名要和下面proxy_pass的一样

upstream fengzp.com {

server 192.168.99.100:42000 weight=1;

server 192.168.99.100:42001 weight=2;

}

server {

listen 80;

server_name 192.168.99.100;

location / {

proxy_pass http://fengzp.com;

proxy_redirect default;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}3、测试

刷新页面发现页面会发生变化,证明负载配置成功。因为我配的权重第二个是第一个的两倍,所以第二个出现的概率会是第一个的两倍。

4、后续问题

如果关了tomcat1,再多次刷新页面,接下来出现的就会都是tomcat2的页面,但是时而快时而慢。这其中原因是当如果nginx将请求转发到tomcat2时,服务器会马上跳转成功,但是如果是转到tomcat1,因为tomcat1已经关闭了,所以会出现一段等待响应过程的过程,要等它失败后才会转到tomcat2。

而这个等待响应的时间我们是可以配置的。

这个时间由以下3个参数控制:

proxy_connect_timeout:与服务器连接的超时时间,默认60s

fail_timeout:当该时间内服务器没响应,则认为服务器失效,默认10s

max_fails:允许连接失败次数,默认为1

等待时间 = proxy_connect_timeout + fail_timeout * max_fails

如果我这样配置的话,只需等待6秒就可以了。

5、负载均衡策略

1、轮询

这种是默认的策略,把每个请求按顺序逐一分配到不同的server,如果server挂掉,能自动剔除。

upstream fengzp.com {

server 192.168.99.100:42000;

server 192.168.99.100:42001;

}2、最少连接

把请求分配到连接数最少的server

upstream fengzp.com {

least_conn;

server 192.168.99.100:42000;

server 192.168.99.100:42001;

}3、权重

使用weight来指定server访问比率,weight默认是1。以下配置会是server2访问的比例是server1的两倍。

upstream fengzp.com {

server 192.168.99.100:42000 weight=1;

server 192.168.99.100:42001 weight=2;

}4、ip_hash

每个请求会按照访问ip的hash值分配,这样同一客户端连续的Web请求都会被分发到同一server进行处理,可以解决session的问题。如果server挂掉,能自动剔除。

upstream fengzp.com {

ip_hash;

server 192.168.99.100:42000;

server 192.168.99.100:42001;

}ip_hash可以和weight结合使用。

转载于:https://www.cnblogs.com/Renyi-Fan/p/11054746.html