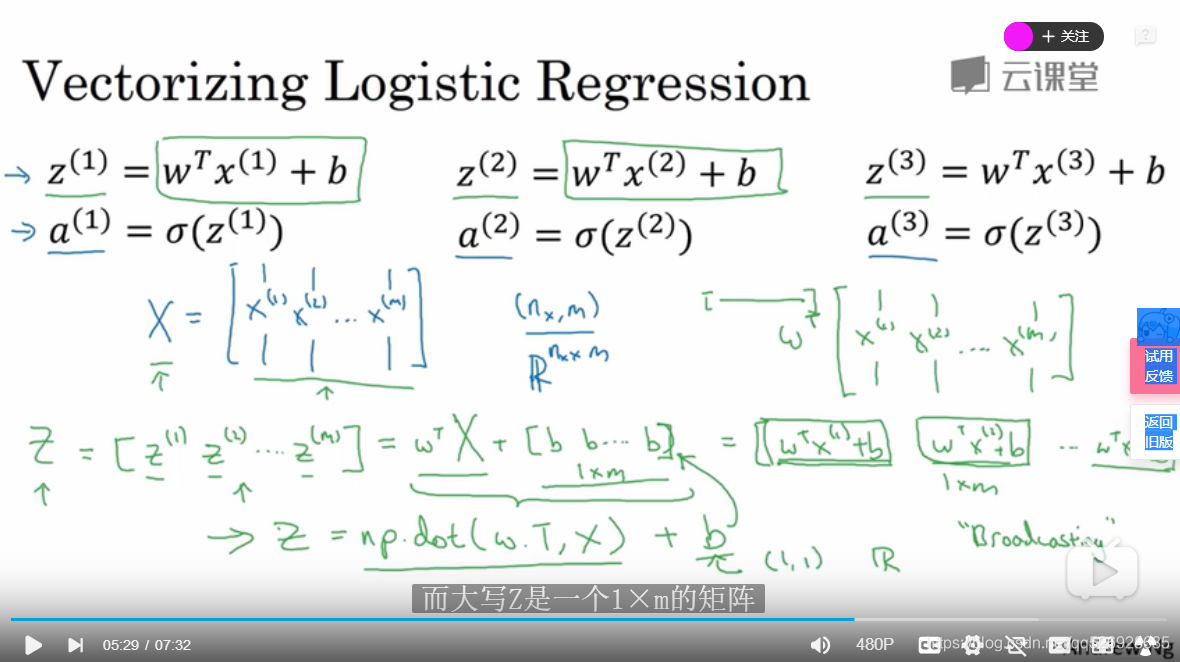

p19.logictics回归的向量化

numpy命令:np.dot(w.T,X)+b;向量乘积

np.abs(x),np.log(x)

python自动扩展:当w,x为n维向量时,b会自动扩展为n维向量

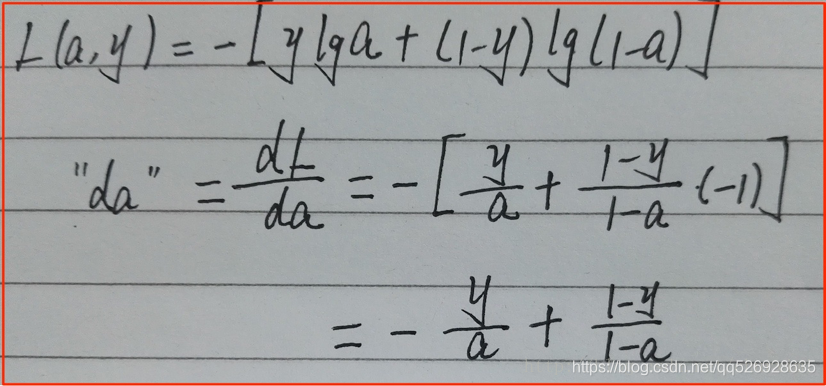

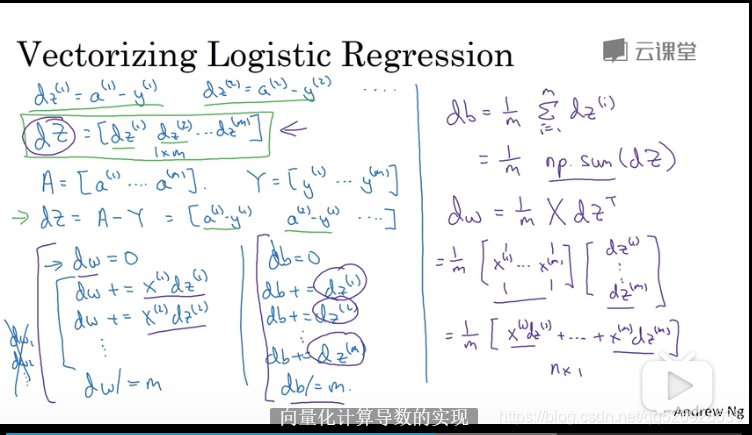

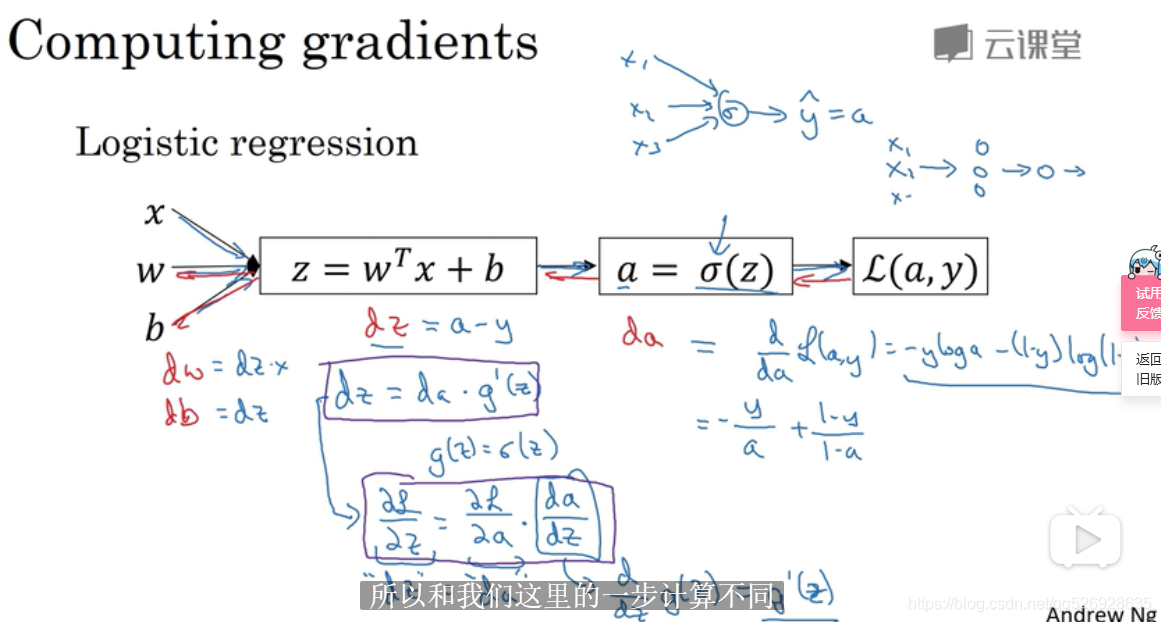

p20向量化logistics回归的梯度下降

dz=a-y,

da=

dw1=x1dz; dw2=x2dz; dw=xdz; db=dz

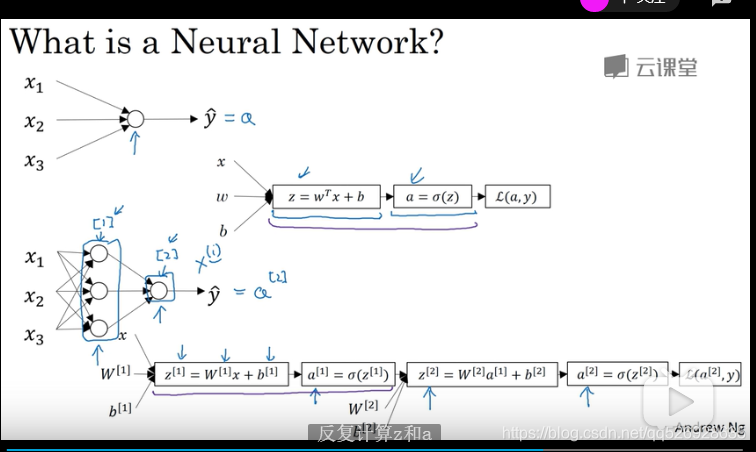

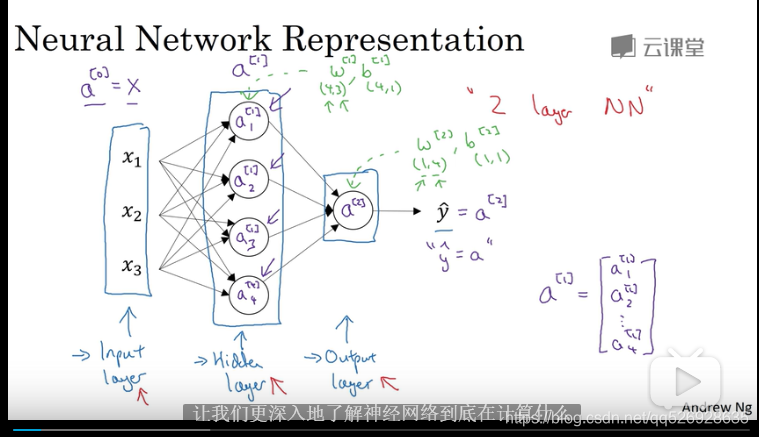

p25神经网络

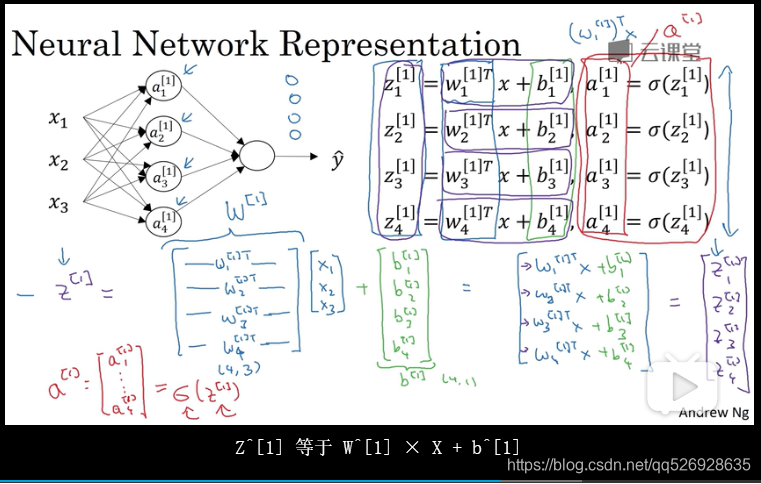

p26神经网络表示

w为43矩阵,b为4*1向量

一般称为双层神经网络

隐藏层:训练集中看不到数值

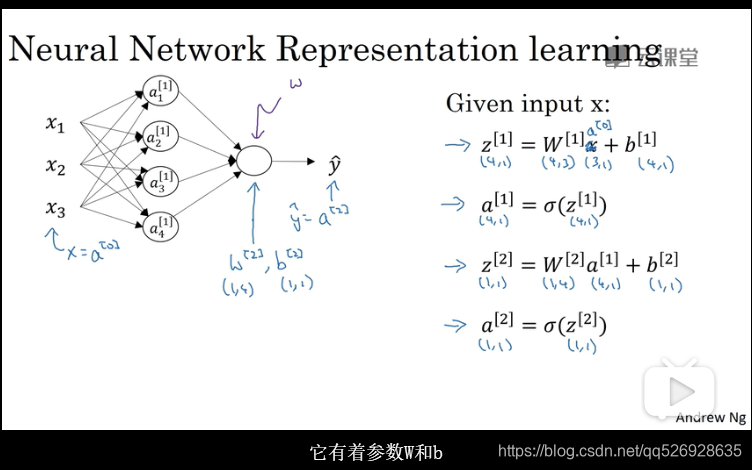

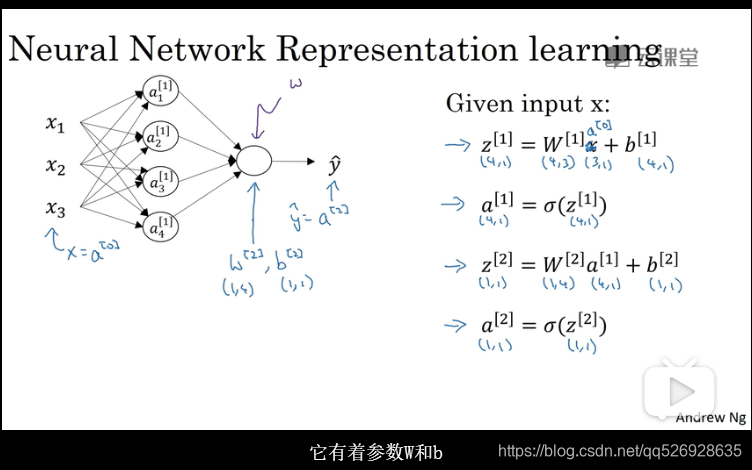

**p27计算机神经网络的输出 **

W2 ,b[1],a[1]

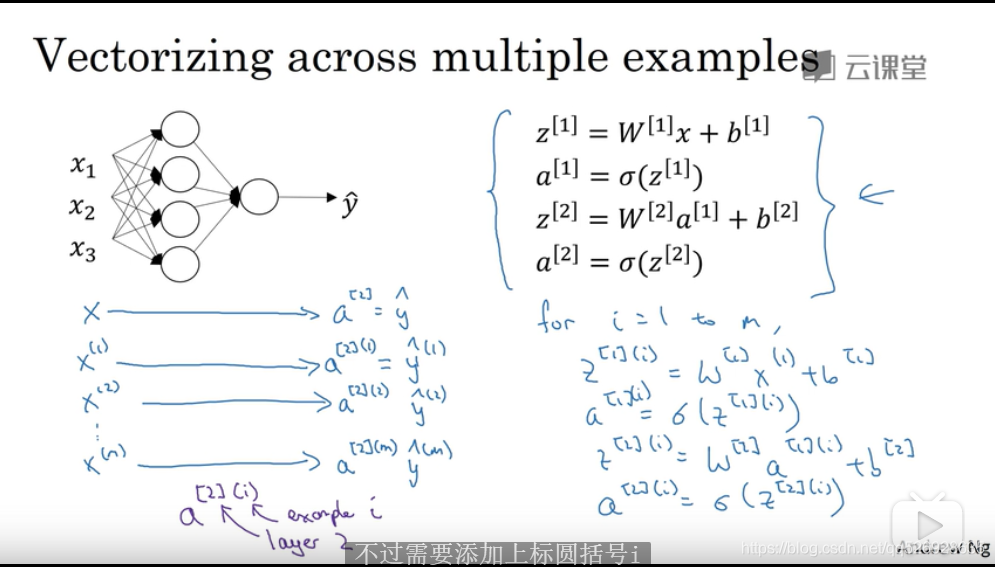

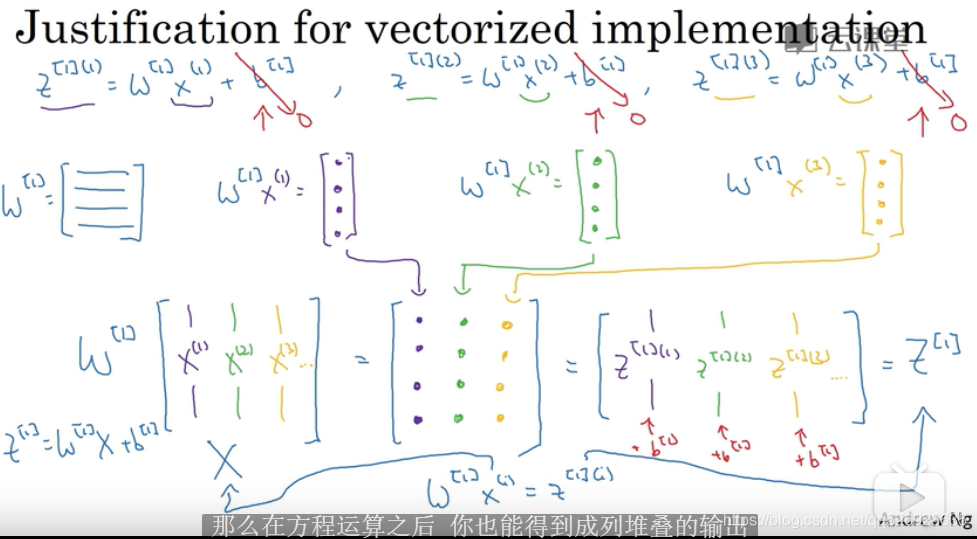

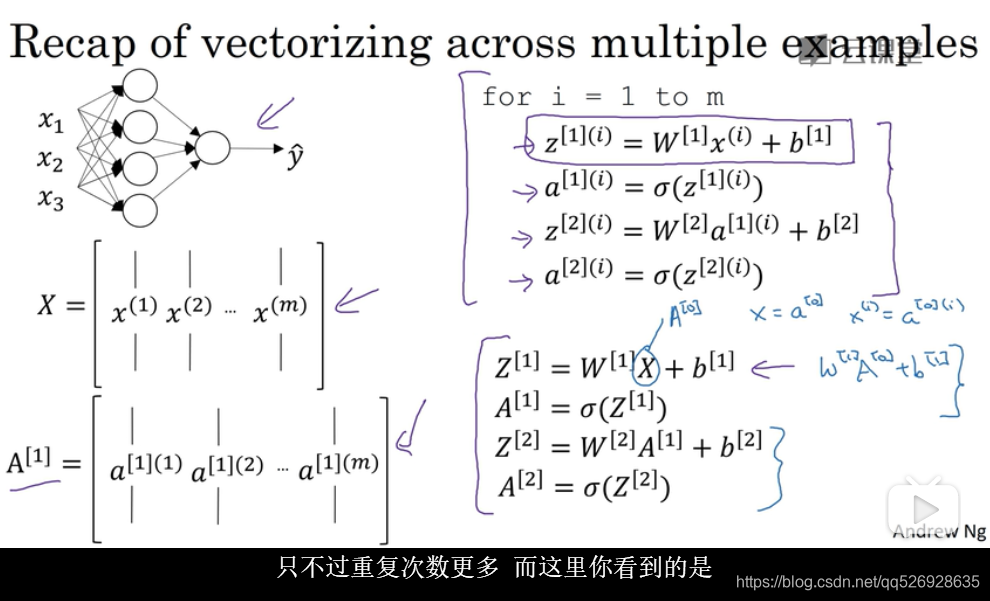

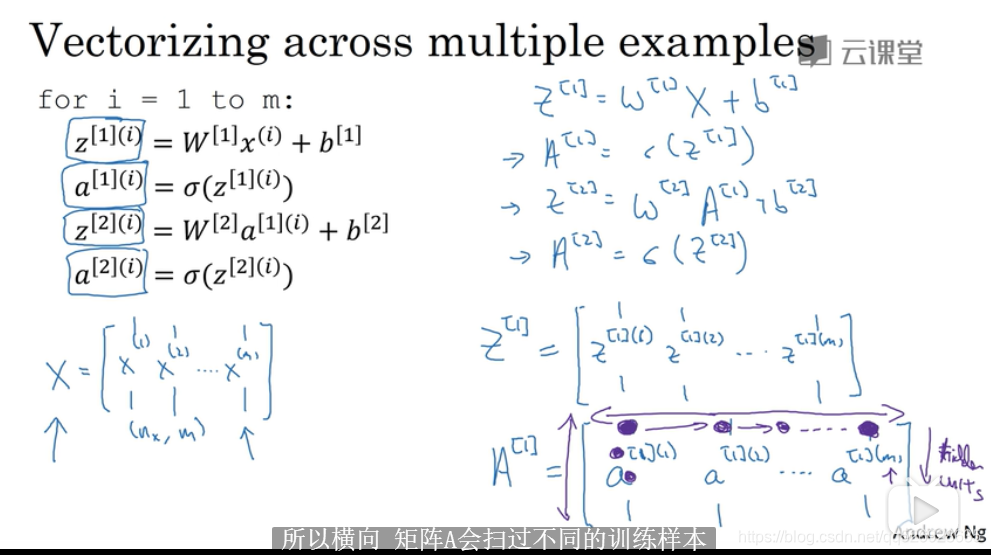

p28多个例子的向量化

a[2](i), 2代表第二层,i代表第i个样本

X横向对应不同样本,坚向对应输入特征

p29向量化的解释

激活函数

tanh函数比sigmiod函数更好 :值介于-1到1之间(不适用于输出层),sigmiod适用于二元分类

a=tanh(z)=e^z-e!-z/e!z+e!-z

ReLU修正线性函数

a=max(0,z) ,z为正时,导数为1,z为负时,导数为0

leaky ReLU函数

线性隐层一点用都没用

回归问题可以使用线性函数

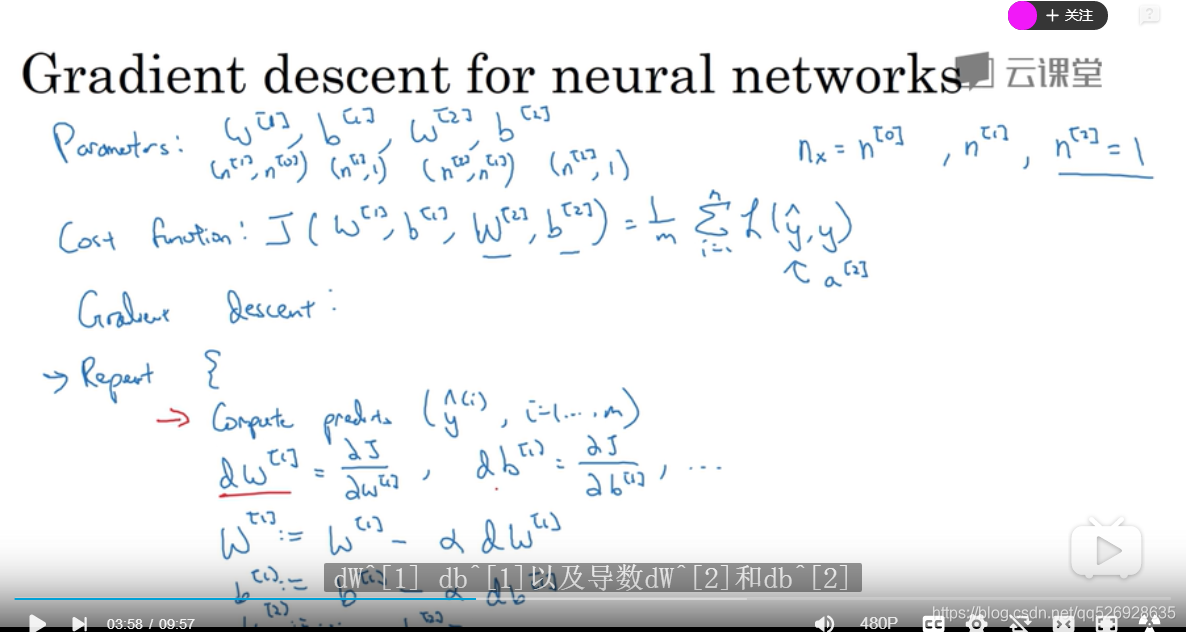

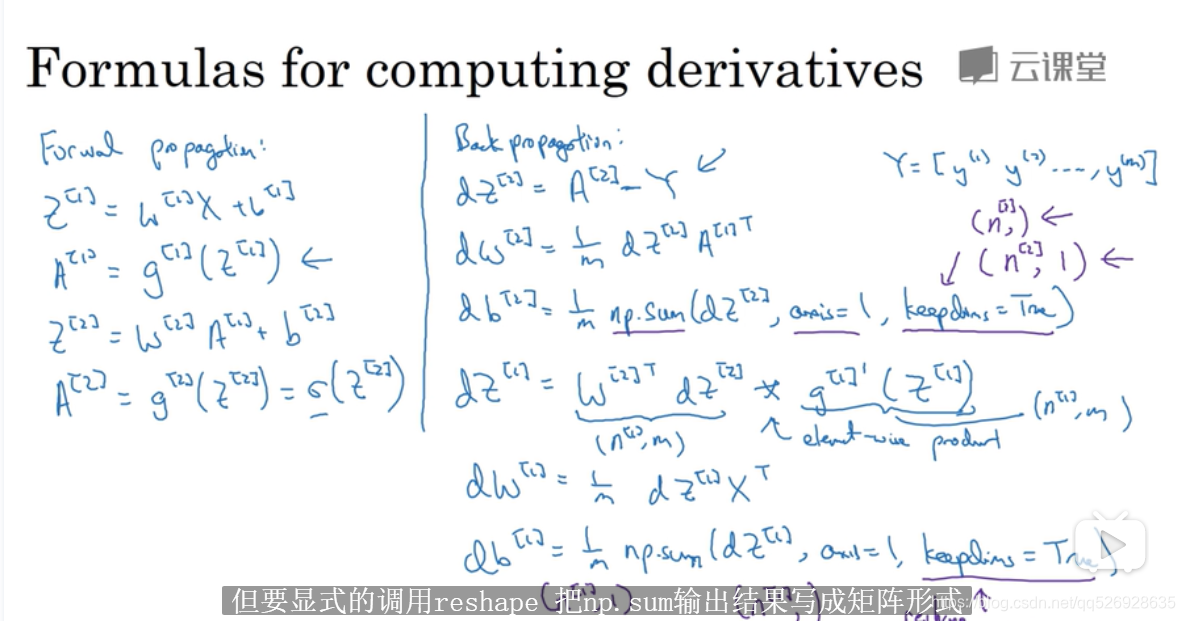

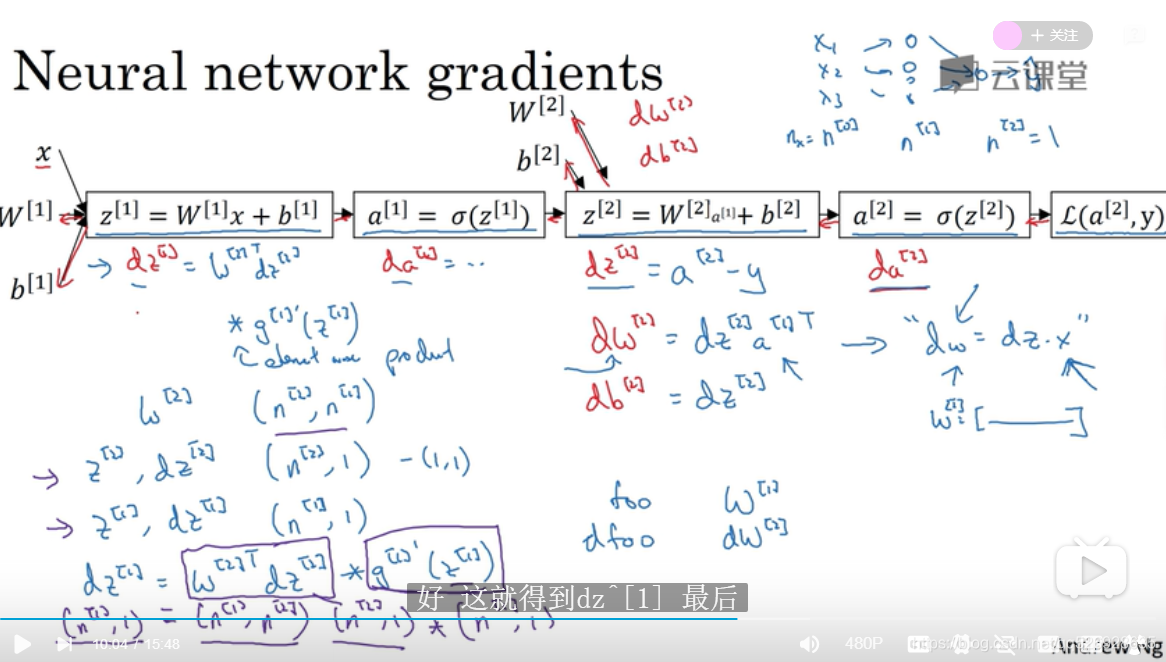

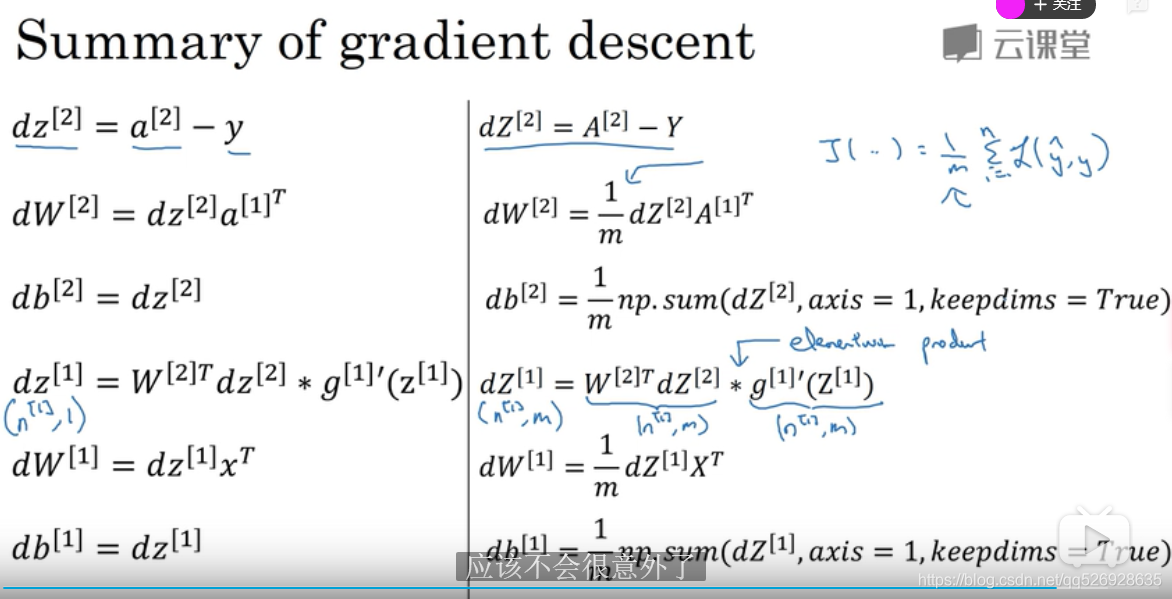

p33神经网络的梯度下降

axis=1 计算的维度为1

keepdism=true 防止输出为秩1的数组

reshape 显式调用输出矩阵形式

反向传播理解

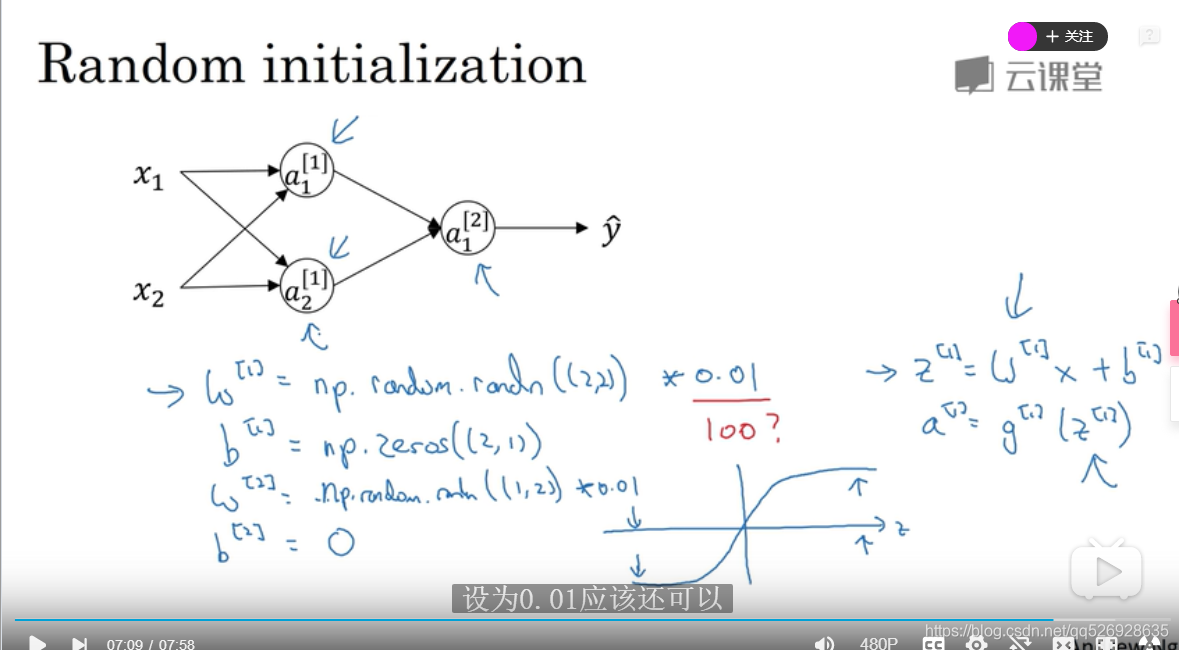

随机初始化

W权重不能全部初始化为为,可证明各dw也会相等,没意义

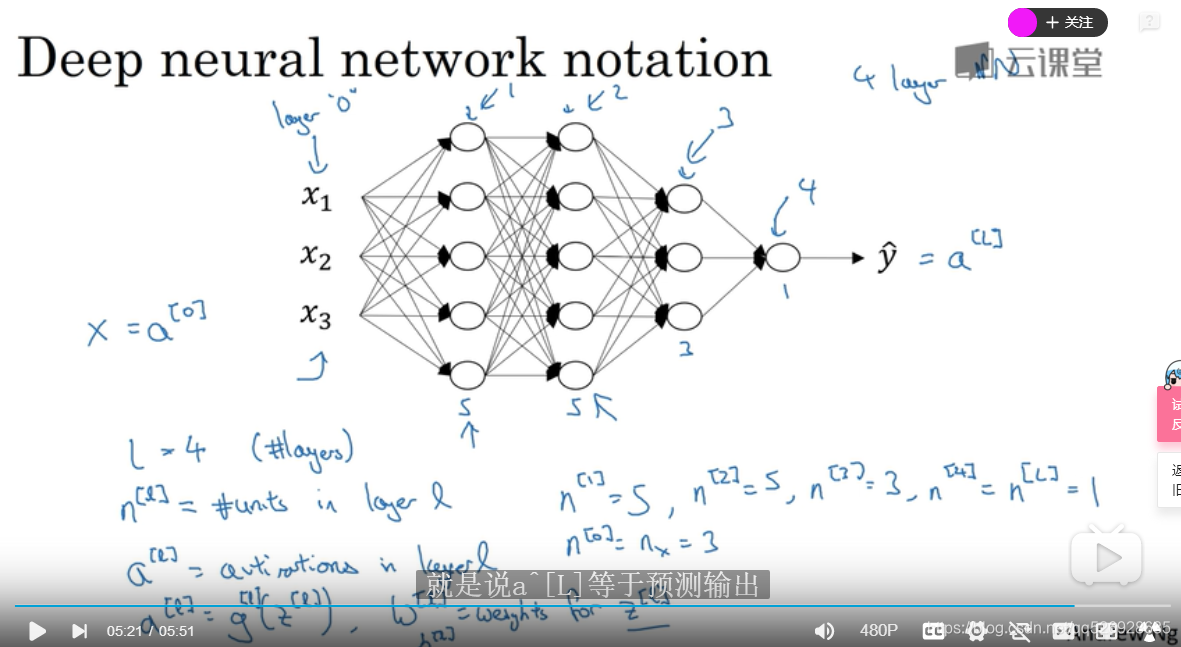

深层神经网络

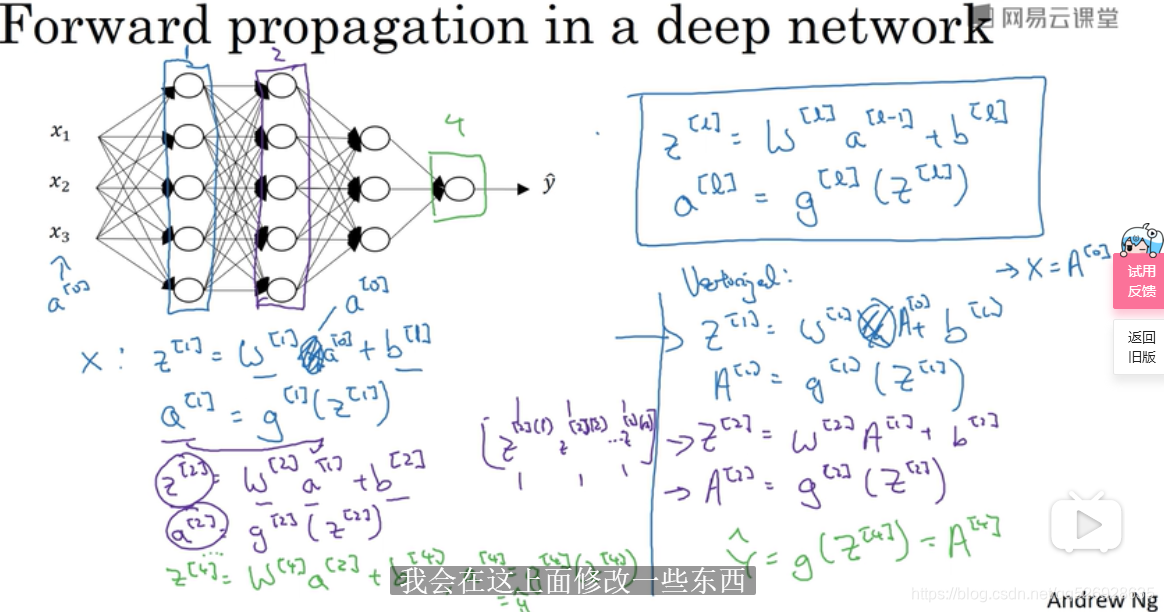

深层神经网络的前向传播

向量版 的前身向传播

层数最好用for

核对维数