1、SqueezeNet创新点

提出Fire Module网络架构来压缩模型,包括一下3点:

(1)1*1卷积核代替3*3卷积核,参数可减小到原来1/9

(2)S1*1 < E1*1 + E3*3,Fire Module网络的开始采用1*1卷积核降维,减少输入通道数

(3)为了给卷积层提供更多的信息,池化层放在相对靠后的地方,这样可以提高准确率

2、SqueezeNet伪代码

(1):获取需要识别图像ROI区域

(2):图像ROI区域缩放成256*256

(3):将256*256裁剪成227*227

(4):将227*227的bgr图像拆分成bgr三通道,同时减去bgr均值进行归一化

(5):SqueezeNet

(6)Softmax取最大值作为预测类别

3、SqueezeNet代码实现注意点

(1)Fire Module的Expand层把1*1卷积核和3*3卷积核升维后的feature map进行concat,为了保证1*1卷积核和3*3卷积核输出结果有相同的尺寸,3*3卷积时需要将输入图像加一个像素边界

4、SqueezeNet疑惑(有懂的大牛留言区解释下,谢谢~)

(1)输入模型的图像先缩放再裁剪,为什么不一步到位缩放成227*227?

(2)图像输入模型前bgr三通道像素分别减去mean进行归一化,mean值的由来?

(3)原论文fire4和fire8后采用maxpooling,实践代码是fire3和fire5后maxpooling,进一步提升模型的运算性能,准确率会稍微降低

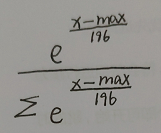

(4) Softmax函数这样做的好处和196的由来?

Softmax函数这样做的好处和196的由来?