一、前言

LeNet-5出自论文Gradient-Based Learning Applied to Document Recognition,是一个用来识别手写数字的最经典的卷积神经网络,是Yann LeCun在1998年设计并提出的。

个人主页:http://yann.lecun.com/

论文链接:https://pan.baidu.com/s/1nEQFgsonFVm790MhJA8kDw 提取码: 27cq

二、LeNet模型结构

输入层: 32×32 大小的图像,卷积核为5×5,步长为1,所以32-5+1=28,C1层卷积特征图的大小为28×28,共有6个

C1层: 输入层到C1层的连接数为C1层的网格个数(6×28×28)乘以每个网格对应连接数(5×5+1),即6×28×28×(5×5+1)=122304。

参数个数为6 ×(5×5+1)=156,后面那个1是bias

S2层: 池化层又称下采样层,卷积核大小为2×2,步长为2,这里是平均池化,所以参数为权值加上bias为2,2×6=12个参数。连接数为(2×2+1)×(6×14×14)=5880个连接。

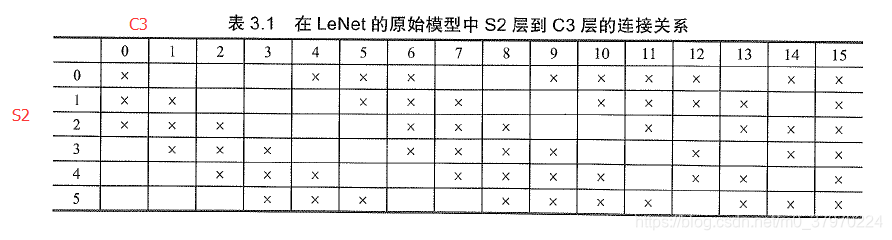

C3层: S2到C3这就是难点了!

S2到C3并不对称,那么它是怎么对应的呢?如下表:

S4层: S4与S2同理,故参数为2×16=32个,连接数为5×16×5×5=2000个

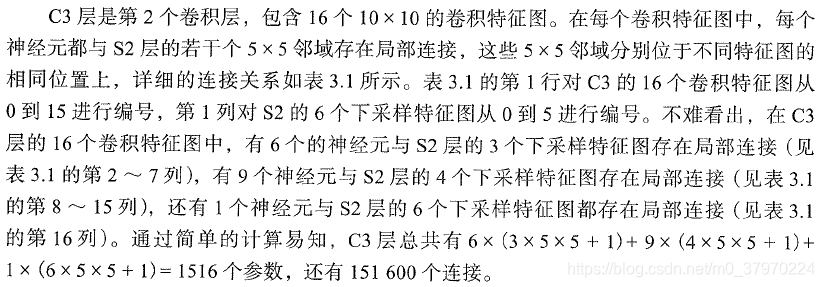

C5:

输入:S4层的全部16个单元特征map(与s4全相连)

卷积核大小:5*5

卷积核种类:120

输出featureMap大小:1×1(5-5+1)

可训练参数/连接:120×(16×5×5+1)=48120

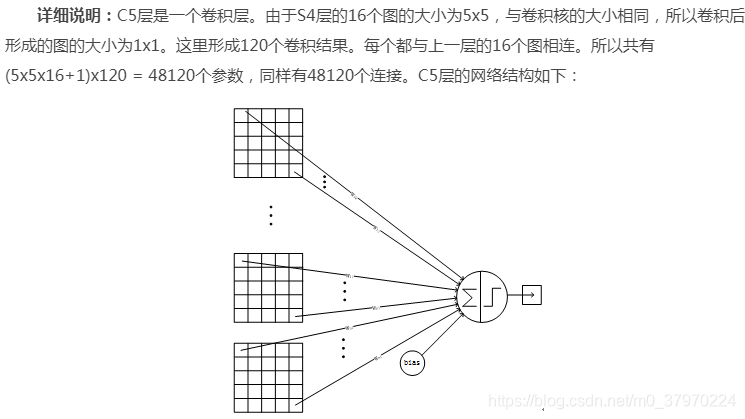

F6:

输入:c5 120维向量

计算方式:计算输入向量和权重向量之间的点积,再加上一个偏置,结果通过sigmoid函数输出。

可训练参数:84*(120+1)=10164

详细说明:6层是全连接层。F6层有84个节点,对应于一个7x12的比特图,-1表示白色,1表示黑色,这样每个符号的比特图的黑白色就对应于一个编码。该层的训练参数和连接数是(120 + 1)x 84=10164。ASCII编码图如下:

输出层:

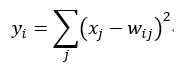

Output层也是全连接层,共有10个节点,分别代表数字0到9,且如果节点i的值为0,则网络识别的结果是数字i。采用的是径向基函数(RBF)的网络连接方式。假设x是上一层的输入,y是RBF的输出,则RBF输出的计算方式是:

上式w_ij 的值由i的比特图编码确定,i从0到9,j取值从0到7*12-1。RBF输出的值越接近于0,则越接近于i,即越接近于i的ASCII编码图,表示当前网络输入的识别结果是字符i。该层有84x10=840个参数和连接。

参考:

https://cuijiahua.com/blog/2018/01/dl_3.html

《深度学习:卷积神经网络从入门到精通》这本书很不错~