1 Stream流

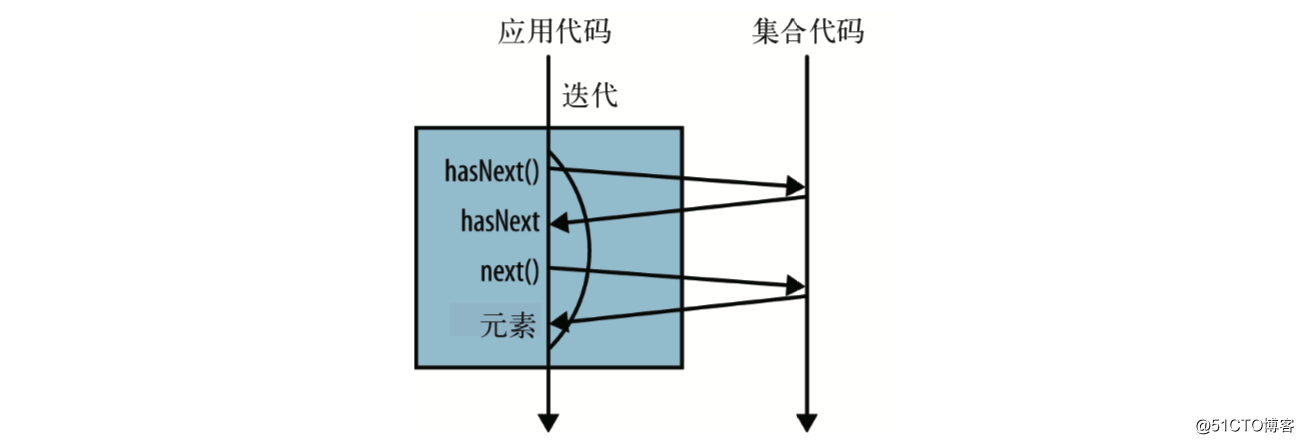

对集合进行迭代时,可调用其iterator方法,返回一个iterator对象,之后便可以通过该iterator对象遍历集合中的元素,这被称为外部迭代(for循环本身正是封装了其的语法糖),其示意图如下:

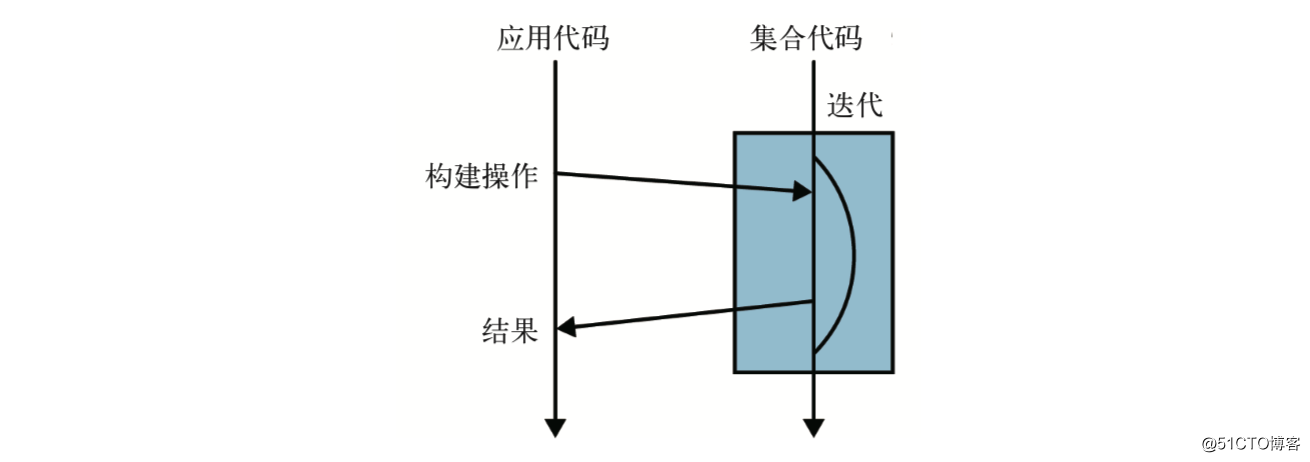

除此之外,还有内部迭代方法,这正是这里要说明的集合的stream()方法返回的Stream对象的一系列操作,比如,要统计一个数字列表的偶数元素个数,当使用Stream对象的操作时,如下:

List<Integer> list = new ArrayList<Integer>(){{

add(1);

add(2);

add(3);

}};

long count = list.stream().filter(num -> num % 2 == 0).count();

System.out.println(count); // 1其示意图如下:

上面提供的例子,比如filter,其参数为一个lambda表达式,所以Stream其实是用函数式编程方式在集合类上进行复杂操作的工具。

2 Stream流操作与Spark RDD算子

其实有Spark经验的人开始使用Stream流操作时,会有似曾相识的感觉,好像一切都那么熟悉。

参考Spark RDD算子介绍的文章:《Spark RDD算子实战》https://blog.51cto.com/xpleaf/2108481

下面从操作对象(名词)和对象操作(动词)两个角度来简单对比一下。

2.1 操作对象

Spark RDD算子的操作对象是RDD,中文意思是弹性分布式数据集,对用户而言,它就是类似集合一样的对象,里面存的是数据,只是底层它的数据可能分布于各个节点的各个partition,但不管怎样,其本质还是数据集。

Stream流操作的操作对象是集合,集合本质也是一种数据集,只是相比RDD,它是单机的。

2.2 对象操作

Spark RDD算子有两种类型,分别是Transformation算子和Action算子,前者是延迟计算的,它仅仅记住了数据的逻辑操作,并没有真正执行,后者是真正触发Transformation算子的计算。

Stream流操作也有两种类型,分别是惰性求值和及早求值(个人觉得这翻译不好),前者也只是记录了惰性求值的逻辑操作,后者才是真正触发操作。

可以看到其两者是非常相似的,一个是对分布式数据进行的各种操作,一个是单机数据进行的各种操作,把计算分为延迟计算和触发计算两种,好处是显而易见的:当对数据集进行多次逻辑操作时,有可能迭代只需要一次就可能完成,这样真正触发计算时,一次迭代带来的性能提升是显著的,比如对于过滤和计算这两个操作(前面计算偶数的操作),在一次迭代中就能够完成。

当然,不仅类型相似,其本身提供的操作的名称而言,都是相似的,有些东西真的是通用的。

3 常用Stream流操作

每个操作都用一个通俗易懂的例子来进行说明。

3.1 及早求值操作

3.1.1 collect(toList())

其作用是将Stream流中的元素收集起来,形成List、Set或Map等。

List<Integer> list = Stream.of(1, 2, 3).collect(Collectors.toList());

System.out.println(list); // [1, 2, 3]1.Stream.of()方法用于方便地生成Stream流;

2.Collectors还有toSet()、toMap()等方法,详见其API。

3.1.2 forEach(Consumer)

对集合中的每个元素进行操作,其参数是Consumer<T>函数接口。

Consumer<Integer> printNum = System.out::print;

Stream.of(1, 2, 3).forEach(printNum); // 123System.out::print表示使用System.out类中的print方法,相当于lambda表达式:element -> System.out.print(element);

上面的例子也可以一步到位:

Stream.of(1, 2, 3).forEach(System.out::print); // 1233.1.3 max和min

其参数为Comparator对象,返回一个Optional对象,Optional说明其结果可能有,也可能没有(比如对空值的Stream流操作时)。

// 计算数值流中的最大值

Optional<Integer> maxOptional = Stream.of(1, 2, 3).max(Comparator.comparing(num -> num));

System.out.println(maxOptional.get()); // 3

// 找出字符串流中长度最小的字符串

Optional<String> minOptional = Stream.of("a", "ab", "abc").min(Comparator.comparing(String::length));

System.out.println(minOptional.get()); // a另外,其确实是及早求值操作,可以验证一下:

Stream.of(1, 2, 3).max(Comparator.comparing(num -> {

System.out.println(num);

return num;

}));输出:

1

2

2

33.2 惰性求值操作

3.2.1 map

其参数为Function<T,R>,用于将Stream流中的值转换为另外一种流。

// 将字母转换为大写

Stream.of("a", "b", "hello")

.map(String::toUpperCase)

.forEach(element -> System.out.print(element + " ")); // A B HELLO 3.2.2 filter

其参数为Predicate<T>,过滤Stream流中的元素。

// 找出偶数

List<Integer> list = Stream.of(1, 2, 3).filter(num -> num % 2 == 0).collect(Collectors.toList());

System.out.println(list); // [2]3.2.3 flatMap

其参数为Function<T,R>,只是此时R限定为Stream,将Stream流中的值转换为更多的流。

// 找出字符串中的单词

List<String> list = Stream.of("hello you", "hello me")

.flatMap(line -> Arrays.stream(line.split(" "))).collect(Collectors.toList());

System.out.println(list); // [hello, you, hello, me]是不是感觉跟Spark的wordcount例子有点像。

3.2.4 reduce

其参数为BinaryOperator<T>,返回一个Optional对象,Optional说明其结果可能有,也可能没有(比如对空值的Stream流操作时,并且没有指定初始值),用于归约操作。

// 求和

Integer res = Stream.of(1, 2, 3).reduce((acc, element) -> acc + element).get();

// 指定初始值6后,Stream的reduce操作结果肯定有值的,因此其返回的不是Optional,而直接是6所属的类型,即Integer

Integer res2 = Stream.of(1, 2, 3).reduce(6, (acc, element) -> acc + element);

System.out.println(String.format("res: %s, res2: %s", res, res2)); // res: 6, res2: 124 参考

《Java 8 Lambdas,Richard Warburton著(O’Reilly,2014)》