首先学习Spark,必须对Spark深入了解

Spark 主要有三个特点:首先,高级 API 剥离了对集群本身的关注,Spark 应用开发者可以专注于应用所要做的计算本身。其次,Spark 很快,支持交互式计算和复杂算法。最后,Spark 是一个通用引擎,可用它来完成各种各样的运算,包括 SQL 查询、文本处理、机器学习等,而在 Spark 出现之前,我们一般需要学习各种各样的引擎来分别处理这些需求。

Spark学习步骤:

1)首先,搭环境一定是必须的啦,答主当时搭环境,前前后后就折腾了一个星期的linux,linux搞不懂,各种奇怪的命令,让人学的头皮发麻,还有权限的各种各样的问题,跟着网上的教程来做还会出错更是伤心。但是经历这个初始的环境折腾之后,你最基础的linux命令至少会了,环境搭建过程中的各种配置文件坑爹问题,经历你的各种搜索之后,你也可以大概知道各种配置文件的作用,这有助于你后面程序出错的时候查找错误。

2)环境搭建好之后,因为项目的关系,你开始要编程了,但是Spark啥也不懂怎么办啊。没关系,先搭好开发环境。搭好后得看你的项目需求了。根据你的项目需求来思考学习方向。

3)你的项目需求大概是,从mongoDB读取数据,进行计算之后回到mongoDB里去,进行下一步操作。

4)搜索Spark如何连接mongoDB,根据当时的情况,使用某度搜索,关键词 Spark和mongoDB是很少用的东西,所以,需要学会科学上网,寻找新的学习资料进行补缺漏洞。

- 连接好了之后,不懂 Scala怎么办,首先,Spark基本是RDD之间的转化操作,就是简单的map,split东西而已,剩下的只要大概懂最基本的语法就可以了(默认题主懂C语言),暂时不需要scala高级功能。

当你项目出现了新问题,要求将计算好的数据同时送到MySQL啊,很是烦恼呦!但程序还是要好好做的。

学会Spark不难,但学好它就需要花点精力。当遇到困难时,要积极与老师和同学互相讨论学习,互相学习每个人的有效建议,多参加项目实战演练,吸取经验,从而更好的提到自己。

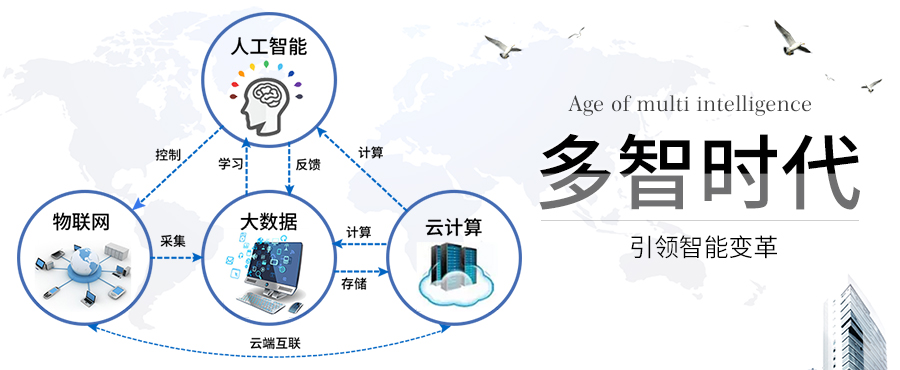

人工智能、大数据、云计算和物联网的未来发展值得重视,均为前沿产业,多智时代专注于人工智能和大数据的入门和科谱,在此为你推荐几篇优质好文:

Spark 和 Hadoop之间,主要有什么联系

http://www.duozhishidai.com/article-9781-1.html

什么是Spark,与Hadoop相比,主要有什么不同?

http://www.duozhishidai.com/article-9778-1.html

什么是Spark,怎么才能成为云计算大数据Spark高手?

http://www.duozhishidai.com/article-916-1.html

[多智时代- 人工智能和 大数据学习入门网站|人工智能、大数据、 物联网、 云计算的学习交流网站](http://www.duozhishidai.com)