目录

决策树理论:

1.信息论基础

(1)信息熵

原本是物理学的定义,后来香农将其引用到信息论领域,用于表示信息量的大小。信息量越大,对应的熵值越大。怎么样才能是信息量比较大呢?越是不确定的事件,包含的信息量也就越大,确定发生的,没什么悬念,包含的信息量就很少了。

(2)联合熵

一维随机变量分布推广到多维随机变量分布。

(3)条件熵

H(Y|X) 表示在已知随机变量 X 的条件下随机变量 Y 的不确定性。条件熵 H(Y|X) 定义为 X 给定条件下 Y 的条件概率分布的熵对 X 的数学期望。

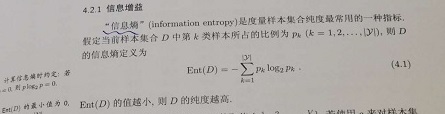

(4)信息增益

(5)基尼指数/基尼不纯度

2:决策树的不同分类算法

(1)ID3算法

采用信息增益划分数据。计算使用所有特征划分数据集,得到多个特征划分数据集的信息增益,从这些信息增益中选择最大的,因而当前结点的划分特征便是使信息增益最大的划分所使用的特征。

不足:信息增益偏向取值较多的特征。

(2)C4.5

采用信息增益比划分数据,弥补ID3的不足

不足:只能进行分类

(3)CART分类树

采用基尼系数划分数据,可针对离散和连续型,可以做分类和回归。

3.回归树的原理

4.决策树防止过拟合的手段

剪枝处理

预剪枝:是在决策树的生成过程中,对每个结点在划分前先进行估计,若当前结点的划分不能带来决策树泛化性能提升,则停止划分即结束树的构建并将当前节点标记为叶结点。

后剪枝:是先从训练集生成一棵完整的决策树,然后自底向上地对叶结点进行考察,若将该结点对应的子树替换为叶结点能带来决策树泛化为性能提升,则将该子树替换为叶结点。泛化性能的提升可以使用交叉验证数据来检查修剪的效果,通过使用交叉验证数据,测试扩展节点是否会带来改进。如果显示会带来改进,那么我们可以继续扩展该节点。但是,如果精度降低,则不应该扩展,节点应该转换为叶节点。