一、Python的第三方库Requests

1、Requests是python公认的第三方优秀的网络爬虫库,通过这个库可以自动爬取HTML页面,自动进行网络内容请求的提交。

2、Requests库的七个主要方法:

3、requests库最常用的方法get方法

requests.get(url,params=None,**kwargs)

url:拟获取页面的url链接

params:url中额外参数,字典或字节流格式,可选

**kwargs:12个控制访问的参数。

如:使用requests用get方法向百度发出一个请求

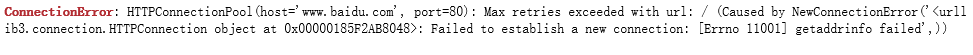

如果断开网络,则会出现下面的错误信息。

二、请求头

1、http请求头,HTTP客户程序(例如浏览器),向服务器发送请求的时候必须指明请求类型(一般是GET或者POST)。如有必要,客户程序还可以选择发送其他的请求头。

2、类型:

Accept:客户机通过这个头,告诉服务器,它支持哪些数据类型

Accept-Charset::客户机通过这个头,告诉服务器,它支持的编码

Accept-Encoding: 客户机通过这个头,告诉服务器,支持哪种数据压缩格式

Accept-Language: 客户机采用的是哪个语言

Host:客户机通过这个头,告诉服务器,想访问服务器哪台主机

If-Modified-Since:客户机通过这个头,告诉服务器,数据缓存的时间

Referer:客户机通过这个头,告诉服务器,客户机是从哪个页面来的(防盗链)

User-Agent: 说明客户机操作系统信息,以及浏览器信息

Cookie:客户机通过这个头,可以带点数据给服务器

Connection:表示是否需要 持久连接。