Hadoop Streaming给许多语言(java,scala,python,C等)提供了使用Hadoop和编写Mapreduce的接口。在实际工作中,我选择python来做大数据处理,在编写mapreduce作业时,经常遇到map和reduce的个数怎么设置,因为它们的个数决定着程序运行的效率和一些其它方面的因素(例如对于一个大的数据集,如果使用一个map来处理,很容易造成该节点的内存等不足)。所以如何设置这两个参数,也非常重要。

本博文

- 首先介绍一下需要设置map和reduce个数的应用场景

- 接着对如何计算map个数给出两个解释(个人认为解释一是有用的)

- 最后给出一个使用Hadoop Streaming 提交python编写的mapreduce作业的事例(应用的解释一)

1. 应用场景

遇到下面的问题时,要考虑设置map个数

- 输入文件size巨大,但不是小文件

这种情况可以通过增大每个mapper的input size,即增大minSize或者增大blockSize来减少所需的mapper的数量。增大blockSize通常不可行,因为当HDFS被hadoop namenode -format之后,blockSize就已经确定了(由格式化时dfs.block.size决定),如果要更改blockSize,需要重新格式化HDFS,这样当然会丢失已有的数据。所以通常情况下只能通过增大minSize,即增大mapred.min.split.size的值 - 输入文件数量巨大,且都是小文件

如果全部文件大小除以blocksize(一般hadoop默认为64M或者128M),比较小,那么map的个数也会很少,这样程序运行就慢,无法发挥大集群的优势。

两个解释

解释一:下面详细来解释一下,map具体的个数是怎么计算出来的。

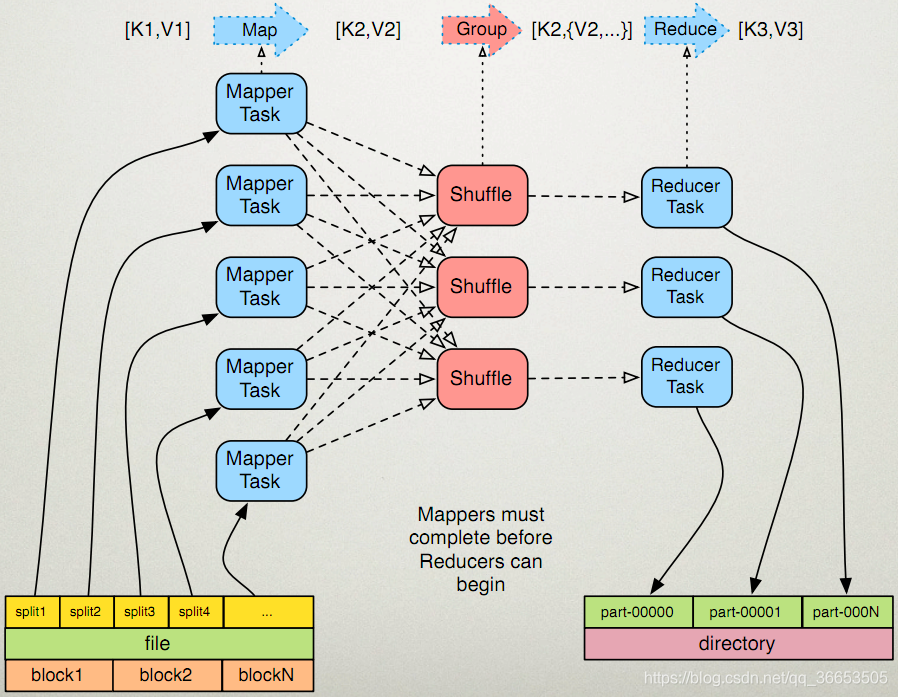

先看一下这个图

输入分片(Input Split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身,而是一个分片长度和一个记录数据的位置的数组。

Hadoop 2.x默认的block大小是128MB,Hadoop 1.x默认的block大小是64MB,可以在hdfs-site.xml中设置dfs.block.size,注意单位是byte。

分片大小范围可以在mapred-site.xml中设置,mapred.min.split.size mapred.max.split.size,minSplitSize大小默认为1B,maxSplitSize大小默认为Long.MAX_VALUE = 9223372036854775807

那么分片到底是多大呢?可以通过下面的公式计算

minSize=max{minSplitSize,mapred.min.split.size}

maxSize=mapred.max.split.size

splitSize=max{minSize,min{maxSize,blockSize}}

我们再来看一下源码

所以在我们没有设置分片的范围的时候,分片大小是由block块大小决定的,和它的大小一样。比如把一个258MB的文件上传到HDFS上,假设block块大小是128MB,那么它就会被分成三个block块,与之对应产生三个split,所以最终会产生三个map task。我又发现了另一个问题,第三个block块里存的文件大小只有2MB,而它的block块大小是128MB,那它实际占用Linux file system的多大空间?

答案是实际的文件大小,而非一个块的大小。

有大神已经验证这个答案了:http://blog.csdn.net/samhacker/article/details/23089157

解释二:我还查到这样一段话

一个split的大小是由goalSize, minSize, blockSize这三个值决定的。computeSplitSize的逻辑是,先从goalSize和blockSize两个值中选出最小的那个(比如一般不设置map数,这时blockSize为当前文件的块size,而goalSize是文件大小除以用户设置的map数得到的,如果没设置的话,默认是1)。

hadooop提供了一个设置map个数的参数mapred.map.tasks,我们可以通过这个参数来控制map的个数。但是通过这种方式设置map的个数,并不是每次都有效的。原因是mapred.map.tasks只是一个hadoop的参考数值,最终map的个数,还取决于其他的因素。

为了方便介绍,先来看几个名词:

block_size : hdfs的文件块大小,默认为64M,可以通过参数dfs.block.size设置

total_size : 输入文件整体的大小

input_file_num : 输入文件的个数

(1)默认map个数

如果不进行任何设置,默认的map个数是和blcok_size相关的。

default_num = total_size / block_size;

(2)期望大小

可以通过参数mapred.map.tasks来设置程序员期望的map个数,但是这个个数只有在大于default_num的时候,才会生效。

goal_num = mapred.map.tasks;

(3)设置处理的文件大小

可以通过mapred.min.split.size 设置每个task处理的文件大小,但是这个大小只有在大于block_size的时候才会生效。

split_size = max(mapred.min.split.size, block_size);

split_num = total_size / split_size;

(4)计算的map个数

compute_map_num = min(split_num, max(default_num, goal_num))

除了这些配置以外,mapreduce还要遵循一些原则。 mapreduce的每一个map处理的数据是不能跨越文件的,也就是说min_map_num >= input_file_num。 所以,最终的map个数应该为:

final_map_num = max(compute_map_num, input_file_num)

经过以上的分析,在设置map个数的时候,可以简单的总结为以下几点:

(1)如果想增加map个数,则设置mapred.map.tasks 为一个较大的值。

(2)如果想减小map个数,则设置mapred.min.split.size 为一个较大的值。

(3)如果输入中有很多小文件,依然想减少map个数,则需要将小文件merger为大文件,然后使用准则2。

3. 实际案例

在工作中,要处理大量的小文件(个数几万个不等),但是总文件大小很小,按照上边解释一计算的map个数就会很少,那么无法利用集群的计算优势,再有可能会出现一些错误(因为文件数量很大,IO开销会很大,mapreduce作业中print函数输出的次数会非常多,会引发异常。。。。)

那么在这种情况下,我们要需要增加map的个数,根据上边解释一,在Hadoop streaming运行程序,自定义文件split的大小,不改变hadoop默认的block_size,通过设置mapred.max.split.size=4194304将文件split大小变为了4M,脚本如下所示:

hadoop jar /home/work/software/hadoop/contrib/streaming/hadoop-streaming.jar \

-D mapred.reduce.tasks=100 \

-D mapred.max.split.size=4194304 \

-D mapreduce.map.memory.mb=8120 \

-D mapreduce.map.java.opts="-Xmx7800m" \

-D mapreduce.reduce.memory.mb=8120 \

-D mapreduce.reduce.java.opts="-Xmx7800m" \

-D mapred.job.name="lkk-s_train_test_split" \

-D mapred.compress.map.output=true \

-D mapred.map.output.compression.codec=com.hadoop.compression.lzo.LzoCodec \

-D mapred.output.compress=true \

-D mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec \

-input $input_dir/nor* \

-output $output_dir \

-outputformat org.apache.hadoop.mapred.lib.SuffixMultipleTextOutputFormat \

-jobconf suffix.multiple.outputformat.filesuffix="train-nor,test-nor" \

-jobconf suffix.multiple.outputformat.separator="#" \

-mapper "./pypy/bin/pypy mapper.py" \

-reducer "./pypy/bin/pypy reducer_split.py" \

-file "mapper.py" \

-file "reducer_split.py" \

-inputformat org.apache.hadoop.mapred.lib.CombineTextInputFormat \

-cacheArchive "/home/hdp-skyeye-data/tangliang/networkurilabel/pypy.tgz#pypy"