Python学习之爬虫-爬虫的异常处理

概述:

爬虫在运行的过程中,很多时候都会遇到这样或那样的异常,如果没有异常处理,爬虫遇到异常时就会直接崩溃停止运行,下次再次运行时,又会重头开始,所以我们必须要对爬虫的异常进行处理,使之遇到异常后仍能继续运行下去。

常见的状态码即含义:

200:成功

301:重定向到新的URL,永久性

302:重定向到临时的URL,非永久性

400:非法请求

401:请求未经授权,没有权限访问

403:禁止访问

404:没有找到对应页面

500:服务器内部出现错误

501:服务器不支持实现请求所需的功能

URLError和HTTPError

两者的关系:HTTPError是URLError的子类。

区别:HTTPError有异常状态码与异常原因,URLError没有异常状态码。

使用注意:不能使用URLError直接代替HTTPError,如果要代替,必须要判断是否有状态码属性。

URLError出现的原因:

-

连不上服务器

-

远程url不存在

-

无网络

-

触发HTTPError

…

扫描二维码关注公众号,回复: 5091172 查看本文章

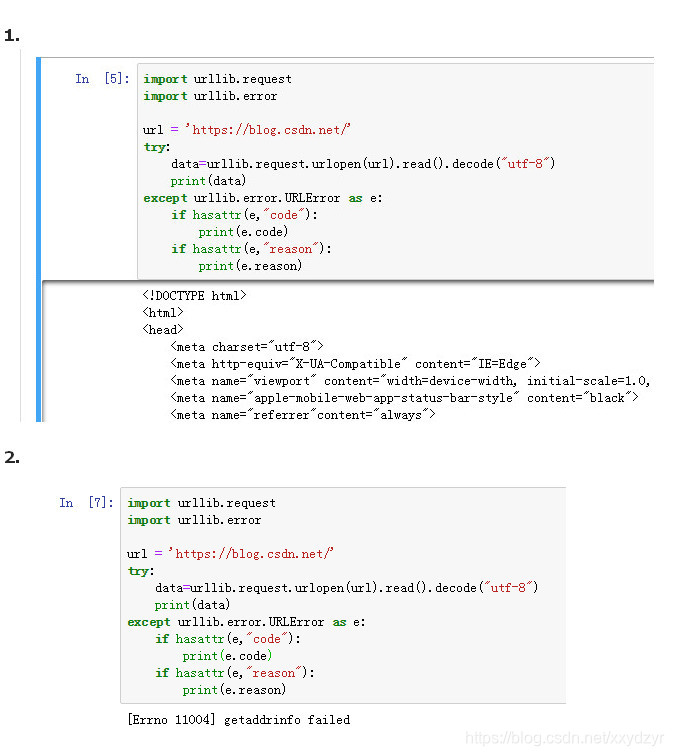

#异常处理

import urllib.request

import urllib.error

url = 'https://blog.csdn.net/'

try:

data=urllib.request.urlopen(url).read().decode("utf-8")

print(data)

except urllib.error.URLError as e:

if hasattr(e,"code"): # hasattr()判断是否用那某项属性

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

练习结果:

我擦,我这竟然可以把首页爬下来…

为得模拟出错,没法,只能把网络给断开,断开后就出现图2的情况