在综述中纷纷云云一言以蔽之就是各种技术的排列组合和性能优化。但神经网络很让人诟病的是它的“黑匣子”特性,在应用于推荐系统中时我们往往无法理解,即没有有效的可解释性。

比如CF 是很好的个性化推荐主流技术,但它只对用户–项目交互进行建模,不能为推荐提供具体的理由(仅仅是你的朋友喜欢那么你就会喜欢,这样的理由往往太过粗糙)。技术上更是因为在基于embedding的方法后,如Wide&Deep和FM等,虽然有很好的推荐性能,但是它们就像黑匣子一样工作,无法解释embedding后的隐变量究竟是什么,也无法明确说明预测的理由。而基于树的方法,如决策树,只是通过从数据中推断决策规则来进行预测的,而忽视了交互特性,因此它具有在协作性、扩展性的场景效果不佳。于是乎:

Tree-enhanced Embedding Method (树增强嵌入方法,TEM) 结合了基于embedding和基于tree的模型的优点。即先使用一个基于树(GBDT)的模型来学习丰富的显式决策规则(从用户和项目的侧信息上学习交叉特性)。然后再用基于embedding的attention模型,它可以包含显式的交叉特征,也可以推广到用户ID上未见的交叉特征和还有物品ID。

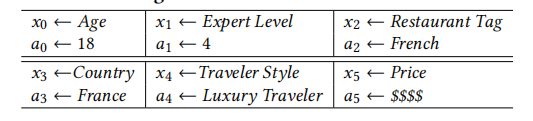

比如上面的GBDT树,具体分类标准如下:

从根结点到叶结点的路径可以看作形成了一个决策规则,这就形成了天然的自解释的性质。但是由于单纯的tree在面对未知特征,比如用户和商品的ID时树模型的泛化能力很差。于是再采用embedding:

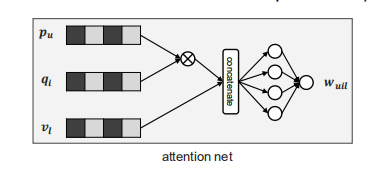

即该模型先使用GBDT来构造各种交叉特征(构造完毕后),然后利用交叉特征,仅仅使用embedding和attention机制来代替全连接层(全连接层的高抽象能力产生的非线性,也没有了模型的可解释性)。其中模型中的attention net具体为:

是(u,i)的第 l 个交叉向量的权重,但是对于没记录即(u,i)不存在的情况下无法估计这个权重,所以作者将它看作是一个独立函数,然后用MLP来估计它。最后再用max或者avg来聚合特征。