代码如下:

package cn.itcast.hdfs; import java.io.IOException; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class TestHDFS { public static void main(String[] args) throws IOException { Configuration conf = new Configuration(); //伪造root用户身份 System.setProperty("HADOOP_USER_NAME","root"); //1首先需要一个hdfs的客户端对象 conf.set("fs.defaultFS", "hdfs://mini1:9000"); FileSystem fs = FileSystem.get(conf); fs.copyToLocalFile( new Path("/hello.txt"),new Path("E://")); fs.close(); } }

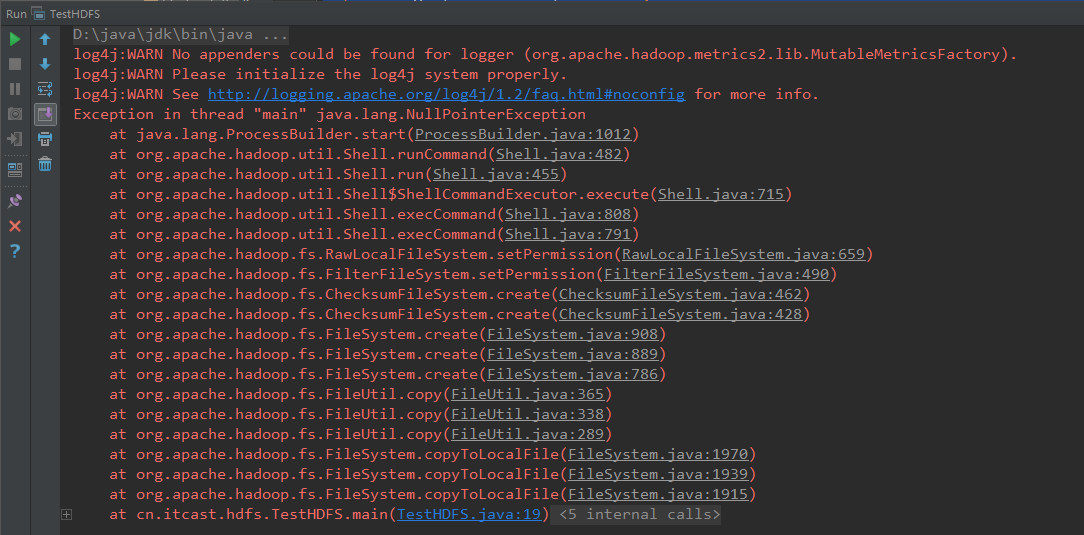

此时会报空指针异常

修改后代码如下:

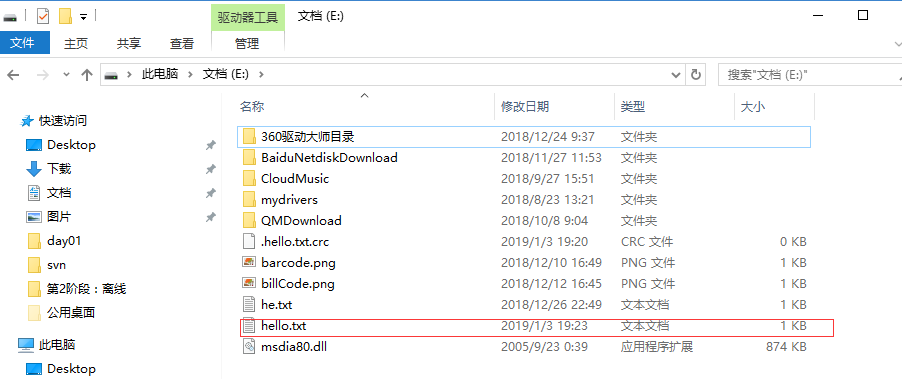

package cn.itcast.hdfs; import java.io.IOException; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class TestHDFS { public static void main(String[] args) throws IOException { Configuration conf = new Configuration(); //伪造root用户身份 System.setProperty("HADOOP_USER_NAME", "root"); //1首先需要一个hdfs的客户端对象 conf.set("fs.defaultFS", "hdfs://mini1:9000"); FileSystem fs = FileSystem.get(conf); // fs.copyToLocalFile( new Path("/hello.txt"),new Path("E://")); fs.copyToLocalFile(false, new Path("/hello.txt"), new Path("E://"), true); fs.close(); } }

注意,出现以上的问题是没有配环境变量造成的

window下开发的说明

建议在linux下进行hadoop应用的开发,不会存在兼容性问题。如在window上做客户端应用开发,需要设置以下环境:

A、用老师给的windows平台下编译的hadoop安装包解压一份到windows的任意一个目录下

B、在window系统中配置HADOOP_HOME指向你解压的安装包目录

C、在windows系统的path变量中加入HADOOP_HOME的bin目录