最近在通读Python自然语言这本书,尝试安装nltk及测试。

Windows平台:

以下操作前提,已经安装Python,只需要安装NLTK。

若没有安装Python,请按照官网或者点击按照下面的链接安装Python。https://www.liaoxuefeng.com/wiki/001374738125095c955c1e6d8bb493182103fac9270762a000/001374738150500472fd5785c194ebea336061163a8a974000

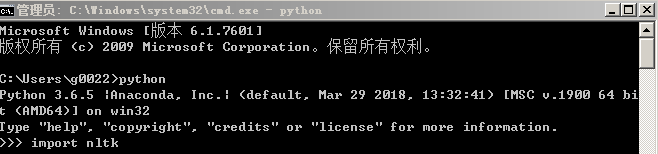

win + R cmd 进入命令行,输入Python,输入:import nltk

执行nltk.download()

![]()

弹出以下窗口(刚打开的status应该是not installed):

双击all 即下载,过程中可能会出现下载失败的问题,只需要重新手动双击未下载成功的identifier即可。

完成:

以下是内置函数Text测试代码:

# -*- coding: utf-8 -*-

from __future__ import division

from nltk.book import *

# 我们可以看到nltk预先帮我们加载了一些书籍数据text1~text9,text1~text9为Text类的实例对象名称,它们都代表一本书籍。

# 实际上Text类的构造函数接受一个单词列表作为参数,NLTK库预先帮我们构造了几个Text对象。

# 搜索文本

# print(text1.concordance("monstrous"))

print(text1.name)

# print(text1.count())

#concordance函数 给出一个指定单词每一次出现,连同上下文一起显示。

con = text1.concordance('monstrous')

print(con)

#similar函数 查找文中上下文结构相似的词,如the___pictures 和 the___size 等。

sim = text1.similar("monstrous")

print(sim)

#common_contexts 函数 检测、查找两个或两个以上的词共同的上下文。

#该方法接受一个单词列表,会打印出列表中所有单词共同的上下文。

com = text2.common_contexts(["monstrous", "very"])

print(com)

#判断词在文本中的位置:从文本开头算起在它前面有多少词。这个位置信息可以用离散图表示。

#该方法接受一个单词列表,会绘制每个单词在文本中的分布情况。

dis = text4.dispersion_plot(["citizens", "democracy", "freedom", "duties", "America"])

print(dis)

#计数词汇

#词语计数

lenT = len(text3)

print(lenT)

#文本-->词表 并排序

sor = sorted(set(text3))

print(sor)

#获取不重复单词数目

lenS = len(set(text3))

print(lenS)

#该方法接受一个单词,返回该单词在文本中出现的次数

coun = text1.count("monstrous")

print(coun)

#词汇丰富度

ric = len(text3) / len(set(text3))

print(ric)

# 词语搭配和双连词

# 该方法会打印出文本中频繁出现的双连词。

text1.collocations()

# 索引列表

# 表示元素位置的数字叫做元素的索引。

word = text1[50]

print(word)

# 找出一个词第一次出现的索引。

index = text1.index('grammars')

print(index)打印的结果就不再粘贴了。