在学习Python爬虫的时候,经常会遇见所要爬取的网站采取了反爬取技术导致爬取失败。高强度、高效率地爬取网页信息常常会给网站服务器带来巨大压力,所以同一个IP反复爬取同一个网页,就很可能被封,这里讲述一个爬虫技巧,设置**代理IP**。

配置环境

- 安装requests库

- 安装bs4库

- 安装lxml库

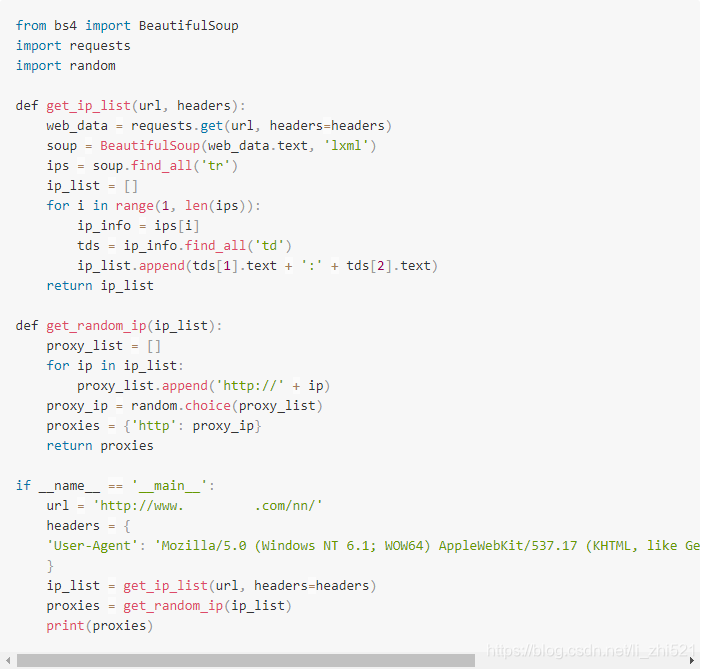

具体代码

函数get_ip_list(url, headers)传入url和headers,最后返回一个IP列表,列表的元素类似122.114.31.177:808格式,这个列表包括国内髙匿代理IP网站首页所有IP地址和端口。

函数get_random_ip(ip_list)传入第一个函数得到的列表,返回一个随机的proxies,这个proxies可以传入到requests的get方法中,这样就可以做到每次运行都使用不同的IP访问被爬取的网站,有效地避免了真实IP被封的风险。

proxies的格式是一个字典:{‘http’: ‘http://122.114.31.177:808‘},可以将下面的执行也封装为方法。

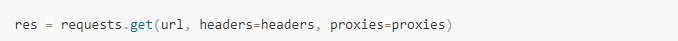

代理IP的使用

运行上面的代码会得到一个随机的proxies,把它直接传入requests的get方法中即可