前一天提交的spark streaming测试程序,master为local[*]

第二天从cdh界面发现该主机多了100多G文件

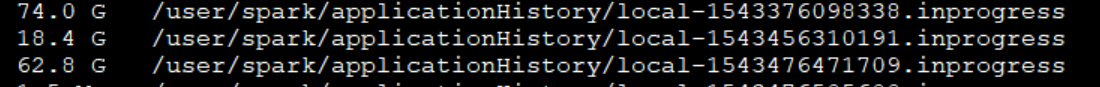

查看hdfs 目录下/user/spark/applicationHistory,发现提交的spark程序产生了大量日志文件

hdfs dfs -du -h /user/spark/applicationHistory

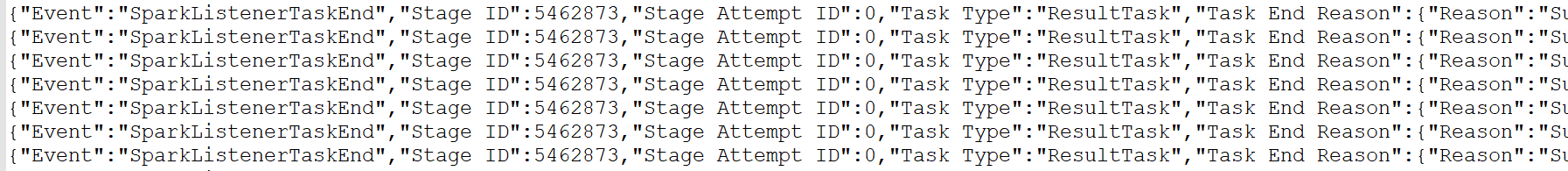

查看前几行,都是些event日志,下面是一部分截图。

去cdh界面,spark搜配置,spark.eventlog.enabled

默认是开启,关闭就ok了,然后将日志文件删除,并清空hdfs回收站.