版权声明:转载需说明出处! https://blog.csdn.net/m0_38106923/article/details/81534919

目录

-

开发环境

- Python 2.X或Python3.X

- OpenCV

- NumPy

- DLIB

- pygame

- PyOpenGL

- 必须从此处下载面部对齐模型:http://sourceforge.net/projects/dclib/files/dlib/v18.10/shape_predictor_68_face_landmarks.dat.bz2并将其解压缩到主项目目录。

-

运行机制

首先,我们获取输入图像(我们想要在自己的脸上看到的人的图像)并找到面部区域及其地标。一旦我们得到了我们将3D模型拟合到那些地标(稍后更多),投射到图像空间的模型的顶点将是我们的纹理坐标。一旦完成并且所有内容都已初始化,相机将开始捕获图像。对于每个捕获的图像,执行以下步骤:

- 检测面部区域并定位面部标志。

- 3D模型适用于定位的地标。

- 使用pygame渲染3D模型,其中初始化期间获得纹理。

- 使用羽化(α混合)和非常简单的颜色校正将渲染模型的图像与从相机获得的图像混合。

- 最终图像显示给用户。

整个过程中最关键的因素是3D模型的拟合。该模型本身包括:

- 中性面的3D形状(顶点集),

- 一些混合形状,可以添加到中性面,以产生张口,眉毛等,

- 面部形状的一组三元组,形成面部的三角形网格,

- 两组索引,用于建立由界标定位器找到的界标与3D面部形状的顶点之间的对应关系。

使用以下等式将模型投影到图像空间中:

其中s是投影形状,a是缩放参数,P是旋转3D表面形状的旋转矩阵的前两行,S_0是中性面形状,w_1-n是混合形状权重,S_1-n是blendshapes,t是2D平移向量,n是混合形状的数量。

通过最小化投影形状和局部标志之间的差异来完成模型拟合。使用高斯牛顿法,相对于混合形状权重,缩放,旋转和平移完成最小化。

扫描二维码关注公众号,回复:

4251273 查看本文章

-

案例效果

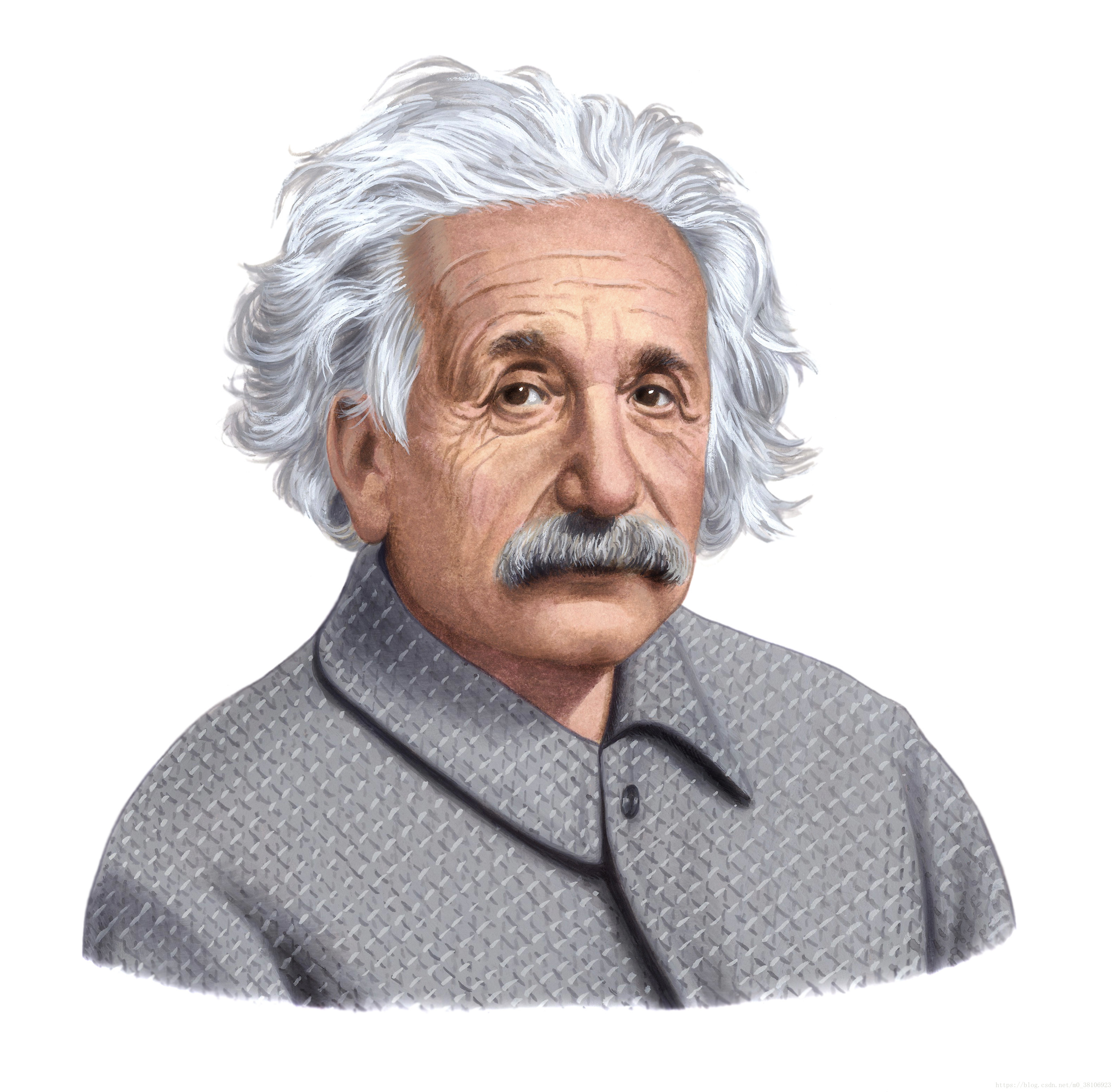

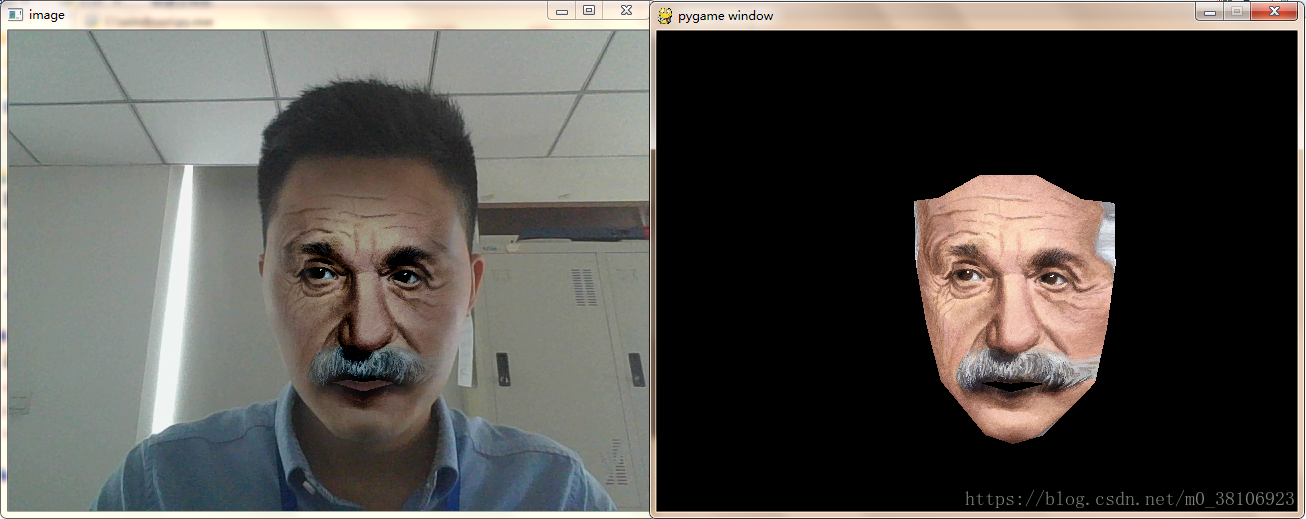

接下来使用实时视频将爱因斯坦的脸移植到我的脸上~

原图片如下:

移植后效果如下:

-

案例下载

案例Demo下载:https://download.csdn.net/download/m0_38106923/10593086