版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/KevinBetterQ/article/details/84500964

首先,对于更定数据集

{

(

x

1

,

y

1

)

,

(

x

2

,

y

2

)

,

…

,

(

x

m

,

y

m

)

}

\{ (x_1,y_1),(x_2,y_2),…,(x_m,y_m) \}

{ ( x 1 , y 1 ) , ( x 2 , y 2 ) , … , ( x m , y m ) }

P

(

X

∣

Y

)

P(X|Y)

P ( X ∣ Y )

P

(

Y

)

P(Y)

P ( Y )

P

(

X

,

Y

)

=

P

(

X

∣

Y

)

P

(

Y

)

P(X,Y) = P(X|Y)P(Y)

P ( X , Y ) = P ( X ∣ Y ) P ( Y )

x

x

x

y

y

y

P

(

y

∣

x

)

=

P

(

x

,

y

)

P

(

x

)

P(y|x) = \frac{P(x,y)}{P(x)}

P ( y ∣ x ) = P ( x ) P ( x , y )

P

P

P

y

y

y

y

y

y

这里有必要解释一下先验概率和后验概率:先验概率 :统计概率,通过历史的数据统计出的事情发生的概率后验概率 :条件概率,当下由因及国的概率似然 :是根据已知结果去推测固有性质的可能性,是对固有性质的拟合程度。在乎的是 x 和 y 的搞演习,拟合程度,所以不能称为概率,为似然函数。

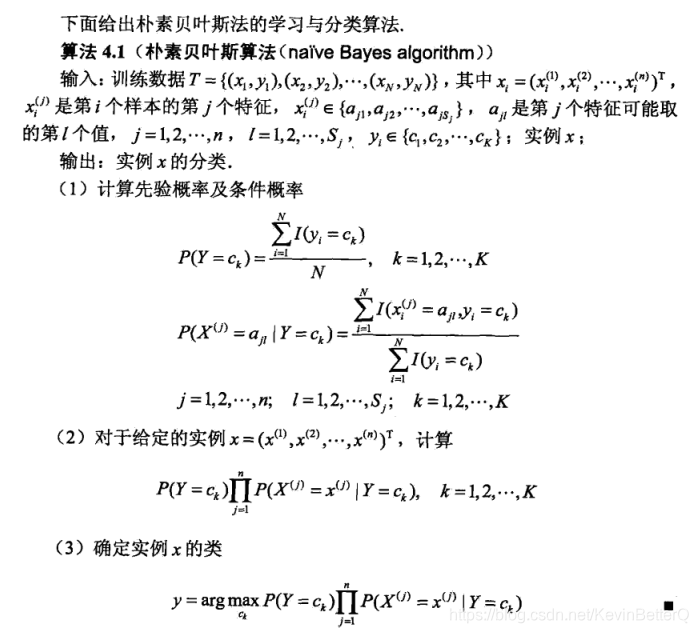

1、朴素贝叶斯法利用贝叶斯定理和学到的联合概率模型进行分类预测:

P

(

Y

∣

X

)

=

P

(

X

,

Y

)

P

(

X

)

P(Y|X) = \frac{P(X,Y)}{P(X)}

P ( Y ∣ X ) = P ( X ) P ( X , Y )

P

(

X

,

Y

)

P(X,Y)

P ( X , Y )

P

(

X

)

P(X)

P ( X )

所以,朴素贝叶斯分类模型 (非最终版):

y

=

a

r

g

m

a

x

c

k

P

(

X

=

x

,

Y

=

c

k

)

y = arg \; {max}_{c_k} \; P(X=x,Y=c_k)

y = a r g m a x c k P ( X = x , Y = c k )

P

(

X

,

Y

)

P(X,Y)

P ( X , Y )

2、如何训练得到联合概率分布 P(X,Y):

P

(

X

,

Y

)

=

P

(

Y

)

P

(

X

∣

Y

)

P(X,Y) = P(Y)P(X|Y)

P ( X , Y ) = P ( Y ) P ( X ∣ Y ) 特征条件独立性假设 :

P

(

X

=

x

∣

Y

=

c

k

)

=

P

(

X

(

1

)

=

x

(

1

)

,

…

,

X

(

n

)

=

x

(

n

)

∣

Y

=

c

k

)

=

∏

j

=

1

n

P

(

X

(

j

)

=

x

(

j

)

∣

Y

=

c

k

)

\begin {aligned} P(X=x|Y=c_k) &= P(X^{(1)}=x^{(1)},…,X^{(n)}=x^{(n)}|Y=c_k)\\ &=\prod_{j=1}^{n}P(X^{(j)}=x^{(j)}|Y=c_k) \end {aligned}

P ( X = x ∣ Y = c k ) = P ( X ( 1 ) = x ( 1 ) , … , X ( n ) = x ( n ) ∣ Y = c k ) = j = 1 ∏ n P ( X ( j ) = x ( j ) ∣ Y = c k )

条件独立性假设: 等于是说用于分类的特征在类确定的情况下都是条件独立的。

2)

P

(

Y

=

c

k

)

P(Y=c_k)

P ( Y = c k )

Y

=

c

k

Y=c_k

Y = c k

3、朴素贝叶斯分类模型 (最终版) :

y

=

a

r

g

m

a

x

c

k

P

(

Y

=

c

k

)

∏

j

=

1

n

P

(

X

(

j

)

=

x

(

j

)

∣

Y

=

c

k

)

y = arg \; {max}_{c_k} \; P(Y=c_k)\prod_{j=1}^{n}P(X^{(j)}=x^{(j)}|Y=c_k)

y = a r g m a x c k P ( Y = c k ) j = 1 ∏ n P ( X ( j ) = x ( j ) ∣ Y = c k )

x

i

=

(

x

i

(

1

)

,

x

i

(

2

)

,

…

,

x

i

(

n

)

)

T

x_i=(x_i^{(1)},x_i^{(2)},…,x_i^{(n)})^T

x i = ( x i ( 1 ) , x i ( 2 ) , … , x i ( n ) ) T

c

k

c_k

c k

注意:这里利用样本数据学习到的是一个分布(联合概率分布 P(X,Y)),而不是像其它ML模型训练那样学习参数。

参考: 机器学习知识点(二十七)先验概率和后验概率理解