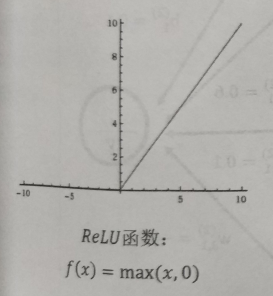

tf.nn.relu()函数是将大于0的数保持不变,小于0的数置为0,函数如图1所示。

ReLU函数是常用的神经网络激活函数之一。

下边为ReLU例子:

import tensorflow as tf

v = tf.constant([-3, 5, 6, -6,9])

sess = tf.Session()

print('v的原始值为:', end='')

print(sess.run(v))

print('v的ReLu后的值为:', end='')

print(sess.run(tf.nn.relu(v)))

sess.close()输出为:

v的原始值为:[-3 5 6 -6 9]

v的ReLu后的值为:[0 5 6 0 9]