分享一下我老师大神的人工智能教程!零基础,通俗易懂!http://blog.csdn.net/jiangjunshow

也欢迎大家转载本篇文章。分享知识,造福人民,实现我们中华民族伟大复兴!

本目录下的代码赢得了2016年MSCOCO关键点挑战赛以及2016年ECCV最佳演示奖,并发表在2017年CVPR的口头论文(Oral Paper)中。

演示视频:

在论文中,我们提出了一种自下而上的方法进行多人姿态估计,这种方法不需要任何行人检测的算法。

论文地址:https://arxiv.org/abs/1611.08050

实验结果

测试C ++(实时版本,用于演示)

按照说明,使用我们改动后的Caffe。

改动后caffe地址:https://github.com/CMU-Perceptual-Computing-Lab/caffe_rtpose

三种输入选项:图像,视频,网络摄像机

Matlab(较慢,用于COCO评估)

·兼容一般的Caffe,但需要编译matcaffe。

·运行

cd testing

get_model.sh

从我们的Web服务器检索最新的MSCOCO模型。

更改config.m中的caffe 地址并运行demo.m例程。

Pythoncd testing / python

ipython notebook

打开demo.ipynb 并执行代码

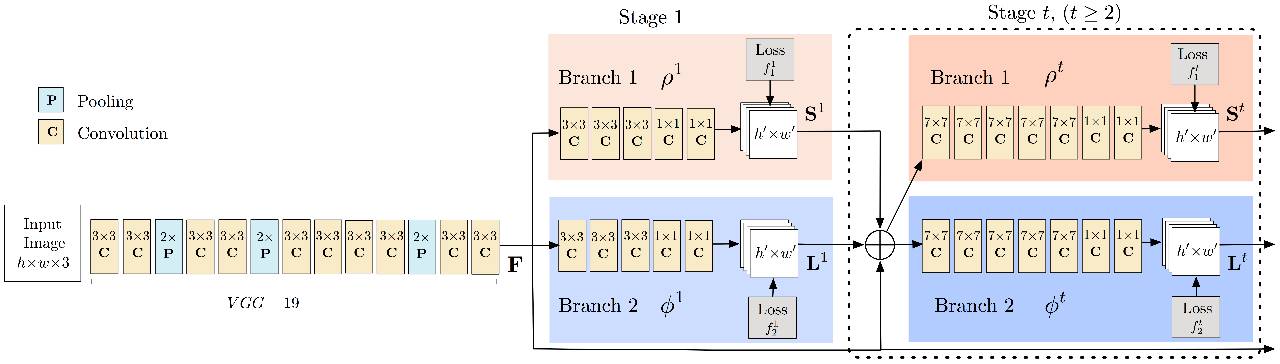

训练网络结构

训练步骤

运行

cd training

bash getData.sh

得到 dataset/COCO/images/ 文件夹下的数据集COCO,关键点信息在 dataset/COCO / annotations / 文件夹中,COCO官方工具箱在文件夹 dataset/ COCO / coco / 下。

·在 matlab 中运行 getANNO.m,在dataset/COCO/mat/将标注格式从 json 转换为 mat。

·在 matlab 中运行 genCOCOMask.m,得到无标签人的掩码图像。并且,在 matlab 中可以使用'parfor'(并行计算)来加速代码。

·运行genJSON('COCO'),在 dataset/COCO/json/中生成一个 json 文件。 json 文件包含训练所需的原始信息。

·运行python genLMDB.py 生成 COCO 数据库的 LMDB 文件,也可以运行如下代码:

bashget_lmdb.sh

得到已经生成好的LMDB文件

·下载改动后的caffe,编译 pycaffe。他将与 caffe_rtpose(用于测试)合并。

·运行

pythonsetLayers.py —exp 1

生成用于训练的prototxt和脚本文件。

下载VGG-19模型。利用此模型初始化前10层网络参数。

模型地址: https://gist.github.com/ksimonyan/3785162f95cd2d5fee77

运行

bash train_pose.sh 0,1

由setLayers.py生成,开始使用两个GPU进行训练。

相关论文:https://github.com/shihenw/convolutional-pose-machines-release

点击阅读原文跳转Github资源

给我老师的人工智能教程打call!http://blog.csdn.net/jiangjunshow