十岁的小男孩

TensorRT 3: Faster TensorFlow Inference and Volta Support

Fast INT8 Inference for Autonomous Vehicles with TensorRT 3

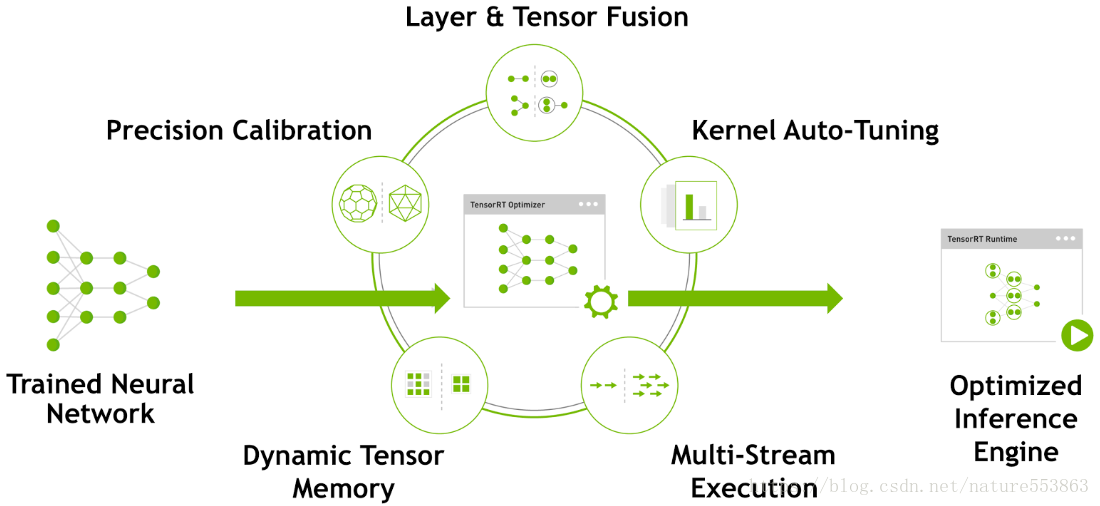

TensorRT是NVIDIA推出的深度学习优化加速工具,采用的原理如下图所示

TensorRT能够优化重构由不同深度学习框架训练的深度学习模型:

对于Caffe与TensorFlow训练的模型,若包含的操作都是TensorRT支持的,则可以直接由TensorRT优化重构;

对于MXnet, PyTorch或其他框架训练的模型,若包含的操作都是TensorRT支持的,可以采用TensorRT API重建网络结构,并间接优化重构;

若训练的网络模型包含TensorRT不支持的操作:

TensorFlow模型可通过tf.contrib.tensorrt转换,其中不支持的操作会保留为TensorFlow计算节点;

不支持的操作可通过Plugin API实现自定义并添加进TensorRT计算图;

将深度网络划分为两个部分,一部分包含的操作都是TensorRT支持的,可以转换为TensorRT计算图。另一部则采用其他框架实现,如MXnet或PyTorch;

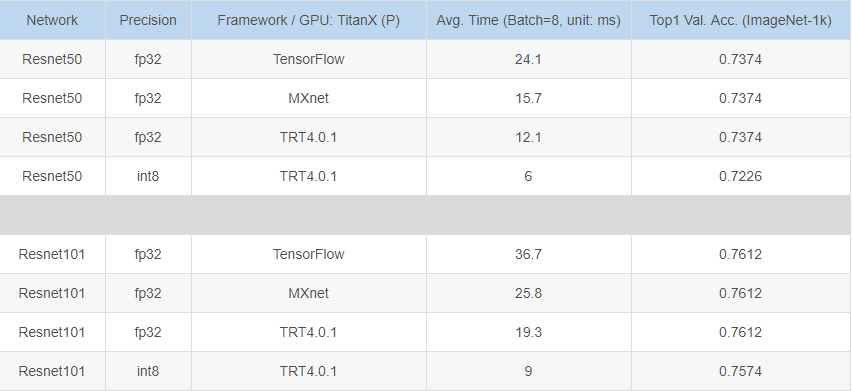

TensorRT的int8量化需要校准(calibration)数据集,一般至少包含1000个样本(反映真实应用场景),且要求GPU的计算功能集sm >= 6.1;

在TitanX (Pascal)平台上,TensorRT对大型分类网络的优化加速效果如下:

知识应该是开源的,欢迎斧正,[email protected]