版权声明: https://blog.csdn.net/zhuangzi123456/article/details/80654188

一,环境说明

服务器型号:DELL R530

硬件规格参数:48核心,64G内存,4*2T硬盘,磁盘阵列卡

操作系统发行版:CentOS Linux release 7.3.1611 (Core)

内核版本:3.10.0-514.el7.x86_64

网络拓扑:

本地计算机:192.168.13.105

宿主机1:

iDRAC地址:10.1.73.10

em3网卡:10.1.73.11

宿主机2:

iDRAC地址:10.1.73.15

em3网卡:10.1.73.16

规划:

磁盘做RAID10

二,通过iDRAC远程管理口配置RAID10、安装操作系统

1,本地电脑需要安装JDK8,如果是JDK7,默认配置会导致开启虚拟控制台的时候始终连接失败,因为JDK7默认支持的TLS1.0,而DELL R530默认是支持的TLS1.1及以上,而JDK8默认就支持TLS1.1及以上,最初这个问题纠结了好久;其实也可以通过修改java控制面板中支持的TLS来实现,不过为了方便可以一步到位直接安装JDK8;

2,在浏览器输入管理口ip地址,以此处为例是

10.1.73.15

(1)建议使用firefox浏览器;

(2)管理口默认的账号为root,密码为calvin;

3,配置RAID10

服务器启动过程中按Ctrl+R键,进入RAID阵列管理器界面:

图1:在该界面按Ctrl+R键可进入RAID阵列管理器界面

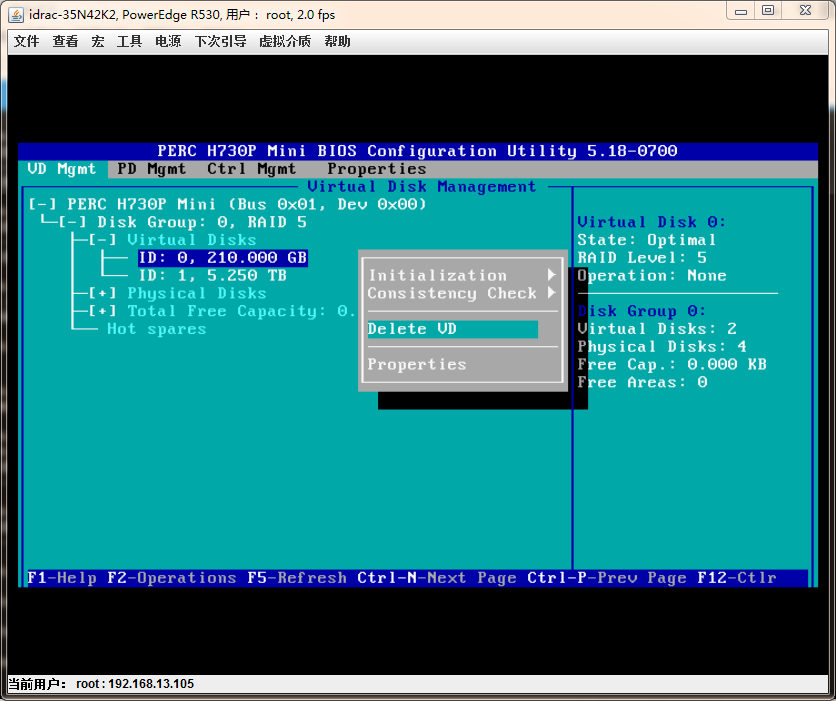

图2:

这里是重新做RAID10,重装系统,之前做的RAID5,所以这里要先把之前的VD删除,先选中要操作的条目,高亮(深蓝色)表示选中,选中后按F2键,弹出菜单,选择Delete VD,同样的操作删除所有的VD;

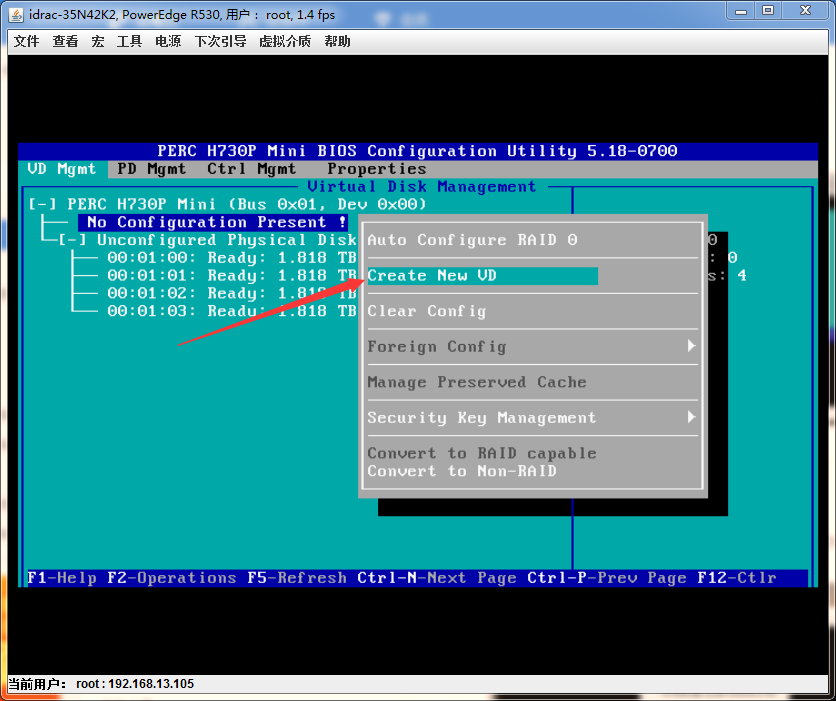

图3:

VD全部删除之后,高亮选中“No Configuration Present !”,按F2键,弹出菜单列表,选中“Create New VD”,此时就开始要配置RAID10了;

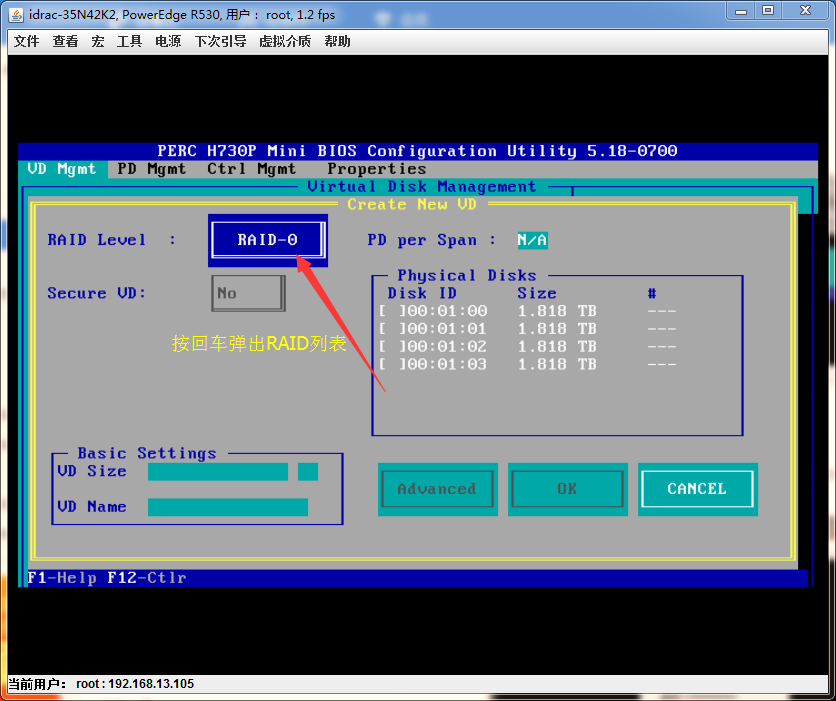

图4:

弹出对话框:高亮RAID-0处,按回车键,可以显示此时服务器支持的RAID级别列表,如图5所示。

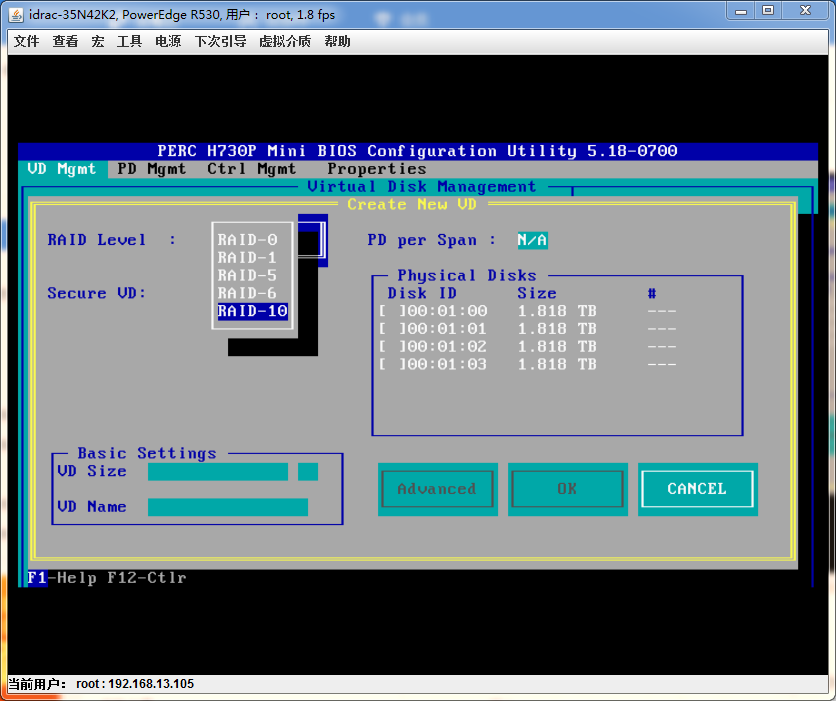

图5:

这里选择RAID10即可;

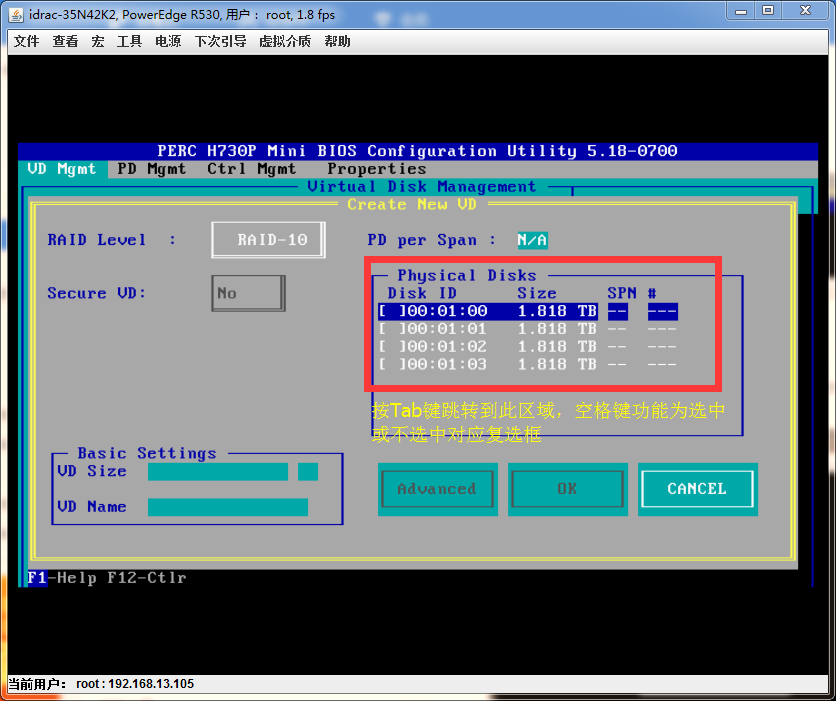

图6:

将所有物理磁盘都勾选上,因为做RAID10最少需要4块硬盘;

图7:

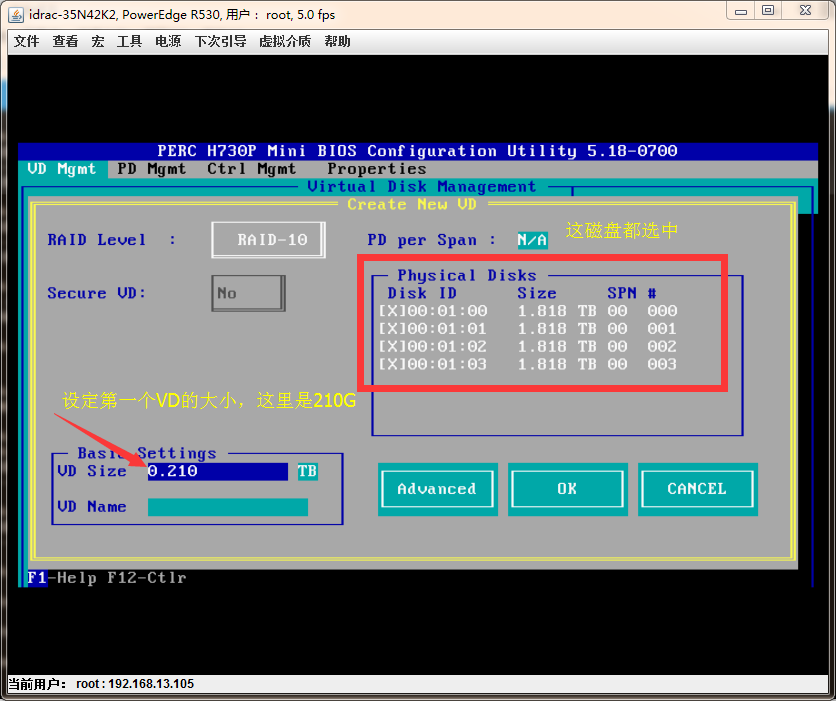

勾选所有物理磁盘之后的样子,在磁盘前面的复选框中都多了一个“X”符号;

然后OK即可;

按照相同的操作接下来创建第二个和第三个VD;

图8:

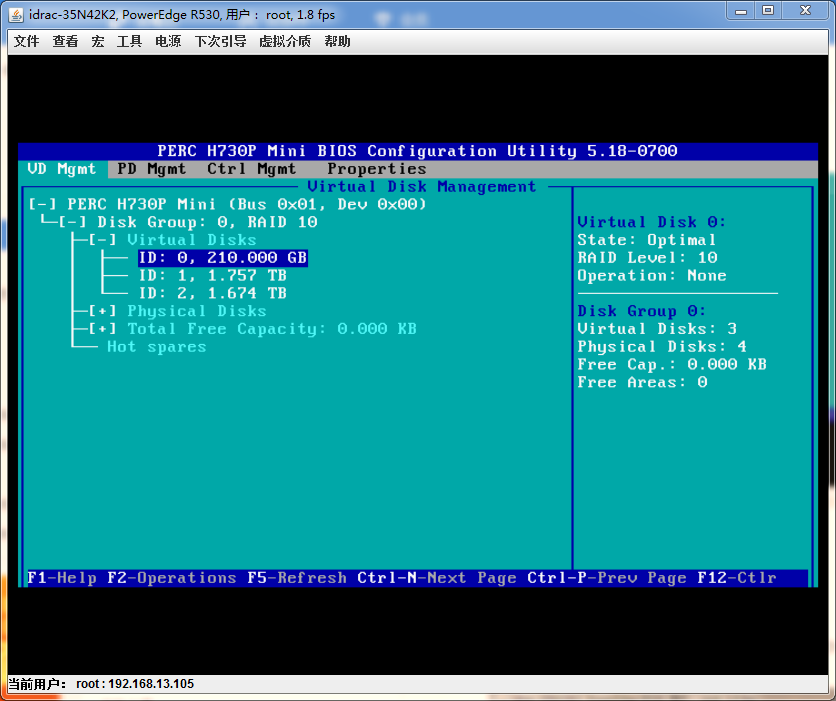

创建好之后如下图所示,我这里是创建了3个VD;

图9:

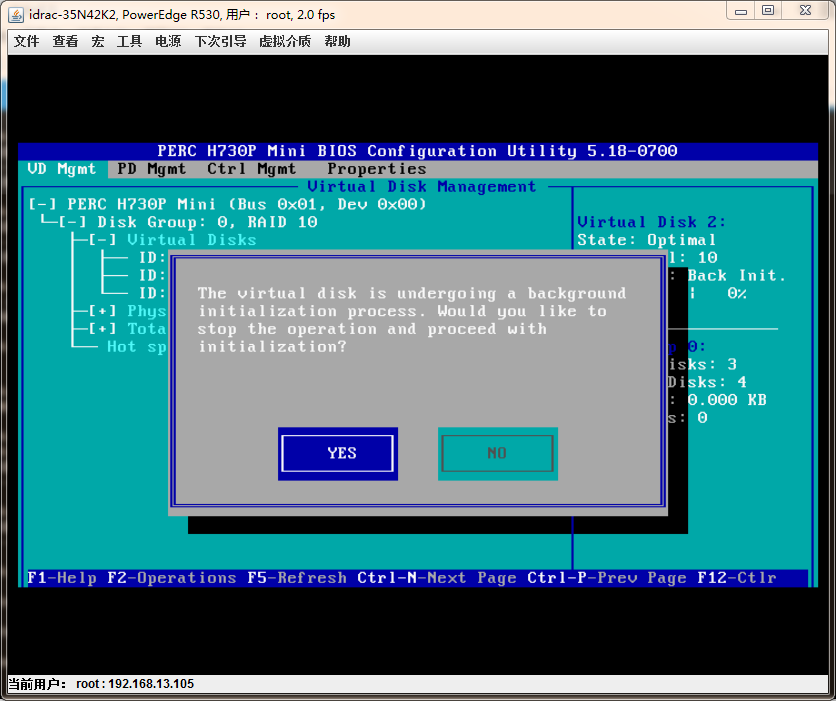

RAID的VD初始化:

选中要配置的项---->按F2键--->Initialization--->Fast init

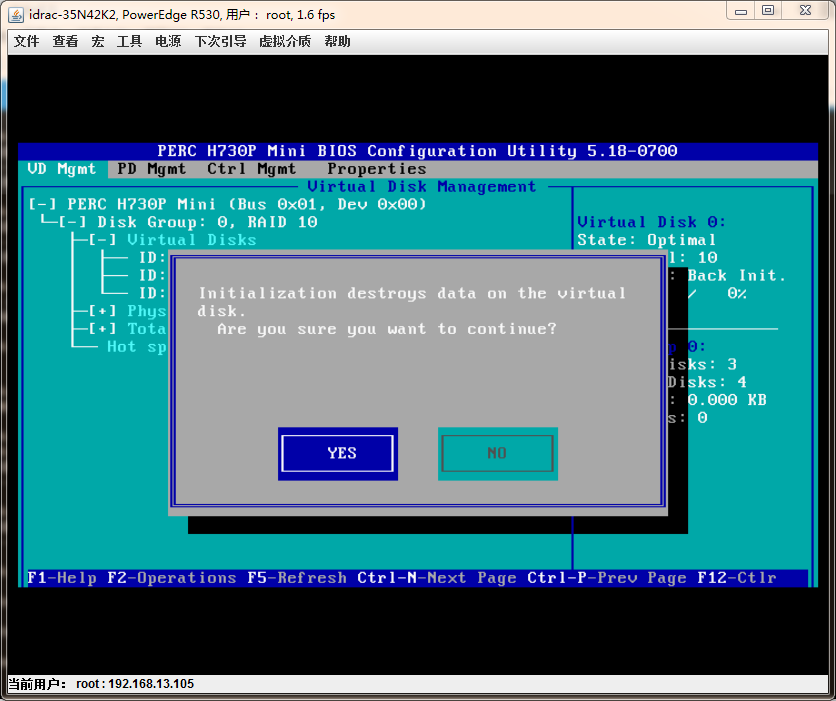

图10:

选择yes

图11:

选择yes

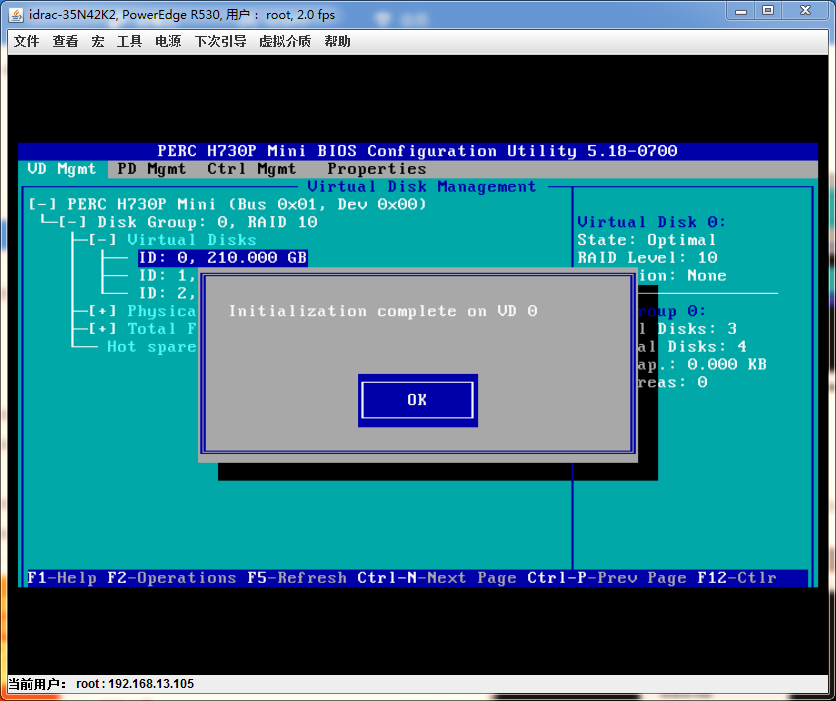

图12:

回车键OK

然后同样的方法初始化VD1和VD2

配置完之后直接退出即可;Esc按键

图13:

配置好之后,重启一下服务器:

图14:

在图1界面时按F2键进入System Setup界面,目的是查看CPU虚拟化技术是否开启,一般默认是开启的,但为了保险起见,还是确认一下:System BIOS--->Processor Settings--->Virtualization Technology

确认之后可以退出,然后一路Esc键就可以了,不需要重启系统,因为我这里服务器是默认就已经启动了,我这里没做修改;

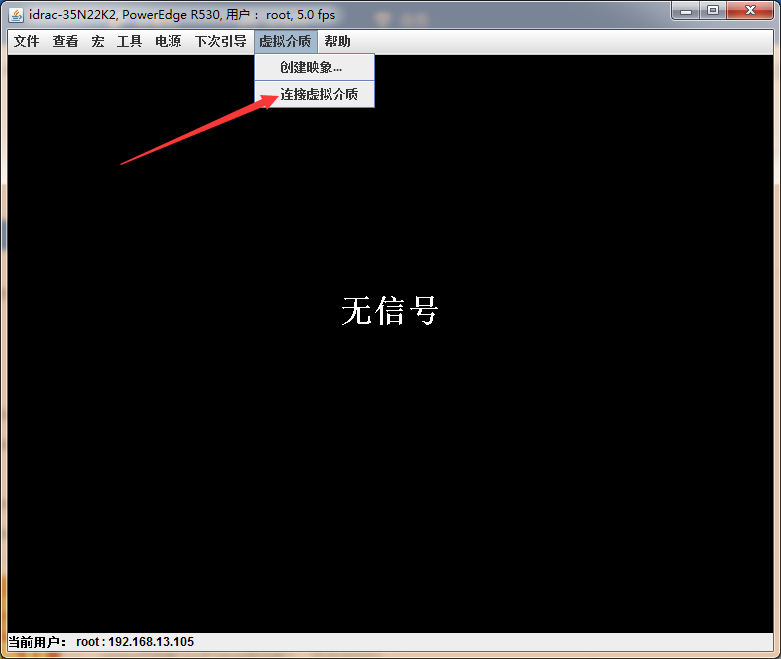

4,开启虚拟控制台挂载系统镜像并安装操作系统

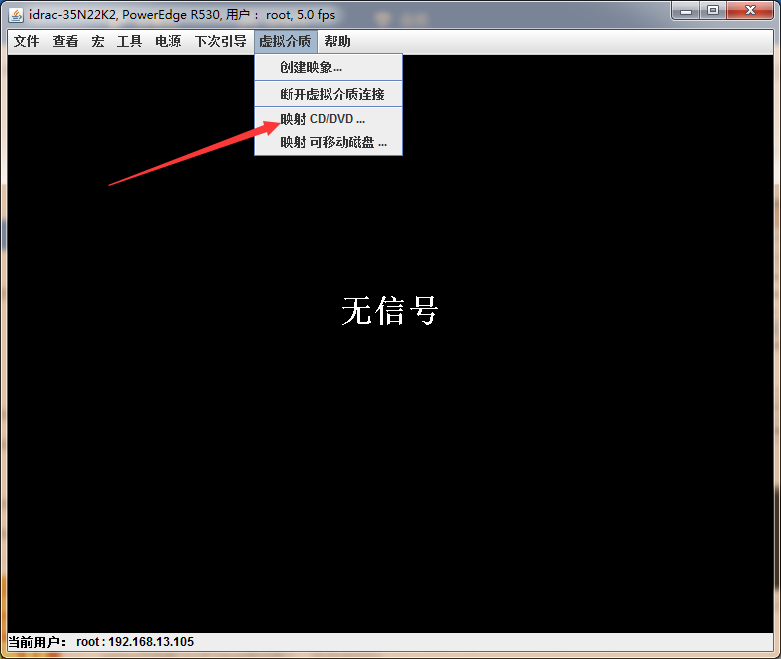

虚拟控制台--->虚拟介质选项卡--->连接虚拟介质--->映射CD/DVD...--->弹出窗口选择--->OK

图15:此处单击“连接虚拟介质”之后才会出现图16中的两个"映射XXXX"条目

图16:

图17:

图18:

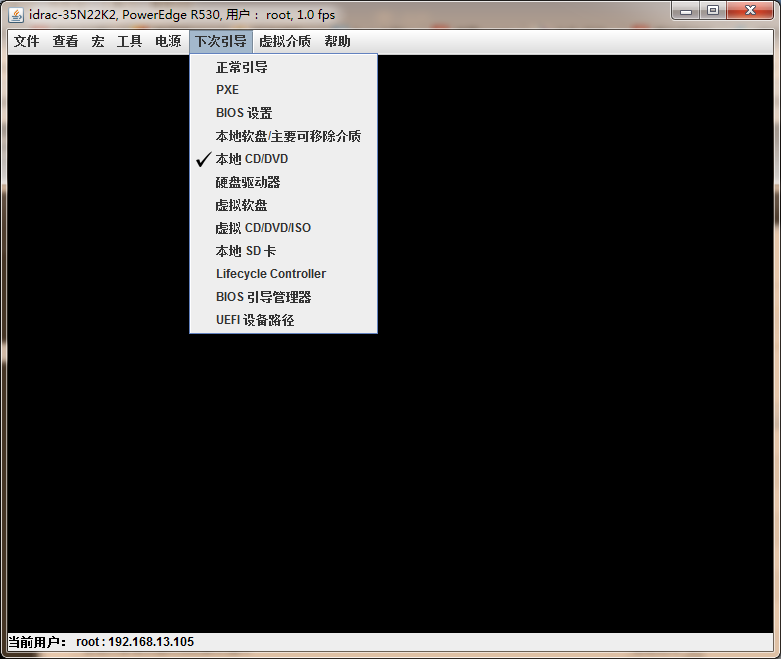

“下次引导”选项卡选择如下(好像选择"虚拟CD/DVD/ISO"也可以,但我这里使用的截图中所示),餐后重启服务器:

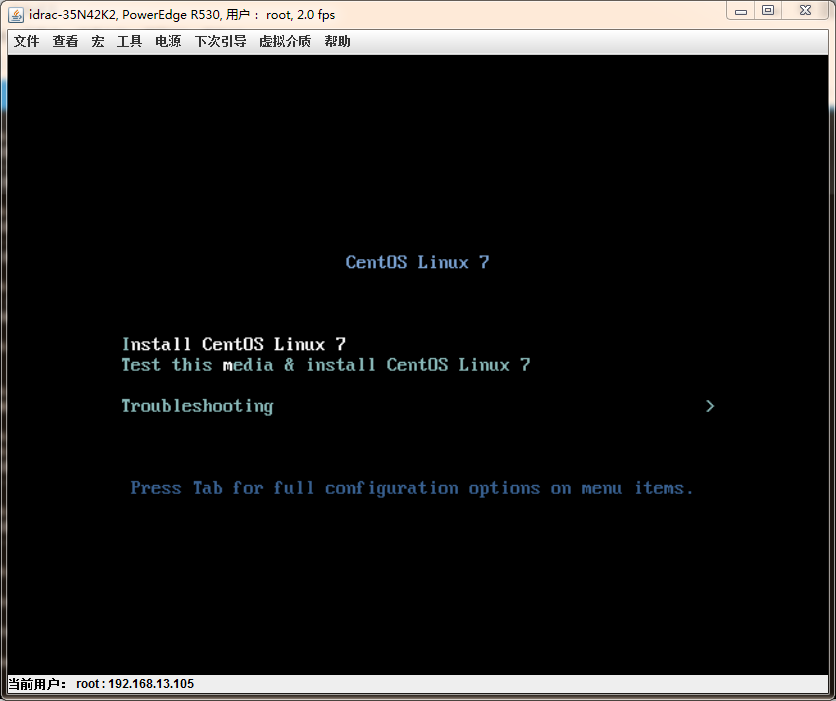

下图回车之后要等待大概一两分钟吧:

图19:

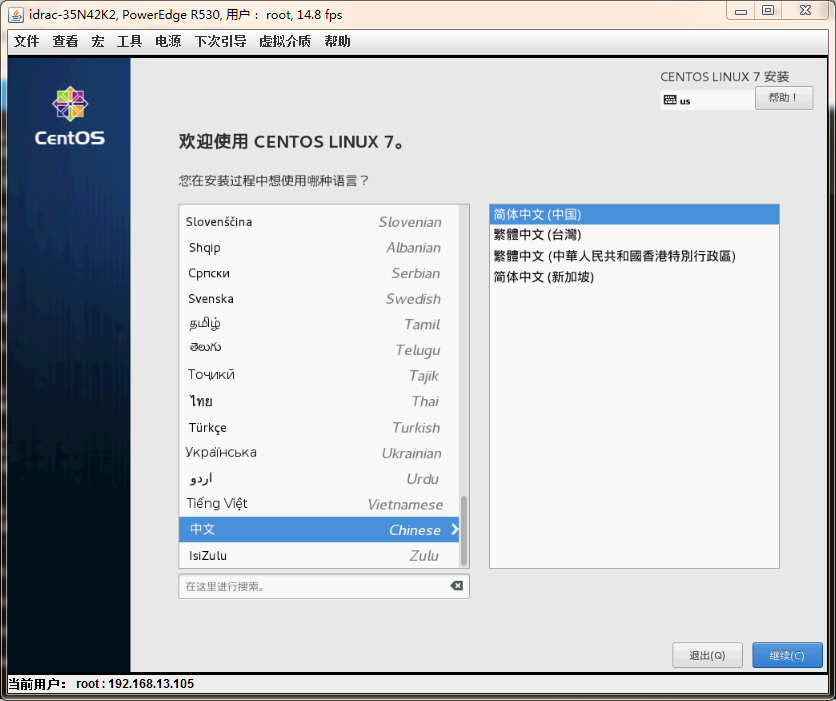

图20:

图21:

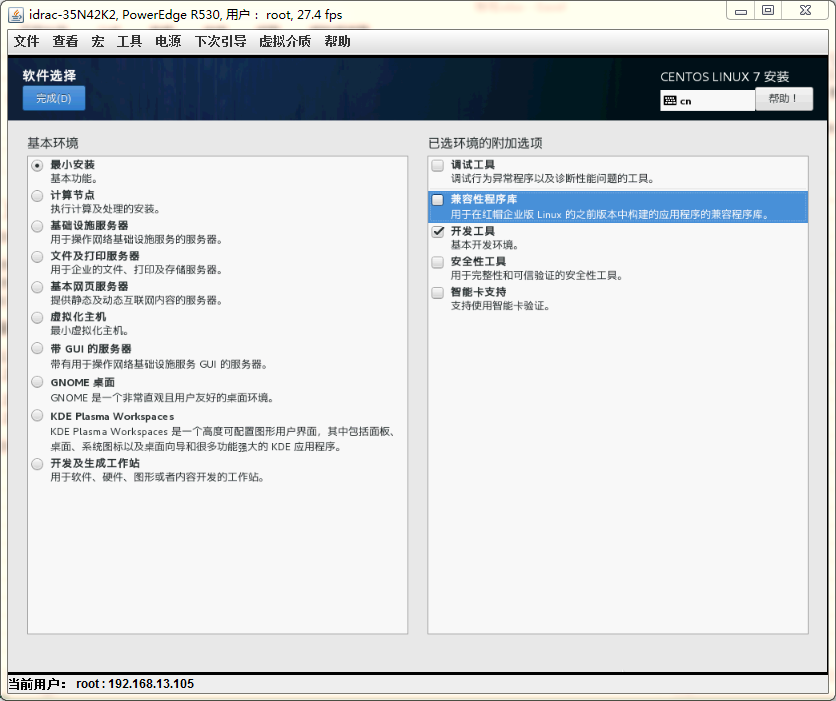

图22:

图23:

图24:

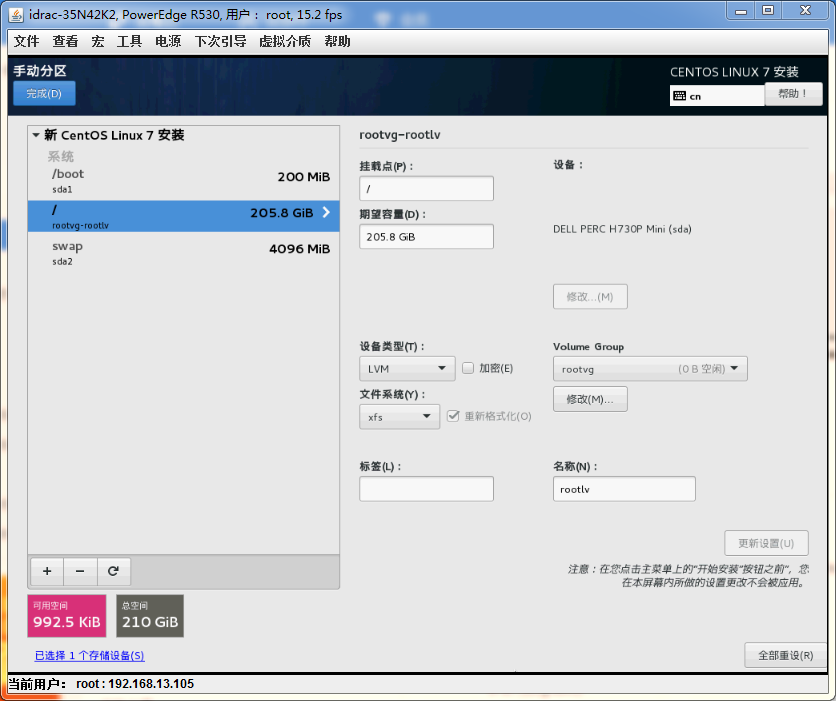

这里将最小的VD(210G)作为根文件系统的安装磁盘,其他的两个VD都作为数据盘来使用;

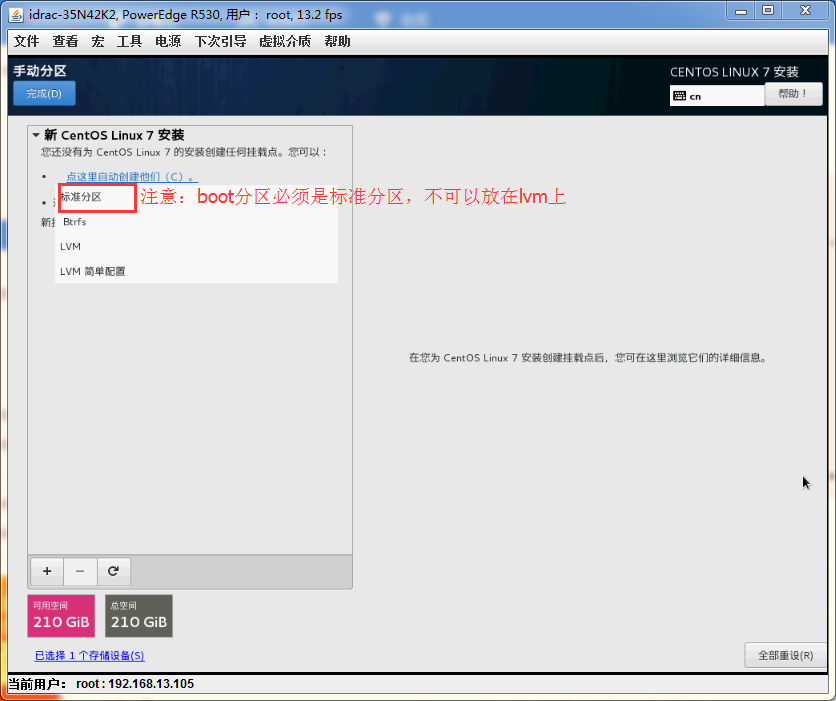

图25:分区格式化

以下为分区信息:

图26:

开始安装即可;等待操作系统安装完成;

到此服务器操作系统安装完成;

三,系统初始配置

1,配置网络

当前环境是只有em3物理网卡接了网线,这一步配置是为了配置好之后可以使用xshell通过ssh连接过去,来使用复制粘贴功能,方便操作:

(1)配置网卡

# cd /etc/sysconfig/network-scripts/

# vi ./ifcfg-em3

TYPE=Ethernet

BOOTPROTO=static

DEFROUTE=yes

PEERDNS=no

PEERROUTES=no

IPV4_FAILURE_FATAL=no

IPV6INIT=no

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=em3

#UUID=c678fab3-a456-4a28-975c-52708fe32600

DEVICE=em3

ONBOOT=yes

IPADDR=10.1.73.11

NETMAK=255.255.255.0

GATEWAY=10.1.73.1

NM_CONTROLLED=no

# systemctl restart network

# ip a

4: em3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP qlen 1000

link/ether 18:66:da:a7:73:72 brd ff:ff:ff:ff:ff:ff

inet 10.1.73.11/24 brd 10.255.255.255 scope global em3

(2)配置宿主机的主机名:

# hostnamectl set-hostname host1

(3)配置DNS服务器(根据需要进行配置)

!!!ip地址配置好之后则通过xshell连接到物理机上,进行下面的操作:

2,数据盘分区格式化:

(1)查看本地磁盘列表

# fdisk -l

(2)分区,使用parted命令:

# parted /dev/sdb

(parted) mklabel gpt

(parted) mkpart primary 0% 100%

(parted) print

(parted) set 1 lvm on------这一步相当于fdisk里面修改设备ID一步,也就是改成LVM的标识8e

(parted) quit

# cat /proc/partitions

# partprobe

(3)LVM创建:

# pvcreate /dev/sdb1

# vgcreate -s 4M datavg /dev/sdb1

# vgdisplay----这里目的是查看卷组包含的PE数量,用在下面一条命令中;

# lvcreate -l 137663 -n datalv datavg

# lvdisplay

# mkfs -t xfs /dev/datavg/datalv

meta-data=/dev/datavg/datalv isize=512 agcount=4, agsize=117963776 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=471855104, imaxpct=5

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=230398, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

3,挂载数据盘及配置自动挂载:

# mkdir /data

# mount -t xfs /dev/datavg/datalv /data

# df -h

文件系统 容量 已用 可用 已用% 挂载点

/dev/mapper/datavg-datalv 1.8T 33M 1.8T 1% /data

# blkid---查看设备的UUID,用来配置fstab文件

/dev/mapper/datavg-datalv: UUID="c976ae32-4a79-4e31-acda-7c3d1cb2ff98" TYPE="xfs"

# vi /etc/fstab

/dev/mapper/rootvg-rootlv / xfs defaults 0 0

UUID=2c0fc1ac-f29b-4b4c-85f3-bdac63abde36 /boot xfs defaults 0 0

UUID=47cc4cf1-2fa1-4c28-8707-16b017ed020b swap swap defaults 0 0

UUID=c976ae32-4a79-4e31-acda-7c3d1cb2ff98 /data xfs defaults 0 0

测试是否生效正常:

# mount -a

4,创建数据盘下的目录结构:

# mkdir -pv /data/kvm/{imgs,os,templates}

# mkdir -pv /data/{scripts,src}

5,上传文件

上传ISO系统镜像到

/data/kvm/os目录下,作为本地yum源以及创建第一台虚拟机安装操作系统使用;

上传所有的组件安装包和配置模板到

/data/src/目录下;

上传shell脚本到

/data/scripts目录下;

6,系统初始化配置

第一步:

# sh -x /data/scripts/osInit_centos7.sh

第二步:

# sh -x /data/scripts/sshUpdate_centos7.sh

7,配置本地yum源(可选)

注意:务必确保有yum源可以正常使用。

# mkdir -pv /media/cdrom

# mount -t iso9660 -o loop /data/kvm/os/CentOS-7-x86_64-DVD-1611.iso /media/cdrom

# sed -i '$a\/data/kvm/os/CentOS-7-x86_64-DVD-1611.iso /media/cdrom iso9660 defaults,ro,loop 0 0' /etc/fstab

# mount -a

# cd /etc/yum.repos.d/

# for i in $(ls);do mv ./$i ./${i}.bak;done

# cat > /etc/yum.repos.d/CentOS-Local.repo <<EOF

[local]

name=CentOS7.3.1611

baseurl=file:///media/cdrom

enabled=1

gpgcheck=0

EOF

# yum repolist

四,搭建kvm虚拟化环境:

# lsmod | grep -i kvm

kvm_intel 170181 0

kvm 554609 1 kvm_intel

irqbypass 13503 1 kvm

# egrep -i "vmx|svm" /proc/cpuinfo

# yum install qemu-kvm qemu-kvm-tools libvirt virt-install virt-manager virt-top

# ln -sv /usr/libexec/qemu-kvm /usr/sbin/

# 宿主机网络配置:注意这里配置的br0和em3的UUID是一样的,重启network也没有报错,一切正常;

# cd /etc/sysconfig/nework-scripts/

# cp ./ifcfg-em3 ./ifcfg-em3.bak

# cp ./ifcfg-em3 ./ifcfg-br0

# vi ./ifcfg-br0

TYPE=Bridge

BOOTPROTO=static

DEFROUTE=yes

PEERDNS=no

PEERROUTES=no

IPV4_FAILURE_FATAL=no

IPV6INIT=no

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=br0

#UUID=8630451e-dfc8-45ca-9a3d-f43a520bc0b2

DEVICE=br0

ONBOOT=yes

IPADDR=10.1.73.11

NETMAK=255.255.255.0

GATEWAY=10.1.73.1

NM_CONTROLLED=no

# vi ./ifcfg-em3

TYPE=Ethernet

BOOTPROTO=static

DEFROUTE=yes

PEERDNS=no

PEERROUTES=no

IPV4_FAILURE_FATAL=no

IPV6INIT=no

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=em3

#UUID=8630451e-dfc8-45ca-9a3d-f43a520bc0b2

DEVICE=em3

ONBOOT=yes

NM_CONTROLLED=no

BRIDGE=br0

# systemctl restart network

# systemctl start libvirtd

# ps -ef | grep libvirt

# ip a

7: virbr0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN qlen 1000

link/ether 52:54:00:40:ec:a9 brd ff:ff:ff:ff:ff:ff

inet 192.168.122.1/24 brd 192.168.122.255 scope global virbr0

valid_lft forever preferred_lft forever

8: virbr0-nic: <BROADCAST,MULTICAST> mtu 1500 qdisc pfifo_fast master virbr0 state DOWN qlen 1000

link/ether 52:54:00:40:ec:a9 brd ff:ff:ff:ff:ff:ff

第一次启动libvirtd服务的时候,总是会创建这么一个virbr0和virtbr0-nic设备,如果你之前手动创建的或者配置文件中配置的名字也是virbr0,那么启动libvirtd就不会创建了,这一点需要注意;

可以先不用管它,也可以直接删掉:

# brctl show

# virsh net-list --all

名称 状态 自动开始 持久

----------------------------------------------------------

default 活动 是 是

# virsh net-destroy default

网络 default 被删除

# virsh net-undefine default

网络 default 已经被取消定义

# systemctl restart libvirtd.service

# virsh net-list --all

名称 状态 自动开始 持久

----------------------------------------------------------

到此,kvm虚拟化环境就准备好了,接下来的事情就是创建虚拟机了;

此博客为原创,所有文字都是博主自己逐个敲的,图片也都是博主自己截的屏幕,若转载请注明出处。