环境

Linux:Centos Linux 7.3

JDK:jdk1.8.0_181

Hadoop:2.8.5

Zookeeper:3.4.13

服务器

bigdata01:192.168.1.50 (主节点)

bigdata02:192.168.1.51

bigdata03:192.168.1.52

安装步骤

1,下载zookeeper安装包,我下载的是zookeeper-3.4.13.tar.gz。

2,将安装包上传到linux服务器,我是放在/opt目录下面,然后解压。

tar -zvxf zookeeper-3.4.13.tar.gz

3,进入zookeeper目录,创建data和logs两个目录用于存储数据和日志。

mkdir data

mkdir logs

4,进入zookeeper的conf目录,将zoo_sample.cfg重命名为zoo.cfg,修改后zookeeper便可以识别到该文件。

mv zoo_sample.cfg zoo.cfg

5,编辑zoo.cfg文件,配置如下:

# The number of milliseconds of each tick

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

dataDir=/opt/zookeeper-3.4.13/data

dataLogDir=/opt/zookeeper-3.4.13/logs

# the port at which the clients will connect

clientPort=2181

# the maximum number of client connections.

# increase this if you need to handle more clients

#maxClientCnxns=60

#

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

#

# http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

#

# The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

#autopurge.purgeInterval=1

server.1=bigdata01:2888:3888

server.2=bigdata02:2888:3888

server.3=bigdata03:2888:3888

tickTime:发送心跳的间隔时间,单位:毫秒

initLimit:leader和follower初始化连接时最长能忍受多少个心跳时间的间隔数

syncLimit:leader和follower之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime的时间长度

dataDir:zookeeper保存数据的目录

dataLogDir:zookeeper保存日志的目录

clientPort:端口

server.1、server.2、server.3是zookeeper机器列表,server.order这里的Order依据集群的机器个数依次进行递增,这里的bigdata01、bigdata02、bigdata03表示机器的主机名

6,配置完成后,切换到刚才配置的dataDir下,在此目录下新建一个myid文件。

vim myid

文件中只需要输入一个数字“1”,这个数字与配置文件中的order保持一致,zookeeper会根据该文件来决定zookeeper集群各个机器的身份分配。

7,将配置好的zookeeper分发到bigdata02和bigdata03。

scp -r zookeeper-3.4.13 root@bigdata02:/opt

scp -r zookeeper-3.4.13 root@bigdata03:/opt

8,修改bigdata02和bigdata03上zookeeper中data目录下的myid文件,将文件中的值改成2和3,与配置文件中的order保持一致。

9,进入zookeeper的bin目录,启动三台机器上的zookeeper。

./zkServer.sh start

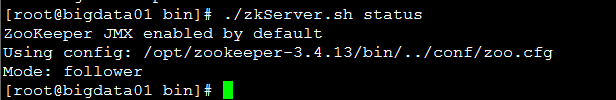

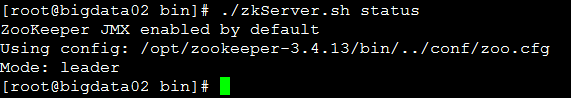

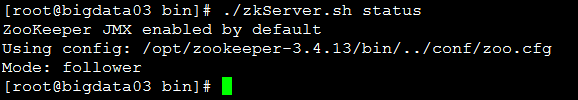

10,查看zookeeper身份

./zkServer.sh status