Sina Weibo:小锋子Shawn

Tencent E-mail:[email protected]

http://blog.csdn.net/dgyuanshaofeng/article/details/83051697

提出深度注意力特征模块(deep attentional feature modules),充分利用不同层的编码信息,也即各层的特征是“通畅的”,解决TRUS图像前列腺分割。

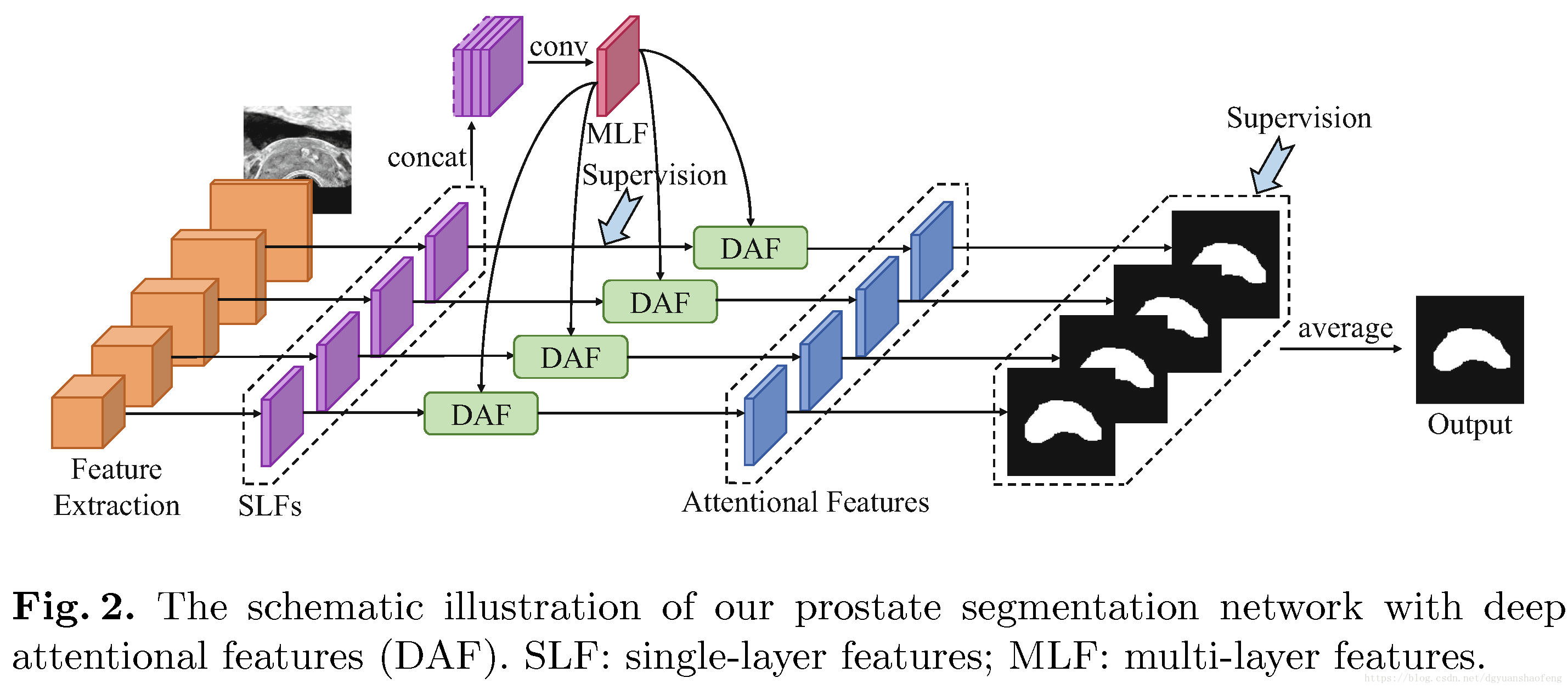

前列腺分割网络如图1所示。TRUS图像通过卷积网络ConvNet得到一系列空间大小不一的特征图,如

。放弃第一个水平的特征图,

经过单层卷积编码得到特征

,然后单层特征

级联起来,经过卷积编码,得到特征

。深度注意力特征模块DAF接收

和对应的

作为输入,输出注意力特征,利用深度监督机制

监督各层学习并输出多层分割结果,最终通过平均(概率)获得最后分割结果。

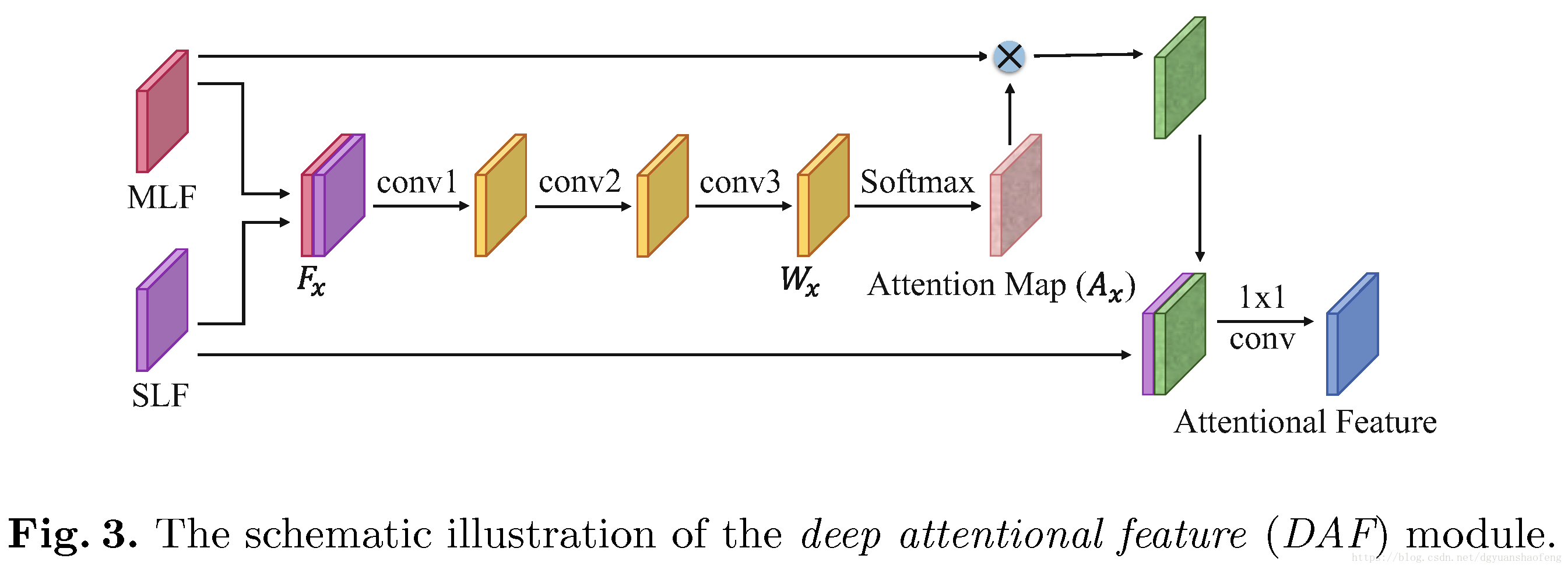

深度注意力特征模块如图2所示,计算过程很清楚。

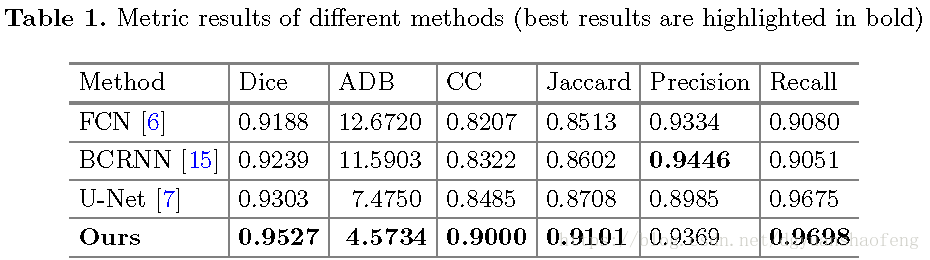

量化结果如图3所示。比较对象是复杂的BCRNN和两种经典全卷积网络FCN、U-Net,说明所提出方法的性能十分优越。值得细想的是,BCRNN算法居然比不过U-Net。另外,所提出方法使用了ResNeXt-101作为骨干网络,与FCN和U-Net比较,当然性能自然不会差,甚至去掉DAF模块,性能还不一定比FCN和U-Net差。所以比较的公平性和证明模块的有效性,在这里就很不明白了。另外,已经有MSRA的学者验证过,采用牛逼的骨干网络,其他乱七八糟的骚操作都是多余的,可以看看文献[2],残差网络加反卷积,轻松虐堆叠沙漏网络。

[1] Deep Attentional Features for Prostate Segmentation in Ultrasound MICCAI 2018 [paper]

[2] Simple Baselines for Human Pose Estimation and Tracking ECCV 2018 [paper]