nginx实现反向代理及负载均衡 转自https://blog.csdn.net/u013144287/article/details/78551398

一、反向代理

1.什么是反向代理

通常的代理服务器,只用于代理内部网络对Internet的连接请求,客户机必须指定代理服务器,并将本来要直接发送到Web服务器上的http请求发送到代理服务器中由代理服务器向Internet上的web服务器发起请求,最终达到客户机上网的目的(也就是正向代理)。

而反向代理(Reverse Proxy)方式是指以代理服务器来接受internet上的连接请求,然后将请求转发给内部网络上的服务器,并将从服务器上得到的结果返回给internet上请求连接的客户端,此时代理服务器对外就表现为一个反向代理服务器。

如下图:

Nginx只做请求的转发,后台有多个http服务器提供服务,nginx的功能就是把请求转发给后面的服务器,决定把请求转发给谁。

2、安装tomcat2个,现在我们模拟的话服务器就采用tomcat来模拟。

安装tomcat的过程就不介绍了,在http://blog.csdn.net/u013144287/article/details/78499485过程中有介绍,

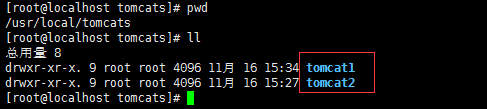

(1)创建一个tomcat目录mkdir -p /usr/local/tomcats

在此目录下安装两个tomcat如图所示:

(2)修改tomcat2的端口号,vi ./tomcat2/conf/server.xml

<Server port="8006" shutdown="SHUTDOWN">

-

<Connector port="8081" protocol="HTTP/1.1" -

connectionTimeout="20000" -

redirectPort="8443" />

<Connector port="8010" protocol="AJP/1.3" redirectPort="8443" />修改此3处端口号,分别在原来基础上加1,然后wq保存,启动两台tomcat

3、需求

nginx的安装可以参考http://blog.csdn.net/u013144287/article/details/78408001此篇文章

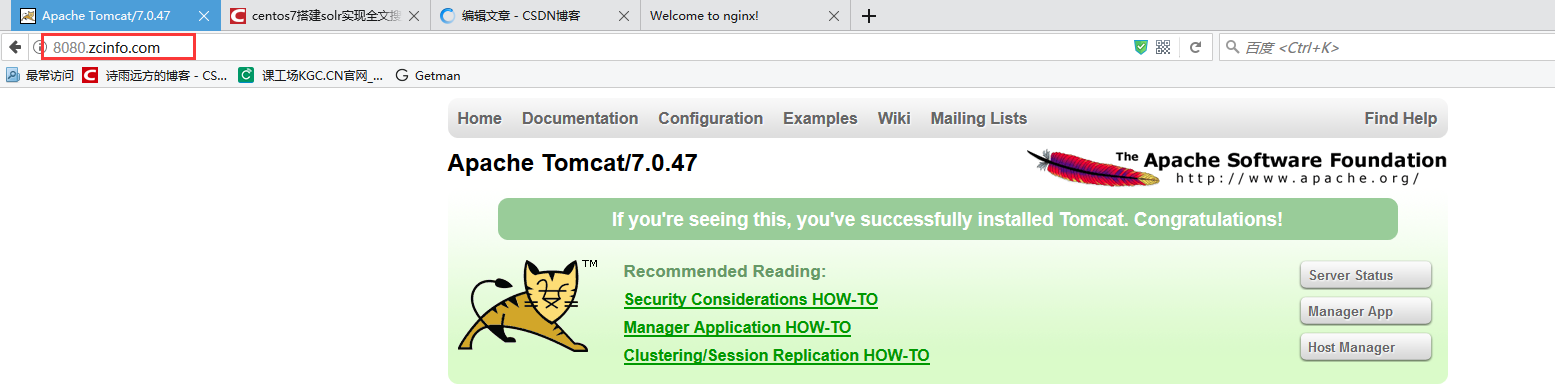

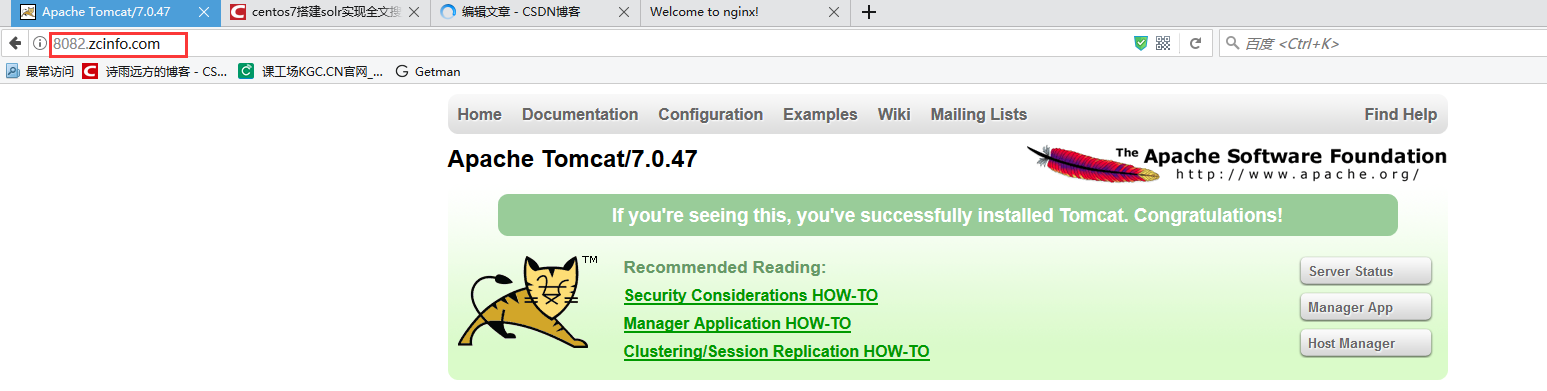

通过访问不同的域名访问运行在tomcat不同端口的服务器,中间使用nginx反向代理服务器

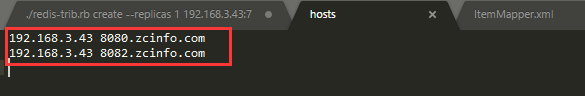

windows上访问需要修改hosts文件进行配置如下:

8080.zcinfo.com 访问运行8080端口的tomcat

8082.zcinfo.com 访问运行8081端口的tomcat

如图所示:hosts目录是:C:\Windows\System32\drivers\etc

4、Nginx的配置

在Nginx的配置文件里面加入如下配置

-

upstream tomcatserver1 { -

server 192.168.3.43:8080; -

} -

upstream tomcatserver2 { -

server 192.168.3.43:8082; -

} -

server { -

listen 80; -

server_name 8080.zcinfo.com; -

#charset koi8-r; -

#access_log logs/host.access.log main; -

location / { -

proxy_pass http://tomcatserver1; -

index index.html index.htm; -

} -

} -

server { -

listen 80; -

server_name 8082.zcinfo.com; -

#charset koi8-r; -

#access_log logs/host.access.log main; -

location / { -

proxy_pass http://tomcatserver2; -

index index.html index.htm; -

} -

}

重启nginx

ps:如果在同一个域名下有多台服务器提供服务,此时需要nginx负载均衡。

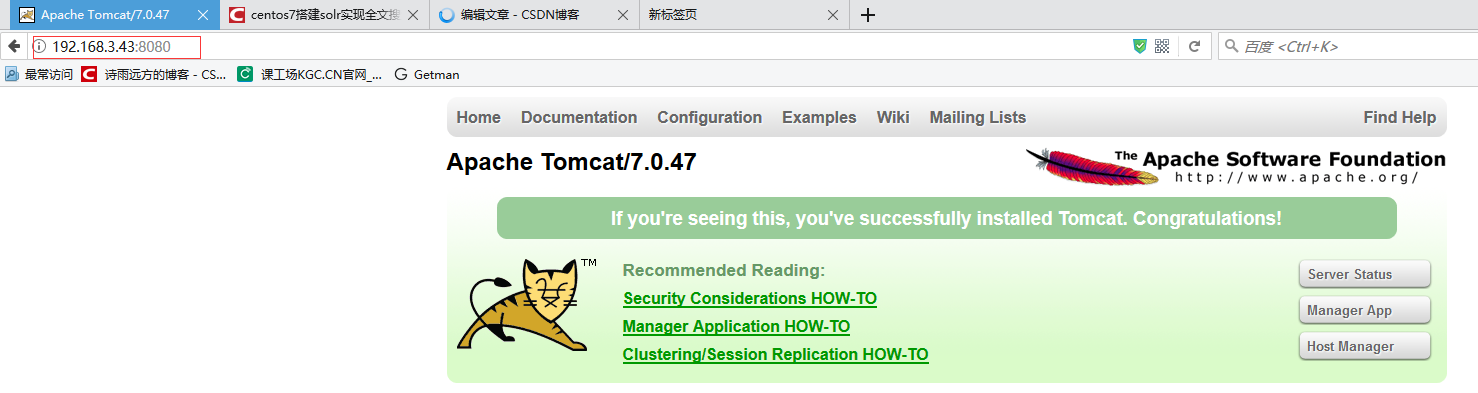

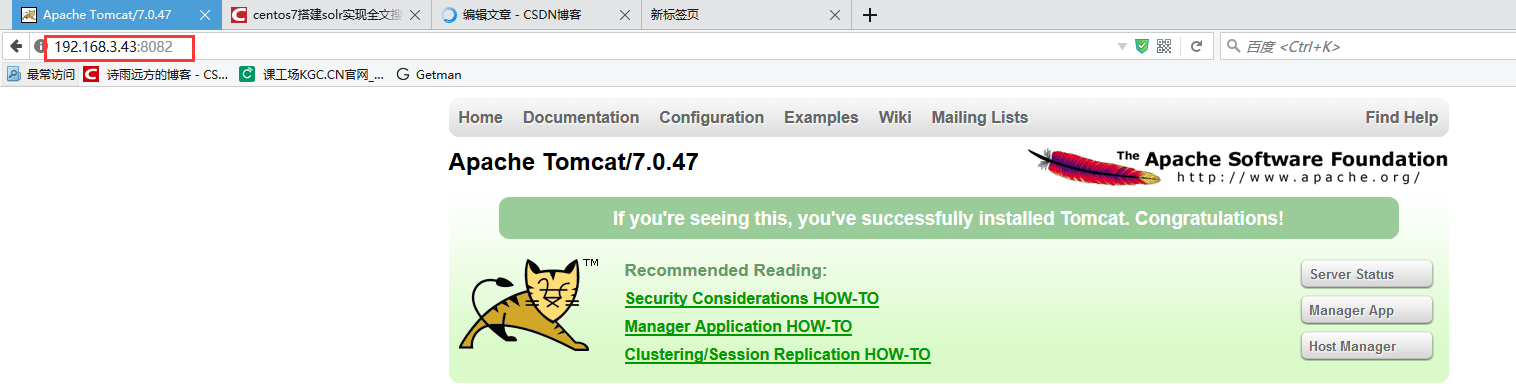

5、测试

至此恭喜您,nginx反向代理成功

二、负载均衡

1、什么是负载均衡?

负载均衡建立在现有网络结构之上,它提供了一种廉价有效透明的方法扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。

负载均衡,英文名称为Load Balance,其意思就是分摊到多个操作单元上进行执行,例如Web服务器、FTP服务器、企业关键应用服务器和其它关键任务服务器等,从而共同完成工作任务。

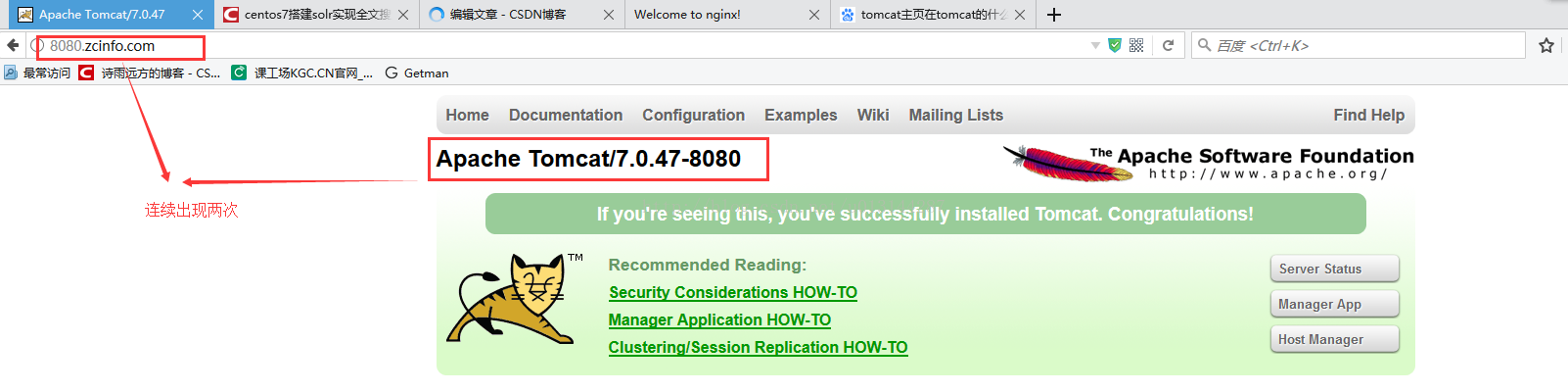

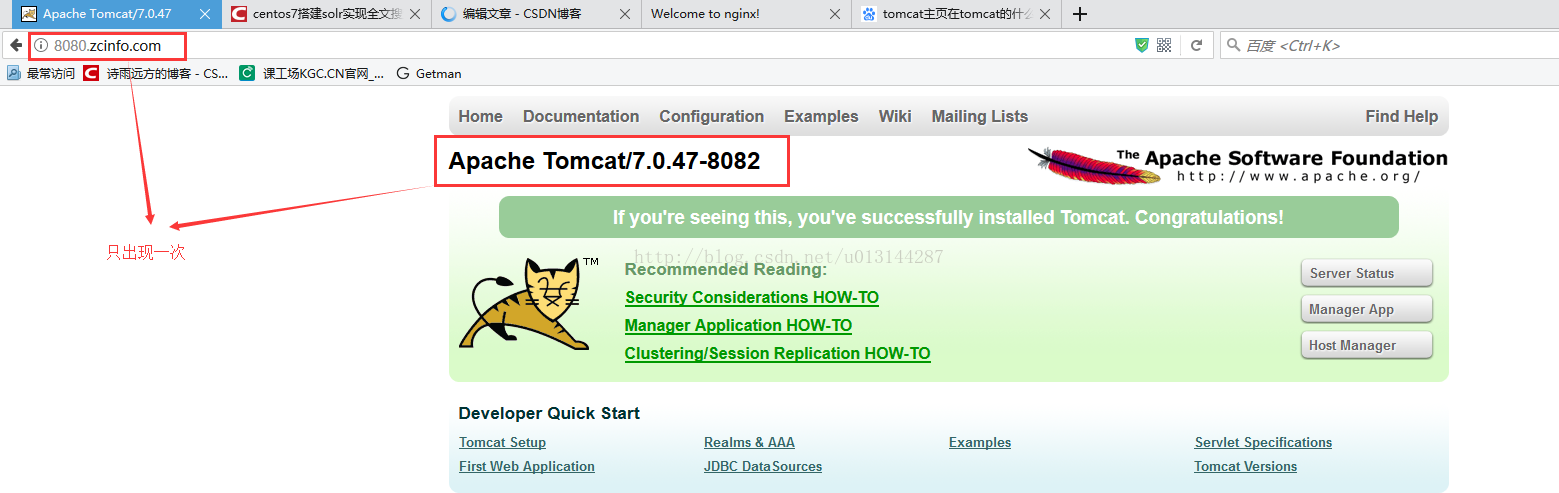

2、需求

nginx作为负载均衡服务器,用户请求先到达nginx,再由nginx根据负载配置将请求转发至tomcat服务器。

nginx负载均衡服务器:192.168.3.43

tomcat1服务器:192.168.3.43:8080

tomcat2服务器:192.168.3.43:8081

3、nginx的配置

-

upstream tomcatserver1 { -

server 192.168.3.43:8080; -

server 192.168.3.43:8082; #多加了此台服务器 -

} -

upstream tomcatserver2 { -

server 192.168.3.43:8082; -

} -

server { -

listen 80; -

server_name 8080.zcinfo.com; -

#charset koi8-r; -

#access_log logs/host.access.log main; -

location / { -

proxy_pass http://tomcatserver1; -

index index.html index.htm; -

} -

} -

server { -

listen 80; -

server_name 8082.zcinfo.com; -

#charset koi8-r; -

#access_log logs/host.access.log main; -

location / { -

proxy_pass http://tomcatserver2; -

index index.html index.htm; -

} -

}

如果两台服务器性能差不多这样设置重启nginx就行了,但是现在假如两台服务器性能不一样,还需要设置性能权重,让性能高服务器做更多事情。只需要加入weight=?就行了,如下:

-

upstream tomcatserver1 { -

server 192.168.3.43:8080 weight=2; -

server 192.168.3.43:8082 weight=1; -

} -

upstream tomcatserver2 { -

server 192.168.3.43:8082; -

} -

server { -

listen 80; -

server_name 8080.zcinfo.com; -

#charset koi8-r; -

#access_log logs/host.access.log main; -

location / { -

proxy_pass http://tomcatserver1; -

index index.html index.htm; -

} -

} -

server { -

listen 80; -

server_name 8082.zcinfo.com; -

#charset koi8-r; -

#access_log logs/host.access.log main; -

location / { -

proxy_pass http://tomcatserver2; -

index index.html index.htm; -

} -

}

重新启动nginx,会发现8080出现了两次,8082出现一次这样轮循。

ps:关于nginx负载均衡的一些参数介绍例子

-

节点说明: -

在http节点里添加: -

#定义负载均衡设备的 Ip及设备状态 -

upstream myServer { -

server 127.0.0.1:9090 down; -

server 127.0.0.1:8080 weight=2; -

server 127.0.0.1:6060; -

server 127.0.0.1:7070 backup; -

} -

在需要使用负载的Server节点下添加 -

proxy_pass http://myServer; -

upstream 每个设备的状态: -

down 表示单前的server暂时不参与负载 -

weight 默认为1.weight越大,负载的权重就越大。 -

max_fails :允许请求失败的次数默认为1.当超过最大次数时,返回proxy_next_upstream 模块定义的错误 -

fail_timeout:max_fails 次失败后,暂停的时间。 -

backup: 其它所有的非backup机器down或者忙的时候,请求backup机器。所以这台机器压力会最轻。

4、效果

至此,恭喜您,nginx反向代理和负载均衡搭建成功

nginx支持的负载均衡调度算法方式如下:

-

weight轮询(默认):接收到的请求按照顺序逐一分配到不同的后端服务器,即使在使用过程中,某一台后端服务器宕机,nginx会自动将该服务器剔除出队列,请求受理情况不会受到任何影响。 这种方式下,可以给不同的后端服务器设置一个权重值(weight),用于调整不同的服务器上请求的分配率;权重数据越大,被分配到请求的几率越大;该权重值,主要是针对实际工作环境中不同的后端服务器硬件配置进行调整的。

-

ip_hash:每个请求按照发起客户端的ip的hash结果进行匹配,这样的算法下一个固定ip地址的客户端总会访问到同一个后端服务器,这也在一定程度上解决了集群部署环境下session共享的问题。

-

fair:智能调整调度算法,动态的根据后端服务器的请求处理到响应的时间进行均衡分配,响应时间短处理效率高的服务器分配到请求的概率高,响应时间长处理效率低的服务器分配到的请求少;结合了前两者的优点的一种调度算法。但是需要注意的是nginx默认不支持fair算法,如果要使用这种调度算法,请安装upstream_fair模块

-

url_hash:按照访问的url的hash结果分配请求,每个请求的url会指向后端固定的某个服务器,可以在nginx作为静态服务器的情况下提高缓存效率。同样要注意nginx默认不支持这种调度算法,要使用的话需要安装nginx的hash软件包

--------------------- 本文来自 Sugar执着 的CSDN 博客 ,全文地址请点击:https://blog.csdn.net/tsummerb/article/details/79248015?utm_source=copy

配置项:

1、轮询

轮询是upstream的默认分配方式,即每个请求按照时间顺序轮流分配到不同的后端服务器,如果某个后端服务器down掉后,能自动剔除。

upstream backend {

server 192.168.1.101:8888;

server 192.168.1.102:8888;

server 192.168.1.103:8888;

}

2、weight

轮询的加强版,即可以指定轮询比率,weight和访问几率成正比,主要应用于后端服务器异质的场景下。

upstream backend {

server 192.168.1.101 weight=1;

server 192.168.1.102 weight=2;

server 192.168.1.103 weight=3;

}

3、ip_hash

每个请求按照访问ip(即Nginx的前置服务器或者客户端IP)的hash结果分配,这样每个访客会固定访问一个后端服务器,可以解决session一致问题。

upstream backend {

ip_hash;

server 192.168.1.101:7777;

server 192.168.1.102:8888;

server 192.168.1.103:9999;

}

4、fair

fair顾名思义,公平地按照后端服务器的响应时间(rt)来分配请求,响应时间短即rt小的后端服务器优先分配请求。

upstream backend {

server 192.168.1.101;

server 192.168.1.102;

server 192.168.1.103;

fair;

}

5、url_hash

与ip_hash类似,但是按照访问url的hash结果来分配请求,使得每个url定向到同一个后端服务器,主要应用于后端服务器为缓存时的场景下。

upstream backend {

server 192.168.1.101;

server 192.168.1.102;

server 192.168.1.103;

hash $request_uri;

hash_method crc32;

}

其中,hash_method为使用的hash算法,需要注意的是:此时,server语句中不能加weight等参数。

关于,如何在负载均衡中使用upstream请参看这里。 --------------------- 本文来自 Aissen0311 的CSDN 博客 ,全文地址请点击:https://blog.csdn.net/clf0311/article/details/71124722?utm_source=copy