版权声明:个人博客网址 https://29dch.github.io/ 博主GitHub网址 https://github.com/29DCH,欢迎大家前来交流探讨和fork! https://blog.csdn.net/CowBoySoBusy/article/details/82917495

采用idea+Maven,添加相关的HDFS依赖

pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>HDFS_Test</groupId>

<artifactId>HDFS_Test</artifactId>

<version>1.0-SNAPSHOT</version>

<name>HDFS_Test</name>

<url>http://maven.apache.org</url>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<hadoop.version>2.6.0-cdh5.7.0</hadoop.version>

</properties>

<repositories>

<repository>

<id>cloudera</id>

<url>https://repository.cloudera.com/artifactory/cloudera-repos/</url>

</repository>

</repositories>

<dependencies>

<!--添加hadoop依赖-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop.version}</version>

</dependency>

<!--添加单元测试的依赖-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.10</version>

<scope>test</scope>

</dependency>

</dependencies>

</project>

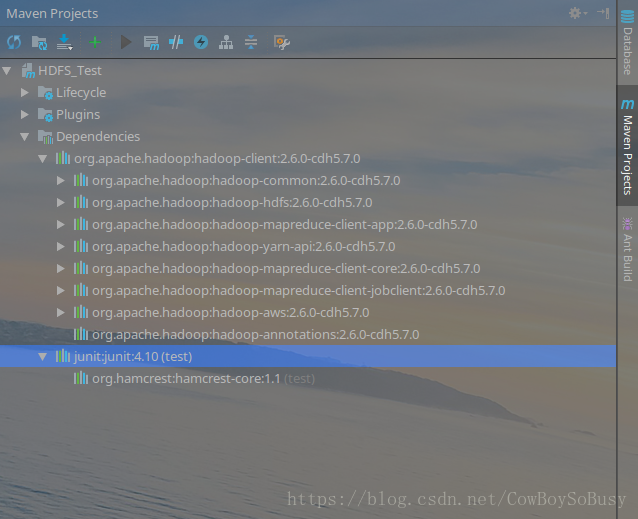

idea的Maven工程在第一次引入这个依赖的时候可能花费一定的时间

完成以后如下所示:

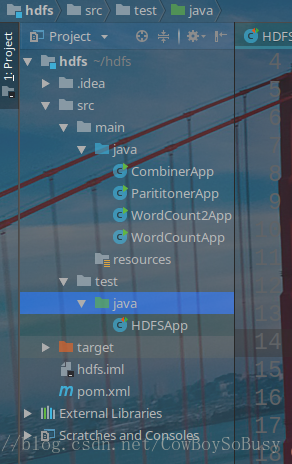

项目结构:

java API操作代码

HDFSApp.java

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.util.Progressable;

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import java.io.BufferedInputStream;

import java.io.File;

import java.io.FileInputStream;

import java.io.InputStream;

import java.net.URI;

/**

* Hadoop HDFS Java API 操作

*/

public class HDFSApp {

public static final String HDFS_PATH = "hdfs://zq:8020";

FileSystem fileSystem = null;

Configuration configuration = null;

/**

* 创建HDFS目录

*/

@Test

public void mkdir() throws Exception {

fileSystem.mkdirs(new Path("/hdfsapi/test"));

}

/**

* 创建文件

*/

@Test

public void create() throws Exception {

FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/a.txt"));

output.write("hello hadoop".getBytes());

/**

* FsDataOutputStream.hflus(); //清理客户端缓冲区数据,被其他client立即可见

* FsDataOutputStream.hsync(); //清理客户端缓冲区数据,被其他client不能立即可见

*/

output.flush();

output.close();

}

/**

* 查看HDFS文件的内容

*/

@Test

public void cat() throws Exception {

FSDataInputStream in = fileSystem.open(new Path("/hdfsapi/test/a.txt"));

IOUtils.copyBytes(in, System.out, 1024);

in.close();

}

/**

* 重命名

*/

@Test

public void rename() throws Exception {

Path oldPath = new Path("/hdfsapi/test/a.txt");

Path newPath = new Path("/hdfsapi/test/b.txt");

fileSystem.rename(oldPath, newPath);

}

/**

* 上传文件到HDFS

*

* @throws Exception

*/

@Test

public void copyFromLocalFile() throws Exception {

Path localPath = new Path("/home/zq/Desktop/data/hello.txt");

Path hdfsPath = new Path("/hdfsapi/test");

fileSystem.copyFromLocalFile(localPath, hdfsPath);

}

/**

* 上传文件到HDFS(带进度条,要想效果明显,上传的文件要大一些)

*/

@Test

public void copyFromLocalFileWithProgress() throws Exception {

InputStream in = new BufferedInputStream(

new FileInputStream(

new File("/home/zq/source/spark-1.6.1/spark-1.6.1-bin-2.6.0-cdh5.5.0.tgz")));

FSDataOutputStream output = fileSystem.create(new Path("/hdfsapi/test/spark-1.6.1.tgz"),

new Progressable() {

public void progress() {

System.out.print("."); //带进度提醒信息

}

});

IOUtils.copyBytes(in, output, 4096);

}

/**

* 下载HDFS文件

*/

@Test

public void copyToLocalFile() throws Exception {

Path localPath = new Path("/home/zq/Desktop/tmp/h.txt");

Path hdfsPath = new Path("/hdfsapi/test/hello.txt");

fileSystem.copyToLocalFile(hdfsPath, localPath);

}

/**

* 查看某个目录下的所有文件

*/

@Test

public void listFiles() throws Exception {

FileStatus[] fileStatuses = fileSystem.listStatus(new Path("/"));

for (FileStatus fileStatus : fileStatuses) {

String isDir = fileStatus.isDirectory() ? "文件夹" : "文件";

//副本系数

short replication = fileStatus.getReplication();

long len = fileStatus.getLen();

String path = fileStatus.getPath().toString();

System.out.println(isDir + "\t" + replication + "\t" + len + "\t" + path);

}

}

/**

* 删除(底层的true参数,代表递归删除)

*/

@Test

public void delete() throws Exception {

fileSystem.delete(new Path("/"), true);

}

@Before

public void setUp() throws Exception {

System.out.println("HDFSApp.setUp");

configuration = new Configuration();

fileSystem = FileSystem.get(new URI(HDFS_PATH), configuration, "zq");

}

@After

public void tearDown() throws Exception {

configuration = null;

fileSystem = null;

System.out.println("HDFSApp.tearDown");

}

}

当"运行查看某个目录下的所有文件"这个Test时输出

HDFSApp.setUp

文件 1 13 hdfs://zq:8020/hello.txt

HDFSApp.tearDown

与 isDir replication len path一一对应

符合我上一篇博客上传的那份文件的信息,详情见我的上一篇博客 https://blog.csdn.net/CowBoySoBusy/article/details/82915357

问题:上上一篇我的博客中在hdfs-site.xml中设置了副本系数为1,但是当目录下的文件数量不为1时,副本系数也不为1

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

解答:

当用hdfs的shell方式的put命令上传时,才采用默认的副本系数1

如果通过像这样的java api操作的话,在本地并没有手工设置副本系数,所以采用的是hadoop自己的副本系数

更多代码以及详细信息见我的github相关项目

https://github.com/29DCH/Hadoop-MapReduce-Examples