今天用scrapy-redis尝试了分布式爬虫,当爬虫结束后你会发现程序不会中断,而是一直在挂起,找了很多地方,一直以为是代码的问题。最后想到分布式爬虫是不断从redis获取爬取的链接,当redis为空时,scrapy只会等待获取redis新的链接,而不会中断程序,故该程序是会不断的运行而不会停止。

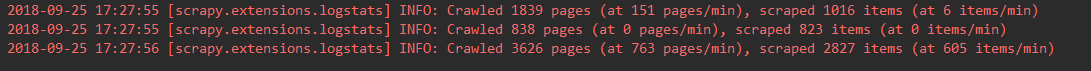

状态如下:

今天用scrapy-redis尝试了分布式爬虫,当爬虫结束后你会发现程序不会中断,而是一直在挂起,找了很多地方,一直以为是代码的问题。最后想到分布式爬虫是不断从redis获取爬取的链接,当redis为空时,scrapy只会等待获取redis新的链接,而不会中断程序,故该程序是会不断的运行而不会停止。

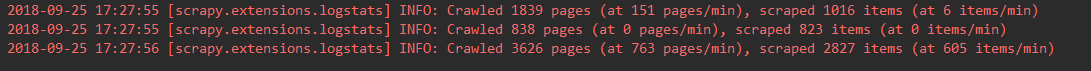

状态如下: