版权声明:本博客都是作者10多年工作总结 https://blog.csdn.net/Peter_Changyb/article/details/82656897

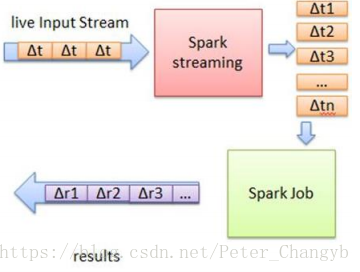

Spark Streaming基本原理:是将流数据分成小的时间片段(几秒),以类似批处理方式来处理这部分小数据。

处理流程:

- Spark Streaming把实时输入数据流以时间片Δt (如1秒)为单位切分成块

- Spark Streaming会把每块数据作为一个RDD,并使用RDD操作处理每一小块数据

- 每个块都会生成一个Spark Job处理

- 最终结果也返回多块

Spark Streaming是建立在Spark上的实时计算框架,通过它提供丰富的API、基于内存的高速执行引擎,用户可以结合流式、批处理和交互试查询应用。

- Saprk的低延迟执行引擎(100MS+)可以用于实时处理

- 相比于strom(基于Record),RDD数据更容易做容错。

- 可以与kafka,Flume,ZeroMQ等进行数据源的对接

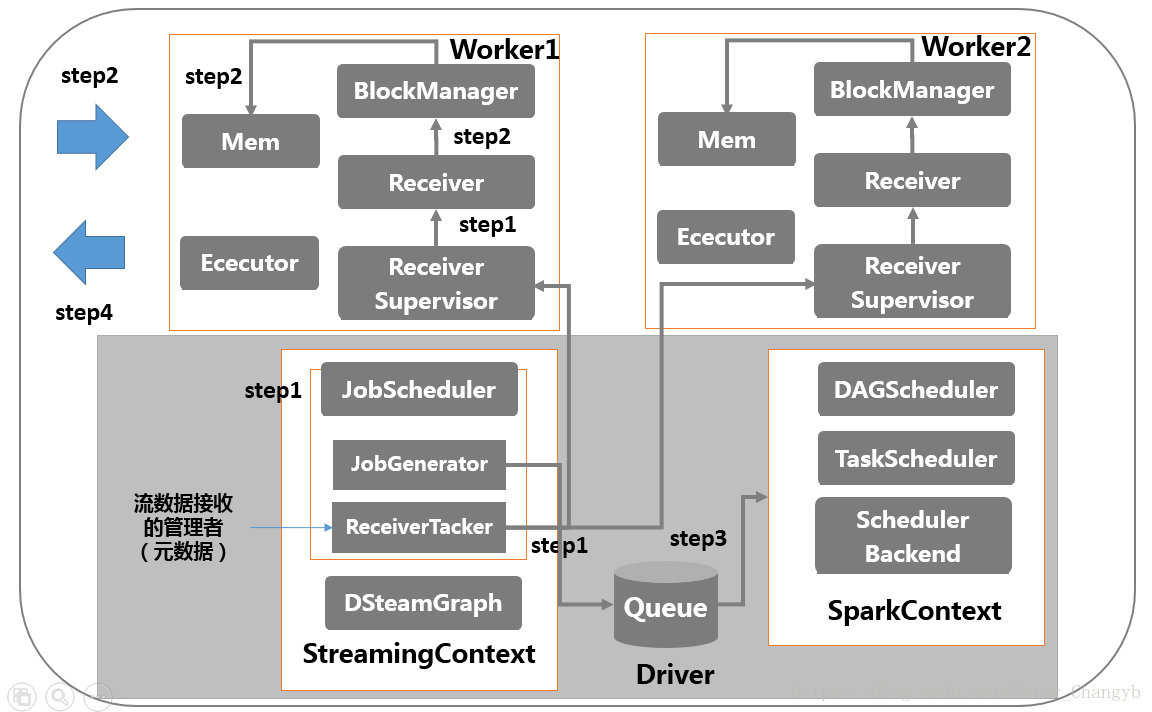

- 先说一下各个组件:SparkStreaming包括Driver和Client端,StreamingContext运行在Driver端,包括如图中的几个进程。

运行步骤如下:

- step1:启动流处理引擎StreamingContext,创建DStreamGraph/JobScheduler(Receiver Tacker管理者),Receiver Tacker通知客户端ReceiverSuperVisor管理者和Receiver干事,要开始接收数据。

- step2:ReceiverSuperVisor通知Receiver写内存或者磁盘,一旦写满,通知Receiver Tacker管理者,提交数据保存位置,把元信息给Receiver Tacker。

- step3:StreamingContext的定时器JobGenerator,通知Receiver Tacker管理者提交数据给集群,并要求DStreamGraph生成作业序号。

- step4:数据处理结果给外部。