马赛克拼图介绍:

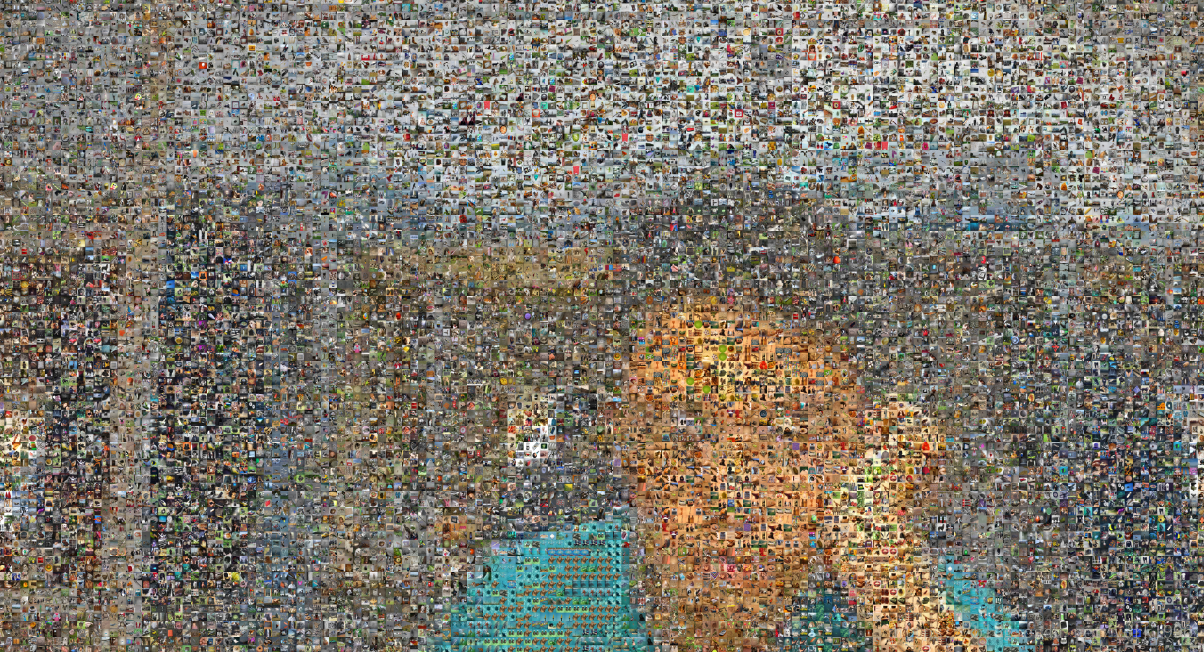

相片马赛克(Photomosaic),或称蒙太奇照片、蒙太奇拼贴,是一种影像处理的艺术技巧,利用这个方式做出来的图片,近看时是由许多张小照片合在一起的,但远看时,每张照片透过光影和色彩的微调,组成了一张大图的基本像素,就叫做相片马赛克技巧。最先是由一个美国大学生发明的,但当时限于计算机性能,无法大量应用。(来源于维基百科相片马赛克)

这是最终得到的效果,如果你的图片集不同,或者参数设置不同,效果也会有差别。

目录

基本原理:

对于要绘制的图的每一个像素,都在图像集中找和这个像素RGB值最接近的图像,然后放在这个位置。

下面是我的实现整个工程的步骤:

1,收集图片素材

要做出上述的效果来,首先就需要大量的图片,图片少了,效果肯定不好,容易重复,需要的像素值找不到相近的等等弊端。人工收集图片的话肯定是非常慢的,如果要手工下载图片,那至少要找图片找很多天了。这个时候一般有两个解决途径:

- 爬取图片

用网络爬虫从别的网站上爬取图片是个不错的选择,也可以用python来实现。

- 下载图片数据集

网络上有别人已经整理好的图像数据集,我使用的是斯坦福大学李飞飞制作的ImageNet数据集。这个数据集是计算机视觉领域常用的一种数据集,它的训练集大概有100多个G,测试集有10多个G,只是测试集就有10万张图片,够本工程使用了。所以我下载的是他的测试集。网速快的话可以十来分钟就下载下来。图片数据集的迅雷下载链接

2,图片预处理

由于每张图片的大小不一致,拼图的时候不好处理,所以首先用OpenCV读取每个图片,再把它们的大小都改为100*100。一次更改,使用多次。代码如下:

#coding=utf-8

import os#和文件有关的模块

import cv2#OpenCV

#这里是10万张图片所在的文件夹,你可以按照你的路径改下面的代码。另外路径好像不支持中文字符。

readPath=r"f:\ILSVRC2012_img_test"

#这里是改变大小之后的图片,要保存的路径。save是一个文件夹

savePath=r"f:\save"

#用一个列表保存所有的图片的文件名字

files=os.listdir(readPath)

#n变量用来看到10万张图片的处理进度。

n=0

#遍历所有图片文件们

for file in files:

n+=1

imgPath=readPath+ "\\" + file#构造图片路径

img=cv2.imread(imgPath)#读取图片到内存img变量

img=cv2.resize(img,(100,100))#更改图片的大小

# 更改之后写入文件,方便以后使用。否则你生成一张马赛克就要处理一次10万张图片

cv2.imwrite(savePath+ "\\"+file,img)

print(n)

cv2.waitKey()3,建立索引

建立索引就是保存每张图片出现次数最多的像素值然后保存到文件中。格式为:

文件名称:B,G,R

建立好索引文件之后,就可以知道每个图片和他们最常见的颜色。在使用这些图片的时候,就可以读取整个索引文件,然后定位到图片文件本身。试想一下,如果没有这些索引文件,那么生成一次马赛克拼图就要求一次所有图片的最多像素,太多冗余了。下面是代码:

import cv2

import os

import collections

readPath=r"f:\save"

files=os.listdir(readPath)

n=0

s=''

for file in files :

li=[]

n+=1

imgPath = readPath + "\\" + file

img=cv2.imread(imgPath)

for i in range(100):

for j in range(100):

b=img[i,j,0]

g=img[i,j,1]

r=img[i,j,2]

li.append((b,g,r))

most=collections.Counter(li).most_common(1)

s += file

s += ":"

s += str(most[0][0]).replace("(","").replace(")","")

s += "\n"

print(n)

f = open('filename.txt','w')

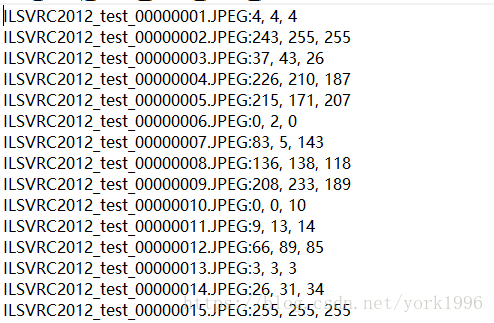

f.write(s)生成的索引文件格式是这样的:

4,画图

首先是读取步骤3生成的索引文件。然后可以选择打乱它,以免一样的图片聚集出现在一个位置附近。

假设目标图片是n*m的,那么新建一个n*100,m*100的图片(这里是100的整数倍是因为刚才把图片集中的每个图片都更改为100*100大小的了)。这是一个很大的图片。对于原图片的每个像素,都遍历索引文件,找到和BGR像素值的欧式距离(你也可以采取其他度量方式,甚至可以找最相近的图片,但这样将导致同图片的聚集,因为相邻的像素值很可能一样的)不大于一个阈值的索引文件中的值,然后根据找到的BGR定位到具体的文件,由文件再读取图片,把图片放到大图上的具体位置。下面是具体代码:

import cv2

import numpy as np

readPath=r"f:\save"

def readIndex():

fs = open("filename.txt","r")

n=0

dic=[]

for line in fs.readlines():

n+=1

temp=line.split(":")

file=temp[0]

bgr=temp[1].split(",")

b=int(bgr[0])

g=int(bgr[1])

r=int(bgr[2])

dic.append((file,(b,g,r)))

return dic

img=cv2.imread("york.jpg")

s=np.shape(img)

big= np.zeros((100*s[0], 100*s[1], 3), dtype=np.uint8)

list=readIndex()#读取索引文件到变量中

for i in range(s[0]):#遍历行和列

for j in range(s[1]):

print(i)

b = img[i, j, 0]

g = img[i, j, 1]

r = img[i, j, 2]#获取图像当前位置的BGR值

np.random.shuffle(list)#打乱索引文件

for item in list:

imgb=item[1][0]

imgg=item[1][1]

imgr=item[1][2]#获取索引文件的RGB值

distance=(imgb-b)**2+(imgg-g)**2+(imgr-r)**2#欧式距离

if distance<100:

filepath=readPath+"\\"+str(item[0])#定位到具体的图片文件

break

little=cv2.imread(filepath)#读取整个最相近的图片

big[i*100:(i+1)*100,j*100:(j+1)*100]=little#把图片画到大图的相应位置

cv2.imwrite("bigYork.jpg",big)#输出大图到文件中大功告成。

下面是我的时间统计:

- 下载图片用了三个多小时

- 图片预处理用了一个多小时

- 建立索引大概需要一个多小时

- 之后画每个一万个像素点左右的图片大概需要三分钟的时间