激活函数

作用:在普通的网络模型中,若未加入激活函数,下一层的输出仅仅只是前一层的线性组合。一个简单的感知机如下:

在未加入激活函数时,X3 = W2*X1 + W1*X2;可类推下一层中某个神经元Y = W1*X1 + W2 * X2 + ... + Wn*Xn;在下一层的网络中的某个神经元Z = W1*Y1 + W2*Y2 + ... + Wn*Yn。由此可知,不管如何设置神经元数目与模型的网络层数,后一层的输出仅为前一层的线性组合。

由此引入激活函数,主要作用如下。

引入非线性因素。

在我们面对线性可分的数据集的时候,简单的用线性分类器即可解决分类问题。但是现实生活中的数据往往不是线性可分的,面对这样的数据,一般有两个方法:引入非线性函数、线性变换。

线性变换

就是把当前特征空间通过一定的线性映射转换到另一个空间,让数据能够更好的被分类。

在神经网络中,为了避免单纯的线性组合,我们在每一层的输出后面都添加一个激活函数(sigmoid、tanh、ReLU等等)。

几种常用的激活函数

1、sigmod函数

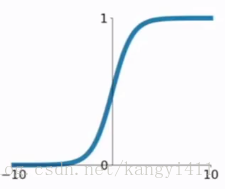

函数图像:

在sigmod函数中我们可以看到,其输出是在(0,1)这个开区间内。可以联想到概率,但是严格意义上讲,不要当成概率。sigmod函数曾经是比较流行的,它可以想象成一个神经元的放电率,在中间斜率比较大的地方是神经元的敏感区,在两边斜率很平缓的地方是神经元的抑制区。

当然,流行也是曾经流行,这说明函数本身是有一定的缺陷的。

1) 当输入稍微远离了坐标原点,函数的梯度就变得很小了,左右都陷入了软饱和,梯度几乎为零。在神经网络反向传播的过程中,我们都是通过微分的链式法则来计算各个权重w的微分的。当反向传播经过了sigmod函数,这个链条上的微分就很小很小了,况且还可能经过很多个sigmod函数,最后会导致权重w对损失函数几乎没影响,这样不利于权重的优化,也就是梯度消失。

2) 函数输出不是以0为中心的,这样会使权重更新效率降低。对于这个缺陷,在斯坦福的课程里面有详细的解释。

3) sigmod函数要进行指数运算,这个对于计算机来说是比较慢的。

2、tanh函数

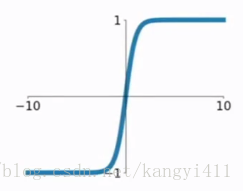

函数图像:

tanh是双曲正切函数,tanh函数和sigmod函数的曲线是比较相近的,咱们来比较一下看看。首先相同的是,这两个函数在输入很大或是很小的时候,输出都几乎平滑,梯度很小,不利于权重更新;不同的是输出区间,tanh的输出区间是在(-1,1)之间,而且整个函数是以0为中心的,这个特点比sigmod的好。

一般二分类问题中,隐藏层用tanh函数,输出层用sigmod函数。不过这些也都不是一成不变的,具体使用什么激活函数,还是要根据具体的问题来具体分析,还是要靠调试的(调参真是门玄学)。

3、ReLU函数

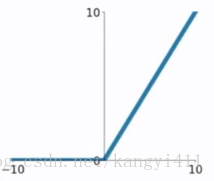

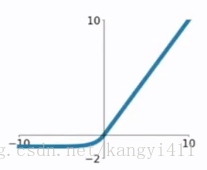

函数图像:

很显然,从图左可以看出,输入信号<0时,输出都是0,>0 的情况下,输出等于输入。w 是二维的情况下,使用ReLU之后的效果如下:

相比于sigmod函数和tanh函数,它有以下几个优点:

1) 在输入为正数的时候,不存在梯度饱和问题。在输入小于0时,输出均为0,左边为硬饱和。

2) 计算速度要快很多(sigmod和tanh要计算指数,计算速度会比较慢)。ReLU函数只有线性关系,不管是前向传播还是反向传播,收敛速度都比sigmod和tanh要快很多。。

当然,缺点也是有的:

1) 当输入是负数的时候,ReLU是完全不被激活的,这就表明一旦输入到了负数,ReLU就会死掉。这样在前向传播过程中,还不算什么问题,有的区域是敏感的,有的是不敏感的。但是到了反向传播过程中,输入负数,梯度就会完全到0,这个和sigmod函数、tanh函数有一样的问题。

实际操作中,如果你的learning rate 很大,那么很有可能你网络中的大面积的神经元都”dead”了。

当然,如果你设置了一个合适的较小的learning rate,这个问题发生的情况其实也不会太频繁。

2) 我们发现ReLU函数的输出要么是0,要么是正数,这也就是说,ReLU函数也不是以0为中心的函数。

4.ELU函数

函数图像:

ELU函数是针对ReLU函数的一个改进型,相比于ReLU函数,在输入为负数的情况下,是有一定的输出的,而且这部分输出还具有一定的抗干扰能力。这样可以消除ReLU死掉的问题,不过还是有梯度饱和和指数运算的问题。

5.PReLU函数

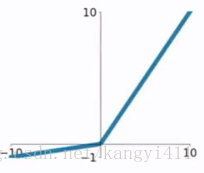

函数图像:

PReLU也是针对ReLU的一个改进型,函数图像与ELU函数类似,仅Y轴左边不同。在负数区域内,PReLU有一个很小的斜率,这样也可以避免ReLU死掉的问题。相比于ELU,PReLU在负数区域内是线性运算,斜率虽然小,但是不会趋于0,同时也避免了指数运算带来的速度问题,这算是一定的优势吧。

我们看PReLU的公式,里面的参数α一般是取0~1之间的数,而且一般还是比较小的,如零点零几。当α=0.01时,我们叫PReLU为Leaky ReLU,算是PReLU的一种特殊情况吧。

总体来看,这些激活函数都有自己的优点和缺点,没有哪一条激活函数是绝对是好的或者绝对是差的,没有最好的或最差的激活函数,只有最适合或者最不适合的激活函数,所有的好坏都要自己去实验中得到。