我们直奔话题!

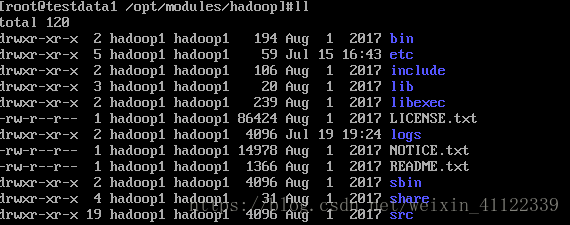

一,首先我们进入hadoop目录下可以看到以下文件:

我们挑重要的说:

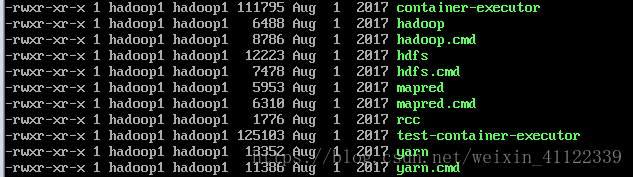

1,bin: 存放的是我们用来实现管理脚本和使用的脚本的目录,我们对hadoop文件系统操作的时候用的就是这个目录下的脚本

常用的命令脚本(我们忽略.cmd的文件这是windows下的使用的文件):hdfs hadoop yarn 来执行对文件操作

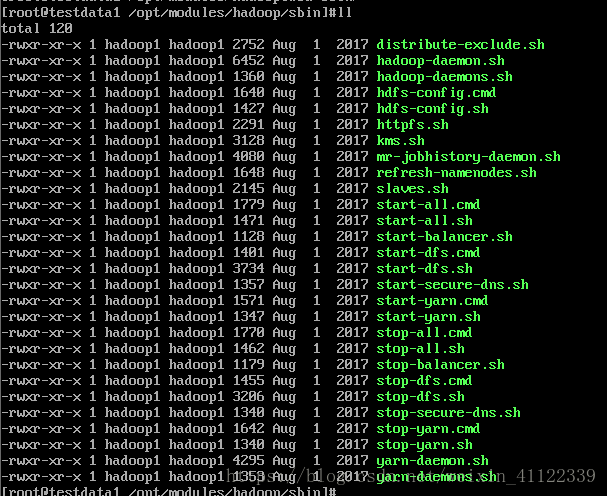

二,sbin: 存放的是我们管理脚本的所在目录,重要是对hdfs和yarn的各种开启和关闭和单线程开启和守护

好多啊,但我们仔细看看很多用不到,我们只需要记住几个就OK了,

1,hadoop-daemon.sh(hadoop-daemons) : 通过执行hadoop命令来启动/停止一个守护进程(daemon);他可以单独开启一个进程也可以使用hadoop-daemons来开启多个进程,这样我们在某台机器挂掉时,就不用全部重新开启了

2,start-all.sh : 他会调用 start-dfs.sh和start-yarn.sh(官方不建议使用)

3, stop-all.sh : 他会调用 stop-dfs.sh和stop-yarn.sh(官方不建议使用)

4,start-dfs.sh: 启动NameNode ,SecondaryNamenode ,DataNode这些进程

5,start-yarn.sh: 启动ResourceManager,nodeManager 这些进程

6,stop-dfs.sh: 关闭NameNode ,SecondaryNamenode ,DataNode这些进程

7, stop-yarn.sh: 关闭ResourceManager,nodeManager 这些进程

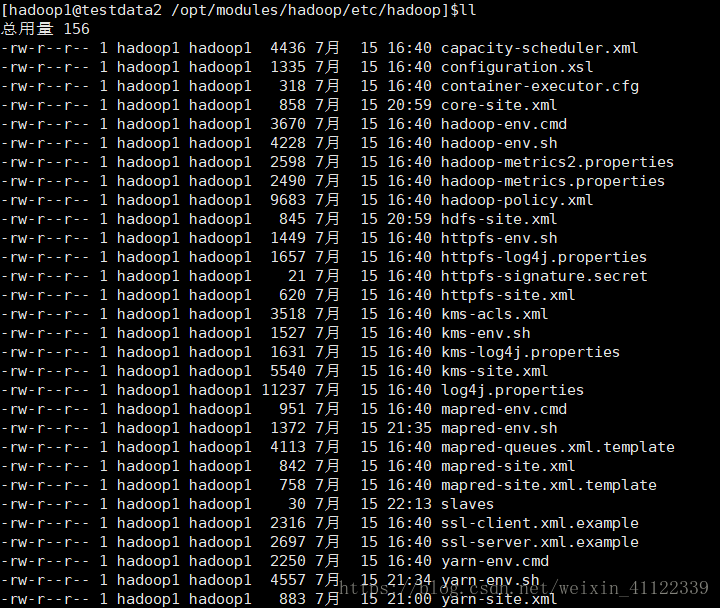

三,etc:存放一些hadoop的配置文件

我们讲一写核心的配置文件:

(1)core-site.xml:

Hadoop核心全局配置文件,可以其他配置文件中引用该文件中定义的属性,如在hdfs-site.xml及mapred-site.xml中会引用该文件的属性;

该文件的模板文件存在于$HADOOP_HOME/src/core/core-default.xml,可将模板文件复制到conf目录,再进行修改。

(2)hadoop-env.sh

Hadoop环境变量

(3)hdfs-site.xml

HDFS配置文件,该模板的属性继承于core-site.xml;该文件的模板文件存于$HADOOP_HOME/src/hdfs/hdfs-default.xml,可将模板文件复制到conf目录,再进行修改

(4)yarn-site.xml

yarn的配置文件,该模板的属性继承于core-site.xml;该文件的模板文件存于$HADOOP_HOME/src/mapred/mapredd-default.xml,

可将模板文件复制到conf目录,再进行修改

(5)slaves

用于设置所有的slave的名称或IP,每行存放一个。如果是名称,那么设置的slave名称必须在/etc/hosts有IP映射配置

4.lib目录

该目录下存放的是Hadoop运行时依赖的jar包,Hadoop在执行时会把lib目录下面的jar全部加到classpath中。

5.logs目录

该目录存放的是Hadoop运行的日志,查看日志对寻找Hadoop运行错误非常有帮助。

6.include目录

对外提供的编程库头文件(具体动态库和静态库在lib目录中),这些头文件均是用C++定义的,通常用于C++程序访问HDFS或者编写MapReduce程序。

7.libexec目录

各个服务对用的shell配置文件所在的目录,可用于配置日志输出、启动参数(比如JVM参数)等基本信息。

8.share目录

Hadoop各个模块编译后的jar包所在的目录。

这大概就是hadoop的文件目录的大概内容了,希望能对学习路上的朋友有帮助!