网站用户体验

1.网页打开速度

2.访客在网站停留时间:

网站整体框架(是否清晰表达信息),网站色调,网站操作是否顺畅

3.访客看完网站之后是否有反馈

seoer

一、专业术语:

超链接:超链接一般分为以下3种类型:内部链接,锚点链接和外部链接。

内链:自己网站的内容链接到自己网站的内部页面

长尾关键词:

定向锚文本 :(可用于新闻中的关键词)

robot:

301转向(或叫301重定向,301跳转)是当用户或搜索引擎向网站服务器发出浏览请求时,服务器返回的HTTP数据流中头信息(header)中的状态码的一种,表示本网页永久性转移到另一个地址。

HTTP 404或Not Found错误信息是HTTP的其中一种“标准回应信息”(HTTP状态码),此信息代表客户端在浏览网页时,服务器无法正常提供信息,或是服务器无法回应且不知原因。

白帽:即通过正常的手段对网站内部优化(包括网站标题,网站结构,网站代码,网站内容,关键词密度等)、网站外部的发布与建设,提高网站关键词在搜索引擎排名的一种seo技术。

蜘蛛池:在网站快速排名中被用的较多的一种黑帽手段

蜘蛛池其实本质上就是站群,利用网站程序或者软件根据模板或者自定义页面实现自动生成文章内容,或者也就是一些采集后加工做伪原创的内容,以此来吸引搜索引擎蜘蛛抓取,然而拥有站群这样页面数量庞大的量后,搜索引擎怎么抓取就会在站群中,也就形成了所谓的蜘蛛池,这也是蜘蛛池的原理所在。

而对于站群来说,大家可能就再熟悉不过了,即使没做过站群,甚至你可能没有见过,但是你一定听过搜索引擎的各种算法要打击站群,正是因为站群的内容根本就不能称之为内容,与搜索引擎而言这是对服务器资源和带宽的严重浪费,而对我们使用搜索引擎的用户来说,就是严重的影响了用户体验,可能我们搜索东西的时候都有这样的体验,点击进去一些页面的内容完全没有可读性,甚至标题与内容完全就是扭头对不上马嘴,所以就不用子凡多介绍了吧。

蜘蛛池的应用

既然蜘蛛池就可以理解为是站群,其站群最主要的一个特点就是其可管理性,虽然很多人做站群的目的是为了获得流量并转化为广告形成利益收成,而更高的一种操作就是蜘蛛池,因为当你拥有这样一个庞大的站群时,只要在页面中放上链接,搜索引擎蜘蛛就能够很快的发现这些链接,从而使得搜索引擎的收录索引。

蜘蛛池的弊端

万事有好的一面,必然也有坏的一面,上面子凡就已经说过即使蜘蛛池可以有利于网站的快速排名优化也依旧不会选择使用,因为我知道使用蜘蛛池也并不是有利无害的东西,当然你也可以理解是我胆小吧!

蜘蛛池本身就是由质量低劣的站群实现,所以当一个网站的链接长期并且不断的堆砌在这些垃圾站点中,对于网站来说无疑是一个定时危险存在,是一件风险极高的事情,搜索引擎也是极力打击这样的站点,当发现你的链接和这些站点密切的时候,再好的排名或收录也将瞬间化为乌有。

对于蜘蛛池的观点,子凡还是建议大家尽可能的不要使用,最好不要去尝试搜索引擎的反映和判断能力,人工的去一些地方发发链接,例如百度百家号、搜狐自媒体等平台,还有其它的第三方博客,论坛等等这些最最最普通的地方留下一些链接就可以不错的吸引到搜索引擎蜘蛛了,这样的外链方式更为自然和有效。

二、习惯性

写下每天的排名啊,收录的,记录每一天的问题,那个网站好的,不好的,搜索引擎远离来推倒不是万能的,只有和排名相结才能得出相应的结果。通过坚持长期观察,分析大量例子,可以了解到很多别人不知道的搜索引擎规则。那么就可以粗略反推出结论,文章里面加图片是一个有利于排名的因素。

三、网站地图

当蜘蛛来到我们的网站时,告诉它我们有多少页面,不同页面是按什么分类的,每个页面的地址是什么。顺着我们的指引,蜘蛛会很轻松的爬遍所有内容。另外,如果你的页面分类比较多,而且数量大,建议添加sitemap索引文件。如果站点经常更新添加新页面,建议及时更新sitemap文件;

主动提交。就是把你的页面直接丢给百度的接口,亲口告诉百度你有哪些页面,这是效率最高也是收录最快的方式了。但是需要注意,百度对每天提交的数量是有限制的,而且反复提交重复的页面,会被降低每日限额,所以已被收录的页面不建议反复提交。收录有个时间过程,请先耐心等待;

实时提交。在页面中安装百度给的提交代码,当这个页面被用户打开我,便自动把这个页面提交给百度。这里不需要考虑重复提交的问题。

四、URL

URL层级嵌套不要太深,建议不超过四层。增加面包屑导航可以使页面层次分明,也有利于为蜘蛛营造顺利的爬取路径。

除此之外,将指向首页的域名全部设置301跳转到同一URL,可以避免分散权重。

五、TDK优化

TDK是搜索引擎判断页面主题内容的关键,所以要在title里面言简意赅的体现出页面的主要内容,如果主体比较多,可以用一些符号把不同的主题词隔开,但是关键词不要太多,最多不要超过五个。

keywords里面把每个关键词用英文逗号隔开,三到五个最佳。尽量覆盖每个关键词。

description就是用自然语言描述页面的主要内容,这里注意一点就是把每个关键词至少覆盖一遍才能达到最佳效果。

六、细节

1.提升页面关键词密度

2.img标签的alt属性

3.页面上的出站链接(也就是指向别的网站的A标签),我们要给它加上nofollow标签,避免它向别的网站输出权重。百度蜘蛛会忽略加了nofollow 的链接。你也可以在网页的meta标签里这么写<meta name=”robots” content=”nofollow” />,这样一来,百度蜘蛛将不追踪页面上的所有链接,但不建议这么做,除非这个页面的所有链接都指向了别的域名。

4.友情链接

5.关键词筛选

七、搜索引擎

从搜索引擎的角度来看,严格来讲,搜索引擎只能识别文字以及链接,编辑出来的内容就是文字,怎么编辑,如何组织内容就显得尤为重要。同样的一个主体相似的网站,内容胜出的更有数据方面的优势。

八、完整详细的网站

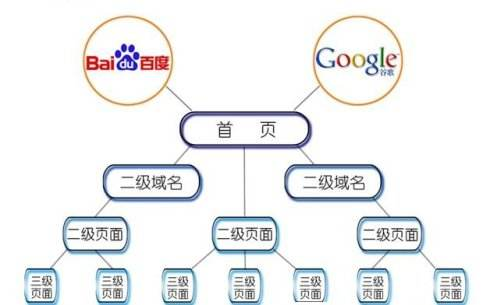

九、网站结构如何优化

1.关键词分布均衡。

首页为核心关键词 > 栏目页为二级关键词 > 文章页长尾关键词。

例如本站:

首页核心关键词主要有三个:“seo教程”、“seo优化”和“网站seo”。

每个栏目页仅有一个二级关键词:“seo视频教程”、“seo优化技术”、“seo建站”。

2、链接结构

清晰合理,层级分明。

如典型的企业站结构:首页 > 栏目页 > 文章页。

除了首页、栏目页和文章页外,还应有专题页或者tag页面。

例如本站,1个首页、9个栏目页、大量tag页。

3、URL

URL名称规划合理,尽量短。

4、禁止抓取

robots文件放在网站的根目录下,可以设置网站的哪些内容不被抓取。如注册界面、网站会员标准之类。

nofollow标签,可以让蜘蛛不跟踪爬行,也不传递权重和锚文字。

noindex meta robots标签,用于指令搜索引擎禁止索引本页内容。

5、减少使用搜索引擎不识别的内容

尽量不使用的情况:大面积Flash、页面跳转、框架结构。

二、利用301重定向,Canonical标签方式集中主url权重。

三、404页面由于网站的某些文章删除,但链接依然保留下其他地方,当人们访问这个链接时,就会无法访问。

404页面的设计,就是把这些无法正常访问的链接,统一跳转至这个404页面。

404页面优势:

1、防止网站出现死链;

2、可以随意设计404页面的风格,包括返回首页、搜索框、联系电话、邮箱等等;

3、给用户更好的体验。

即使只是前端改版,因为关键词词频和位置发生了变化,也会造成网站流量损失,注意改版后的关键词位置以及词频。