前面看了很仔细的一些知识,今天换个口味,我们来了解一下机器学习中的两大学派,即频率学派和贝叶斯学派,我们为什么突然走起了这个风格的style呢?是不是没吃药?哈哈哈,不是这样的,是以前对机器学习的理解理解都是挑的比较详细的知识点进行串联,体系结构形成的并不是很完善,因此回头过来看看最基础的一些看似没用的东西,可以起到事半功倍的效果呢,事实证明也的确如此(关于这个论证感兴趣的小伙伴可以从减小过拟合的正则化原因中去探索,一定会有所收获!)这两个学派有什么区别呢?下面我们就来看看他们各自的定义:

表述:

1)频率学派:事件本身是服从某种分布的,这种分布的参数是固定的,(频率即概率,在极限情况下(数据量足够多)的情况下,频率可以近似看做概率,且概率是不变的,事件A在n次独立重复试验中发生的频率趋于极限p,那么此时频率可以看做该事件的概率。)

2)贝叶斯学派:我们无法确定这些参数,因此我们需要关心的是参数空间中的每一个值,我们假设这些参数值是符合某种分布的(先验假设),然后根据这个假设去做实验,不断调整我们的假设,得到最后结果(后验分布)。

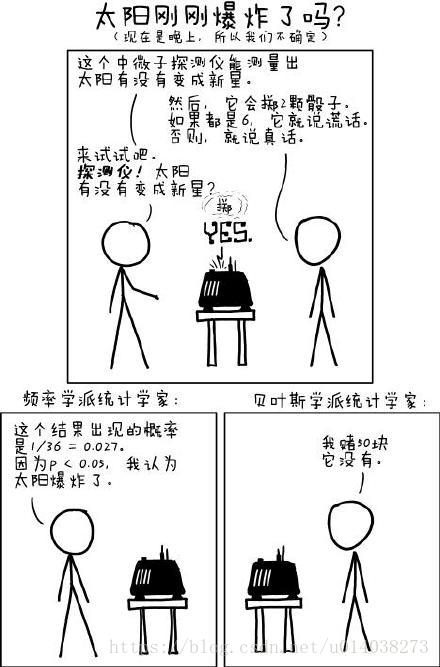

贝叶斯重视先验,频率重视似然;贝叶斯重视带有主观色彩,频率带有自然色彩;贝叶斯看重的是人的先验知识,频率学派只谈数据;频率学派太注重事件,容易被事件蒙蔽;而贝叶斯学派太过幻想,很多东西都不好实现,例如参数的先验假设,即参数服从怎样的分布呢?

本质差别是什么呢?

频率学派认为某一事件发生的概率是常量,贝叶斯学派认为事件发生的概率是变量!,因此频率学派中的概率是样本

即我们将待求解的参数当做了待求解系数还是当做了一个随机变量:

频率/贝叶斯:p(x;w)|p(x,w)=p(x|w)p(w)

(PS:p(x;w)表明随机变量x服从某种分布,该分布的参数是w,w是确定的,不是随机变量;

p(x,w)表明了将x,w看做两个随机变量符合某个联合分布,即w服从某种分布,(x|w)服从某种分布,p(x|w)即在w发生的情况下样本x发生的概率,即此时已经确定了w,又可以回归到频率学派的p(x;w),即可看做p(x|w)==p(x;w))

那它们的联系又是什么呢?

频率学派可以被看成特别特殊的贝叶斯学派,在这种情况下,我们认为超参数均匀的;贝叶斯学派的计算方法在样本足够多的情况下近似可以看做频率学派,它们二者的关系是:样本越多,两者越接近!

影响:

针对频率学派和贝叶斯学派的观点,我们衍生了两种参数估计方法,因为机器学习最终还是为了得到最优参数,即参数估计,这两种方法是什么呢?

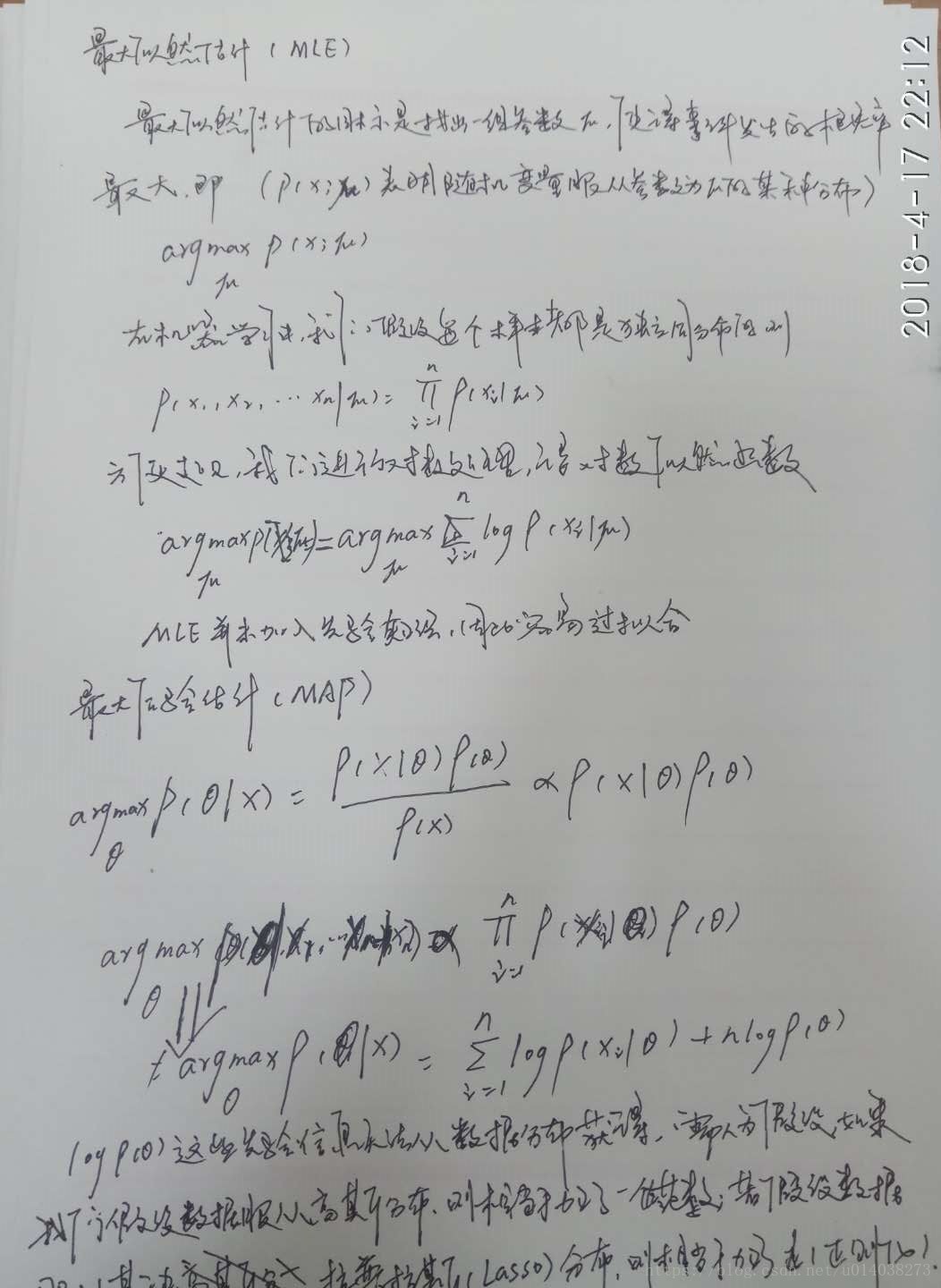

频率学派:极大似然估计(MLE/MLLE(因为一般是log-likely似然函数))

贝叶斯学派:最大后验估计(MAP(max a posteriori Estimation))