只针对会linux命令,会python的伙伴,

使用环境为:

群辉ds3615xs 6.1.7

python3.5

最近使用scrapy开发了一个小爬虫,因为很穷没有服务器可已部署。

所以打起了我那台千辛万苦攒出来的群辉的主意。以前折腾的时候发现群辉6.1.7基于linux64位系统实现的。

既然是linux系统就应该可以装python。开始我的折腾之路。

刚开始直接ssh远程上去后想apt-get install 方法安装python的,结果发现根本就没有apt-get命令。

后来又试过官网下载pthon3.6源码进行安装,发现没有编译环境。

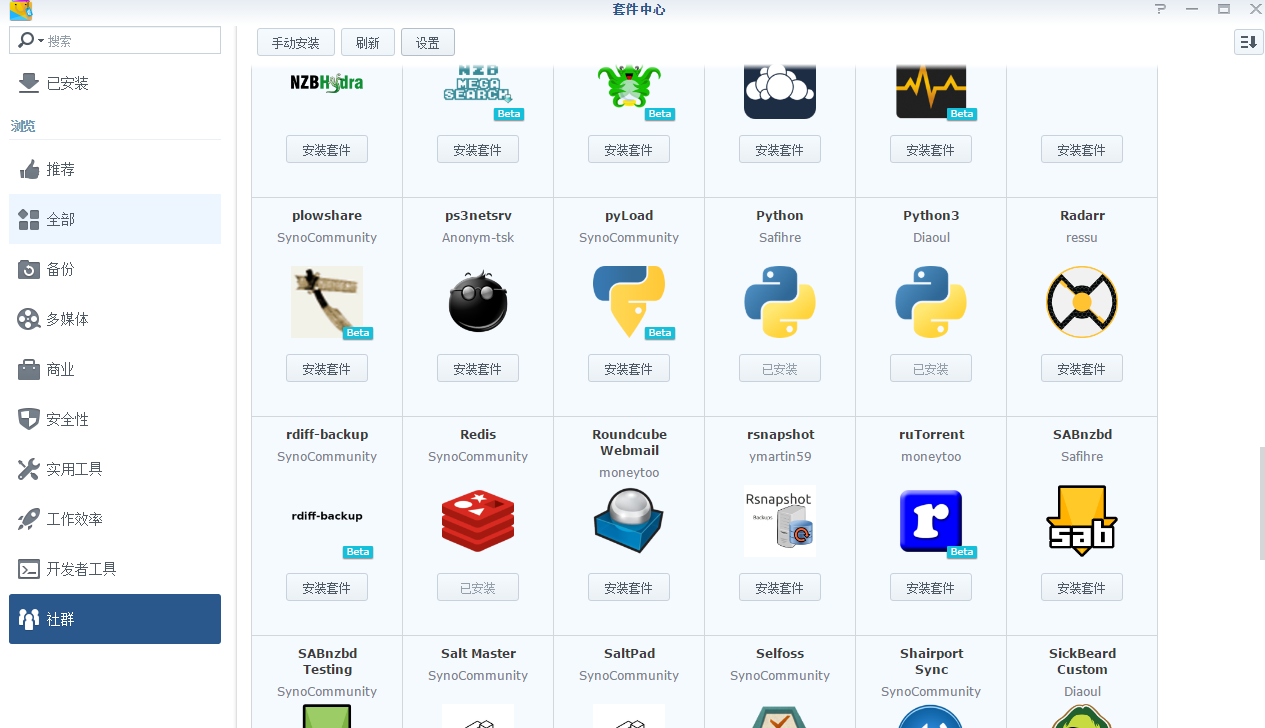

不过群辉的好处就是第三方套件很多。

以下命令的路径都是基于本人真实路径,请根据实际情况修改

1.添加第三方套件源 http://packages.synocommunity.com/

安装第三方的python3(官方也提供了一个python3,但是我没用,也不知道是为什么,为什么呢,为什么呢,问了自己八百遍。建议不太懂的参考我的)

安装如下python3就好

安装完成后,进入设置开启ssh,putty远程连接上群辉。

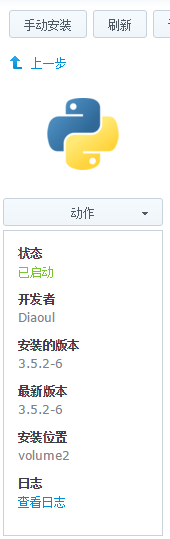

记得查看一下python3安装在哪个位置,在下图中可以得到位置,我的是在volume2下

2.群辉官方安装的python3默认是没有pip的,我废了老大劲装上了,然后pip3 install scrapy装不上。

当然如果装上了这个教程就到此结束了,结果废了半天劲最后没用上pip。

pip安装scrapy 期间处理各种错误,奈何本人技术有限无法成功,只能另辟蹊径用非正常方法了。

本人开发环境是虚拟机下的deepin系统(底层也是linux),已经装好了scrapy框架,同样是python3.5。

进入deppin虚拟机的套件安装目录,本人的路径是/home/libing/.local/lib/python3.5/site-packages,别的系统自行查找

复制出来以下文件夹待用 pydispatch,pyOpenSSL-18.0.0.dist-info,scrapy,twisted,Twisted-18.7.0.dist-info,

复制出来scrapy文件,命令行下 type scrapy 可以查看路径。

上传复制出来的文件到群辉。我上传到了 /volume2/docker 目录下

文件夹名称可能版本不同有所差异,可能有漏的,因为我安装了pip复制完成后又执行了pip install scrapy 进行了安装会把某些漏网之鱼装上。

3.putty连接上群辉 执行sudo su - 命令输入当前用户的密码进入超级管理员(注意su和-有一个空格)

cd 到 /volume2/@appstore/python3/lib/python3 目录

volume2就是刚才群辉安装套件的位置

python3.5根据安装版本不同可能不同。

执行cp命令复制刚才上传的文件到当前目录

cp -r /volume2/docker/python3/刚才上传的文件夹名/ ./

所有的都有全部复制过去

然后把scrapy文件复制到/usr/local/bin/就好

cp /volume2/docker/python3/scrapy /usr/local/bin/scrapy /usr/local/bin/

还要为python3创建一个软连接,不然会提示没有python3命令根据我的路径是如下命令

ln -s /volume2/docker/python3/scrapy /usr/local/bin/python3 /bin/

也可以这样给pip3添加软连接。

建议再进行pip3 install scrapy安装一次,防止有漏的文件夹和文件。

完成后如果执行scrapy命令不报错,那么恭喜你成功了。