1.概述

(1) 所谓HA(high available),即高可用(7*24小时不中断服务)。

(2) 实现高可用最关键的策略是消除单点故障。HA严格来说应该分成各个组件的HA机制:HDFS的HA和YARN的HA。

(3) Hadoop2.0之前,在HDFS集群中NameNode存在单点故障(SPOF)。

(4) NameNode主要在以下两个方面影响HDFS集群

NameNode机器发生意外,如宕机,集群将无法使用,直到管理员重启

NameNode机器需要升级,包括软件、硬件升级,此时集群也将无法使用

HDFS HA功能通过配置Active/Standby两个nameNodes实现在集群中对NameNode的热备来解决上述问题。如果出现故障,如机器崩溃或机器需要升级维护,这时可通过此种方式将NameNode很快的切换到另外一台机器。

2.HDFS-HA集群配置

(1) 环境准备

修改IP

修改主机名及主机名和IP地址的映射

关闭防火墙

ssh免密登录

安装JDK,配置环境变量等

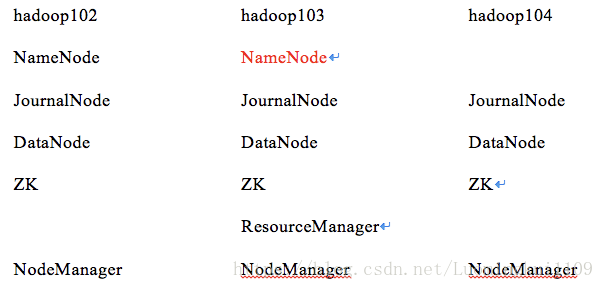

(2) 规划集群

(3)

配置Zookeeper集群

详见:Zookeeper 集群部署与命令行操作

(4) 配置HDFS-HA集群

① 官方地址:

http://hadoop.apache.org/

② 在opt目录下创建一个ha文件夹

mkdir HA

③ 将/opt/app/下的 hadoop-2.7.2拷贝到/opt/ha目录下

cp -r hadoop-2.7.2/ /opt/HA/

④ 配置hadoop-env.sh

export JAVA_HOME=/opt/module/jdk1.8.0_144

⑤ 配置core-site.xml

<configuration>

<!-- 把两个NameNode)的地址组装成一个集群mycluster -->

<property>

<name>fs.defaultFS</name>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/HA/hadoop-2.7.2/data/tmp</value>

</property>

</configuration>

⑥ 配置hdfs-site.xml

<configuration>

<!-- 完全分布式集群名称 -->

<property>

<name>dfs.nameservices</name>

<value>mycluster</value>

</property>

<!-- 集群中NameNode节点都有哪些 -->

<property>

<name>dfs.ha.namenodes.mycluster</name>

<value>nn1,nn2</value>

</property>

<!-- nn1的RPC通信地址 -->

<property>

<name>dfs.namenode.rpc-address.mycluster.nn1</name>

<value>hadoop102:9000</value>

</property>

<!-- nn2的RPC通信地址 -->

<property>

<name>dfs.namenode.rpc-address.mycluster.nn2</name>

<value>hadoop103:9000</value>

</property>

<!-- nn1的http通信地址 -->

<property>

<name>dfs.namenode.http-address.mycluster.nn1</name>

<value>hadoop102:50070</value>

</property>

<!-- nn2的http通信地址 -->

<property>

<name>dfs.namenode.http-address.mycluster.nn2</name>

<value>hadoop103:50070</value>

</property>

<!-- 指定NameNode元数据在JournalNode上的存放位置 -->

<property>

<name>dfs.namenode.shared.edits.dir</name>

</property>

<!-- 配置隔离机制,即同一时刻只能有一台服务器对外响应 -->

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<!-- 使用隔离机制时需要ssh无秘钥登录-->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/luomk/.ssh/id_rsa</value>

</property>

<!-- 声明journalnode服务器存储目录-->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/opt/module/HA/hadoop-2.7.2/data/jn</value>

</property>

<!-- 关闭权限检查-->

<property>

<name>dfs.permissions.enable</name>

<value>false</value>

</property>

<!-- 访问代理类:client,mycluster,active配置失败自动切换实现方式-->

<property>

<name>dfs.client.failover.proxy.provider.mycluster</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

</configuration>

⑦ 拷贝配置好的hadoop环境到其他节点

(5) 启动HDFS-HA集群

① 在各个JournalNode节点上,输入以下命令启动journalnode服务:

sbin/hadoop-daemon.sh start journalnode

② 在[nn1]上,对其进行格式化,并启动:

bin/hdfs namenode -format

sbin/hadoop-daemon.sh start namenode

③ 在[nn2]上,同步nn1的元数据信息:

bin/hdfs namenode -bootstrapStandby

④ 启动[nn2]:

sbin/hadoop-daemon.sh start namenode

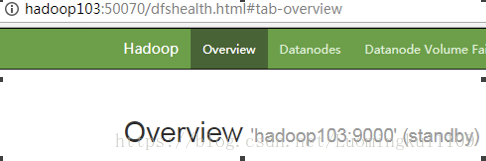

⑤ 查看web页面显示

⑥ 在[nn1]上,启动所有datanode

sbin/hadoop-daemons.sh start datanode

⑦ 将[nn1]切换为Active

bin/hdfs haadmin -transitionToActive nn1

⑧ 查看是否Active

bin/hdfs haadmin -getServiceState nn1

(6) 配置HDFS-HA自动故障转移

① 具体配置

a.在hdfs-site.xml中增加

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

b.在core-site.xml文件中增加

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop102:2181,hadoop103:2181,hadoop104:2181</value>

</property>

② 启动

//关闭所有HDFS服务:

sbin/stop-dfs.sh

//启动Zookeeper集群:

bin/zkServer.sh start

//初始化HA在Zookeeper中状态:

bin/hdfs zkfc -formatZK

//启动HDFS服务:

sbin/start-dfs.sh

//在各个NameNode节点上启动DFSZK Failover Controller,先在哪台机器启动,哪个机器的NameNode就是Active NameNode

sbin/hadoop-daemin.sh start zkfc

③ 验证

//将Active NameNode进程kill

kill -9 namenode的进程id

//将Active NameNode机器断开网络

service network stop

3.配置YARN-HA集群

(1)环境准备

修改IP

修改主机名及主机名和IP地址的映射

关闭防火墙

ssh免密登录

安装JDK,配置环境变量等

配置Zookeeper集群

(2) 规划集群

(3) 具体配置

① yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!--启用resourcemanager ha-->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<!--声明两台resourcemanager的地址-->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>cluster-yarn1</value>

</property>

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>hadoop102</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>hadoop103</value>

</property>

<!--指定zookeeper集群的地址-->

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>hadoop102:2181,hadoop103:2181,hadoop104:2181</value>

</property>

<!--启用自动恢复-->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!--指定resourcemanager的状态信息存储在zookeeper集群-->

<property>

<name>yarn.resourcemanager.store.class</name> <value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

</configuration>

② 同步更新其他节点的配置信息

(4) 启动hdfs

①

在各个JournalNode节点上,输入以下命令启动journalnode服务:

sbin/hadoop-daemon.sh start journalnode

②

在[nn1]上,对其进行格式化,并启动:

bin/hdfs namenode -format

sbin/hadoop-daemon.sh start namenode

③

在[nn2]上,同步nn1的元数据信息:

bin/hdfs namenode -bootstrapStandby

④

启动[nn2]:

sbin/hadoop-daemon.sh start namenode

⑤

启动所有datanode

sbin/hadoop-daemons.sh start datanode

⑥

将[nn1]切换为Active

bin/hdfs haadmin -transitionToActive nn1

(5) 启动yarn

① 在hadoop102中执行:

sbin/start-yarn.sh

② 在hadoop103中执行:

sbin/yarn-daemon.sh start resourcemanager

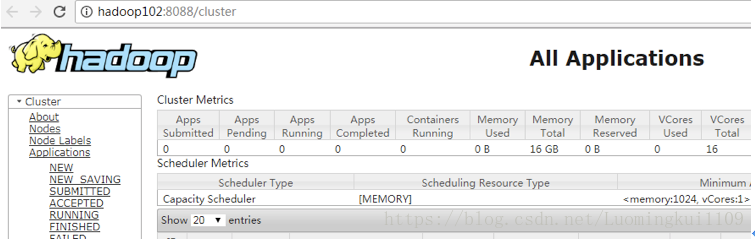

③ 查看服务状态

bin/yarn rmadmin -getServiceState rm1