环境

Windows 10

Centos 7.4

java 1.8.0-openjdk.x86_64

scala 2.12.6

spark 2.3.1

Windows10 安装Spark 2.3.1

1. 安装Java 1.8

官网下载JDK 1.8 http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

安装后版本检查

java -version

2. 安装Scala 2.12.6

Windows版本下载 https://downloads.lightbend.com/scala/2.12.6/scala-2.12.6.msi

安装后版本检查

scala -version

3. 设置Hadoop路径

命令行窗口

set HADOOP_HOME = C:\winutils

4. 下载winutils

从https://github.com/steveloughran/winutils/blob/master/hadoop-2.7.1/bin/winutils.exe下载winutils,保存到文件夹 C:\winutils\bin\ 下

5. 修改hive文件夹权限

命令行窗口

c:\winutils\bin\winutils chmod 777 c:\tmp\hive

6. 安装Spark

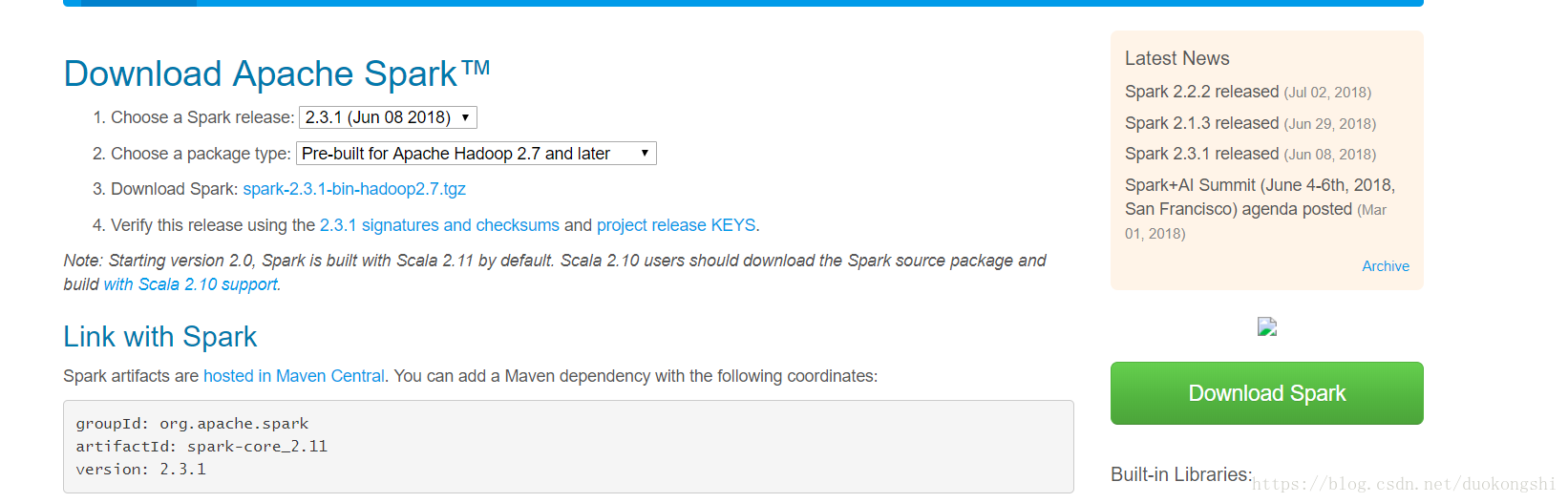

从官网https://spark.apache.org/downloads.html下载Spark2.3.1,并展开。设置SPARK_HOME, 并且添加%SPARK_HOME%\bin到PATH环境变量里

7. 运行spark互动模式

命令行窗口

spark-shell

Centos7 安装Spark 2.3.1

本文档是用于Spark的测试与学习,安装用户全部是root; 如果是用于生产环境,需要做相应的调整。

1. 安装Java 1.8

yum install java-1.8.0-openjdk.x86_64

版本检查

java -version

2. 安装Scala 2.12.6

# 如果没有wget, 需要先安装:

# yum install wget

wget -O scala-2.12.6.tgz https://downloads.lightbend.com/scala/2.12.6/scala-2.12.6.tgz

# 如果没有gunzip, 需要先安装:

# yum install unzip

gunzip -c scala-2.12.6.tgz|tar xvf -

mv scala-2.12.6 /opt

export PATH=$PATH:/opt/scala-2.12.6/bin

版本检查

scala -version

3. 安装Spark 2.3.1

wget -O spark-2.3.1-bin-hadoop2.7.tgz http://www-us.apache.org/dist/spark/spark-2.3.1/spark-2.3.1-bin-hadoop2.7.tgz

gunzip -c spark-2.3.1-bin-hadoop2.7.tgz |tar xvf -

mv spark-2.3.1-bin-hadoop2.7 /opt

export PATH=$PATH:/opt/spark-2.3.1-bin-hadoop2.7/bin

4. 运行spark互动模式

spark-shell