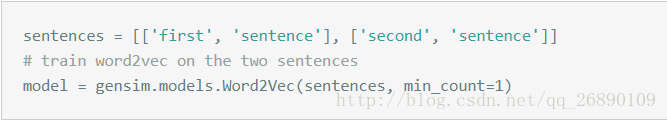

ex:

调用word2vec(sentences,iter=1)会调用句子迭代器运行两次;第一次运行负责收集单词以及单词出现的频率,从而构造一个内部字典树。第二次以及后续运行负责训练神经模型。

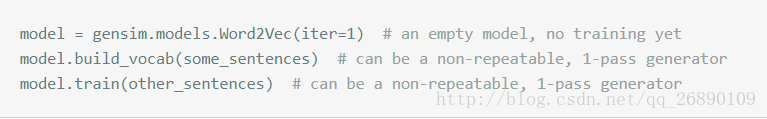

如果sentences是不可迭代的,可手动初始化:

word2vec中影响训练速度和质量的参数

1.在一个数以亿计的语料库中出现1~2次的单词非常有可能是噪音或不需要被关注;另外,也没有足够的数据对他们进行有意义的训练,最好的方法是过滤到这些低频词。

其中min_count就是用于设置过滤阈值的参数,合理的范围为0~100;默认值为5。

2.神经网络神经层数size;默认值为100,更大的size值需要更多的训练数据,合理的取值范围是几十到几百。

3.训练并行粒度,用来加速训练 workers;只有机器安装了Cython才会起到作用。否则以但和运行

内存存储形式

内部,Word2vec模型的参数以矩阵形式存储(numpy数组)数组大小为词汇个数乘以size

存储和载入模型

model.save(filepath)

new_model = gensim.models.Word2vec.load(filepath)##将模型内部的numpy矩阵从硬盘载入到虚拟内存中

还有方法load_word2vec_format()